解码器专题

NLP-生成模型-2014:Seq2Seq【缺点:①解码器无法对齐编码器(Attention机制);②编码器端信息过使用或欠使用(Coverage机制);③解码器无法解决OOV(Pointer机制)】

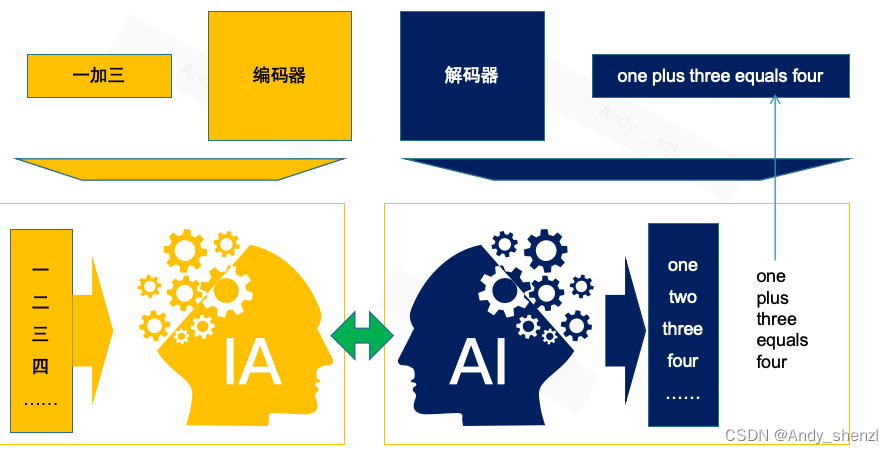

《原始论文:Sequence to Sequence Learning with Neural Networks》 Seq2Seq模型是将一个序列信号,通过“编码&解码”生成一个新的序列信号,通常用于机器翻译、语音识别、自动对话等任务。 Seq2Seq(多层LSTM-多层LSTM)+Attention架构是Transformer提出之前最好的序列生成模型。 我们之前遇到的较为熟悉的序列问题,

9-6 编码器-解码器架构

正如我们在 9-5节中所讨论的, 机器翻译是序列转换模型的一个核心问题, 其输入和输出都是长度可变的序列。 为了处理这种类型的输入和输出, 我们可以设计一个包含两个主要组件的架构: 第一个组件是一个编码器(encoder): 它接受一个长度可变的序列作为输入, 并将其转换为具有固定形状的编码状态。 第二个组件是解码器(decoder): 它将固定形状的编码状态映射到长度可变的序列。 这被称为编码器

seq2seq编码器encoder和解码器decoder详解

编码器 在序列到序列模型中,编码器将输入序列(如一个句子)转换为一个隐藏状态序列,供解码器生成输出。编码层通常由嵌入层和RNN(如GRU/LSTM)等组成 Token:是模型处理文本时的基本单元,可以是词,子词,字符等,每个token都有一个对应的ID。是由原始文本中的词或子词通过分词器(Tokenizer)处理后得到的最小单位,这些 token 会被映射为词汇表中的唯一索引 ID输入: 原始

认识org.apache.hadoop.io.compress解码器/编码器

认识org.apache.hadoop.io.compress解码器/编码器 编码器和解码器用以执行压缩解压算法。在Hadoop里,编码/解码器是通过一个压缩解码器接口实现的。因此,例如,GzipCodec封装了gzip压缩的压缩和解压算法。下表列出了Hadoop可用的编码/解码器。 压缩格式 Hadoop压缩编码/解码器 DEFLATE org.apache.hadoop.io

Netty中分隔符和定长解码器的应用

一.使用DelimiterBasedFrameDecoder自动完成以分隔符作为结束标志的解码 1.1 DelimiterBasedFrameDecoder服务端开发 1.1.1 EchoServer实现 import io.netty.bootstrap.ServerBootstrap; import io.netty.buffer.ByteBuf; import io.netty.b

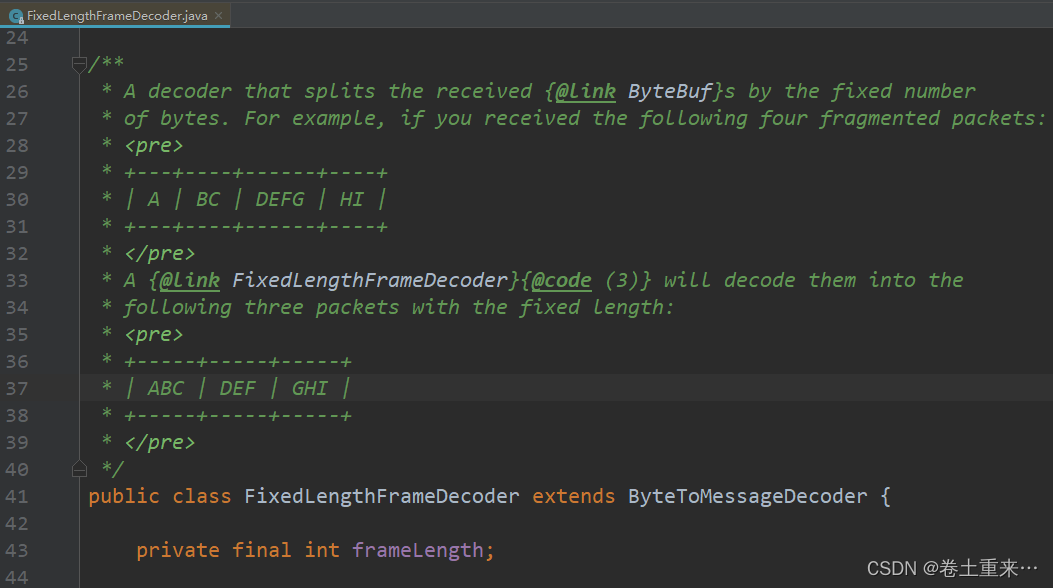

31.FixedLengthFrameDecoder定长解码器

消息会有黏包和半包现象,使用定长帧解码器去解码。FixedLengthFrameDecoder 1.设定一条消息的定长。要找到所有可能发送的消息,找到最大长度的消息作为定长。 2.当客户端消息过来,长度不够定长则等待。等待消息长度够了,再处理。这就保证了是一条完整的消息。如果长度超过了定长,也会把定长段的消息进行处理,剩下的消息和后面的消息合并。 3.这个定长帧解码器handler一定要放在

在线二维码解码器:将二维码转换成网址链接

在当今数字化时代,二维码(QR码)已成为一种便捷的信息传递工具。它不仅可以存储大量数据,还能快速分享信息。然而,有时我们需要将二维码中的内容转换为网址链接,以便在浏览器中直接访问。小编将详细介绍如何使用在线二维码解码器实现这一功能。 一、什么是二维码? 二维码是一种由黑白相间的图案组成的矩形图像,通过扫描设备(如智能手机)可以快速读取其中存储的数据。这些数据可以是网址、文本、联系信息等。

RNN/LSTM/GRU/TRANFORMER/编码器解码器理解

编码器和解码器是一种框架,lstm和gru都是这个框架中对这一框架的不同实现 编码器与解码器是一种架构,一种思想,注意力也是一种思想,相互独立,只是二者可以结合以用来训练模型可以提升模型能力 rnn gru lstm是三种不同的模型 里面并没有注意力机制这回事 RNN中有编码器和解码器实现,为什么要重新使用gru定义解码器和编码器? 编码器和解码器是一种思想,工业界实现目前也仅仅使用一个,但是通过

为什么Transformer的编码器和解码器如此重要?一文带你读懂

Transformer 模型是一种基于自注意力(self-attention)机制的深度学习模型,最初是为了解决自然语言处理(NLP)中的序列到序列(sequence-to-sequence)任务而提出的,如机器翻译。Transformer 由编码器和解码器两部分组成,两者都基于相同的自注意力机制,但它们在功能和使用上有所不同。 编码器(Encoder) 编码器是Transformer模型中的

【开源项目】minimp3 MP3解码器

【开源项目】minimp3 MP3解码器 简介 minimp3 是一个极简的MP3解码器,它的特点是小巧(只有单个头文件)、快速(支持SSE和NEON)和准确(符合ISO标准)。 LICENSE:CC0-1.0 License 项目地址: https://github.com/lieff/minimp3 该项目中提供了在 i7-6700K 上使用 perf粗略测量的基准测试结果: V

Netty(十) Netty5.x 自定义编码解码器

Netty(十) Netty5.x 自定义编码解码器 netty学习目录 一、Netty(一) NIO例子 二、Netty(二) netty服务端 三、Netty(三) Netty客户端+服务端 四、Netty(四) 简化版Netty源码 五、Netty(五)Netty5.x服务端 六、Netty(六) Netty Http 服务器例子 七、Netty(七) Netty服务端+客户

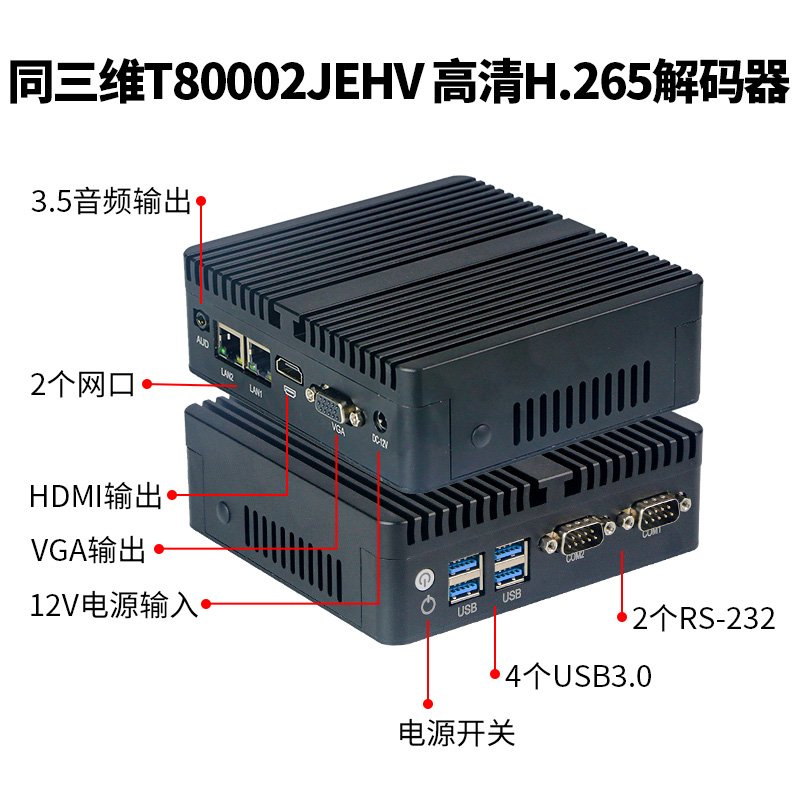

同三维T80002JEHV H.265高清解码器

同三维T80002JEHV H.265高清解码器 1路HDMI+1路VGA解码输出,1/2/4画面分割或16路轮询显示 产品简介: 同三维T80002JEHV解码器使用Linux系统,支持VGA/HDMI二种接口同时输出,支持多流输入多流解码及多屏显示,具有完善的Web控制功能,并提供SDK用于二次开发。支持H265/H264视频解码,支持AAC/MP3高清音频解

同三维T80004JEH2-4K60 双路4K60 HDMI解码器

输出:2路HDMI+2路3.5音频,最高支持1路4K60HDMI输出 可以同源/独立分屏输出两种模式可选:对应两个HDMI输出一样和不一样的信号 同源可以解码36路网络流(1/4/9/16/25/36),两个HDMI输出一样的信号,独立分屏可以解32路网络流,两个HDMI独立解16个不同网络流(1/4/9/16) 自动搜索局域网内onvif设备,一键获取拉流地址 2个网口,一主一备,都

Transformer系列:图文详解Decoder解码器原理

从本节开始本系列将对Transformer的Decoder解码器进行深入分析。 内容摘要 Encoder-Decoder框架简介shifted right移位训练解码器的并行训练和串行预测解码器自注意力层和掩码解码器交互注意力层和掩码解码器输出和损失函数 Encoder-Decoder框架简介 在原论文中Transformer用于解决机器翻译任务,机器翻译这种Seq2Seq问题通常

同三维T80005JEHVA 4K视频解码器

同三维T80005JEHVA视频解码器 可解1路4K30HDMI/VGA/CVBS+1路3.5音频 可解电台音频网络流,可同时解4个网络流,分割输出 可预设十个流,任意切换1路流输出 <!--[endif]----><!--[if !vml]--> <!--![endif]----> 介绍: 同三维T80005JEHVA 4K视频解码器支持多种音视频流协议解码输出,支持HDMI/

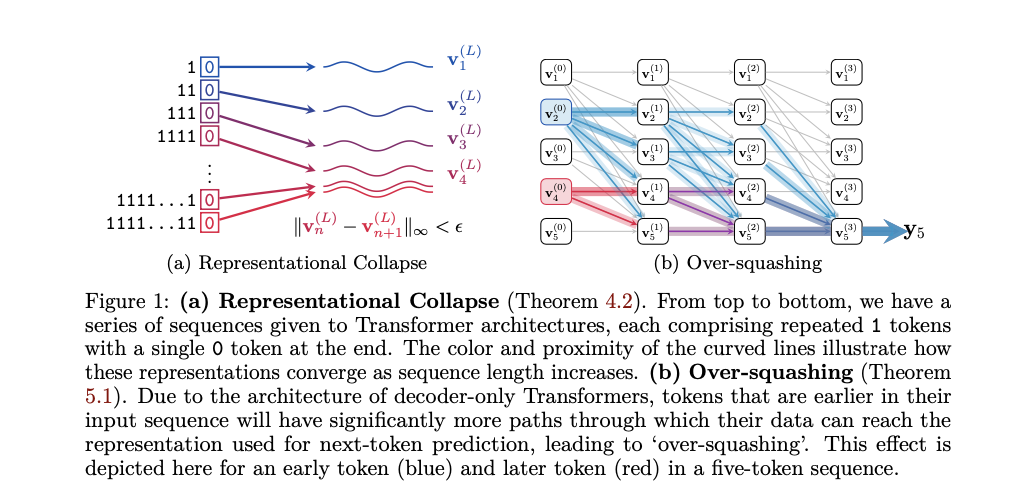

自然语言处理领域的重大挑战:解码器 Transformer 的局限性

每周跟踪AI热点新闻动向和震撼发展 想要探索生成式人工智能的前沿进展吗?订阅我们的简报,深入解析最新的技术突破、实际应用案例和未来的趋势。与全球数同行一同,从行业内部的深度分析和实用指南中受益。不要错过这个机会,成为AI领域的领跑者。点击订阅,与未来同行! 订阅:https://rengongzhineng.io/ 自然语言处理(NLP)领域面临的一个主要挑战是解决解码器 Trans

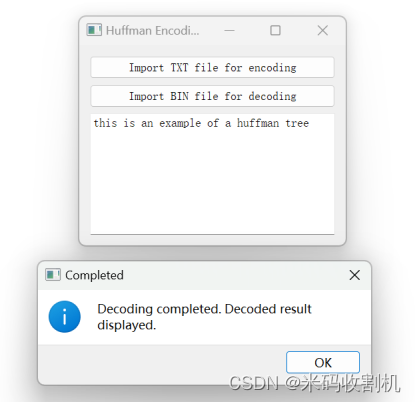

【C++】C++ QT实现Huffman编码器与解码器(源码+课程论文+文件)【独一无二】

👉博__主👈:米码收割机 👉技__能👈:C++/Python语言 👉公众号👈:测试开发自动化【获取源码+商业合作】 👉荣__誉👈:阿里云博客专家博主、51CTO技术博主 👉专__注👈:专注主流机器人、人工智能等相关领域的开发、测试技术。 C++ QT实现Huffman编码器与解码器(源码+课程论文+文件)【独一无二】 目录 C++ QT实现Huffman

使用Python实现GLM解码器的示例(带有Tensor Shape标注)

下面是一个示例,演示了如何使用Python和PyTorch实现一个基于GLM(Glancing Language Model)原理的解码器,包括对每个Tensor的shape进行标注。 代码示例 import torchimport torch.nn as nnimport torch.nn.functional as Fclass GlancingDecoder(nn.Module):d

Transformer系列:图文详解KV-Cache,解码器推理加速优化

前言 KV-Cache是一种加速Transformer推理的策略,几乎所有自回归模型都内置了KV-Cache,理解KV-Cache有助于更深刻地认识Transformer中注意力机制的工作方式。 自回归推理过程知识准备 自回归模型采用shift-right的训练方式,用前文预测下一个字/词,并且前文中的最后一个词经过解码器的表征会映射为其下一个待预测词的概率分布。在训练阶段,句子完整输入给网

【FPGA】Verilog:解码器 | 编码器 | 多路复用器(Mux, Multiplexer)

0x00 什么是解码器 解码器是根据输入信号在多个输出位中选择一个输出位的装置。例如,当解码器接收2位二进制值作为输入时,它可以接收00、01、10、11四种输入值,并根据每个输入值在4个输出位中选择一个,输出为1000、0100、0010、0001中的一种。这样的解码器被称为高电平有效解码器(active high decoder),即输出位中只有一个被选择为1;而低电平有效解码器(a

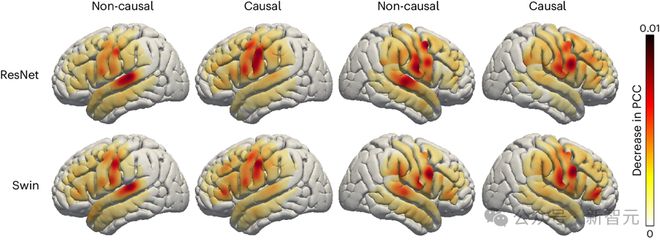

LeCun转发,AI让失语者重新说话!纽约大学发布全新「神经-语音」解码器 | 最新快讯

新智元报道 编辑:LRT 通过采集皮层电图(ECoG)的数据信号,模型可以将其转换为可解释的语音参数(如音高,响度,共振峰频率等),并合成出既准确又自然的语音波形。 脑机接口(BCI)在科研和应用领域的进展在近期屡屡获得广泛的关注,大家通常都对脑机接口的应用前景有着广泛的畅享。 比如,由于神经系统的缺陷造成的失语症不仅严重阻碍患者的日常生活,还可能限制他们的职业

centos7下安装mplayer及其解码器和皮肤

安装mplayer及其解码器和皮肤 本人系统为centos7 参考:http://jingyan.baidu.com/article/1709ad80ab17fc4635c4f070.html 正常步骤 1.去mplayer官网(http://mplayerhq.hu/design7/dload.html)下载相应的软件 [root@localhost mplayer]# lse

Netty笔记5----定长解码器解决粘包

Netty笔记5----定长解码器解决粘包 服务端启动类 import io.netty.bootstrap.ServerBootstrap;import io.netty.channel.ChannelFuture;import io.netty.channel.ChannelInitializer;import io.netty.channel.ChannelOption;i

Netty笔记4----分隔符解码器解决粘包

Netty笔记4----分隔符解码器解决粘包 客户端启动类 import io.netty.bootstrap.Bootstrap;import io.netty.buffer.ByteBuf;import io.netty.buffer.Unpooled;import io.netty.channel.ChannelFuture;import io.netty.channel.

白话transformer(六)编码器与解码器

B 站视频:https://www.bilibili.com/video/BV1fE421T7tR/?vd_source=9e18a9285284a1fa191d507ae548fa01 白话transformer(六) 1、前言 今天我们将探讨Transformer模型中的两个核心组件:编码器和解码器。我们将通过一个具体的任务——将中文算术表达式翻译成英文——来深入理解这两

Transformer模型-decoder解码器,target mask目标掩码的简明介绍

今天介绍transformer模型的decoder解码器,target mask目标掩码 背景 解码器层是对前面文章中提到的子层的包装器。它接受位置嵌入的目标序列,并将它们通过带掩码的多头注意力机制传递。使用掩码是为了防止解码器查看序列中的下一个标记。它迫使模型仅使用之前的标记作为上下文来预测下一个标记。然后,它再通过另一个多头注意力机制,该机制将编码器层的输出作为额外的输入。最后,它