池化专题

GPU池化赋能智能制造

2023年3月10日,“第六届智能工厂高峰论坛”在杭州隆重揭幕。本次会议由e-works数字化企业网、浙江制信科技有限公司主办,中国人工智能学会智能制造专业委员会、长三角新能源汽车产业链联盟、长三角(杭州)制造业数字化能力中心、浙江省智能工厂操作系统技术创新中心协办。趋动科技作为钻石合作伙伴出席了本次峰会,与制造业精英企业以及行业专业人士共同分享制造业在智能工厂推进过程中的成功经验,探讨工厂改进中

最大池化、非线性激活、线性层

一、最大池化原理 二、最大池化实例 import torchimport torchvisionfrom torch import nnfrom torch.nn import MaxPool2dfrom torch.utils.data import DataLoaderfrom torch.utils.tensorboard import SummaryWriterdatas

【小白深度学习入门】【2】池化层详解:工作原理、维度计算、池化类型

《博主简介》 小伙伴们好,我是阿旭。专注于人工智能、AIGC、python、计算机视觉相关分享研究。 👍感谢小伙伴们点赞、关注! 《------往期经典推荐------》 一、AI应用软件开发实战专栏【链接】 项目名称项目名称1.【人脸识别与管理系统开发】2.【车牌识别与自动收费管理系统开发】3.【手势识别系统开发】4.【人脸面部活体检测系统开发】5.【图片风格快速迁移软件开发】6

一文彻底搞懂CNN - 卷积和池化(Convolution And Pooling)

Convolutional Neural Network CNN(卷积神经网络)最核心的两大操作就是卷积(Convolution)和池化(Pooling)。卷积用于特征提取,通过卷积核在输入数据上滑动计算加权和;池化用于特征降维,通过聚合统计池化窗口内的元素来减少数据空间大小。 Convolution And Pooling 一、_卷积(Convolution) 卷积(Convol

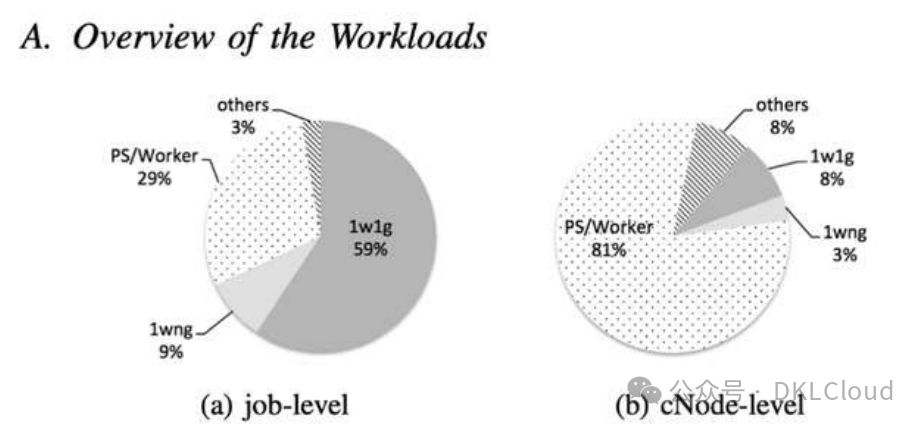

智算中心算力池化技术深度分析报告

智算中心算力池化技术深度分析 智能算力,人工智能基石,助力构建多要素融合信息基础设施。作为数字经济高质量发展核心引擎,智能算力基础设施建设正迎来高潮。 智算中心,作为集约化算力基础设施,以智能算力为核心,包括GPU、AI芯片等,提供全栈软硬件环境。致力于承载模型训练、推理及多媒体渲染等业务,助力千行百业实现数智化转型升级。 算力池化技术是

GenericObjectPool对象池化的介绍与用法

前言 GenericObjectPool 是 Apache Commons Pool 库的一部分,它提供了一个通用的对象池实现,允许用户在需要时从池中借用和返回对象,而不是每次需要一个新实例时都创建一个。这种方法可以显著提高性能,特别是对于创建开销大或需要频繁使用的对象。 哪些对象创建、销毁成本较高 创建和销毁成本较大的 对象有哪些、原因是啥: 数据库连接:建立数据库连接涉及网络通讯以及

DL基础补全计划(六)---卷积和池化

PS:要转载请注明出处,本人版权所有。 PS: 这个只是基于《我自己》的理解, 如果和你的原则及想法相冲突,请谅解,勿喷。 环境说明 Windows 10VSCodePython 3.8.10Pytorch 1.8.1Cuda 10.2 前言 本文是此基础补全计划的最终篇,因为从我的角度来说,如果前面这些基础知识都能够了解及理解,再加上本文的这篇基础知识,那么我们算是小半只脚踏入了大

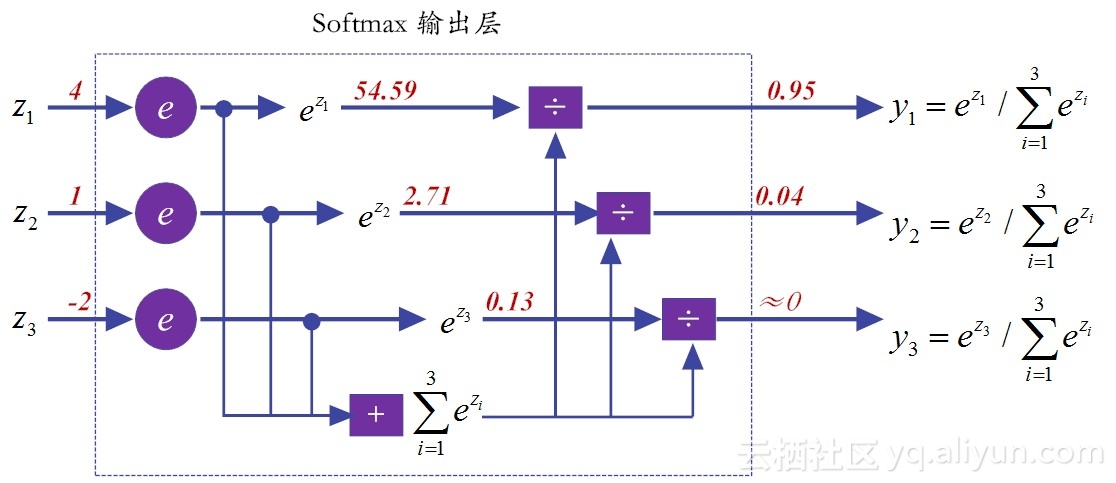

【池化方法】——softpool

转载自:AI人工智能初学者 code 1. 前言 通常卷积神经网络(CNNs)都会使用池化pool操作来减少Feature Map的尺寸。这个过程对于实现局部空间不变和增加后续卷积的感受野是至关重要的。因此池化pool操作应该尽量减少Feature Map映射中信息的丢失。同时,应该限制计算和内存开销。 为了满足这些需求,本文提出了一种快速、高效的池化方法SoftPool,softpo

【池化方法】——strip pooling

转载自:AI算法修炼营 论文链接:https://arxiv.org/abs/2003.13328v1 代码链接:https://github.com/Andrew-Qibin/SPNet 1. 前言 提高卷积神经网络中远程依赖关系建模能力的一种方法是采用self-attention机制或non-local模块。然而,它们会消耗大量内存。 具体文章可以关注:视觉注意力机制:self-a

卷积、池化、反卷积、反池化、上采样的知识点记录

卷积: SAME:输入大小不够时会在右边加padding补足。output_shape = ceil(input_shape/ stride_size) VALID:output_shape = ceil((input_shape + kernel_shape - 1) / stride_size) 池化: 池化没有参数,除非使用tf.nn.max_pool_with_argmax_

【深度学习】激活引入非线性,池化预防过拟合

深度学习的入门过程(截图自《TensorFlow技术解析与实战.李嘉璇.2017.pdf》) 原博文: 12.1 两个看似闲扯的问题 在开讲本章内容之前,先请你思考两个问题呗:第一个问题,你能用直线画出一张漂亮的笑脸吗?第二个问题是,你知道那副著名的对联:“诸葛一生唯谨慎,吕端大事不糊涂”,说得是什么典故吗? 如果你不是抬杠的话,我想你第一个问题的答案,应该是不能。因为直线的表现力非常

分布式MPI实现矩阵乘法、卷积以及池化运算

参考文章:1. 相关代码:https://blog.csdn.net/weixin_56273009/article/details/131280755 2.多主机配置:https://blog.csdn.net/m0_62346268/article/details/134139495、https://blog.csdn.net/liu_feng_zi_/article/details/1084

【深度学习】之 卷积(Convolution2D)、最大池化(Max Pooling)和 Dropout 的NumPy实现

1. 2D 卷积操作 import numpy as npdef conv2d(image, kernel, stride=1, padding=0):"""应用2D卷积操作到输入图像上。参数:- image: 输入图像,2D数组。- kernel: 卷积核,2D数组。- stride: 卷积步幅。- padding: 图像周围的零填充数量。返回值:- output: 卷积操作的结果。"""#

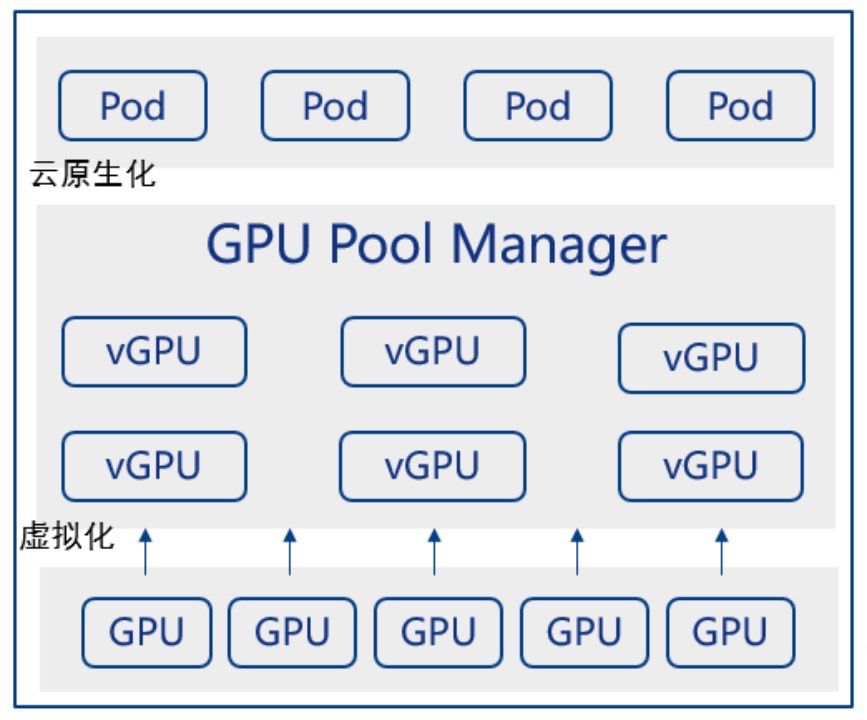

揭秘GPU技术新趋势:从虚拟化到池化

从GPU虚拟化到池化 大模型兴起加剧GPU算力需求,企业面临GPU资源有限且利用率不高的挑战。为打破这一瓶颈,实现GPU算力资源均衡与国产化替代,GPU算力池化成为关键。本文深入探讨GPU设备虚拟化途径、共享方案及云原生实现,旨在优化资源利用,推动算力革命。 汪照辉,中国银河证券杰出架构师,深耕容器云、微服务、DevOps等数据转型技

特征融合篇 | YOLOv8改进之利用新的空间金字塔池化FocalModulation取代SPPF

前言:Hello大家好,我是小哥谈。Focal Modulation Networks(FocalNets)的基本原理是替换自注意力(Self-Attention)模块,使用焦点调制(focal modulation)机制来捕捉图像中的长距离依赖和上下文信息。本文所做的改进是将新的空间金字塔池化FocalModulation取代SPPF模块。🌈 目录

卷积神经网络,卷积和池化

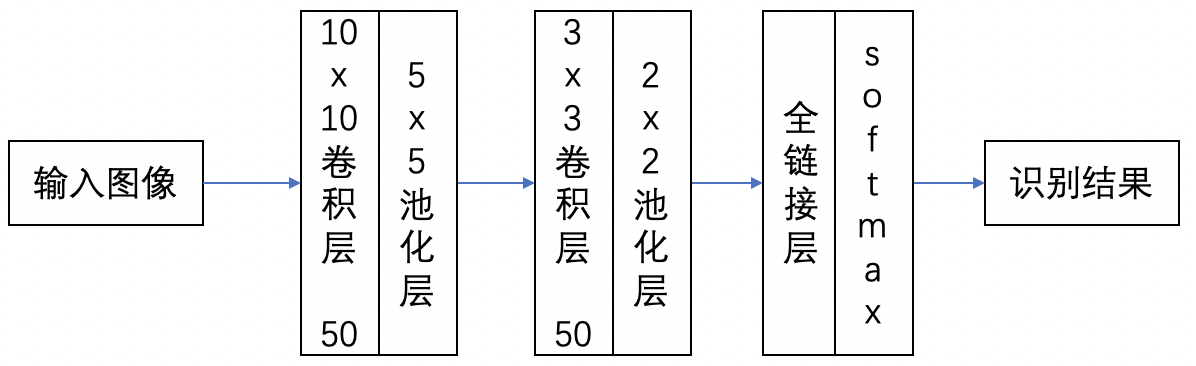

卷积神经网络是一种多层神经网络,擅长处理图像特别是大图像的相关机器学习问题。 卷积网络通过一系列方法,成功将数据量庞大的图像识别问题不断降维,最终使其能够被训练。CNN最早由Yann LeCun提出并应用在手写字体识别上(MINST)。LeCun提出的网络称为LeNet,其网络结构如下: 这是一个最典型的卷积网络,由卷积层、池化层、全连接层组成。其中卷积层与池化层配合,组成多个卷积组,逐层

GpuMall的GPU算力资源池化技术有何优势?

GpuMall的GPU算力资源池化技术具有显著的优势,这些优势使得其在智算云领域脱颖而出,为用户提供了高效、灵活且可靠的GPU算力服务。以下是GpuMall GPU算力资源池化技术的主要优势: GpuMall智算云 | 省钱、好用、弹性。租GPU就上GpuMall,面向AI开发者的GPU云平台 1. 高效利用算力资源 通过GPU算力资源池化技术,GpuMall能够将大量的GPU算力资源进行集

理解CNN参数及PyTorch实例,卷积核kernel,层数Channels,步长Stride,填充Padding,池化Pooling,PyTorch中的相关方法,MNIST例子

1.34.理解CNN参数及PyTorch实例 1.34.1.卷积核kernel 1.34.2.层数Channels 1.34.3.步长Stride 1.34.4.填充Padding 1.34.5.池化Pooling 1.34.6.PyTorch中的相关方法 1.34.7.MNIST例子 1.34.理解CNN参数及PyTorch实例 参考地址:http://guileen.github.io/2

一位中国博士把整个 CNN 都给可视化了,可交互有细节,每次卷积 ReLU 池化都清清楚楚...

本文经AI新媒体量子位(公众号ID:qbitai)授权转载,转载请联系出处 本文约900字,建议阅读5分钟。 本文带你一张图看懂CNN。 标签:人工智能技术 CNN是什么?美国有线电视新闻网吗? 每一个对AI抱有憧憬的小白,在开始的时候都会遇到CNN(卷积神经网络)这个词。 但每次,当小白们想了解CNN到底是怎么回事,为什么就能聪明的识别人脸、听辨声音的时候,就懵了,只好理解为玄学: 好吧,

AI视觉入门:卷积和池化

从2012年以AlexNet为代表的模型问世以来,人工智能尤其是视觉cv部分飞速发展,在刚开始效果不如人类,到2015年在ImageNet1000数据集的表现就超过了人类。在Transformer模型出现之前,视觉模型的主要组成部分就是卷积和池化,AI就是靠卷积和池化实现了对人类的超越。 卷积和池化 卷积和池化,作为深度学习的核心组件,尤其在卷积神经网络(CNN)中扮演着不可或缺的角色。它们在

Pytorch中Tensor的各种池化操作

AdaptiveAvgPool1d(N) 对一个C*H*W的三维输入Tensor, 池化输出为C*H*N, 即按照H轴逐行对W轴平均池化 >>> a = torch.ones(2,3,4)>>> a[0,1,2] = 0>>>> atensor([[[1., 1., 1., 1.],[1., 1., 0., 1.],[1., 1., 1., 1.]],[[1., 1., 1., 1.],

卷积神经网络的基本概念——【1】卷积和池化

卷积神经网络利用滤波器(即内核)来检测图像中展示的特征,例如边缘。卷积神经网络四个主要的操作如下: 卷积 非线性(ReLU) 池化或子采样(Sub Sampling) 分类(全连接层) 一、卷积 卷积是两股信息源交织在一起的有序的过程;亦是一个把函数转换成其它东西的操作。 卷积已经长时

PyTorch----torch.nn.AdaptiveAvgPool2d()自适应平均池化函数

AdaptiveAvgPool2d是PyTorch中的一个模块,用于卷积神经网络(CNNs)中的自适应平均池化。它通常用于需要将输入张量的大小调整为固定大小,而不考虑其原始尺寸。 “自适应”方面是指输出大小是由用户指定的,而不是固定的。这为模型设计提供了更大的灵活性,因为池化操作可以适应不同的输入大小。 以下是AdaptiveAvgPool2d的工作原理: 输

深入理解RCNN:区域建议与区域兴趣池化技术解析

引言 随着深度学习技术的发展,目标检测在计算机视觉领域扮演着越来越重要的角色。RCNN(Region-based Convolutional Neural Network)是一种经典的深度学习模型,它通过引入区域建议和区域兴趣池化技术,实现了对图像中目标的准确检测和定位。本文将深入探讨RCNN模型的原理、工作流程以及优缺点,并结合示例详细说明区域建议和区域兴趣池化的工作原理。 RCNN模型概述