提速专题

使用 Flask-Cache 缓存给Flask提速

Django里面可以很方便的应用缓存,那Flask里面没准备这么周全怎么办?自己造轮子么?不用的,前人种树后人乘凉,我们有Flask-Cache,用起来和Django里面一样方便哦! 1.安装 pip install Flask-Cache 2.配置 以我的zhihu项目(源码)为例: 在config.py里面,设置simple缓存类型,也可以用第三方的redis之类的,和Django一

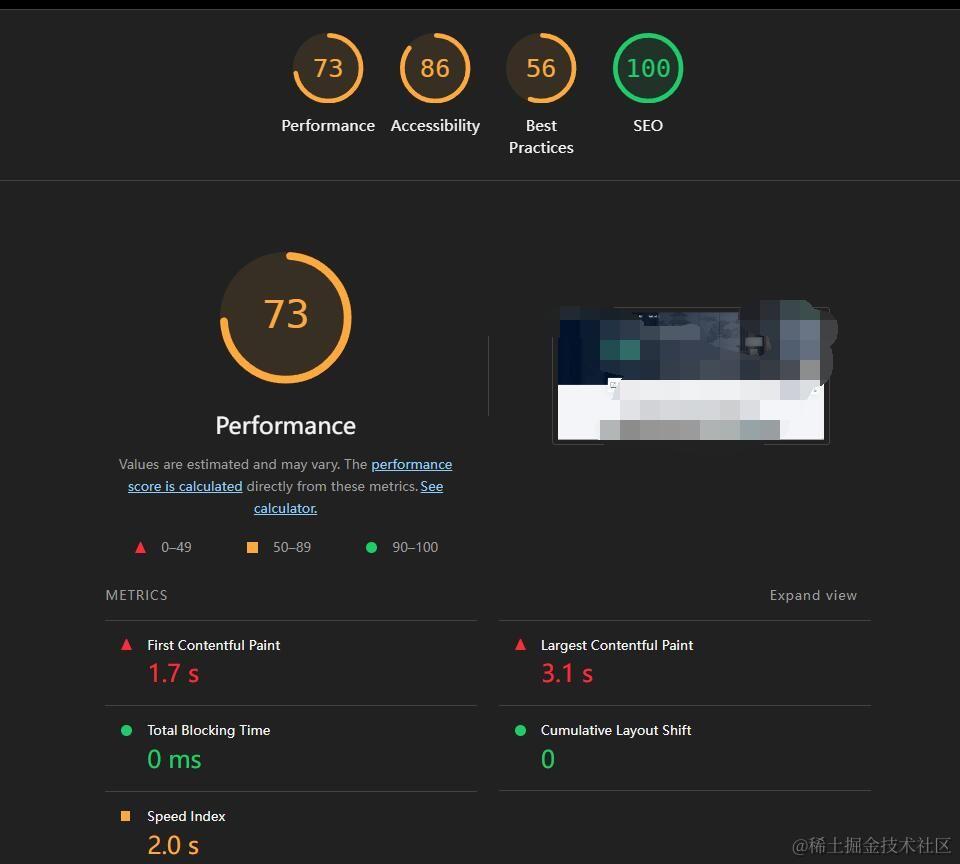

Nuxt 项目实战 - 16:利用CDN+OSS给网站全面提速

背景 我面试过一些前端同学,同时也看到网上很多前端同学说可以利用CDN加速,提高网站的访问速度,具体如何搞?具体如何配置?估计很多前端都是不知道的,一方面权限所限,另一方面可能只是知道可以利用CDN加速网站,具体如何搞完全不知道,其实我也不太清楚😅。现在我有权限操作打算好好实践一番,让CDN好好给我开发的Nuxt网站提提速。🥰 创建和配置OSS Bucket 注意:读写权限写成

Access SQL 语句优化提速

exists() 语句 条件放在外面提速不少 select * from T_ZDJZD a where exists(select * from T_ZDJZX b where a.ZD_ID=b.ZD_ID and ZD_ID=73090 and a.JZD_ID=b.QS_JZD and a.JZ_XH<>b.JZ_XH) 优化为: select * from T_ZDJZD

碳化硅普及再提速!天岳先进上半年营收翻倍

导语 扭亏为盈,营收翻倍!2024年上半年碳化硅渗透速度有多快? 8月23日,国内碳化硅衬底龙头天岳先进发布了2024年半年报,上半年实现营业收入9.12 亿元,较上年同期增长 108.27%;归母净利润 1.02 亿元,同比增加 241.40%,较上年同期扭亏为盈。这已是天岳先进连续第 9 个季度保持营收增长趋势。 天岳先进2024年上半年业绩情况 图片来源:天岳先进

豆包大模型迎来多维升级:综合性能提升20.3% 零售、汽车等行业落地提速

2024年无疑是科技行业公认的“AI大模型落地元年”,大模型应用的供需关系正在经历着前所未有的变化。 与过去AI厂商单方面探索应用场景的做法不同,今年我们见证了更多的重要行业和头部企业,在降本提效、以技术驱动新发展和新升级的需求之下,开始以更加开放的姿态主动拥抱大模型,并探索AI技术与自身业务深度融合的可能性。 有数据表明,大模型技术正在带来生产力水平的大跃迁。据红杉美国发布的报告,生成式AI

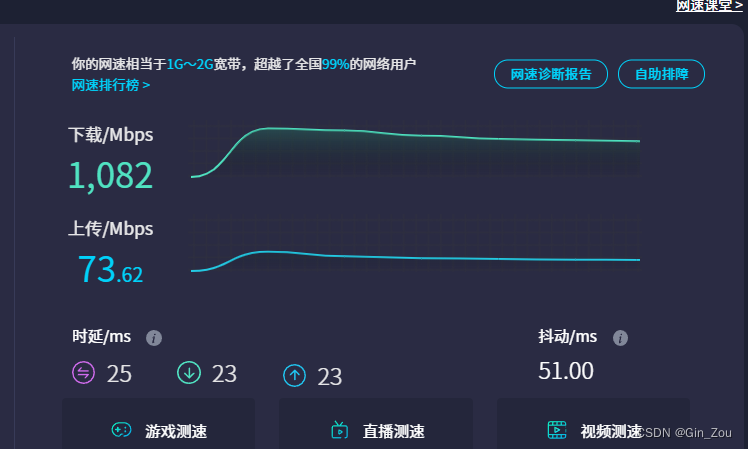

关于使用绿联 USB-A转RJ45 2.5G网卡提速的解决问题

问题 网络下载速率低 我的自带网卡是 I219v 在嵌入了2.5G网络后一直无法到达1.5G以上。 平均测速300~500M 解决方案 更新了USB的网卡驱动 禁用了 I219-V的驱动。测速即可 USB下载地址 https://download.csdn.net/download/qq_28198181/89468806

pip下载越来越慢,需要怎么提速了?

pip下载慢通常是因为默认的Python包索引服务器在国外,国内访问受到网络限制。 为了解决这个问题,可以尝试以下几种方法来提高pip下载速度: 更换镜像源: 中国科技大学、清华大学等国内高校提供了Python包索引的镜像,你可以使用这些镜像来替代默认的PyPI源。例如,使用清华大学的镜像: pip install -i https://pypi.tuna.tsinghua.edu.cn/si

产业生态远超预期,商用进程全面提速:5G RedCap,凭什么这么火?

2022年6月,3GPP R17版本正式宣布冻结。除了针对传统5G技术标准进行完善之外,R17还推出了一项新的中高速物联技术标准,也就是我们今天文章的主角——RedCap。 RedCap推出后,受到了业界上下的广泛关注。它在传统5G的基础上,对一部分功能和协议进行了裁剪,虽然速率等性能指标有所削弱,但也大幅降低了成本和功耗。因此,它也被人们称为轻量化5G,或者“5G青春版”。 RedCap是R

如何将IAST工具引入DevSecOps,让开发安全提速

随着数字化发展的不断深入,软件应用的迭代要求越来越高,既要保持产品的快速交付,又要持续保障交付物的安全与质量,在此需求下,DevSecOps的重要性日益凸显。在开发(Dev)、安全(Sec)和运维(Ops)的每个阶段都融入安全实践,是确保软件全生命周期安全的关键策略。 在DevSecOps理念中,“安全”已不再是开发流程的附属品,而是与开发、测试、部署等环节并驾齐驱,形成了一条无缝衔接的安

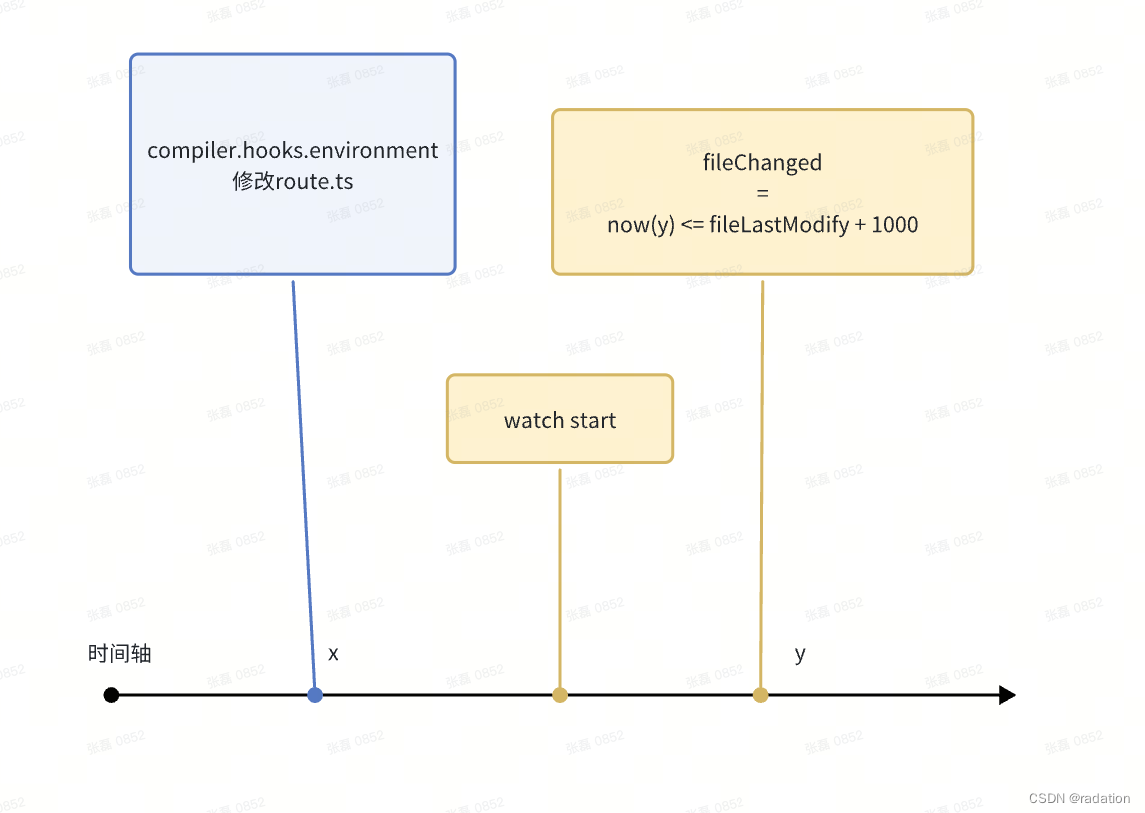

缩窄route范围来提速本地打包的尝试

目录 为什么要缩窄route范围缩窄route的方式意外触发的重复构建重复构建的原因解决方案 为什么要缩窄route范围 对于一些大单页,单个router-view中可能包含上百个页面。但是开发的时候其实并不需要那么多调试那么多页面。 因此,为了节省不必要的打包和热更新时间,可以对route进行缩窄 缩窄route的方式 笔者这里以webpack-plugin的方式去做构建时

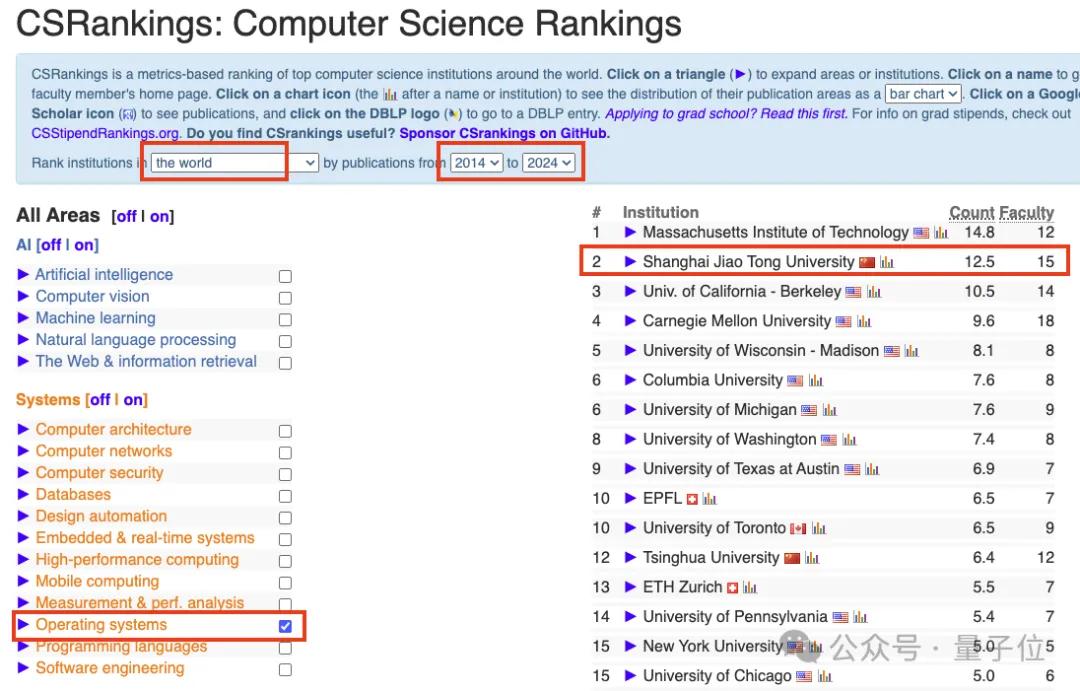

手机流畅运行470亿大模型:上交大发布LLM手机推理框架PowerInfer-2,提速29倍

卡奥斯智能交互引擎是卡奥斯基于海尔近40年工业生产经验积累和卡奥斯7年工业互联网平台建设的最佳实践,基于大语言模型和RAG技术,集合海量工业领域生态资源方优质产品和知识服务,旨在通过智能搜索、连续交互,实时生成个性化的内容和智能化产品推荐,为用户提供快速、可靠的交互式搜索服务,首创了聚焦工业领域的智能交互引擎。 详情戳:智能交互引擎https://datayi.cn/w/DPWgDgjP 苹果

IAST面面观 | 将IAST工具引入DevSecOps,让开发安全提速

随着数字化发展的不断深入,软件应用的迭代要求越来越高,既要保持产品的快速交付,又要持续保障交付物的安全与质量,在此需求下,DevSecOps的重要性日益凸显。在开发(Dev)、安全(Sec)和运维(Ops)的每个阶段都融入安全实践,是确保软件全生命周期安全的关键策略。 在DevSecOps理念中,“安全”已不再是开发流程的附属品,而是与开发、测试、部署等环节并驾齐驱,形成了一条无缝衔接的安

EXCEL VBA终极提速,超级公式,算法优化

1,简化公式,200个字变成10个字 有很多公式写的很长,看不懂很难维护,如果改成VBA代码,简化成一个超级函数,方便维护,还可以给多个工程共用,实现模块化开发 2,计算提速。有些vba运算很慢,需要几分钟到几小时,用好的方法,运行速度可以减到1分钟以内甚至10秒以内。 这2天做了一个3万个左右的订单表和产品销售统计的算法。 原来的主人,运行后就卡死了,后面按10个产品去查找订单,需要1秒左右,那

算法提速cin加速读取文件

static auto x = []() {// turn off syncstd::ios::sync_with_stdio(false);// untie in/out streamscin.tie(NULL);return 0;}(); 有效使得算法读入大文件的速度cin和scanf相当。

用ForkJoin框架为归并排序提速

归并排序典型的分治思想的算法。每层递归有三个步骤 分解(Divide):将n个元素分成个含n/2个元素的子序列。解决(Conquer):用合并排序法对两个子序列递归的排序。合并(Combine):合并两个已排序的子序列已得到排序结果。 使用递归算法的代码demo public class SortArray {int[] tmp;public int[] sortArray(int[] nu

大模型生成提速2倍!单GPU几小时搞定微调,北大数院校友共同一作丨开源

只需给大模型“加点小零件”,推理速度立刻提升2倍! 不需要额外训练一个模型,也不需要对计算硬件做优化,单张A100最快几小时就能微调完成。 这项新研究名叫Medusa(美杜莎),来自普林斯顿、UIUC、CMU和康涅狄格大学,FlashAttention作者Tri Dao也在其中。 目前,它已经成功部署到伯克利70亿参数的“骆马”Vicuna中,后续还会支持其他大模型,已经登上GitH

为wordpress提速,禁用gravatar,使用本地头像

亲测可用,若有疑问请私信 WordPress默认的头像是读取gravatar.com上的图片的,对于国内用户来说会使网页打开速度变慢。所以我决定删除掉这块功能。 修改get_avatar函数,在wp-includes/pluggable.php内。修改后的函数如下: if ( !function_exists( 'get_avatar' ) ) : /** * Retrieve the

AI新突破:多标签预测技术助力语言模型提速3倍

DeepVisionary 每日深度学习前沿科技推送&顶会论文分享,与你一起了解前沿深度学习信息! 引言:多标签预测的新视角 在人工智能领域,尤其是在自然语言处理(NLP)中,预测模型的训练方法一直在不断进化。传统的语言模型,如GPT和BERT,主要依赖于单标签预测,即在给定前文的情况下预测下一个最可能的单个词。然而,这种方法虽然在许多任务上表现出色,但在处理需要更广泛上下文理解的复杂任务时,

大模型的实践应用23-深度混合的transformer改造模型MoD,计算提速50%,算力资源大大节省

大家好,我是微学AI,今天给大家介绍一下大模型的实践应用23-深度混合的transformer改造模型MoD,计算提速50%,算力资源大大节省。“Mixture-of-Depths Transformer”是创新型语言模型,与传统的模型不同,这个模型能够根据输入序列的特定部分动态调整其计算资源的分配,而不是简单地对所有部分进行平均分配。这种策略使得模型在保持原有性能的同时,能够显著减少计算量,从而

提速20倍!3个细节优化Tableau工作簿加载过程(附实例)

作者:Jeffrey A. Shaffer;翻译:张玲;校对:丁楠雅; 本文约3000字,建议阅读10分钟。 本文为你简要介绍快速加载Tableau工作簿的技巧,以优化其性能。 Katarzyna "Kasia" Gasiewska的Tableau Public主页上经常有一些精彩的可视化作品,她拥有100多位粉丝,如果你没有位列其中,那么你遗憾地错过了不少作品。 她在Twitter上发表

P1020 导弹拦截(dp,二分提速)

这是什么神仙想出来的方法! 题目描述 某国为了防御敌国的导弹袭击,发展出一种导弹拦截系统。但是这种导弹拦截系统有一个缺陷:虽然它的第一发炮弹能够到达任意的高度,但是以后每一发炮弹都不能高于前一发的高度。某天,雷达捕捉到敌国的导弹来袭。由于该系统还在试用阶段,所以只有一套系统,因此有可能不能拦截所有的导弹。 输入导弹依次飞来的高度(雷达给出的高度数据是 \le 50000≤50000的正整数)

加州理工华人用AI颠覆数学证明!提速5倍震惊陶哲轩,80%数学步骤全自动化

加州理工团队解决了形式化研究神器Lean运行LLM推理时的核心技术挑战,可以让LLM在Lean中提出证明策略,允许人类以无缝的方式干预和修改。 Lean Copilot,让陶哲轩等众多数学家赞不绝口的这个形式化数学工具,又有超强进化了? 就在刚刚,加州理工教授Anima Anandkumar宣布,团队发布了Lean Copilot论文的扩展版本,并且更新了代码库。 论文地址:http

Stinger Initiative:让Hive提速100倍

摘要:在Hadoop生态圈,没有一家公司有比Hortonworks有更高的统治力,在Apache Hadoop社区,他占据最多的PMC和committer。他和Cloudera是社区利益最主要的争夺者。Stinger Initiative是一个彻底提升Hive效率的工具,与此同时,Hortonworks还在Apache孵化着多个项目,进一步扩大领地。 自从2007年Facebook提出

数据蒋堂 | JOIN提速 - 外键指针的衍生

来源:数据蒋堂 作者:蒋步星 本文长度为1320字,建议阅读3分钟 本文为你讲解外间指针的衍生。 我们继续讨论外键JOIN,并延用上一篇的例子。 当数据量大到无法全部放进内存时,前述的指针化方法就不再有效了,因为在外存无法保存事先算好的指针。 一般来讲,外键指向的维表容量较小,而不断增长的事实表要大得多。如果内存还能把维表放下的话,我们可

数据蒋堂 | JOIN提速 - 外键指针化

来源:数据蒋堂 作者:蒋步星 本文长度为1520字,建议阅读4分钟 本文为你讲解重新定义JOIN后如何能够提高运算性能。 我们来看重新定义JOIN后如何能够提高运算性能,先看外键式JOIN的情况。 设有两个表: 其中sales表中的productid是指向products表中id字段的外键,id是products表的主键。 现在我们想计算销售额有多少(为简化讨论,就不再设