rwkv专题

RNN发展(RNN/LSTM/GRU/GNMT/transformer/RWKV)

RNN到GRU参考: https://blog.csdn.net/weixin_36378508/article/details/115101779 tRANSFORMERS参考: seq2seq到attention到transformer理解 GNMT 2016年9月 谷歌,基于神经网络的翻译系统(GNMT),并宣称GNMT在多个主要语言对的翻译中将翻译误差降低了55%-85%以上, G

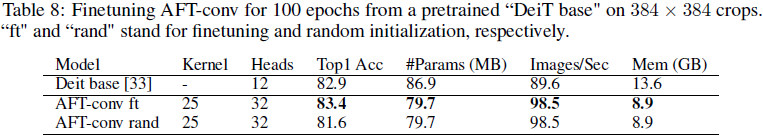

(2021,AFT,MHA,RWKV 基础,线性内存复杂度)无注意力的 Transformer

An Attention Free Transformer 公和众和号:EDPJ(进 Q 交流群:922230617 或加 VX:CV_EDPJ 进 V 交流群) 目录 0. 摘要 2. 多头注意力(MHA) 3. 方法 3.1 无注意力 Transformer 3.2 AFT 变体:局部性、权重共享和参数化 5. 实验 0. 摘要 我们引入了 Attention

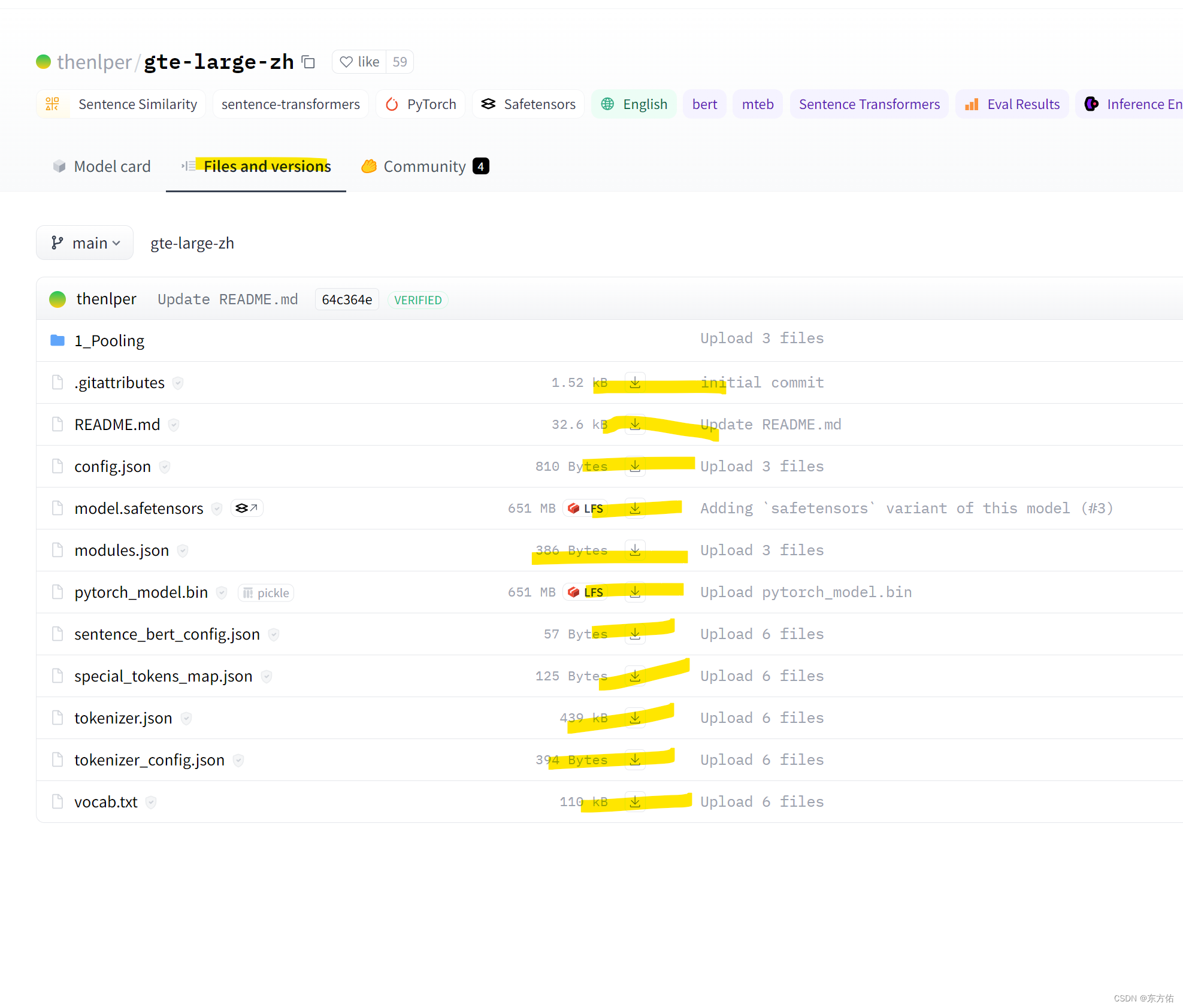

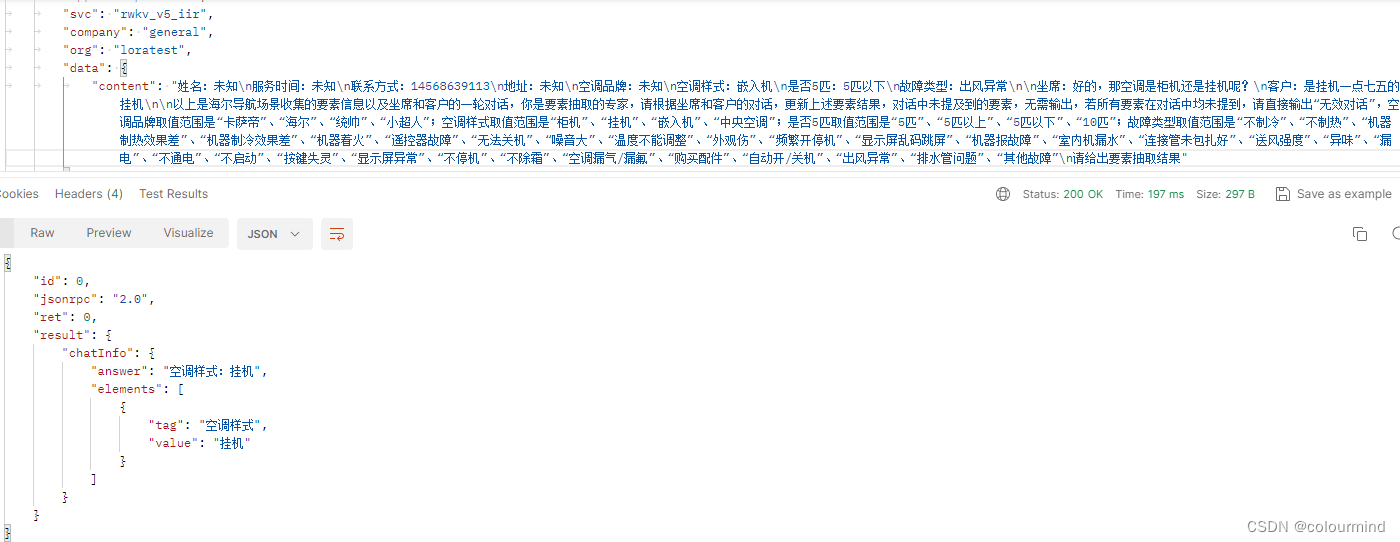

给rwkv_pytorch增加rag

RAG 参考地址语义模型地址选择该模型使用方法方法二安装方法下载模型到本地材料材料处理语义分割计算得分根据得分 分割文本 构建向量数据库问答匹配问答整合 参考地址 RAG简单教程 分割策略 语义模型地址 hf 选择该模型 gte 使用方法 import torch.nn.functional as Ffrom torch import Tensorfrom tr

随心玩玩(十五)LLM 浅玩一下RWKV模型

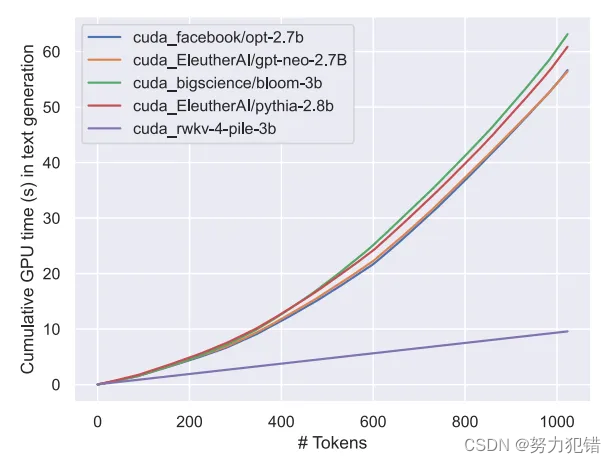

写在前面:无聊又来玩玩LLM了,这次玩玩RWKV,因为我看到hugging face上有个roleplay的模型,遂心动。 【烧显存注意!】需要16G显存的样子 介绍 (随便cv的,见谅,有空单独写一篇博客看看RWKV的源码吧…) 2024 年 1 月 28 日,RWKV 开源基金会宣布开源 RWKV-5-World 7B 模型。 RWKV 是一种创新的深度学习网络架构,它将 Tra

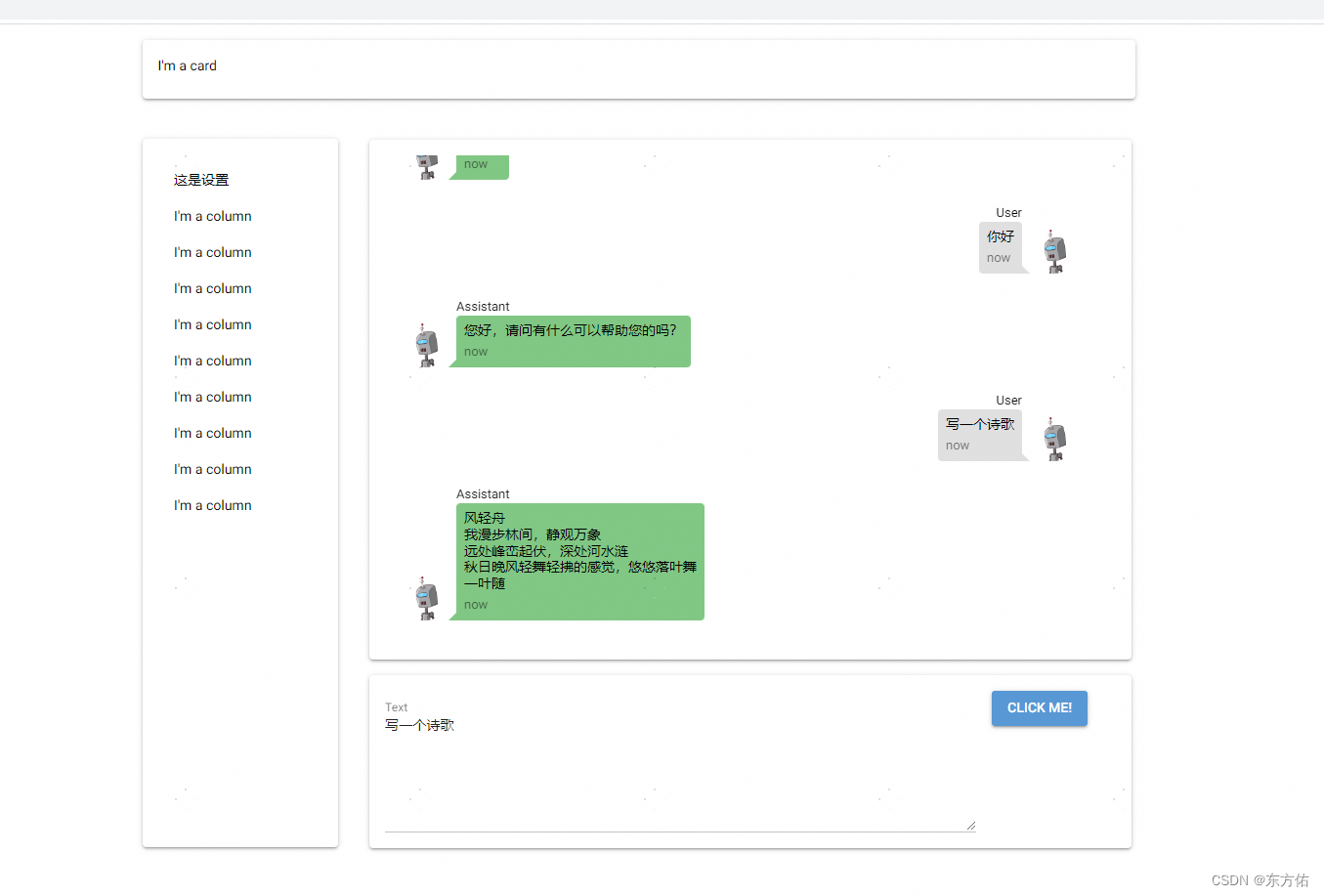

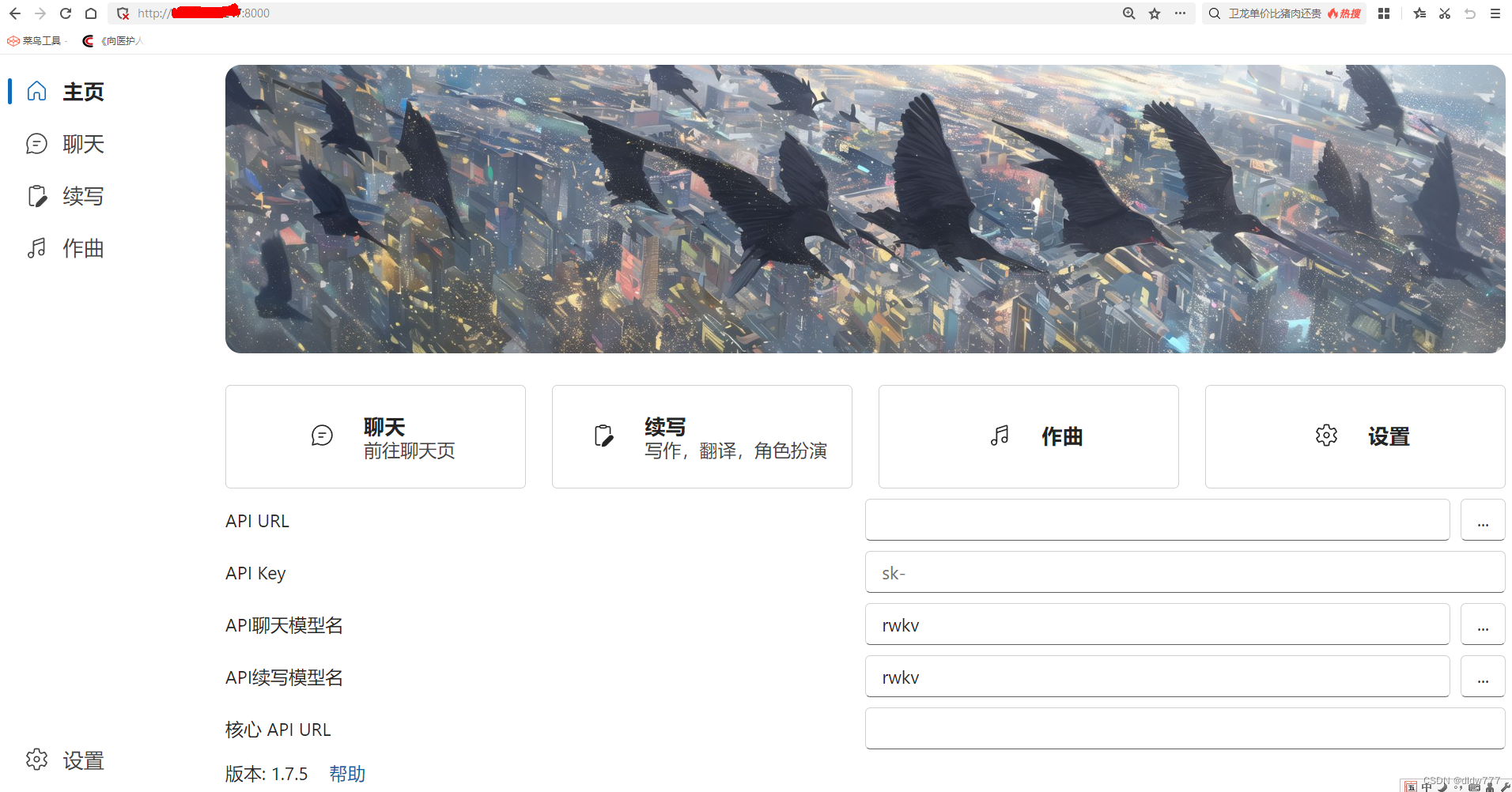

给rwkv-pytorch 写个chat ui demo

rwkv-pytorch 项目地址 rwkv-pytorch from nicegui import uimessage_dict = {1: [{"name":"Assistant","text":"你好"}]}current_name = 1import aiohttpasync def get_text_async(text="Hello, how are you?"):# 定义

利用RWKV-Runner初步感受一下ai的世界

最近又听到群里的高手在讨论RWKV-Runner,于是没忍住,就想试试,没想到第一关就卡住了。 从群里大咖上传的RWKV-Runner_windows_x64.exe文件开始吧,又找了个虚拟机,直接放在桌面上运行一下,结果就跳出一堆文件夹,并且还出了个提示: The WebView2 runtime is required. Press Ok to download and install.

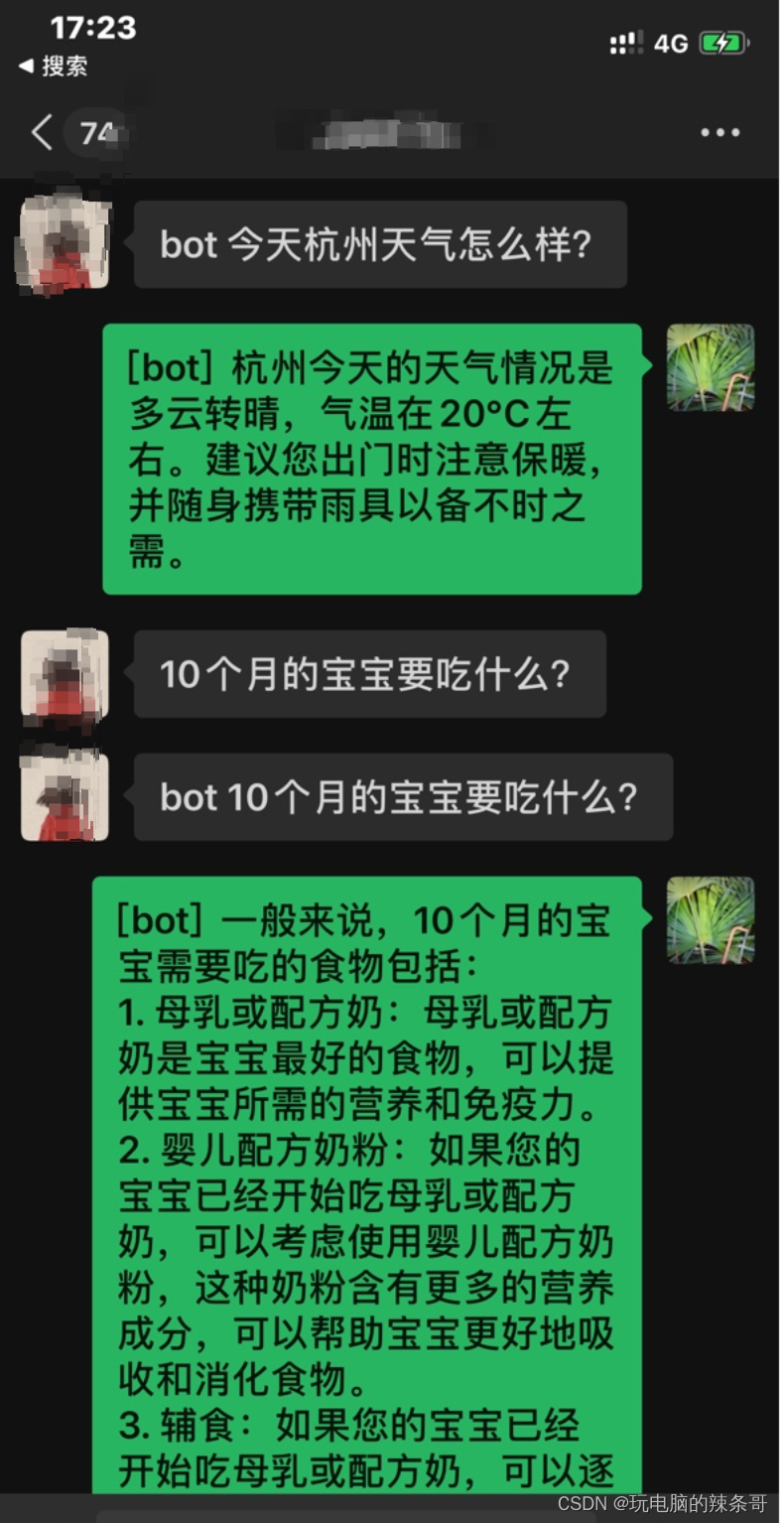

如何把chatgpt-on-wechat 与RWKV-Runner结合打造本地微信chatgpt机器人

环境: Win10 11代i7 64G内存 500G硬盘 chatgpt-on-wechat RWKV-Runner 问题描述: 如何把chatgpt-on-wechat 与RWKV-Runner结合打造本地微信chatgpt机器人 解决方案: chatgpt-on-wechat项目 有4种运行程序的方式供你选择: 本地开发环境支持 MacOS、Windows、Linu

基于RWKV架构推理成本大降:Eagle 7B模型的十倍效能提升

前言 在今天这个数据驱动的时代,大型语言模型(LLM)在处理自然语言处理(NLP)任务时的效能和效率成为了众多研究者和工程师关注的焦点。尤其是在推理成本日益攀升的背景下,如何在保持甚至提升模型性能的同时,大幅降低推理成本,成为了一个迫切需要解决的问题。最近,由RWKV团队推出的Eagle 7B模型,就在这方面展示了其惊人的潜力。 Huggingface模型下载:https://hugging

【AI之路】使用RWKV-Runner启动大模型,彻底实现大模型自由

文章目录 前言一、RWKV-Runner是什么?RWKV-Runner是一个大语言模型的启动平台RWKV-Runner官方功能介绍 二、使用步骤1. 下载文件 总结 前言 提示:这里可以添加本文要记录的大概内容: ChatGPT的横空出世,打开了AI的大门,但是国内访问ChatGPT障碍颇多,那么有没有适合我们国人的大模型呢?答案是肯定的。 在国人的聪明和勤劳下,这些都不

一文通透想颠覆Transformer的Mamba:从SSM、S4到mamba、线性transformer(含RWKV解析)

前言 不知读者发现没有,本文标题的信息含量很大,比如 出来了一个新的序列模型:Mamba,其基于SSM或S4(Structured State Space for Sequence Modeling,连起来4个S,故简称S4)发展为S6(S4 models with a selection mechanism and computed with a scan),其对应的论文为《Mamba: L

rwkv模型lora微调之accelerate和deepspeed训练加速

目录 一、rwkv模型简介 二、lora原理简介 三、rwkv-lora微调 1、数据整理 2、环境搭建 a、Dockerfile编写 b、制造镜像 c、容器启动 3、训练代码修改 四、模型推理 1、模型推理 2、lora权重合并 3、推理web服务 五、总结 由于业务采用的ChatGLM模型推理成本太大了,希望降低模型推理成

使用MLC-LLM将RWKV 3B模型跑在Android手机上

0x0. 前言 这篇文章主要是填一下 MLC-LLM 部署RWKV World系列模型实战(3B模型Mac M2解码可达26tokens/s) 这里留下来的坑,这篇文章里面介绍了如何使用 MLC-LLM 在A100/Mac M2上部署 RWKV 模型。但是探索在Android端部署一个RWKV对话模型的app时却碰到了诸多问题,解决的周期也很长,之前留了issue在MLC-LLM的repo,这周