resnext专题

ResNeXt - Aggregated Residual Transformations for Deep Neural Networks

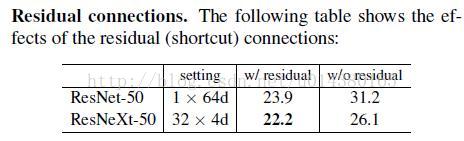

《Aggregated Residual Transformations for Deep Neural Networks》是Saining Xie等人于2016年公开在arXiv上: https://arxiv.org/pdf/1611.05431.pdf 创新点 1.在传统Resnet基础上采用group convolution,在不增加参数量的前提下,获得更强的representat

深度学习 Day27——J7对于ResNeXt-50算法的思考

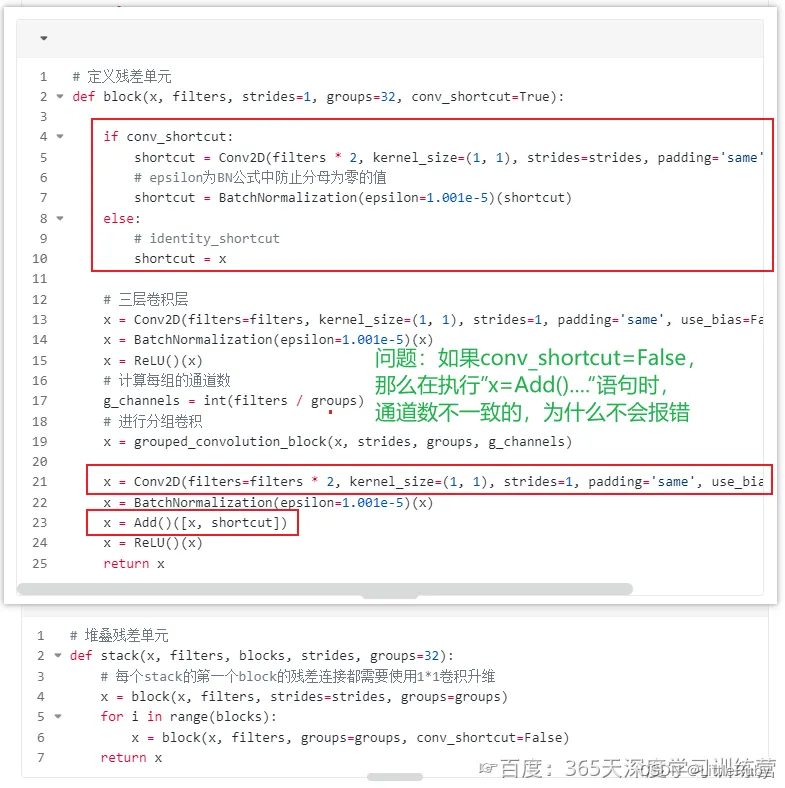

🍨 本文为🔗365天深度学习训练营 中的学习记录博客🍖 原作者:K同学啊 | 接辅导、项目定制🚀 文章来源:K同学的学习圈子 文章目录 前言问题分析 前言 关键问题:ResNeXt-50中conv_shortcut=False时,block函数中ADD()的两个输入通道不同为什么不报错 本周打卡需要完成以下问题 📌你需要解决的疑问:这个代码是否有错?对错与否

霹雳学习笔记——6.1.2 ResNeXt

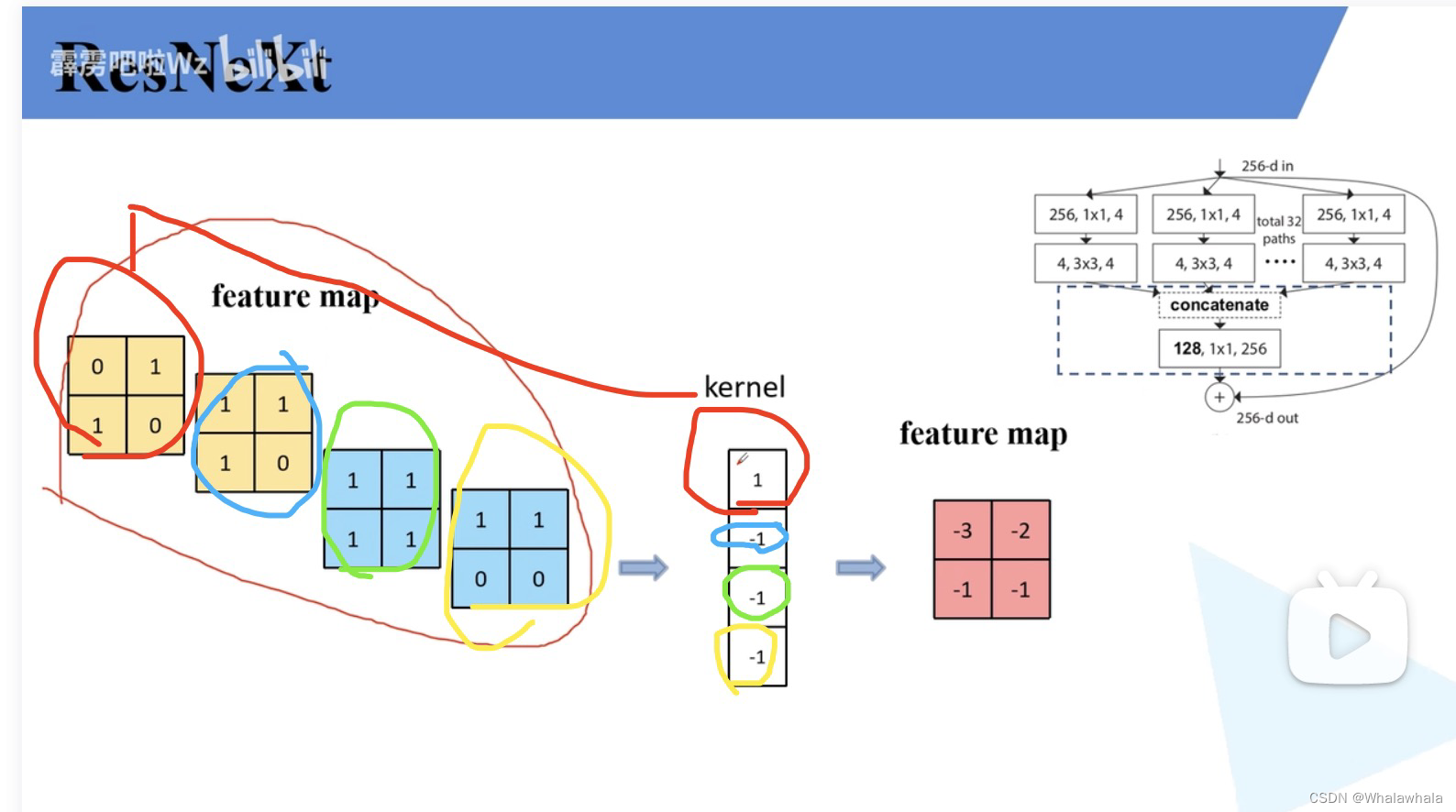

相比于ResNet,更新了block 效果:错误率低于ResNet,并且计算量一样。 对比卷积和组卷积,参数个数会变成1/g倍,g是分成了g组 最终输出的channel与卷积核的个数相同。 (好像是。。。好像之前听过这个,这个图也是这样的) 搞明白了多个卷积核与多通道输入的关系了!!!(理论上应该是输入是几channel,卷积核就是几个,卷积核几个,输出几channel)

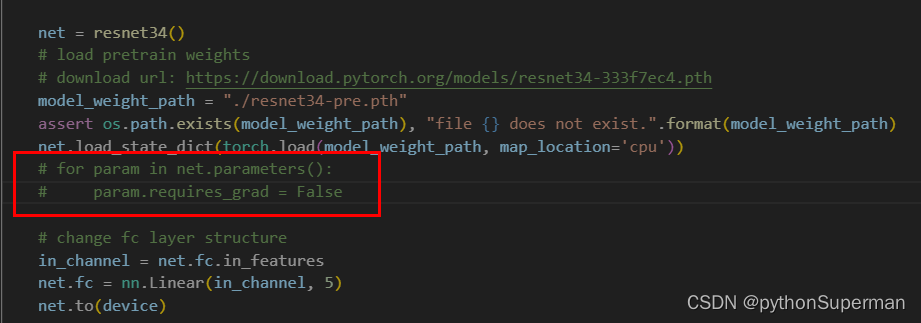

使用pytorch搭建ResNeXt并基于迁移学习训练

冻结除最后全连接层以外的所有权重,只去单独训练它最后一层的的权重,这个方法,冻结了所有网络的权重。 for param in net.parameters():param.requires_grad = False

新resnet和resnext结构的改动

对resnet 和resnext 网络结构进行修改。主要修改为两处 第一处: 原先的bottleneck 模块三层卷积层, 1*1 increase_dim=True:stride=2 increse_dim=False:stride=13*3stride=11*1stride=1 而网站上有这样一句话: 且在

『青年AI自强计划』第6章视觉分类任务LeNet5,AlexNet,ZFNet,VGG,GoogleNet,ResNet,ResNeXt,SENet,MobileNet!

视觉分类任务 文章目录 一、分类任务简介1.1、分类发展简史 二、卷积知识回顾2.1、卷积运算2.2、池化运算2.3、padding运算2.4、三维卷积(池化)2.5、LeNet5 :一切的原点 三、AlexNet&ZFNet3.1、AlexNet(2012):深度CNN与BD的首次触电3.2、ZFNet(2013):过渡,对AlexNet小调整 四、VGG(2014):“标准模块+堆叠”

2023暑期培训【week 3】——ResNet+ResNeXt

目录 1.ResNet+ResNeXt 1.1 ResNet 1.2 ResNeXt 2.猫狗大战代码练习 2.1 LeNet 2.2 ResNet 3.问题理解 1 ResNet+ResNeXt 1.1 ResNet ResNet(残差网络)是一种深度残差神经网络结构,由Microsoft Research团队于2015年提出。它是针对训练非常深的神经网络时遇到的梯度消失

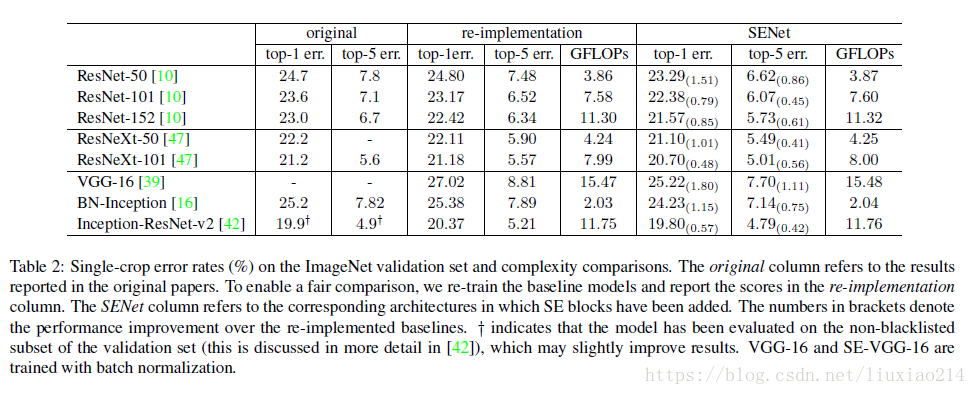

经典卷积神经网络总结:Inception v1\v2\v3\v4、ResNet、ResNext、DenseNet、SENet等

本文为总结今年来的卷积神经网络,主要按照时间线和方法类似程度的顺序总结。 开篇先前说下概要,然后展开详细介绍,主要是在densenet、resnext、senet这三个网络上介绍,前面的一系列网络大概讲一下思想。 1、时间轴 时间团队论文2014.09googleInception v12015.02googleInception v22015.12googleInception v32