rectified专题

ReLU(Rectified Linear Unit)和Sigmoid激活函数

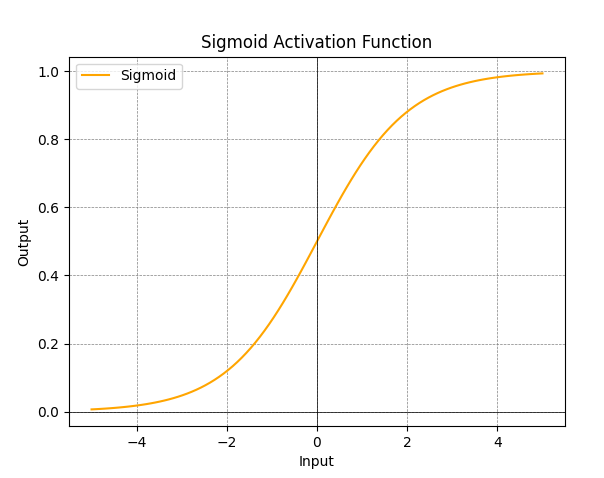

ReLU(Rectified Linear Unit)和Sigmoid都是神经网络中常用的激活函数。 特点: ReLU是一种简单而有效的激活函数。它对于正数部分直接返回输入,对于负数部分返回零。这种非线性转换有助于网络学习更复杂的表示。ReLU在许多深度学习模型中被广泛使用,因为它在梯度下降中的计算上相对简单,且有效防止了梯度消失问题。 Sigmoid函数将输入映射到(0,1)之间的范围

Rectified Linear Unit (ReLU)

在神经网络中,常用到的激活函数有sigmoid函数,双曲正切(hyperbolic tangent)函数f(x) = tanh(x)。 今天要说的是另外一种activation function,rectified linear function 线性整流函数(Rectified Linear Unit, ReLU),又称修正线性单元, 是一种人工神经网络中常用的激活函

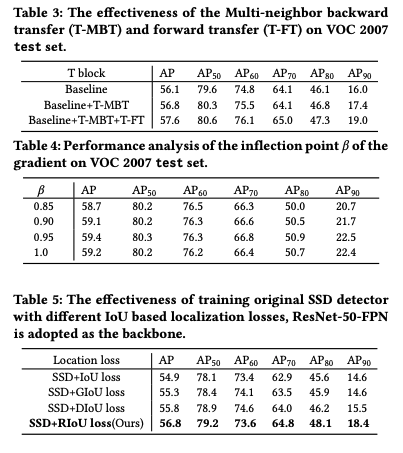

【目标检测】30、Rectified IoU: Single-Shot Two-Pronged Detector with Rectified IoU Loss

文章目录 一、背景二、方法三、效果 论文:Single-Shot Two-Pronged Detector with Rectified IoU Loss 代码:暂无 出处:ACM MM 2020 一、背景 在检测任务重,IoU 经常被用来选择预选框,但这种直接的做法也忽略了样本分布的不均衡的特点,这会影响定位 loss 的梯度,从而影响最终的效果。 作者思考,能不能

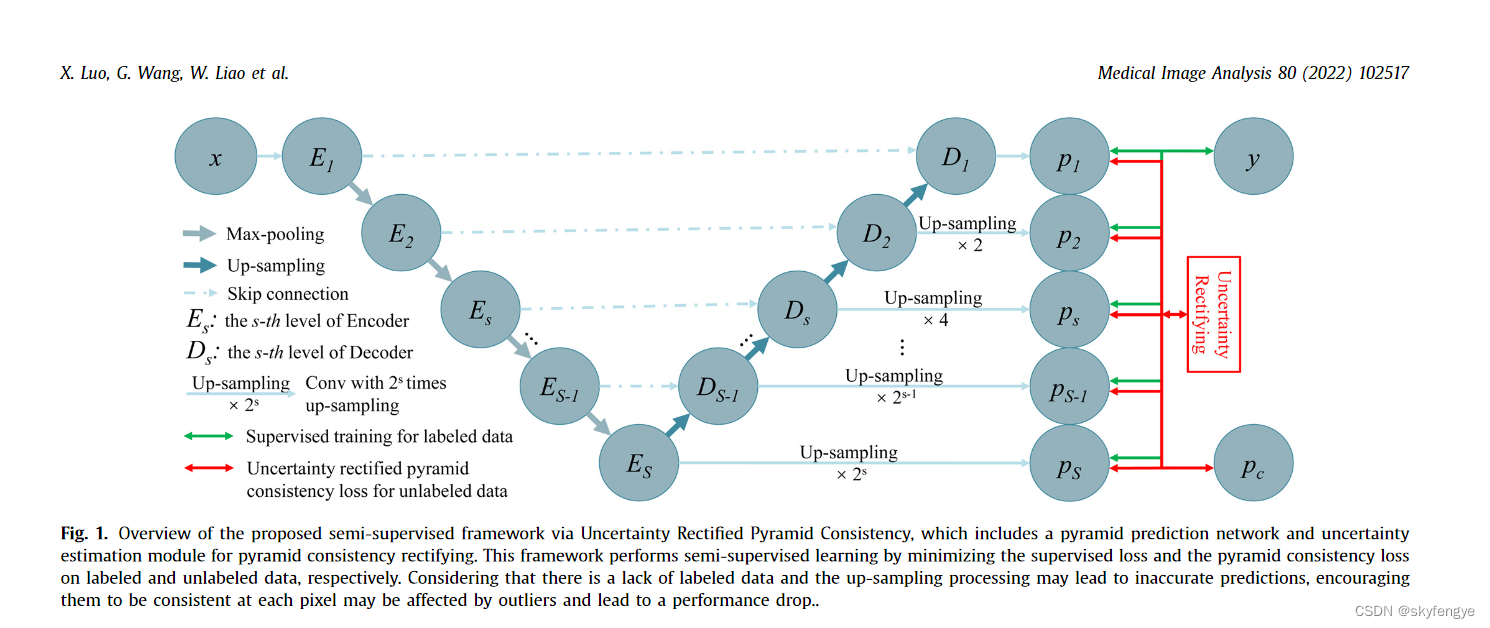

Semi-supervised medical image segmentation via uncertainty rectified pyramid consistency 半监督医学图像分割

↵ 现在由于深度学习有监督分割基本也搞到头了,各种新网络新结构层出不穷,人们把精力主要放到了半监督分割任务上了。半监督学习旨在通过结合少量标记数据和大量未标记数据来取得可喜的结果,因此关键步骤是为未标记数据设计有效的监督。因此,已经提出了许多方法来有效地利用未注释的图像。今天看到一篇毕竟好的论文,整个思路并不复杂,给人感觉,原来还可以这么弄呀。 通过图片,我们可以发现,这是一个典型的UN

Rectified Linear Units, 线性修正单元激活函数

ReLU 在神经网络中,常用到的激活函数有sigmoid函数: f(x)=11+e−xf(x)=11+e−x 双曲正切函数: f(x)=tanh(x)f(x)=tanh(x) 而本文要介绍的是另外一种激活函数,Rectified Linear Unit Function(ReLU, 线性激活函数) ReLU函数可以表示为 f(x)=max(0,x)f(x)=max(0,x) 显然

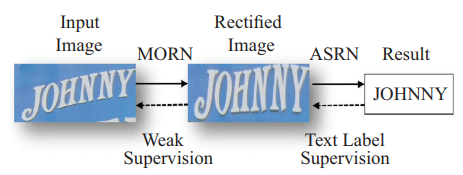

Text recognition文本识别算法MORAN: A Multi-Object Rectified Attention Network for scence text recognition

MORAN: A Multi-Object Rectified Attention Network for scence text recognition Pattern Recognition 2019 一、Introduction MORAN分为两部分一个是对形变input image的校正网络MORN(multi-object rectification network)和对矫正后照片

rectified linear unit修正线性单元Relu

Relu = rectified linear unit 修正指的是,取值大于0 使用Relu函数而不是Sigmoid函数的原因是:在x较大时,Sigmoid函数值接近于1,导数接近0,梯度下降特别慢。而Relu函数的梯度在X>0时一直为1,梯度下降快

ORA-13199: the given geometry cannot be rectified ORA-13000: 维数超出范围 SDO_MIGRATE. TO_CURRENT

报错信息: Traceback (most recent call last):File "exp_csv.py", line 22, in <module>for row_data in curs: # add table rowscx_Oracle.DatabaseError: ORA-13199: the given geometry cannot be rectifiedORA-06

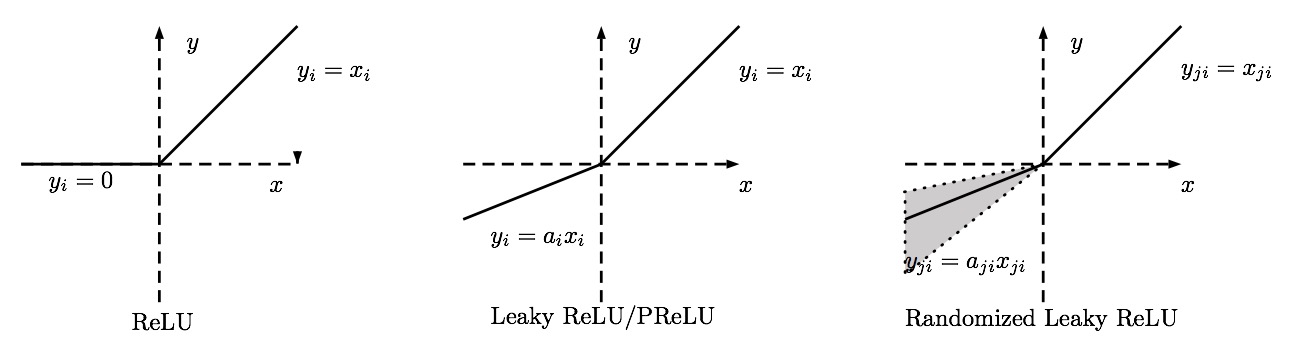

Empirical Evaluation of Rectified Activation in Convoluation Network 激活函数的讨论

Empirical Evaluation of Rectified Activation in Convoluation Network 对神经网络激活函数的经验评估 Standard rectified linear unit relu 标准整流线单元 这是最常用的激活函数 Leaky rectified linear unit lrelu Parametric r

Adversarial Training with Rectified Rejection 笔记

Adversarial Training with Rectified Rejection 笔记 Abstract1 Introduction2 Related work3 Classification with a rejection option3.1 True confidence (T-Con) as a certainty oracle 4 Learning T-Con via r

Relu-Rectified linear unit激活函数

传统Sigmoid系激活函数 传统神经网络中最常用的两个激活函数,Sigmoid系(Logistic-Sigmoid、Tanh-Sigmoid)被视为神经网络的核心所在。 从数学上来看,非线性的Sigmoid函数对中央区的信号增益较大,对两侧区的信号增益小,在信号的特征空间映射上,有很好的效果。 从神经科学上来看,中央区酷似神经元的兴奋态,两侧区酷似神经元的抑制态,因而在神经网

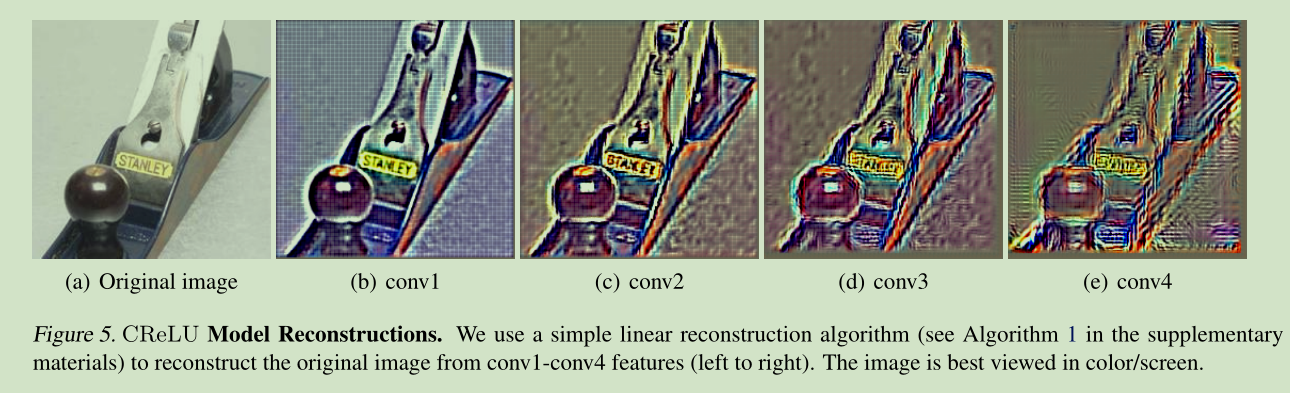

激活函数-Concatenated Rectified Linear Units

ICML2016 Understanding and Improving Convolutional Neural Networks via Concatenated Rectified Linear Units 本文在深入分析CNN网络内部结构,发现在CNN网络的前几层学习到的滤波器中存在负相关。 they appear surprisingly opposite to each oth

Topology and Geometry of Deep Rectified Network Optimization Landscapes 读书笔记

If you have any questions, plz contact luweihao@126.com