normalization专题

Layer Normalization论文解读

基本信息 作者JL Badoi发表时间2016期刊NIPS网址https://arxiv.org/abs/1607.06450v1 研究背景 1. What’s known 既往研究已证实 batch Normalization对属于同一个Batch中的数据长度要求是相同的,不适合处理序列型的数据。因此它在NLP领域的RNN上效果并不显著,但在CV领域的CNN上效果显著。 2. What’s

神经网络训练不起来怎么办(五)| Batch Normalization

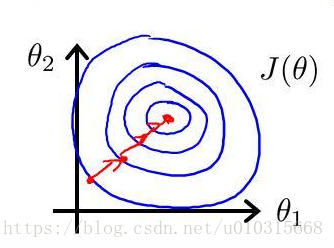

Ⅰ,领域背景 训练困境:当 input feature 在不同 dimension 上差距很大的时候,会产生一个非常崎岖的 error surface(误差平面)。这种崎岖多变的误差平面容易导致训练陷入以下的几个困境。 收敛困难:在崎岖的误差表面上,梯度下降等优化算法很容易陷入局部最小值或者鞍点,并且很难继续优化。这会导致模型无法收敛到全局最优解,训练过程变得非常困难。训练速度变慢:由于优化算

深度学习中的Normalization模型

深度学习中的Normalization模型 本文转载自张俊林的知乎专栏[https://zhuanlan.zhihu.com/p/43200897],谢谢大佬的分享。 Batch Normalization(简称BN)自从提出之后,因为效果特别好,很快被作为深度学习的标准工具应用在了各种场合。BN大法虽然好,但是也存在一些局限和问题,诸如当Batc

基于医学图像配准软件 ANTs(Advanced Normalization Tools)提取脑图像数值并与临床量表计算相关

前言: 神经影像学与临床评估的结合正在革新我们对神经精神疾病的理解。本博客聚焦于如何利用先进的医学图像配准软件ANTs(Advanced Normalization Tools)提取脑图像数值,并将其与临床量表进行相关性分析。 目录 一、准备掩模(Mask) 二、准备T-value map T-map 和 Z-map的转化 比较同一结果的T-map和Zmap 三、提取Mask

Layer Normalization(层归一化)里的可学习的参数

参考pyttorch官方文档: LayerNorm — PyTorch 2.4 documentation 在深度学习模型中,层归一化(Layer Normalization, 简称LN)是一种常用的技术,用于稳定和加速神经网络的训练。层归一化通过对单个样本内的所有激活进行归一化,使得训练过程更加稳定。 关于层归一化是否可训练,其实层归一化中确实包含可训练的参数。具体来说,层归一化会对激活值

深度学习中的Normalization模型(二)

上次我们主要介绍了Batch Normalization,今天接下去介绍其他的正则化方法。 四.Layer Normalization、Instance Normalization及Group Normalization 4.1 Layer Normalization 为了能够在只有当前一个训练实例的情形下,也能找到一个合理的统计范围,一个最直接的想法是:MLP的同一隐层自己包含了若干神经元

深度学习中的Normalization模型(一)

之前一直在做CV相关的工作,一直在用cnn,cnn中有个特别常用的东西叫做归一化,归一化的方法也有很多,用法也各不相同,发现一篇整理的很好的文章,给大家分享一下,文章图文并茂,有原理也有例子,文章有点长,分两次给大家分享,但是这个时间花的很值得,相信大家一定会有收获的。 以下为干货! Batch Normalization(简称BN)自从提出之后,因为效果特别好,很快被作为深度学习的标准工具

BatchNormalization和Layer Normalization解析

Batch Normalization 是google团队2015年提出的,能够加速网络的收敛并提升准确率 1.Batch Normalization原理 图像预处理过程中通常会对图像进行标准化处理,能够加速网络的收敛,如下图所示,对于Conv1来说输入的就是满足某一分布的特征矩阵,但对于Conv2而言输入的feature map就不一定满足某一分布规律了(注意这里所说满足某一分布规律并不是

caffe中BatchNorm层和Scale层实现批量归一化(batch-normalization)注意事项

caffe中实现批量归一化(batch-normalization)需要借助两个层:BatchNorm 和 Scale BatchNorm实现的是归一化 Scale实现的是平移和缩放 在实现的时候要注意的是由于Scale需要实现平移功能,所以要把bias_term项设为true 另外,实现BatchNorm的时候需要注意一下参数use_global_stats,在训练的时候设为false,

归一化(Normalization)与标准化(Standardization)

在机器学习和数据挖掘中,经常会听到两个名词:归一化(Normalization)与标准化(Standardization)。它们具体是什么?带来什么益处?具体怎么用?本文来具体讨论这些问题。 一、是什么 1. 归一化 常用的方法是通过对原始数据进行线性变换把数据映射到[0,1]之间,变换函数为: x′=x−minmax−min x′=x−minmax−min 其中 min

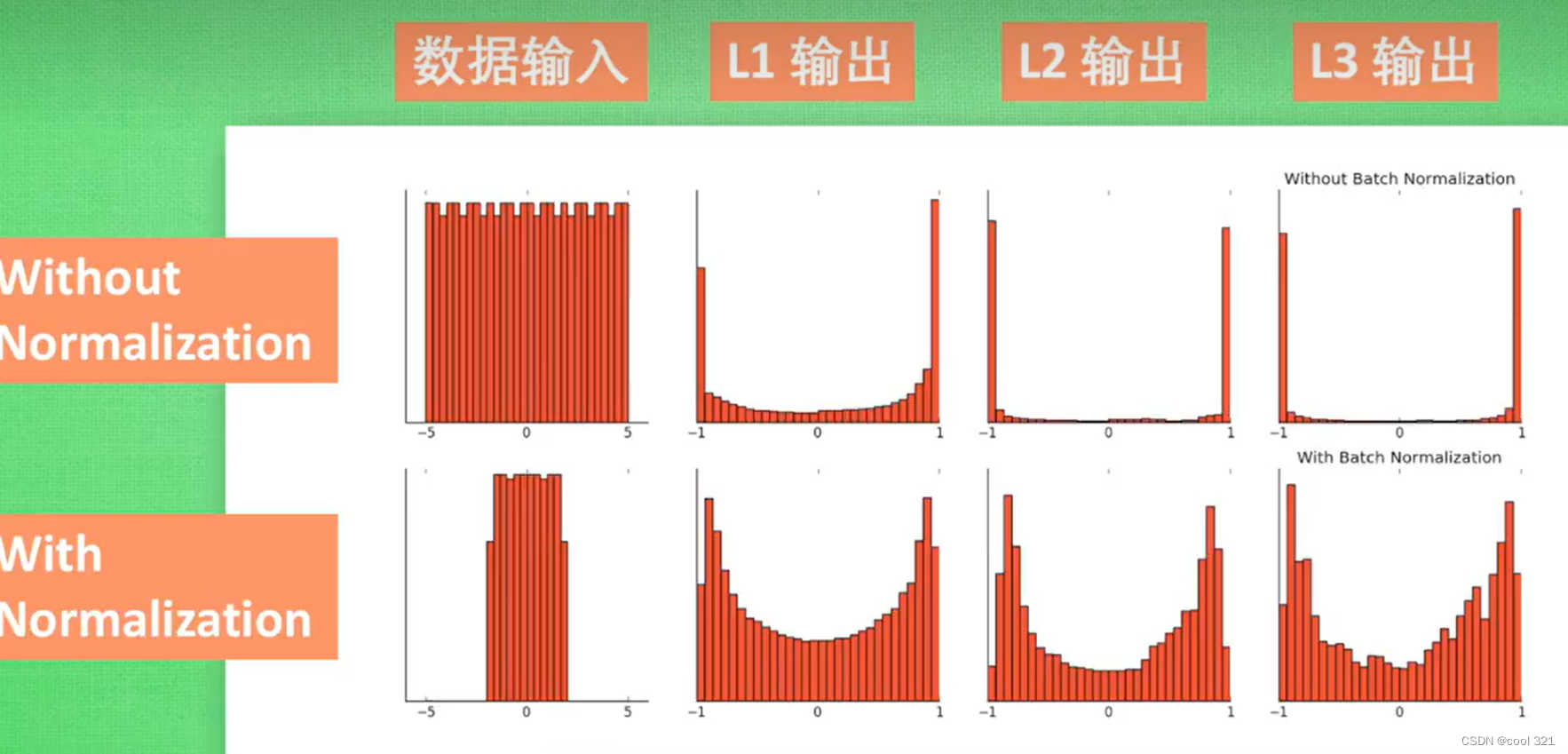

小知识点快速总结:Batch Normalization Layer(BN层)的作用

本系列文章只做简要总结,不详细说明原理和公式。 目录 1. 参考文章2. 主要作用3. 具体分析3.1 正则化,降低过拟合3.2 提高模型收敛速度,加速训练3.3 减少梯度爆炸或者梯度消失的情况 4. 补充4.1 BN层做的是标准化不是归一化4.2 BN层的公式4.3 BN层为什么要引入gamma和beta参数 1. 参考文章 [1] Sergey Ioffe, “Batch

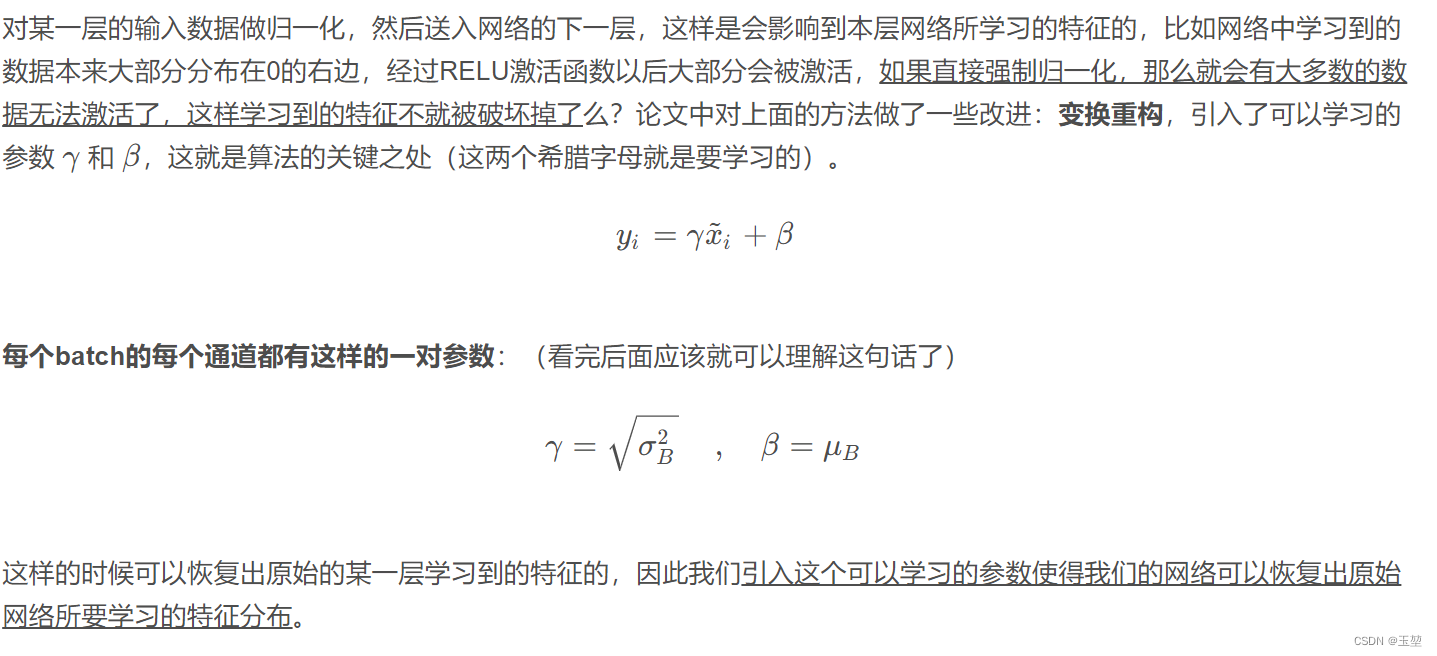

什么是 Batch Normalization 批标准化和全连接层

Batch Normalization 神经元在经过激活函数之后会处于饱和状态,无论后续怎么变化都不会再起作用。 每一层都会进行batch normalization的处理! without normalization 会导致数据分布再饱和区 全连接层: 全连接层(fully connected layers,FC)在整个卷积神经网络中起到“分类器”的作用。如果说卷积

pytorch-Normalization

目录 1. 为什么Normalization2. Normalization2.1 image Normalization2.2 Batch Normalization 3. Normalization pytorch实现3.1 Normalization标准公式3.2 2d normalization3.3 normalize test 4. 使用normalization的好处

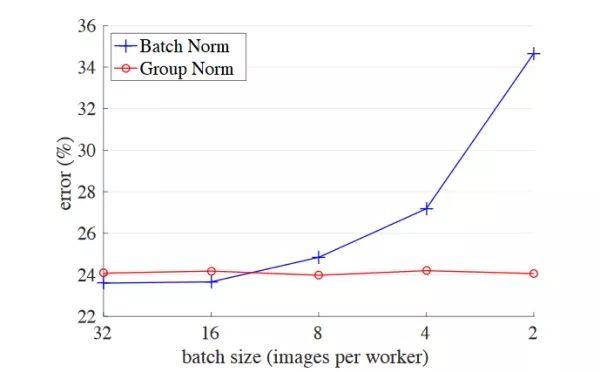

[论文阅读]Group Normalization IBN-Net(ECCV2018)

这里主要介绍两篇ECCV2018的论文,都是关于神经网络层中的normalization归一化的。 目录 《Group Normalization》【ECCV2018】 方法 代码 实验 《Two at Once: Enhancing Learning and Generalization Capacities via IBN-Net》【ECCV2018】 摘要 Instanc

机器学习之特征归一化(normalization)

一 引子 对房屋售价进行预测时,我们的特征仅有房屋面积一项,但是,在实际生活中,卧室数目也一定程度上影响了房屋售价。下面,我们有这样一组训练样本: 房屋面积(英尺)卧室数量(间)售价(美元)210433999001600332990024003369000141622320003000453990019854299900 注意到,房屋面积及卧室数量两个特征在数值上差异巨大,如果直接将该样本送

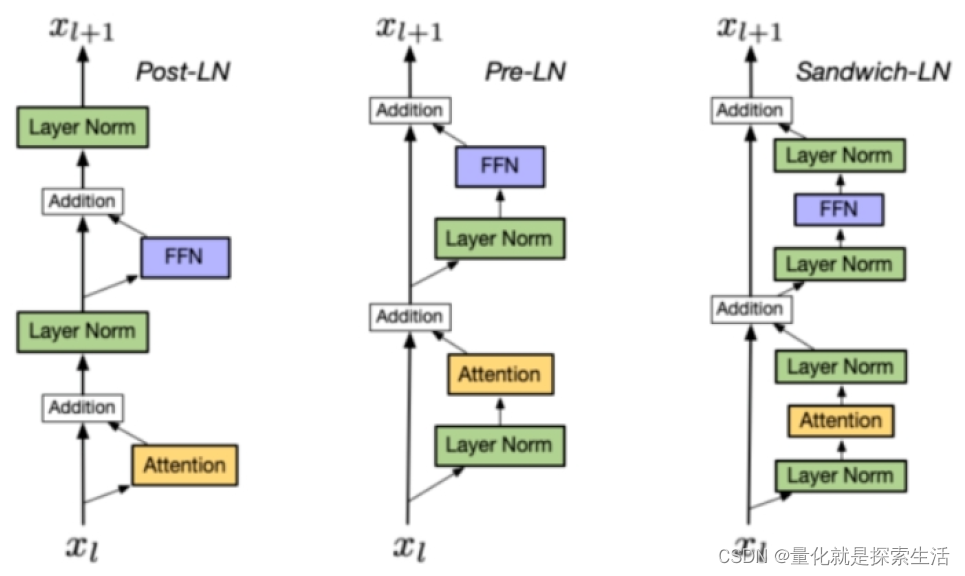

AIGC算法1:Layer normalization

1. Layer Normalization μ = E ( X ) ← 1 H ∑ i = 1 n x i σ ← Var ( x ) = 1 H ∑ i = 1 H ( x i − μ ) 2 + ϵ y = x − E ( x ) Var ( X ) + ϵ ⋅ γ + β \begin{gathered}\mu=E(X) \leftarrow \frac{1}{H} \sum_

[论文笔记]Root Mean Square Layer Normalization

引言 今天带来论文Root Mean Square Layer Normalization的笔记,论文题目是均方根层归一化。 本篇工作提出了RMSNorm,认为可以省略重新居中步骤。 简介 层归一化对Transformer等模型非常重要,它可以帮助稳定训练并提升模型收敛性,因为它能够处理输入和权重矩阵的重新居中(re-centering)和重新缩放(re-scaling)。然而,Layer

Transformer模型-Normalization归一化的简明介绍

背景 一般而言,Normalization归一化是将特征转换为可比较尺度的过程。有许多方法可以对特征进行归一化 例如:最小-最大特征缩放 最小-最大特征缩放将值转换到[0,1]的范围内。这也被称为基于单位的归一化。可以使用以下方程进行计算: 该方程的顶部将每个值减去X_min;当X等于X_min时,分子变为0。当分子被分母除时,输出为0。 同样,当分子为X_max — X_min时

normalization (标准化或者正则化)

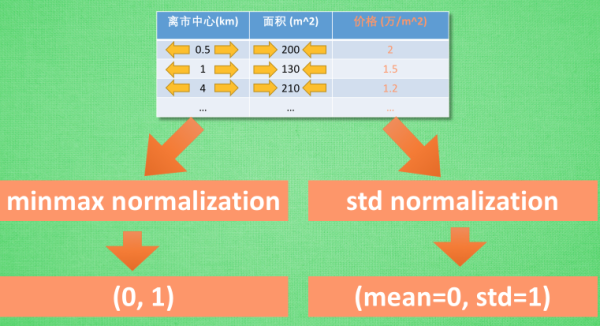

通常用于 特征标准化的途径有两种, 一种叫做 min max normalization, 他会将所有特征数据按比例缩放到0-1的这个取值区间. 有时也可以是-1到1的区间. 还有一种叫做 standard deviation normalization, 他会将所有特征数据缩放成 平均值为0, 方差为1. 使用这些标准化手段. 我们不仅可以快速推进机器学习的学习速度, 还可以避免机器学习

Lesson 8 Batch Normalization

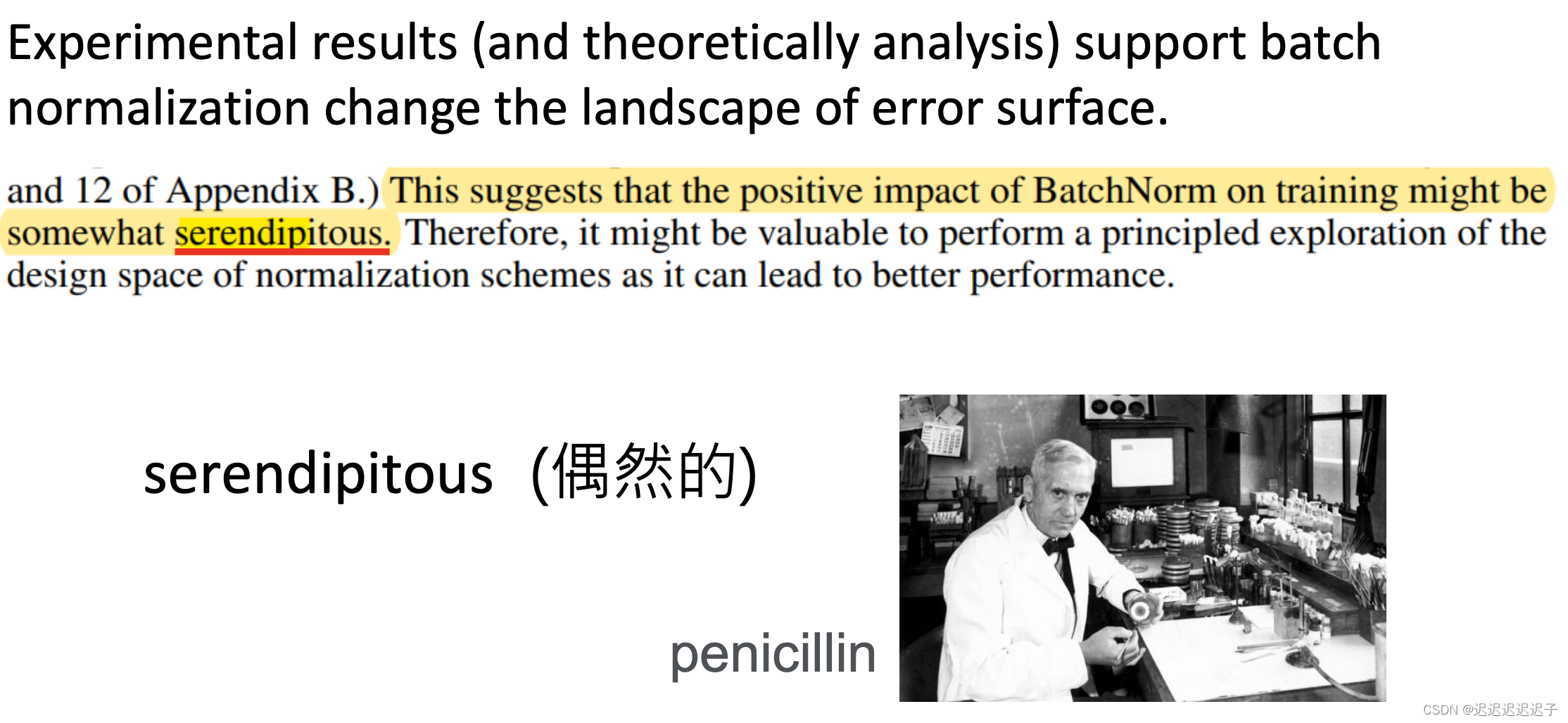

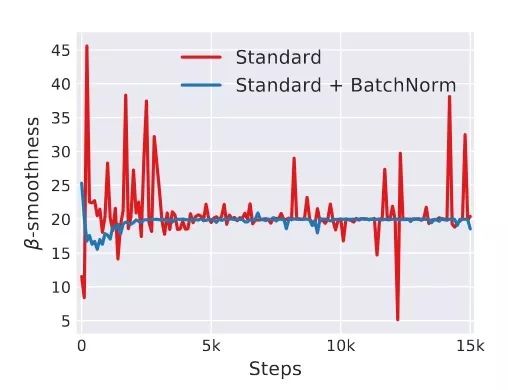

听课(李宏毅老师的)笔记,方便梳理框架,以作复习之用。本节课主要讲了batch normalization是什么,为什么要用batch normalization,是用来解决什么问题的,以及batch normalization在测试和训练上不同的计算方法 1. changing landscape 陡峭的error surface难train,因为这样的error surface对于参数的变

TensorFlow使用之tf.layers.batch_normalization函数详解

1、写在前面 这是我的处女作,其实想写写自己的博客有一段时间了,主要也是为了记录自己所学到的新知识点,以后可以再来回顾一下,另则加深印象。由于最近在准备做OCR识别的内容,后来遇到了tf.layers.batch_normalization()这个函数,经过多方的学习网上大佬们的文章之后,在此以最简单的方式来说说这个函数,并把自己学习的过程走过的弯路在此记下,希望有缘人能够看到,互相交流。 2

深度学习入门笔记(十三):批归一化(Batch Normalization)

欢迎关注WX公众号:【程序员管小亮】 专栏——深度学习入门笔记 声明 1)该文章整理自网上的大牛和机器学习专家无私奉献的资料,具体引用的资料请看参考文献。 2)本文仅供学术交流,非商用。所以每一部分具体的参考资料并没有详细对应。如果某部分不小心侵犯了大家的利益,还望海涵,并联系博主删除。 3)博主才疏学浅,文中如有不当之处,请各位指出,共同进步,谢谢。 4)此属于第一版本,若有错误,还需继续

Batch Normalization(批量归一化)和 Layer Normalization(层归一化)

Batch Normalization(批量归一化)和 Layer Normalization(层归一化)都是深度学习中用于改善网络训练过程的归一化技术。尽管它们的目标相似,即通过规范化中间层的激活值来加速训练过程并提高性能,但它们在细节上有所不同。 Batch Normalization (批量归一化) Batch Normalization是google团队在2015年论文《Batch N

Batch Normalization原理与实战(下)

来自 | 知乎 作者 | 天雨粟 链接 | https://zhuanlan.zhihu.com/p/34879333 编辑 | 深度学习这件小事公众号 本文仅作学术交流,如有侵权,请联系后台删除。 前言 本文主要从理论与实战视角对深度学习中的Batch Normalization的思路进行讲解、归纳和总结,并辅以代码让小伙伴儿们对Batch Normalization的作用有更加直观

Batch Normalization原理与实战(上)

来自 | 知乎 作者 | 天雨粟 链接 | https://zhuanlan.zhihu.com/p/34879333 编辑 | 深度学习这件小事公众号 本文仅作学术交流,如有侵权,请联系后台删除。 前言 本文主要从理论与实战视角对深度学习中的Batch Normalization的思路进行讲解、归纳和总结,并辅以代码让小伙伴儿们对Batch Normalization的作用有更加直观

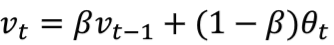

李宏毅 Normalization

对L影响很小。假设 input很小, 对L影响很小 Feature normalization,对所有输入进行 normalization 可以在 activication 之前或者之后做 normalization, sigmoid函数最好是在activiation之前做 gama 初始 为1, beta 初始为0 加BN时候 error surface 就会比较

![[论文笔记]Root Mean Square Layer Normalization](https://img-blog.csdnimg.cn/img_convert/ebea04d0e75943d4b3eeb5b2449b92db.png)