mechanism专题

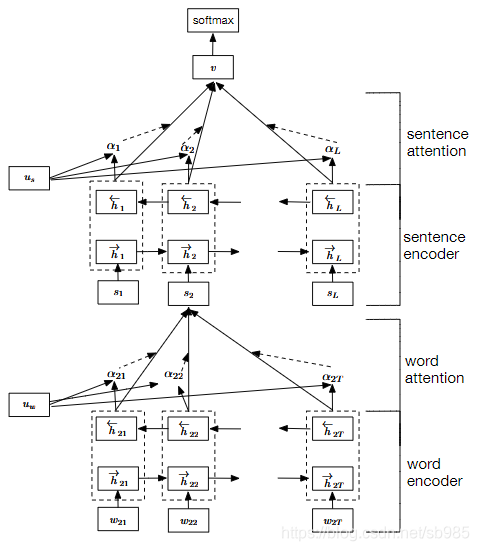

注意力机制(Attention mechanism)(中篇)

模型的输入是一组向量,它可以是文字,可以是语音,可以是图。而输出有三种可能性, 第一种可能性是每一个向量都有一个对应的标签。如图1所示,当模型看到输入是4个向 量的时候,它就要输出4个标签。如果是回归问题,每个标签是一个数值。如果是分类问题, 每个标签是一个类别。但是在类型1的问题里面,输入跟输出的长度是一样的。模型不需要 去烦恼要输出多少的标签,输出多少的标量。反正输入是4个向量,输出就是4个标

注意力机制(Attention mechanism)(上篇)

在图像识别的时候,假设输入的图像大小都是一样的。但如果问题变得复杂,如图1所 示,输入是一组向量,并且输入的向量的数量是会改变的,即每次模型输入的序列长度都不一 样,这个时候应该要怎么处理呢?我们通过具体的例子来讲解处理方法。 图1 输入是一组向量 第一个例子是文字处理,假设网络的输入是一个句子,每一个句子的长度都不一样(每个 句子里面词汇的数量都不一样)

10A event mechanism

转自 http://wenku.baidu.com/view/f1e9c3bdfd0a79563c1e7235.html event机制是MTK feature phone平台10A代码里面的最重要的机制之一.当某一个函数或者功能模块post或者send一个event之后,相关的就收函数就会去接收这个event然后做出相关的动作。 问题在于:我们自己怎样使用event机制?怎

Message passing mechanism (消息传递机制)

objc_msgSend 是 Objective-C 运行时系统中的一个核心函数,用于实现消息传递机制。在 Objective-C 中,方法调用实际上是消息传递的过程,当你在代码中调用一个方法时,编译器会将其转换为 objc_msgSend 函数的调用。 objc_msgSend 的作用 objc_msgSend 的主要作用是: 方法查找: 根据消息的接收者(对象)和选择器(方法名),在接

Hue error: 集成hive报错Could not start SASL: Error in sasl_client_start (-4) SASL(-4): no mechanism avai

1.问题描述 hue配置完hive后,打开hue界面报错: Could not start SASL: Error in sasl_client_start (-4) SASL(-4): no mechanism available: No worthy mechs found (code THRIFTTRANSPORT): TTransportException('Could not sta

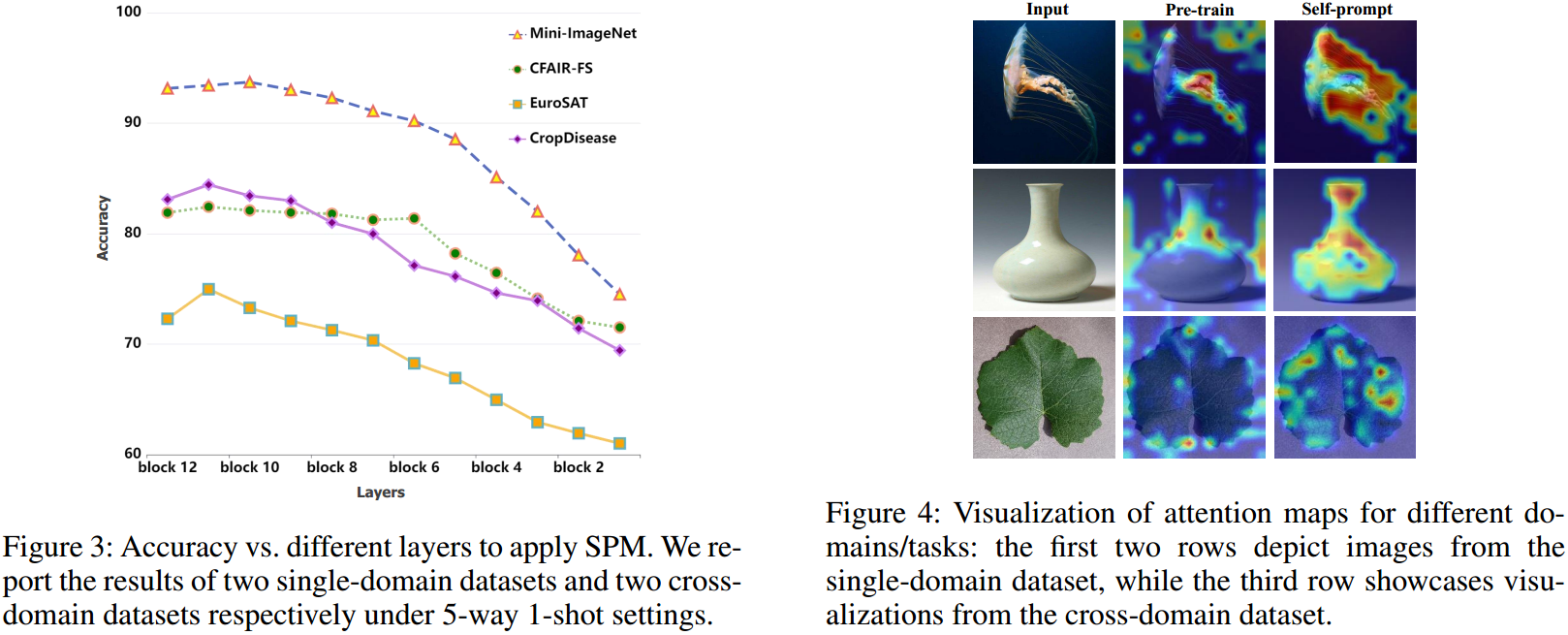

论文解读:Self-Prompt Mechanism for Few-Shot Image Recognition

文章汇总 存在的问题 由于提示文本和图像特征之间固有的模态差异,常规的提示方法的性能受到限制。 动机 让视觉信息自己给自己提示 解决办法 SPM涉及到图像编码器跨空间和通道维度产生的固有语义特征的系统选择,从而产生自提示信息。随后,在将这种自提示信息反向传播到神经网络的更深层后,它有效地引导网络学习和适应新样本。 流程解读 作者的想法很简单,常规的方法都是用文本来指导Image E

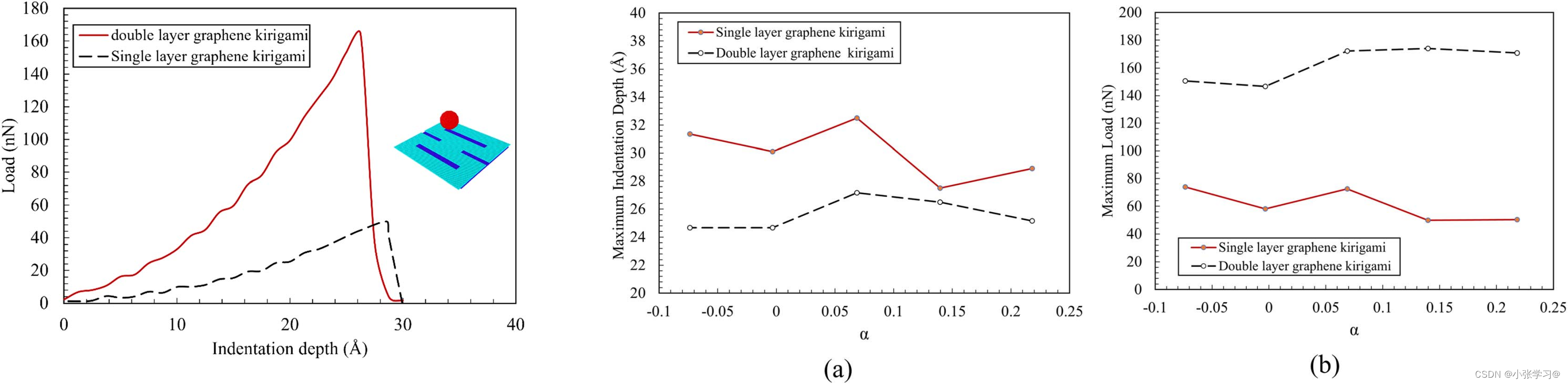

20240422Failure mechanism of graphene kirigami under anoindentation

题目:Failure mechanism of graphene kirigami under nanoindentation DOI:https://doi.org/10.1088/1361-6528/ac7655 纳米压痕下,研究石墨烯剪纸的几何参数和压头的尺寸与速度对压痕的影响,最后使用两层石墨烯(石墨烯剪纸和完美石墨烯)权衡柔性和强度。 1、模型以及压痕过程 2、几何尺寸的影响

Spinlock kernel lock mechanism

一、概述 spinlock是kernel的一种锁机制 kernle的锁机制有三种: spinlock mutex semaphore 在设备驱动开发中,spinlock与mutex比较常用 一个thread去获取spinlock的时候是会不断的去轮询的,比较耗用cpu资源。(在mutex的时候,是进入sleep,所以不耗cpu资源)。所以spinlock用在很短的lock任务下。

self-attention mechanism DQN 算法和DQN算法的区别在哪

self-attention mechanism DQN 算法与标准的 DQN 算法之间的主要区别在于其在网络结构中引入了自注意力机制(self-attention mechanism)。下面是两者之间的主要区别: 网络结构: 标准的 DQN 通常使用深度神经网络(如卷积神经网络或全连接神经网络)来近似状态动作值函数(Q 函数)。这些网络结构主要由卷积层或全连接层组成,用于从状态中提取特征,并

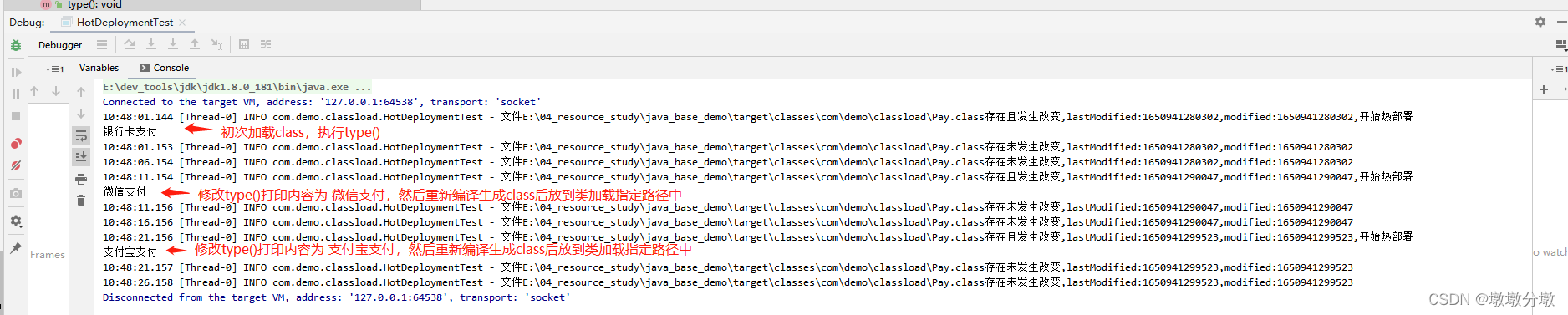

【Jvm】类加载机制(Class Loading Mechanism)原理及应用场景

文章目录 Jvm基本组成一.什么是JVM类的加载二.类的生命周期阶段1:加载阶段2:验证阶段3:准备阶段4:解析阶段5:初始化 三.类初始化时机四.类加载器1.引导类加载器(Bootstrap Class Loader)2.拓展类加载器(Extension Class Loader)3.应用程序类加载器(System Class Loader)4.自定义类加载器(Custom Class L

激活函数总结(八):基于Gate mechanism机制的激活函数补充(GLU、SwiGLU、GTU、Bilinear、ReGLU、GEGLU)

激活函数总结(八):基于Gate mechanism机制的激活函数补充 1 引言2 激活函数2.1 GLU激活函数2.2 SwiGLU激活函数2.3 GTU激活函数2.4 Bilinear激活函数2.5 ReGLU激活函数2.6 GEGLU激活函数 3. 总结 1 引言 在前面的文章中已经介绍了介绍了一系列激活函数 (Sigmoid、Tanh、ReLU、Leaky ReLU、PR

深度学习优化策略-4 基于Gate Mechanism的激活单元GTU、GLU

1、Sigmoid和Tanh激活函数及存在问题 深度学习(神经网络)中最先被广泛使用的激活函数是Sigmoid函数和双曲正切激活函数,都是非线性的激活函数,两个激活函数的表达式如下: sigmoid函数: f(x)= 1 / (1+exp(−x)) 双曲正切函数: f(x)= tanh(x) 激活函数的图形如图所示:

Hue Could not start SASL: Error in sasl_client_start (-4) SASL(-4): no mechanism available: No worth

问题: thriftpy.transport.TTransportException: TTransportException(type=1, message="Could not start SASL: b'Error in sasl_client_start (-4) SASL(-4): no mechanism available: No worthy mechs found'") 原因:

阅读《 Sentiment Classification Based on Part-of-Speech and Self-Attention Mechanism》

Sentiment Classification Based on Part-of-Speech and Self-Attention Mechanism 2020.1 KEFEI CHENG 1 , YANAN Y 摘要: 目前,各种基于注意的神经网络在情感分类任务中取得了成功,因为注意机制能够更多地关注那些对情感极性预测有贡献的词。 然而,这些方法的主要缺点是它们只注重词语,而忽略了词性中

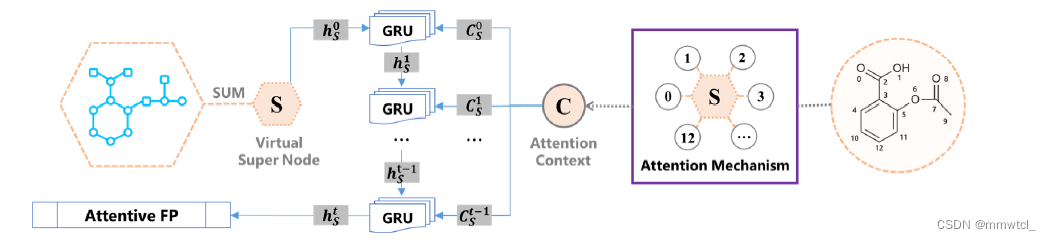

Pushing the boundaries of molecular representation for drug discovery with graph attention mechanism

AttentiveFP 2020 Motivations 1、The gap between what these neural networks learn and what human beings can comprehend is growing 2、Graph-based representations take only the information concerning th

Hue error: 集成hive报错Could not start SASL: Error in sasl_client_start (-4) SASL(-4): no mechanism avai

1.问题描述 hue配置完hive后,打开hue界面报错: Could not start SASL: Error in sasl_client_start (-4) SASL(-4): no mechanism available: No worthy mechs found (code THRIFTTRANSPORT): TTransportException('Could not sta

注意力机制(Attention Mechanism)学习笔记

参考自:https://blog.csdn.net/qq_40027052/article/details/78421155 对内容进行抽取的少许补充。 还有 https://spaces.ac.cn/archives/4765/comment-page-3。在后面加入了此文的内容。 原理是一个encoder、decoder框架:输入句子Source,目标句子target。 source=<x

Attention mechanism总结

Attention mechanism 总结:Attention机制简单来说就是一种信息过滤或者提取机制类似于记忆或者门控机制,用来筛选、更新信息。 类比于人脑,神经网络中可以存储的信息量称为网络容量。要存储的信息越多,神经元数量就越多或者网络越复杂,大量的信息增加了存储负担和计算开销。由于人脑每个时刻接收的外界信息非常多,在有限的资源下,并不能同时处理这些过载的输入信息。大脑神经系统通

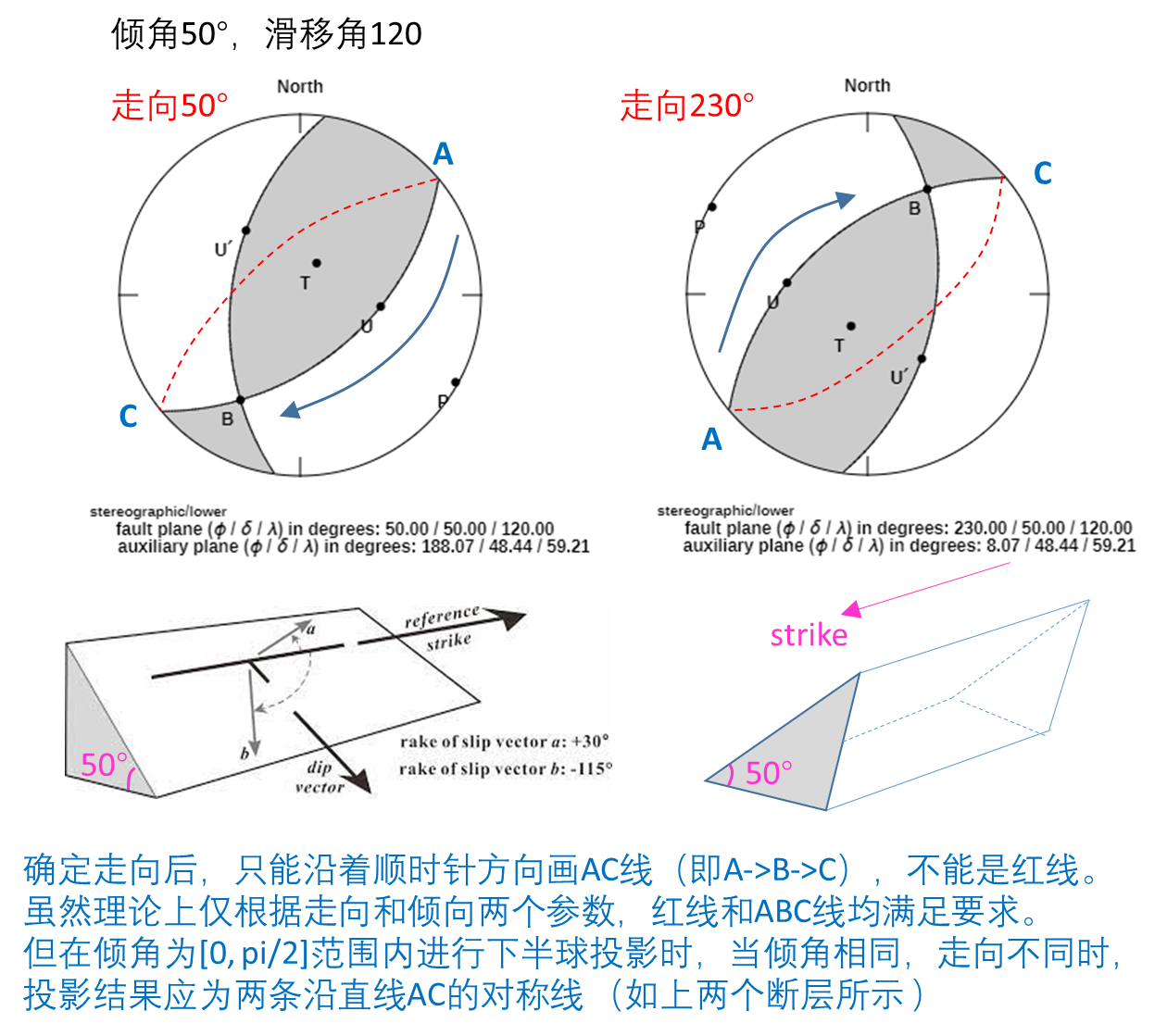

震源机制沙滩球(focal mechanism beach ball)绘制之傻瓜式教程

震源机制系列文章: 震源机制(Focal Mechanism)之断层基本知识 震源机制(Focal Mechanism)之沙滩球(Beach Ball) 目录 1. 断层的定义 2. 绘制流程 3. 更多示例 1. 断层的定义() 走向(strike):正北方顺时针旋转到走向 倾角(dip):从水平面向下旋转到断层面的角度 滑移角(rake): 走向旋转至滑动

文献阅读--Federated Learning with Unreliable Clients: Performance Analysis and Mechanism Design

本文讲述了在联邦学习中,如何确定上传异常梯度的 Unreliable Clients,并提出了DeepSA算法,用来屏蔽Unreliable Clients上传的本地模型参数。除此以外,本文还推算了在异常场景下中心模型损失函数收敛的上界,并得到了最佳本地训练epoch的数量。 创新点:使用卷积神经网络鉴别异常参数(通过观察发现针对同一用户,其第k轮的数据及其领域几轮的数据具有相关性,这样的相关性

01 Incentive Mechanism for Reliable Federated Learning: A Joint Optimization Approach to Combining R

01 Incentive Mechanism for Reliable Federated Learning: A Joint Optimization Approach to Combining Reputation and Contract Theory 概括 1基于声誉衡量可靠性,选择矿工。 2区块链管理声誉。 3奖惩。 在本文中,我们首先引入声誉作为衡量移动设备可靠性和可信度的指标。

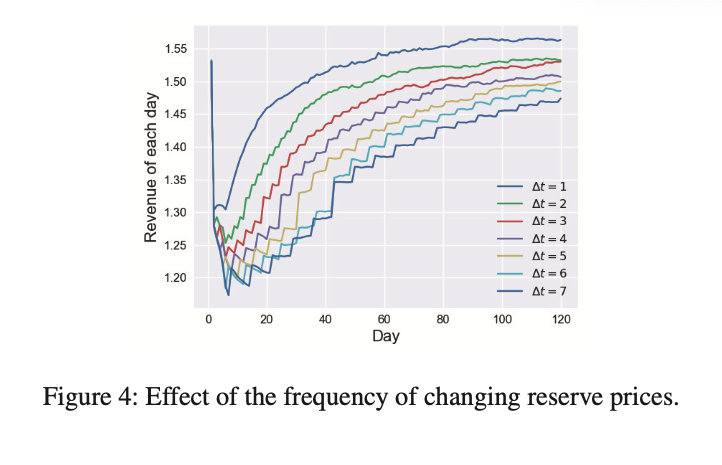

Reinforcement Mechanism Design:With Applications to Dynamic Pricing in Sponsored Search Auction

【论文阅读】Reinforcement Mechanism Design : With Applications to Dynamic Pricing in Sponsored Search Auctions 1 本文解决了什么问题? 本文旨在结合机制设计和强化学习来解决 搜索引擎的动态定价问题(dynamic pricing problem)。在该场景中,通过与投标人的反复互动,搜索引擎