layers专题

OpenXR Monado compositor处理应用layers(cheduled->delivered)

OpenXR Monado compositor处理应用的layer,scheduled->delivered @src/xrt/targets/common/target_instance.ct_instance_create_system@src/xrt/compositor/main/comp_compositor.ccomp_main_create_system_composito

Convolutional layers/Pooling layers/Dense Layer 卷积层/池化层/稠密层

Convolutional layers/Pooling layers/Dense Layer 卷积层/池化层/稠密层 Convolutional layers 卷积层 Convolutional layers, which apply a specified number of convolution filters to the image. For each subregion, the

C++卷积神经网络实例:tiny_cnn代码详解(11)——层结构容器layers类源码分析

在这篇博文中我们对tiny_cnn卷积神经网络模型中的最后一个网络结构方面的类——layers做简要分析。 首先,layers通俗的讲可以被称为是层结构的vector,即层结构容器。由于卷积神经网络是一个多层的网络模型,因此有必要将网络中各个层进行统一管理,这便引出了本篇博文中所要介绍的layers类。layers类是一个vector类型的变量,其中压入的元素就是网络中的各个层模型,这里

tf.layers.conv1d函数解析(一维卷积)

一维卷积一般用于处理文本,所以输入一般是一段长文本,就是词的列表 函数定义如下: tf.layers.conv1d(inputs,filters,kernel_size,strides=1,padding='valid',data_format='channels_last',dilation_rate=1,activation=None,use_bias=True,

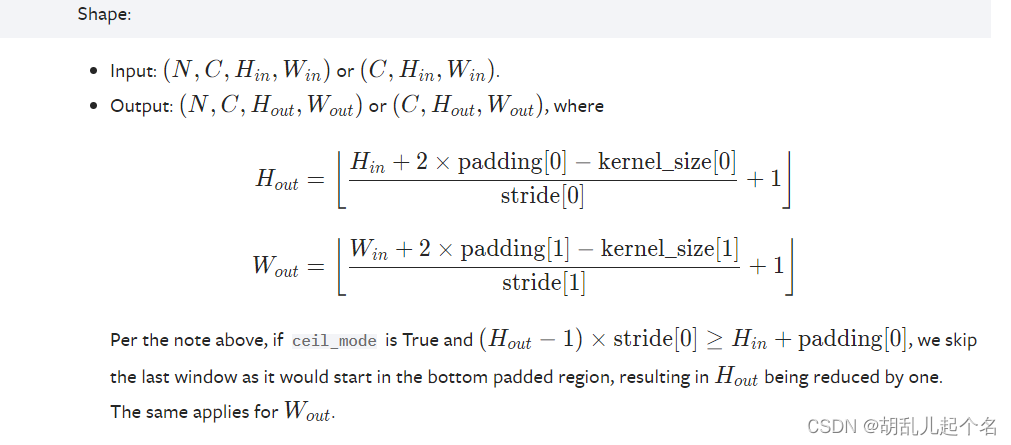

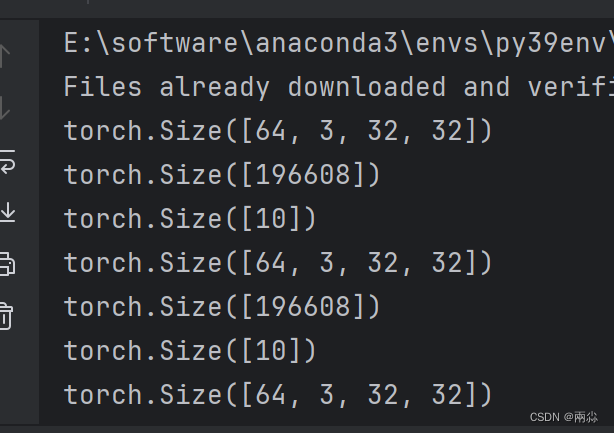

pytorch--Pooling layers

文章目录 1.torch.nn.MaxPool1d()2.torch.nn.MaxPool2d3.torch.nn.AvgPool2d()4.torch.nn.FractionalMaxPool2d()5.torch.nn.AdaptiveMaxPool2d()6.torch.nn.AdaptiveAvgPool2d() 1.torch.nn.MaxPool1d() t

Llama模型家族之Stanford NLP ReFT源代码探索 (二)Intervention Layers层

LlaMA 3 系列博客 基于 LlaMA 3 + LangGraph 在windows本地部署大模型 (一) 基于 LlaMA 3 + LangGraph 在windows本地部署大模型 (二) 基于 LlaMA 3 + LangGraph 在windows本地部署大模型 (三) 基于 LlaMA 3 + LangGraph 在windows本地部署大模型 (四) 基于 LlaMA 3

神经网络 torch.nn---Linear Layers(nn.Linear)

torch.nn - PyTorch中文文档 (pytorch-cn.readthedocs.io) torch.nn — PyTorch 2.3 documentation nn.Linear torch.nn.Linear(in_features, out_features, bias=True, device=None, dtype=None) 参数: in_features -

Keras深度学习框架基础第四讲:层接口(layers API)“层权重约束”

1、层权重约束概述 1.1 层权重约束的定义 Keras层权重约束的定义主要涉及到在训练神经网络模型时,对层的权重参数施加一定的限制或约束,以提高模型的泛化能力和稳定性。以下是关于Keras层权重约束的详细定义: 约束的目的: 防止过拟合:通过限制权重的大小或范围,可以减少模型对训练数据的过度依赖,从而提高模型在未见数据上的性能。 提高模型稳定性:约束可以确保权重参数在合理的范围内变化

Keras深度学习框架基础第二讲:层接口(layers API)第二部分“基本层类”

1、layer 类 典型的layer类如下 keras.layers.Layer(activity_regularizer=None,trainable=True,dtype=None,autocast=True,name=None,**kwargs) 这是一个所有层都继承的基类。 一个层是一个可调用的对象,它接受一个或多个张量作为输入,并输出一个或多个张量。它涉及计算,这些计算在ca

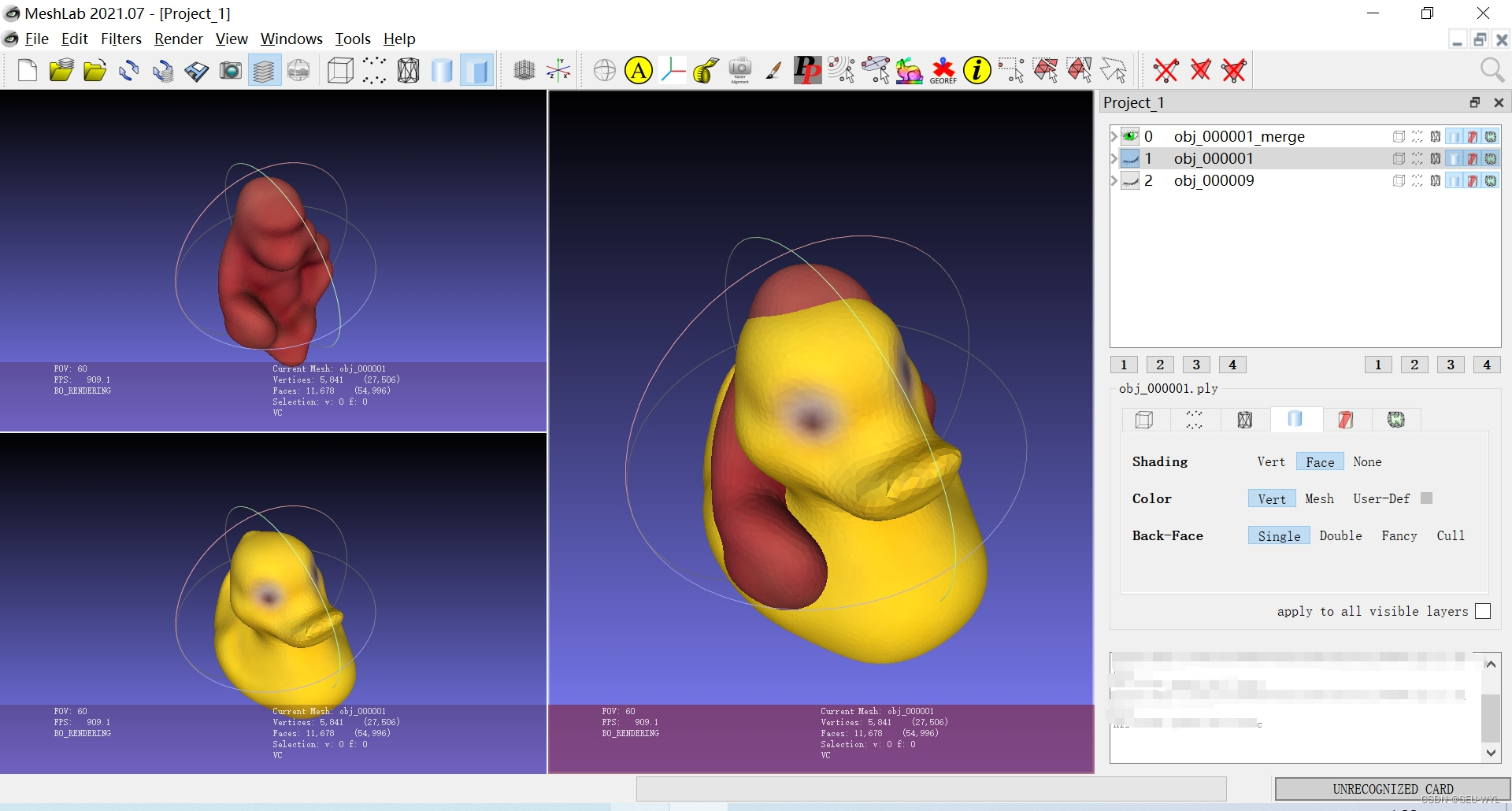

meshlab: pymeshlab合并多个物体模型并保存(flatten visible layers)

一、关于环境 请参考:pymeshlab遍历文件夹中模型、缩放并导出指定格式-CSDN博客 二、关于代码 本文所给出代码仅为参考,禁止转载和引用,仅供个人学习。 本文所给出的例子是https://download.csdn.net/download/weixin_42605076/89233917中的obj_000001.ply和obj_000009.ply。 合并多个物体模型并不是布

Tensorflow常用函数-keras.layers.Dense

keras.layers.Dense(units, activation=None, use_bias=None, kernel_initializer=None,bias_initializer=None,kernel_regularizer=None,bias_regularizer=None,activity_regularizer=None,kernel_constraint=None,b

TensorFlow使用之tf.layers.batch_normalization函数详解

1、写在前面 这是我的处女作,其实想写写自己的博客有一段时间了,主要也是为了记录自己所学到的新知识点,以后可以再来回顾一下,另则加深印象。由于最近在准备做OCR识别的内容,后来遇到了tf.layers.batch_normalization()这个函数,经过多方的学习网上大佬们的文章之后,在此以最简单的方式来说说这个函数,并把自己学习的过程走过的弯路在此记下,希望有缘人能够看到,互相交流。 2

openlayers 入门教程(四):layers 篇

还是大剑师兰特:曾是美国某知名大学计算机专业研究生,现为航空航海领域高级前端工程师;CSDN知名博主,GIS领域优质创作者,深耕openlayers、leaflet、mapbox、cesium,canvas,webgl,echarts等技术开发,欢迎加底部微信(gis-dajianshi),一起交流。 No.内容链接1Openlayers 【入门教程】 - 【源代码+示例300+】

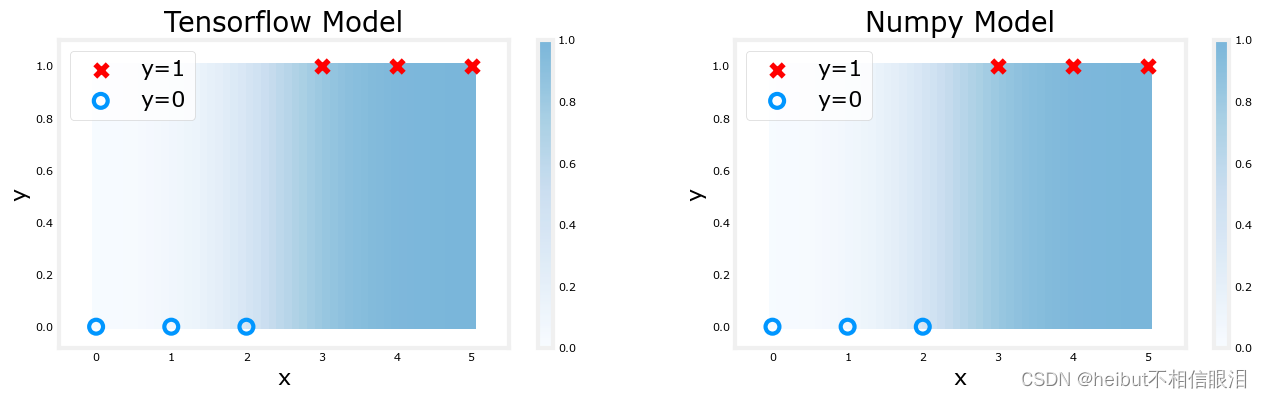

吴恩达机器学习-可选实验室:神经元和层(Neurons and Layers)

文章目录 可选实验室:神经元和层包无激活神经元-回归/线性模型Sigmoid激活的神经元祝贺 可选实验室:神经元和层 实验室将探索神经元和层的内部工作原理,特别是将课程1中掌握的模型,即回归/线性模型和逻辑斯蒂模型,与之进行对比。本实验室将介绍Tensorflow并演示这些模型是如何在该框架中实现的。 包 Tensorflow和Keras Tensorflow是谷歌开发的

[记录]-cannot import name ‘prelu‘ from ‘lasagne.layers‘

问题:cannot import name 'prelu' from 'lasagne.layers' 现有版本:lasagne== 0.1,需要更新版本,直接pip installLasagne==0.2 目前还不行 需要去源码下载 命令: pip install --upgrade https://github.com/Theano/Theano/archive/master.zip

from tensorflow.keras.layers import Dense,Flatten,Input报错无法引用

from tensorflow.keras.layers import Dense,Flatten,Input 打印一下路径: import tensorflow as tfimport kerasprint(tf.__path__)print(keras.__path__) ['E:\\开发工具\\pythonProject\\studyLL\\venv\\lib\\si

猫头虎分享已解决Bug || ImportError: cannot import name ‘relu‘ from ‘keras.layers‘

博主猫头虎的技术世界 🌟 欢迎来到猫头虎的博客 — 探索技术的无限可能! 专栏链接: 🔗 精选专栏: 《面试题大全》 — 面试准备的宝典!《IDEA开发秘籍》 — 提升你的IDEA技能!《100天精通鸿蒙》 — 从Web/安卓到鸿蒙大师!《100天精通Golang(基础入门篇)》 — 踏入Go语言世界的第一步!《100天精通Go语言(精品VIP版)》 — 踏入Go语言世界的第二步!

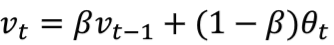

DL学习笔记【20】nn包中的各位Simple layers

来自教程: https://github.com/torch/nn/blob/master/doc/simple.md 这个还是比较容易明白,只简单写一下咯 Parameterized Modules Linear 公式如下: y = Ax + b SparseLinear 稀疏的,输入的

DL学习笔记【17】nn包中的各位Convolutional layers

用一句喜欢的话开始这篇博文:if you can't explain it simply, you don't understand it well enough. 参考文章:https://github.com/torch/nn/blob/master/doc/convolution.md#nn.VolumetricReplicationPadding Temporal Modules

tf.contrib.layers.fully_connected详解

博主 https://www.jianshu.com/p/673fd07954e9 tf.contrib.layers.fully_connected(F, num_outputs,activation_fn) F ---[batch_size,images_pixels],tensor num_outputs --- numbers of outputs,[batch_size,num_

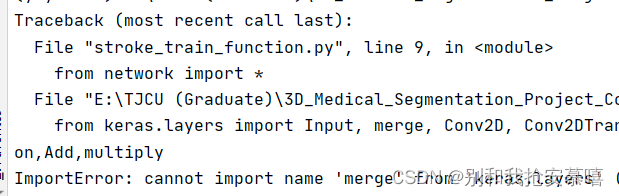

解决问题(Tensorflow框架):ImportError: cannot import name ‘merge‘ from ‘keras.layers‘

看了一圈解决方案,没有找到跟我这个相关的 这就是版本兼容性问题 说句最简单的,针对我这个问题 直接把merge删除点就完事了,因为新版的tensorflow框架这个里面不包含merge,所以直接删掉问题就解决了

GCN学习:用PyG实现自定义layers的GCN网络及训练(五)

深度讲解PyG实现自定义layer的GCN 完整代码自定义layer传播方式从节点角度解读GCN原理逐行讲解代码原理initforwardmessage 目前的代码讲解基本都是直接使用PyG内置的包实现固定结构的网络层。虽然我们可以通过每层使用不同的传递方式来建立不同的网络,但是却不能自定义网络层的传递方式,对于做创新性的研究工作而言是一个不足。 本篇在 GCN学习:Pyt

layers.Normalization

标准化,就是执行 特征标准化层, 第一种方式:通过数据计算出均值和方差: adapt_data = np.array([[0., 7., 4.],[2., 9., 6.],[0., 7., 4.],[2., 9., 6.]], dtype='float32')input_data = np.array([[0., 7., 4.]], dtype='float32')layer = tf.

【阅读笔记】Layer-wise relevance propagation for neural networks with local renormalization layers

Binder, Alexander, et al. “Layer-wise relevance propagation for neural networks with local renormalization layers.” International Conference on Artificial Neural Networks. Springer, Cham, 2016. 本文是探究

keras.layers.Conv2D() 函数参数

tf.keras.layers.Conv2D() 函数 Conv2D (二维卷积层) 这一层创建了一个卷积核,它与这一层的输入卷积以产生一个输出张量 当使用此层作为模型的第一层时,提供关键字参数 input_shape (整数元组,不包括样本轴,不需要写batch_size) def __init__(self, filters,kernel_size,strides=(1, 1),pad