huggingface专题

我的第2个AI项目-RAG with Gemma hosted on HuggingFace and Weaviate in DSPy

目录 项目简介概述时间kaggle地址主要工作和收获技术栈数据集模型表现 未来项目说明思路和原则为什么不把现在的项目做深一点?博客风格转变 bug修复版本兼容问题 项目简介 概述 本项目简要介绍了如何使用 DSPy 构建一个简单的 RAG 管道,且利用了托管在 Hugging Face 上的 Gemma LLM模型 和 Weaviate 向量数据库。 时间 2024.09

huggingface快速下载模型及其配置

大家知道,每次进huggingface里面一个个手动下载文件然后再上传到我们的服务器是很麻烦的。其实huggingface提供了下载整个包的命令,很简单,如下: 1. 进入huggingface官网,随便搜索一个模型,点击右上角的三个点,如下图: 2. 出现如下图的命令。 也就是按照他的提示,你需要首先安装lfs包,然后回到自己的model文件路径中,用git clone来克隆该包即可下

服务器/linux上登录huggingface网站

在服务器上使用 Hugging Face 的 transformers 库时,如果需要访问私有模型或使用 Hugging Face 的 API,你可以通过 huggingface-cli login 命令来登录你的 Hugging Face 账户。以下是具体步骤: 1. 运行 Hugging Face 登录命令 在服务器的终端中,运行以下命令来登录 Hugging Face 账户: hugg

模型从 HuggingFace 转存到 ModelScope

由于 HuggingFace 网络访问比较慢,国内通常会使用魔搭下载模型,如果魔搭上还没有,需要从 HuggingFace 准存一下,本文将通过 Colab + AliyunPan 的方式下载模型并进行转存。 登录Colab 并运行一下命令 安装依赖包,Huggingface 和云盘 # 安装需要的包!pip install huggingface_hub aligo 下载模型 im

【HuggingFace Transformers】LlamaMLP源码解析

LlamaMLP源码解析 1. LlamaMLP 介绍2. LlamaMLP类 源码解析 1. LlamaMLP 介绍 LlamaMLP 是 LLaMA 模型中的 MLP 层,主要用于对输入特征进行非线性变换。在分片预训练模式下,线性层的权重被切分,分步处理后再进行拼接和求和,而在常规模式下,直接应用线性变换和激活函数处理输入数据。其计算公式为: o u t p u t = W

huggingface.co 无法访问问题换源解决

原因 Hugging Face是一家美国公司,专门开发用于构建机器学习应用的工具。该公司的代表产品是其为自然语言处理应用构建的transformers库,以及允许用户共享机器学习模型和数据集的平台。 既然是美国的公司,自然涉及到科学上网的问题, 但是科学上网并不稳定。 报错信息 requests.exceptions.ConnectionError: (MaxRetryError("HTTP

【HuggingFace Transformers】LlamaModel源码解析

LlamaModel源码解析 1. LlamaModel 介绍2. LlamaModel类 源码解析3. 4维因果注意力掩码生成 1. LlamaModel 介绍 LlamaModel 是一个基于 Transformer 架构的解码器模型,用于自然语言处理任务。它是 Meta 的 LLaMA (Large Language Model Meta AI) 系列的一部分,设计用于生成

重磅 | HuggingFace自然语言处理详解,快速掌握HuggingFace这本书足够了

前言 本书是一本全面介绍HuggingFace社区提供的两大核心工具集——datasets 和 transformers 的指南。 它不仅涵盖了基本的使用方法,还包括了实际项目的开发流程和预训练模型的设计理念与实现机制。本书分为三个部分: 工具集基础用例演示篇(第1~6章) —— 详细介绍HuggingFace工具集的基础操作和一般工作流程,确保读者能够迅速上手。中文项目实战篇(第7~1

如何在huggingface上下载模型

先安装: pip install huggingface_hub 终端登录huggingface账号: huggingface-cli login 填写上自己的token之后现实登录成功,然后就可以下载不需要额外认证的模型 如果不能连接上huggingface,可以使用镜像网站,在终端运行: export HUGGINGFACE_CO_RESOLVE_ENDPOINT=https:/

【HuggingFace Transformers】BertSelfOutput 和 BertOutput源码解析

BertSelfOutput 和 BertOutput源码解析 1. 介绍1.1 共同点(1) 残差连接 (Residual Connection)(2) 层归一化 (Layer Normalization)(3) Dropout(4) 线性变换 (Linear Transformation) 1.2 不同点(1) 处理的输入类型(2) 线性变换的作用(3) 输入的特征大小 2. 源码解析

【HuggingFace Transformers】BertIntermediate 和 BertPooler源码解析

BertIntermediate 和 BertPooler源码解析 1. 介绍1.1 位置与功能1.2 相似点与不同点 2. 源码解析2.1 BertIntermediate 源码解析2.2 BertPooler 源码解析 1. 介绍 1.1 位置与功能 (1) BertIntermediate 位置:位于 BertLayer 的注意力层(BertSelfAttention

基于huggingface peft进行qwen1.5-7b-chat训练/推理/服务发布

一、huggingface peft微调框架 1、定义 PEFT 是一个为大型预训练模型提供多种高效微调方法的Python库。 微调传统范式是针对每个下游任务微调模型参数。大模型参数总量庞大,这种方式变得极其昂贵和不切实际。PEFT采用的高效做法是训练少量提示参数(Prompt Tuning)或使用低秩适应(LORA)等重新参数化方法来减少微调时训练参数的数量。 二、qwen-1.5b-c

【HuggingFace Transformers】BertSelfAttention源码解析

BertSelfAttention源码解析 1. BertSelfAttention类 介绍1.1 关键组件1.2 主要方法 2. BertSelfAttention类 源码解析(核心简版)3. BertSelfAttention类 源码解析 1. BertSelfAttention类 介绍 BertSelfAttention 类是 BERT 模型的核心组件之一,主要负责实现多头

好书强推丨HuggingFace自然语言处理详解,快速掌握HuggingFace这本书足够了

今天又来给大家推荐一本HuggingFace的好书,这本《HuggingFace自然语言处理详解》综合性讲解HuggingFace社区提供的工具集datasets和transformers,书中包括最基础的工具集的用例演示,具体的项目实战,以及预训练模型的底层设计思路和实现原理的介绍。 通过本书的学习,读者可以快速掌握HuggingFace工具集的使用方法,掌握自然语言处理项目的一般研发流程,并

利用命令行从youtube下载影片,并用huggingface的大语言模型翻译成中文

今天,从网络流媒体上下载字幕,并把它翻译成各种语言是一个非常常规的操作。 我创建了一个工作流程。可以根着这个工作流程,从网上先下载影片,然后转出字幕,最后再做翻译。 https://github.com/victorspaceRMW/download-Youtube-with-yt-dlp-and-translate-with-HuggingFace-s-whisper-model/tree/

huggingface连不上的解决方案

解决方法大全: 【Hugggingface.co】关于huggingface.co无法访问&大模型下载运行报错解决We couldn‘t connect to ‘https://huggingface.co‘ to.-CSDN博客 本文解决方法参考: huggingface连不上的解决方案_huggingface offline mode-CSDN博客 搜素对应的库hugg

HuggingFace CLI 命令全面指南

文章目录 安装与认证1.1 安装 HuggingFace Hub 库使用 pip 安装使用 conda 安装验证安装 1.2 认证与登录生成访问令牌使用访问令牌登录环境变量认证验证认证 下载文件2.1 下载单个文件安装 `huggingface_hub` 库认证与登录下载单个文件 2.2 下载特定版本的文件下载特定版本的文件指定下载路径 创建与管理仓库3.1 创建仓库3.1.1 使用 C

HuggingFace烧钱做了一大批实验,揭示多模态大模型哪些trick真正有效

构建多模态大模型时有很多有效的trick,如采用交叉注意力机制融合图像信息到语言模型中,或直接将图像隐藏状态序列与文本嵌入序列结合输入至语言模型。 但是这些trick为什么有效,其计算效率如何,往往解释得很粗略或者或者缺乏充分的实验验证。 Hugging Face团队最近进行了广泛的实验以验证在构建多模态大模型时哪些trick是真正有效的,得出了一系列极具参考价值的结论,甚至推翻了以往文献中普

下载huggingface上的大模型文件

Git LFS 是一个 Git 扩展,用于处理大文件。你需要先安装 Git LFS,然后再尝试克隆仓库。 安装 Git LFS 对于 Ubuntu/Debian: sudo apt-get install git-lfs 对于 macOS(使用 Homebrew): brew install git-lfs 对于 Windows: 可以从 Git LFS 官方网站下载并安装。

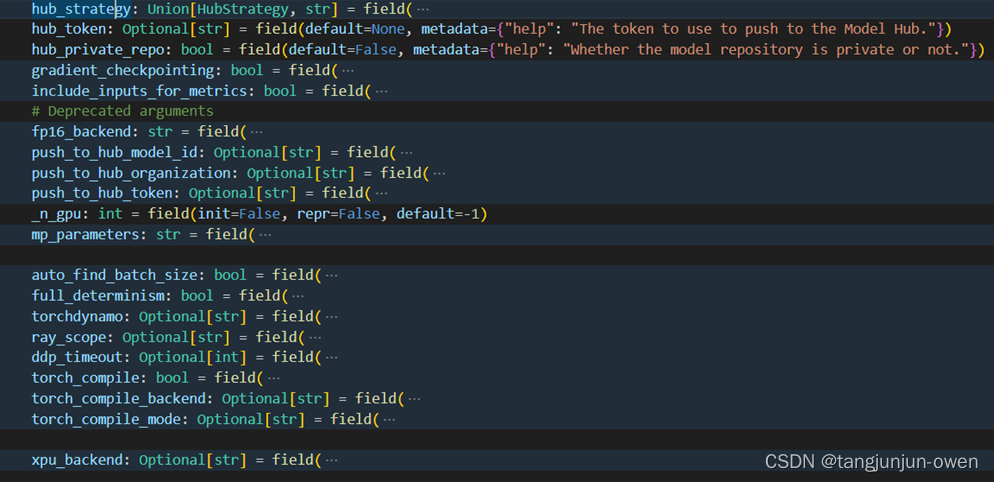

第二章:huggingface的TrainingArguments与Trainner参数

文章目录 前言一、TrainingArguments类参数说明1、TrainingArguments使用Demo2、TrainingArguments参数内容与意义3、TrainingArguments参数图示 二、Trainer类的参数说明1、Trainer类使用Demo2、Trainer类的初始化参数3、参数内容与意义4、部分参数属性说明 总结 前言 大模型基本使用hug

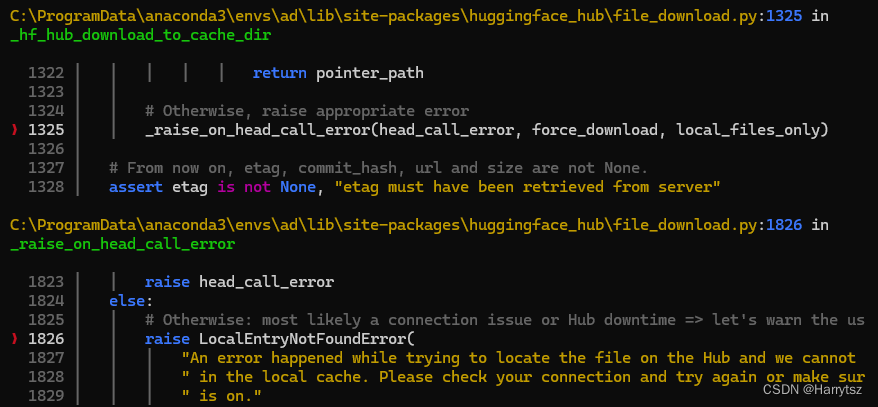

huggingface_hub LocalEntryNotFoundErroringface

报错详细 LocalEntryNotFoundError: An error happened while trying to locate the file on the Hub and we cannot find the requestedfiles in the local cache. Please check your connection and try again or m

Huggingface-cli 登录最新版(2024)

安装Huggingface-cli pip install -U "huggingface_hub[cli]" 设置好git的邮箱和用户名和huggingface的github账号一致 git config --global user.mail xxxgit config --global user.name xxx 登录 复制token,划红线的地方,在命令行中点击右键粘贴,而不

不能访问huggingface、与GPU配置

不能访问huggingface解决方法 如果是从 huggingface.co 下载模型,由于国内不能访问,所以建议先配置一下环境变量, 通过访问国内镜像站点 https://hf-mirror.com来下载模型。 (1)Linux系统设置环境变量: export HF_ENDPOINT=https://hf-mirror.com 示例源码很多需要连接huggin

【langchain】langchain调用huggingface本地模型基础demo

目前网上的langchain教程大多数都是关于如何调用OpenAI等远程模型,对于本地模型的调用示例写法比较少。而且langchain也在不停迭代,文档也比较杂。我个人用Hugging Face的开源模型比较多。因此,本文将向大家介绍如何使用Langchain调用Hugging Face本地模型的基础demo,帮助大家快速开始langchain的“Hello World”。 相关写

DeepSpeed Huggingface模型的自动Tensor并行

推理阶段。在后台,1. DeepSpeed会把运行高性能kernel(kernel injection),加快推理速度,这些对用户是透明的; 2. DeepSpeed会根据mp_size来将模型放置在多个GPU卡上,自动模型并行; import osimport torchimport transformersimport deepspeedlocal_rank = int(os.get

HuggingFace团队亲授大模型量化基础: Quantization Fundamentals with Hugging Face

Quantization Fundamentals with Hugging Face 本文是学习https://www.deeplearning.ai/short-courses/quantization-fundamentals-with-hugging-face/ 这门课的学习笔记。 What you’ll learn in this course Generative AI mo