本文主要是介绍huggingface_hub LocalEntryNotFoundErroringface,希望对大家解决编程问题提供一定的参考价值,需要的开发者们随着小编来一起学习吧!

报错详细

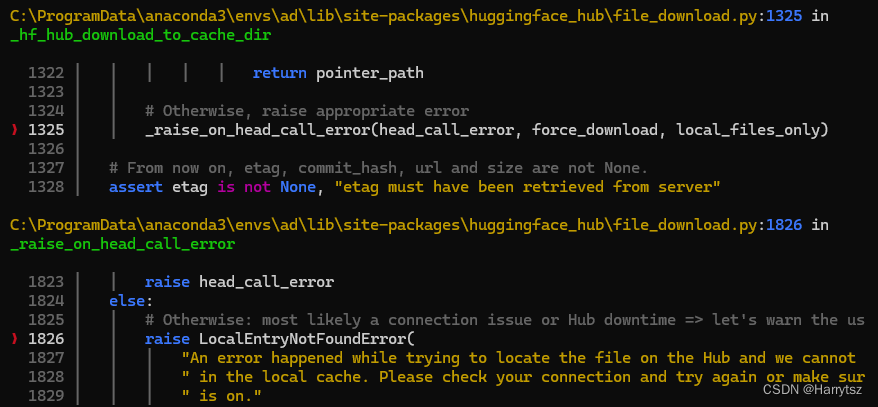

LocalEntryNotFoundError: An error happened while trying to locate the

file on the Hub and we cannot find the requested

files in the local cache. Please check your connection and try

again or make sure your Internet connection is on.

问题说明

在使用到 huggingface时,下载连接不稳定导致,ConnectError。

解决方式

使用镜像网站链接解决稳定性问题,可使用以下其中一种方式改变huggingface网址

1)在超时报错信息中找到 C:\ProgramData\anaconda3\envs\ad\lib\site-packages\huggingface_hub\__init__.py 代码中加入以下代码:

import os

os.environ["HF_ENDPOINT"] = "https://hf-mirror.com"

或者:

2)在命令行中设置环境变量

HF_ENDPOINT=https://hf-mirror.com python xxx.py

这篇关于huggingface_hub LocalEntryNotFoundErroringface的文章就介绍到这儿,希望我们推荐的文章对编程师们有所帮助!