hmm专题

【数学】【机器学习】什么是隐马尔可夫模型 (HMM)?

文章目录 隐马尔可夫模型 (HMM)背景公式示例题目详细讲解Python代码求解实际生活中的例子 什么是隐变量背景隐含变量的意义举例说明HMM的三个基本问题示例 隐马尔可夫模型 (HMM) 背景 隐马尔可夫模型(Hidden Markov Model, HMM)是一种统计模型,用于描述含有隐含变量的时间序列数据。它在自然语言处理、语音识别、生物信息学等领域有广泛应用。HMM

HMM地图匹配算法库Barefoot环境搭建

1.引入gps路径匹配开源项目barefoot 克隆仓库 git clone https://github.com/bmwcarit/barefoot.git 打开项目执行mvn命令将项目打包到maven仓库 mvn install -DskipTests 在自己的maven项目中引入barefoot依赖 <dependency><groupId>com.bmw-c

HMM在自然语言处理中的应用一:词性标注2

http://www.52nlp.cn/hmm-application-in-natural-language-processing-one-part-of-speech-tagging-2 上一节我们对自然语言处理中词性标注的基本问题进行了描述,从本节开始我们将详细介绍HMM与词性标注的关系以及如何利用HMM进行词性标注。首先回顾一下隐马尔科夫模型(HMM)的定义和三大基本问题,并由

一文说尽HMM(隐马尔科夫链)

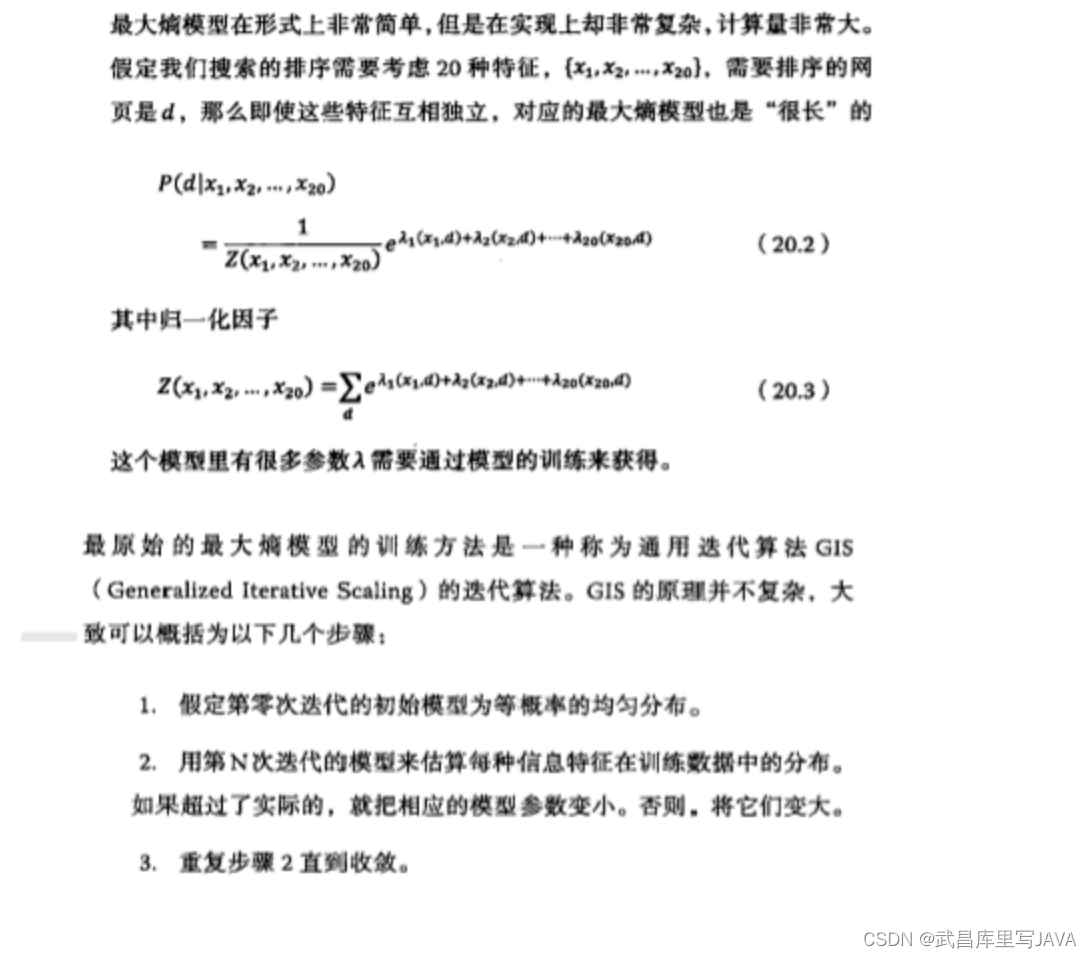

转载大神的博客,原文有很多图:http://www.cnblogs.com/skyme/p/4651331.html 我这里就不贴了 什么是熵(Entropy) 简单来说,熵是表示物质系统状态的一种度量,用它老表征系统的无序程度。熵越大,系统越无序,意味着系统结构和运动的不确定和无规则;反之,,熵越小,系统越有序,意味着具有确定和有规则的运动状态。熵的中文意思是热量被温度除的商。负熵是物质系

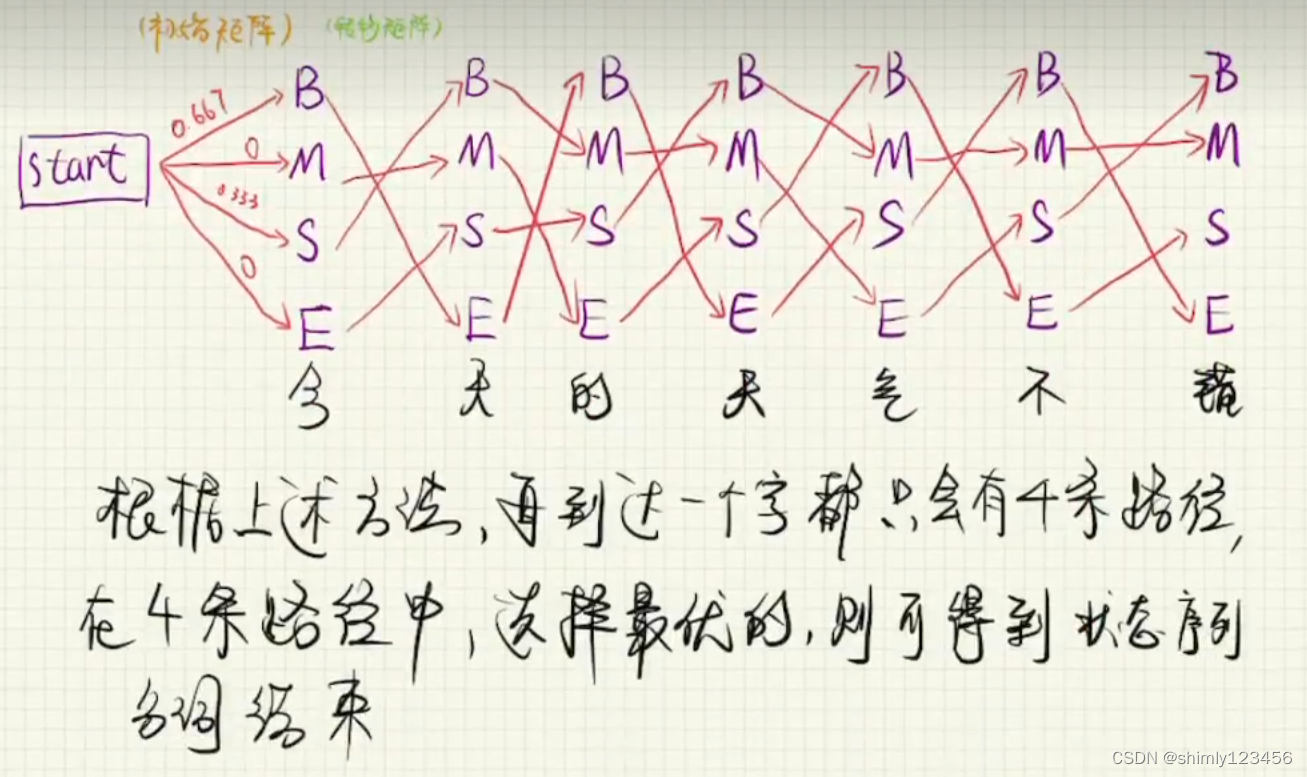

(done) NLP+HMM 协作,还有维特比算法

参考视频:https://www.bilibili.com/video/BV1aP4y147gA/?p=2&spm_id_from=pageDriver&vd_source=7a1a0bc74158c6993c7355c5490fc600 (这实际上是 “序列标注任务”) HMM 的训练和预测如下图 训练过程:我们首先先给出一个语料文本,这个语料文本每个词组都分配了一个“词性”。在训练过程中

隐马尔可夫模型(HMM),了解一下?

隐马尔可夫模型(HMM) 隐马尔可夫模型(HMM) 1. 隐马尔可夫模型基本概念 1.1 定义1.2 观测序列生成过程1.3 3个基本问题 2. 概率计算方法 2.1 直接计算法2.2 前向算法2.3 后向算法 3. 学习算法 3.1 监督学习方法3.2 非监督学习方法 EM算法 Baum-Welch算法 4. 预测算法 4.1 近似算法4.2 维特比算法 1. 隐马尔可

对比五款基于HMM和N-gram模型的开源语音识别工具

在语音识别技术的飞速发展中,开源工具以其灵活性和成本效益,为开发者和研究者提供了宝贵的资源。本文将深入对比五款基于HMM和N-gram模型的开源语音识别工具:CMUSphinx,Kaldi,HTK,Julius和ISIP,同时也会探讨一些基于深度学习的工具,如Mozilla DeepSpeech、Whisper和Flashlight ASR,旨在为开发者提供一个选择和使用的综合指南。 1.

HMM原理简述和使用说明

1、原理简述 为了对GMM-HMM在语音识别上的应用有个宏观认识,花了些时间读了下HTK(用htk完成简单的孤立词识别)的部分源码,对该算法总算有了点大概认识,达到了预期我想要的。不得不说,网络上关于语音识别的通俗易懂教程太少,都是各种公式满天飞,很少有说具体细节的,当然了,那需要有实战经验才行。下面总结以下几点,对其有个宏观印象即可(以孤立词识别为例)。 一、每个

马尔可夫模型及隐马尔可夫模型(HMM)

马尔可夫模型 马尔可夫模型是由Andrei A. Markov于1913年提出的 ∙ ∙ 设 S S是一个由有限个状态组成的集合 S={1,2,3,…,n−1,n} S={1,2,3,…,n−1,n} 随机序列 X X 在 t t时刻所处的状态为 qt qt,其中 qt∈S qt∈S,若有: P(qt=j|qt−1=i,qt−2=k,⋯)=P(qt=j|qt

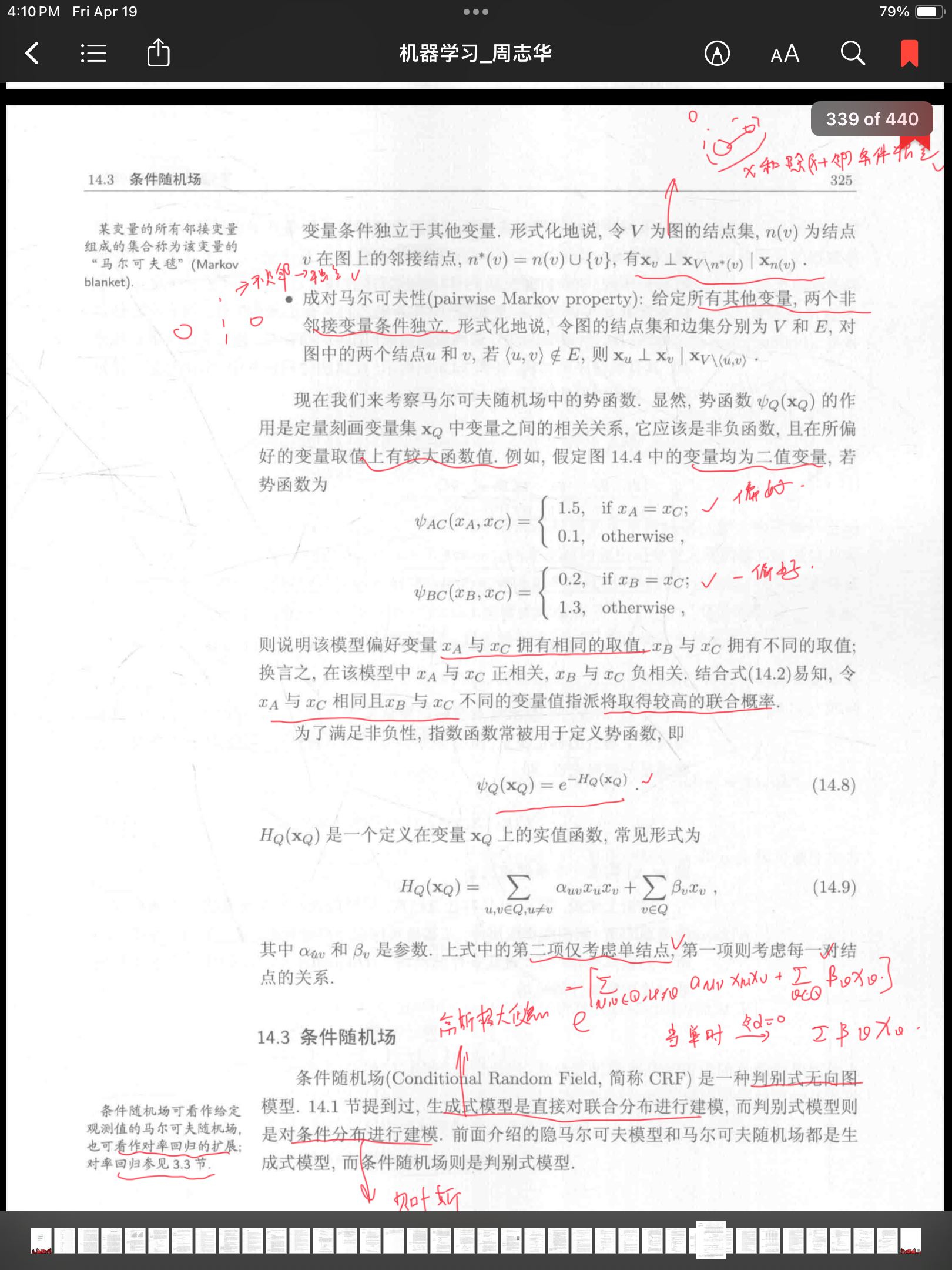

隐马尔可夫模型(HMM)硬啃西瓜书

隐马尔可夫模型(HMM) 好吧隐马尔可夫模型出现的次数实在有点多;今天来讲讲吧 先来四个概念: 可见状态链 观测结果隐含状态链 产生结果的实体类型转换概率 相邻实体之间转换的概率输出概率 实体输出结果的概率 两个基本假设: 1) 齐次马尔科夫链假设。即任意时刻的隐藏状态只依赖于它前一个隐藏状态。 2) 观测独立性假设;实体输出结果的概率完全独立 本来说的是参考几篇文章来写,t

20240325-1-HMM

HMM 直观理解 马尔可夫链(英语:Markov chain),又称离散时间马尔可夫链(discrete-time Markov chain,缩写为DTMC),因俄国数学家安德烈·马尔可夫(俄语:Андрей Андреевич Марков)得名,为状态空间中经过从一个状态到另一个状态的转换的随机过程。 隐马尔可夫模型包含5个要素:初始概率分布,状态转移概率分布,观测概率分布,所有可

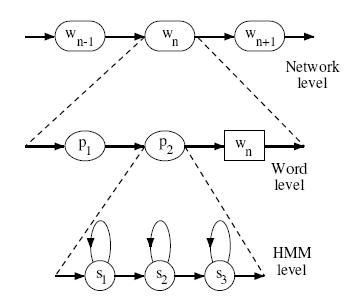

语音识别:基于HMM

HMM语音识别的解码过程 从麦克风采集的输入音频波形被转换为固定尺寸的一组声学向量: 其中是维的语音特征向量(例如MFCC)。 解码器尝试去找到上述特征向量序列对应的单词(word)的序列: 单词序列的长度是。 也即是解码器尝试寻找模型产生的那个最有可能的单词序列: 经过贝叶斯公式: 似然概率是语音识别的声学模型,先验概率是语音模型。 是一个单词由基

隐马尔科夫模型Hmm的研究

隐马尔科夫模型Hmm的研究 摘要 隐马尔可夫模型(Hidden Markov Model,HMM)作为一种统计分析模型,创立于20世纪70年代。80年代得到了传播和发展,成为信号处理的一个重要方向,现已成功地用于语音识别,行为识别,文字识别以及故障诊断等领域。本文主要从以下几个方面研究了hmm。第一,分析了hmm经典三大问题及其推导过程。第二,总结hmm在语音信号处理上一个经典的应用——应用h

GMM-HMM在语音中的应用常识

本人正在攻读计算机博士学位,目前一直再学习各种模型啊算法之类的。所以一直想把自己的学习过程总结一下,所以就开通了这个博客。 这两天一直再看语音识别方面的知识,想把自己的理解总结一下,希望对其他学习的人有所帮助。 提前需要掌握的知识: 语音信号基础:语音信号的表示形式、分帧、特征(MFCC)、音素等等HMM模型:离散隐马尔科夫模型级3个问题的求解方法GMM:混合高斯模型,用于连续隐马尔科夫模型

隐马尔可夫模型(HMM) |前向算法 |一个简单的例子说清计算过程 |一般步骤总结

如是我闻: 本文通过一个简单的例子来详细说明隐马尔可夫模型(HMM)的前向算法 我们求解的问题类型是:给定模型及观测序列计算其出现的概率。 隐马尔可夫模型由三个主要部分组成: 隐藏状态集合观测状态集合以及三个概率矩阵(状态转移概率矩阵、观测概率矩阵、和初始状态概率向量) 1. 示例说明 假设有一个简化的天气模型,其中隐藏状态是“晴朗”(Sunny)和“雨天”(Rainy),观测状态是“干

自然语言处理(十四)——隐马尔科夫模型(HMM)初步理解

一、前言 本文主的目的是对隐马尔科夫模型进行初步的理解,也就是明白这个隐马尔科夫模型到底是个什么东西,明报这个隐马尔科夫模型到底有什么用。至于怎么利用这个马尔科夫模型做一个解决语音识别领域问题的小成品,本文还没有涉及,本人水平有限,正处在小白学习的阶段,因此有什么错误的地方,望各位不吝赐教。下面进入正题,这里用知乎一位答主的例子黄以及志洪老师课程来理解隐马尔科夫模型。 二、骰子案例来理解HMM

GMM/DNN-HMM语音识别:从0讲解HMM类算法原理?看这一篇就够了

摘要 | Abstract 这是一篇对语音识别中的一种热门技术——GMM/DNN-HMM混合系统原理的透彻介绍。 当前网上对HMM类语音识别模型的讲解要么过于简单缺乏深度,要么知识点过于细化零碎分散。而本文旨在为语音识别方面知识储备较少的读者,从头开始深入解读GMM-HMM模型和DNN-HMM模型。 在本文里,我们: 讨论了语音识别里的两个重

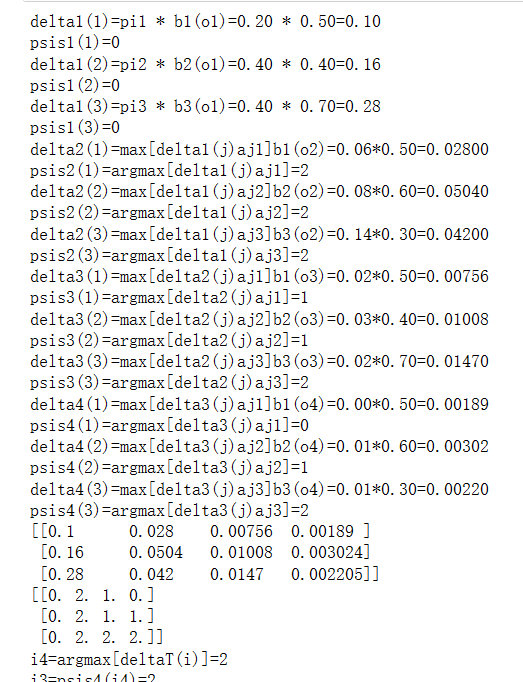

机器学习---HMM前向、后向和维特比算法的计算

1. HMM import numpy as np# In[15]:class HiddenMarkov:def forward(self, Q, V, A, B, O, PI): # 使用前向算法N = len(Q) # 状态序列的大小M = len(O) # 观测序列的大小alphas = np.zeros((N, M)) # alpha值T = M # 有几个时刻,有几个观测序列

概率图系列之隐马尔可夫模型(HMM)

文章目录 概率图模型隐马尔可夫模型(HMM)观测序列的生成HMM的三个基本问题及解法概率问题直接计算前向算法后向算法概率和期望 学习问题监督学习Baum-Welch 算法 预测问题近似算法维特比算法(Viterbi) 结语 概率图模型 概率图模型是一类用图来表达变量相关关系的概率模型。常见的是用一个节点表示一个或一组随机变量,节点之间的边表示变量之间的概率相关关系,如下图:

【正在更新】从零开始认识语音识别:DNN-HMM混合系统语音识别(ASR)原理

摘要 | Abstract TO-BE-FILLED 1.前言 | Introduction 近期想深入了解语音识别(ASR)中隐马尔可夫模型(HMM)和深度神经网络-隐马尔可夫(DNN-HMM)混合模型,但是尽管网络上有许多关于DNN-HMM的介绍,如李宏毅教授的《深度学习人类语言处理》[1],一些博主的语音识别系列文章[2],斯坦福大学HMM课件[3]。但

HMM隐尔马科夫模型

HMM概念 隐马尔可夫模型(Hidden Markov Model,HMM)是统计模型,它用来描述一个含有隐含未知参数的马尔可夫过程。 举一个经典的例子:一个东京的朋友每天根据天气{下雨,天晴}决定当天的活动{公园散步,购物,清理房间}中的一种,我每天只能在twitter上看到她发的推“啊,我前天公园散步、昨天购物、今天清理房间了!”,那么我可以根据她发的推特推断东京这三天的天气。在这个例子

多文多面阐述HMM很清晰

一文搞懂HMM很清晰 https://www.cnblogs.com/fulcra/p/11065474.html HMM抓老千 https://blog.csdn.net/ppn029012/article/details/8923501 大师高德纳给年轻人建议 https://www.youtube.com/watch?v=75Ju0eM5T2c