gram专题

【大模型基础】P1 N-Gram 模型

目录 N-Gram 概述N-Gram 构建过程TokenN-Gram 实例第1步 构建实验语料库第2步 把句子分成 N 个 “Gram”第3步 计算每个 Bigram 在语料库中的词频第4步 计算出现的概率第5步 生成下一个词第6步:输入前缀,生成连续文本 上述实例完整代码N-Gram 的局限性 N-Gram 概述 N-Gram 诞生于统计学 NLP 初期,为解决词序列冗长导致的

word2vec 两个模型,两个加速方法 负采样加速Skip-gram模型 层序Softmax加速CBOW模型 item2vec 双塔模型 (DSSM双塔模型)

推荐领域(DSSM双塔模型): https://www.cnblogs.com/wilson0068/p/12881258.html word2vec word2vec笔记和实现 理解 Word2Vec 之 Skip-Gram 模型 上面这两个链接能让你彻底明白word2vec,不要搞什么公式,看完也是不知所云,也没说到本质. 目前用的比较多的都是Skip-gram模型 Go

每天一个数据分析题(五百一十七)- Skip-Gram模型

Skip-Gram模型的基础形式非常简单,为了更清楚地解释模型,我们先从最一般的基础模型来看Word2Vec。Skip-Gram模型不包含以下哪一项? A. 输入层 B. 池化层 C. 输出层 D. 隐藏层 数据分析认证考试介绍:点击进入 题目来源于CDA模拟题库 点击此处获取答案 数据分析专项练习题库 内容涵盖Python,SQL,统计学,数据分析理论,深度学习,可视化,机器学

Word2Vec之Skip-Gram与CBOW模型

Word2Vec之Skip-Gram与CBOW模型 word2vec是一个开源的nlp工具,它可以将所有的词向量化。至于什么是词向量,最开始是我们熟悉的one-hot编码,但是这种表示方法孤立了每个词,不能表示词之间的关系,当然也有维度过大的原因。后面发展出一种方法,术语是词嵌入。 [1.词嵌入] 词嵌入(Word Embedding)是NL

使用sklearn CountVectorizer 实现n-gram

#coding=utf-8'''Created on 2018-1-25'''from sklearn.feature_extraction.text import CountVectorizertext = ["A smile is the most charming part of a person forever.","A smile is"]# ngram_range=(2, 2)表明

《自然语言处理宗述》英文版N-gram阅读笔记

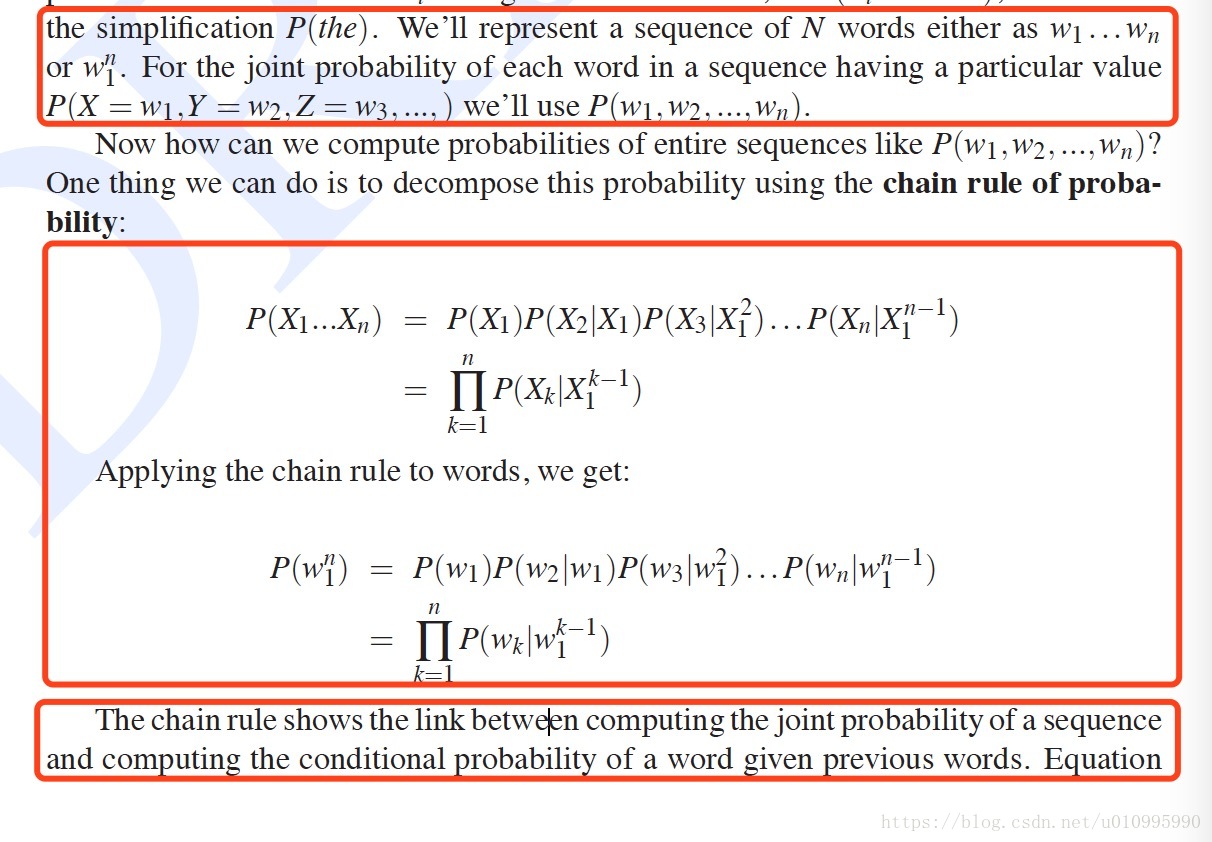

第四章 N-gram模型:用前面的N-1个词去预测第N个词的概率的模型。并且这种预测第N个词的模型。N指的是句子中的连续N个词。最终显示他与预测一系列词出现的概率相似。 4.2 simple(unsmoothed)N-grams 我们的目标是计算在给定一些内容h,来计算词w出现的概率,即P(w | h).比如计算P(the | its water is so transpar

文本处理——Word2Vec之 Skip-Gram 模型(三)

博文地址: https://zhuanlan.zhihu.com/p/27234078 原文英文文档请参考链接:- Word2Vec Tutorial - The Skip-Gram Model - Word2Vec (Part 1): NLP With Deep Learning with Tensorflow (Skip-gram) 什么是Word2Vec和Embeddings?

对比五款基于HMM和N-gram模型的开源语音识别工具

在语音识别技术的飞速发展中,开源工具以其灵活性和成本效益,为开发者和研究者提供了宝贵的资源。本文将深入对比五款基于HMM和N-gram模型的开源语音识别工具:CMUSphinx,Kaldi,HTK,Julius和ISIP,同时也会探讨一些基于深度学习的工具,如Mozilla DeepSpeech、Whisper和Flashlight ASR,旨在为开发者提供一个选择和使用的综合指南。 1.

Sweet Snippet 之 Gram-Schmidt 正交化

Gram-Schmidt 正交化的简单实现 Gram-Schmidt(格拉姆-施密特) 正交化可以正交化一组给定的向量,使这些向量两两垂直,这里列出一份简单的实现(Lua): -- vector addfunction add(a, b)if a and b and #a == #b thenlocal ret = {}for i = 1, #a dotable.insert(ret,

[机器学习与深度学习] - No.1 基于Negative Sampling SKip-Gram Word2vec模型学习总结

基于Negative Sampling SKip-Gram Word2vec模型学习总结 1. Word2vec简介 Word2Vec是从大量文本语料中以无监督的方式学习语义知识的一种模型,它被大量地用在自然语言处理(NLP)中。那么它是如何帮助我们做自然语言处理呢?Word2Vec其实就是通过学习文本来用词向量的方式表征词的语义信息。Word2vec的结果是为了获得Word Embeddin

python-pytorch实现skip-gram 0.5.001

python-pytorch实现skip-gram 0.5.000 数据加载、切词准备训练数据准备模型和参数训练保存模型加载模型简单预测获取词向量画一个词向量的分布图使用词向量计算相似度参考 数据加载、切词 按照链接https://blog.csdn.net/m0_60688978/article/details/137538274操作后,可以获得的数据如下 wordList

python-pytorch实现skip-gram 0.5.000【直接可运行】

python-pytorch实现skip-gram 0.5.000【直接可运行】 参考导入包加载数据和切词获取wordList、raw_text获取vocab、vocab_sizeword_to_idx、idx_to_word准备训练数据准备模型和参数训练模型保存模型简单预测获取训练后的词向量画图看下分布利用词向量计算相似度余弦点积 参考 https://blog.csdn.

计算机语言学笔记(三)N-gram和数据平滑

3 N-gram和数据平滑 3.1 语言建模 语言建模:对于一个服从某个未知概率分布P的语言L,根据给定的语言样本估计P的过程被称作语言建模。 语言建模技术首先在语音识别研究中提出,后来陆续用到OCR、,手写体识别,机器翻译,信息检索等领域。 在语音识别中,如果识别结果有多个,则可以根据语言模型计算每个识别结果的可能性,然后挑选一个可能性 较大的识别结果。 对于给定句子s= w1w2w3…,使

【名词解释】ImageCaption任务中的CIDEr、n-gram、TF-IDF、BLEU、METEOR、ROUGE 分别是什么?它们是怎样计算的?

CIDEr CIDEr(Consensus-based Image Description Evaluation)是一种用于自动评估图像描述(image captioning)任务性能的指标。它主要通过计算生成的描述与一组参考描述之间的相似性来评估图像描述的质量。CIDEr的独特之处在于它考虑了人类对图像描述的共识,尝试捕捉描述的自然性和信息量。 CIDEr的计算过程 CIDEr的计算可以分

N-Gram原码分析

N表示词的长度,Gram表示按长度N切分原词得到的词段 1.N最小取值规则,如果原词的长度大于5,则最小值为3,如果原词的长度等于5,则最小值为2,否则最小值为1. 2.N最大值取值规则,如果原词长度大于5,则最大值为4,原词长度等于5,则最大值为3,否则最大值为2. 原码如下: //获取最小值private static int getMin(int l) {if (l > 5) {

Word2vec之skip-gram训练词向量

参考自哈工大车万翔等老师编写的《自然语言处理-基于预训练模型的方法》 # coding: utf-8# Name: tesst2# Author: dell# Data: 2021/10/12# 基于负采样的skip-garm模型import torchimport torch.nn.functional as Fimport torch.nn as nn

三、N元语法(N-gram)

为了弥补 One-Hot 独热编码的维度灾难和语义鸿沟以及 BOW 词袋模型丢失词序信息和稀疏性这些缺陷,将词表示成一个低维的实数向量,且相似的词的向量表示是相近的,可以用向量之间的距离来衡量相似度。 N-gram 统计语言模型是用来计算句子概率的概率模型,即某一个词的出现由其前面每一个词出现的概率决定。假设一个长度为N的句子,句子 S=(X1,...,XN),那么这个句子的概率(也就是这 N

机器学习笔记 大语言模型是如何运作的?一、语料库和N-gram模型

一、语料库 语言模型、ChatGPT和人工智能似乎无处不在。了解大型语言模型(LLM)“背后”发生的事情将是驾驭数字世界的关键。 首先在提示中键入一个单词,然后点击提交。您可以尝试新的提示,并根据需要多次重新生成响应。 这个我们称之为“T&C”的语言模型是在一组被称为语料库的文本上训练的。该语料库是大型科技公司的条款和条件。

【风格迁移】CAST:对比学习,从图像特征而非其二阶统计量(Gram矩阵)中学习风格

CAST:对比学习,从图像特征而非其二阶统计量(Gram矩阵)中学习风格 提出背景5 why 分析5 so分析 CAST 框架多层风格投影器领域增强模块生成网络 效果对比 StyleGAN 提出背景 论文:https://arxiv.org/pdf/2205.09542.pdf 代码:https://github.com/zyxElsa/CAST_pytorch.

读懂Word2Vec之Skip-Gram

本教程将介绍Word2Vec的skip gram神经网络体系结构。我这篇文章的目的是跳过对Word2Vec的一般的介绍和抽象见解,并深入了解其细节。具体来说,我正在深入skipgram神经网络模型。 模型介绍 skip-gram神经网络模型其最基本的形式实际上是惊人的简单; Word2Vec使用了一个你可能在机器学习中看到过的技巧。我们将训练一个带有单个隐藏层的简单的神经网络来完成某个任务,但是

c++ 线性代数 克·施密特(Gram Schmidt)

克·施密特(Gram-Schmidt)正交化方法是一种将一组线性无关的向量转换为一组正交(垂直)向量的技术。该方法是线性代数中常用的工具,它的核心思想是将一组线性无关的向量集合通过减去它们在前面向量方向上的投影来得到一组正交的向量。 具体步骤如下: 给定一组线性无关的向量 {v₁, v₂, ..., vn}。将第一个向量v₁单位化得到u₁: u₁ = v₁ / ||v₁||,其

cbow 和skip-gram比较

https://blog.csdn.net/weixin_45069761/article/details/106999780?utm_medium=distribute.pc_feed_404.none-task-blog-BlogCommendFromBaidu-1.nonecase&depth_1-utm_source=distribute.pc_feed_404.none-task-blo

11正交矩阵和Gram-Schmidt正交化法

转载自:https://blog.csdn.net/huang1024rui/article/details/69568991 这是关于正交性最后一讲,已经知道正交空间,比如行空间和零空间,今天主要看正交基和正交矩阵 1.标准正交基与正交矩阵 1.定义标准正交向量(orthonormal): qTiqj={01i!=ji=j q i T q j = { 0 i!=j 1 i=j q^

【RNN】理解word2vec中的 Skip-Gram

在处理文字模型的时候,将文字转化成可以放进模型的数字,最简单方法是用 one-hot 编码。但是这种方法有弊端,转化后的每个词之间在数字上都是相互独立的,任何一对词的one-hot向量的余弦相似度都为0,任何词之间都没有关系。 Google团队发表的 word2vec 工具。word2vec工具主要包含两个模型:跳字模型(skip-gram)和连续词袋模型(continuous bag of w

![[机器学习与深度学习] - No.1 基于Negative Sampling SKip-Gram Word2vec模型学习总结](https://img-blog.csdnimg.cn/img_convert/8c61d4a1a0606904cba380eaafffa1d7.png)