gpt2专题

gpt2使用ggml推理

gpt2使用ggml推理 ggml/examples/gpt-2/main-backend.cpp : #include "ggml/ggml.h"#include "ggml/ggml-alloc.h"#include "ggml/ggml-backend.h"#ifdef GGML_USE_CUDA#include "ggml-cuda.h"#endif#ifdef GGML_US

train_gpt2_fp32.cu - layernorm_forward_kernel3

源码 __global__ void layernorm_forward_kernel3(float* __restrict__ out, float* __restrict__ mean, float* __restrict__ rstd,const float* __restrict__ inp, const float* __restrict__ weight,const float*

train_gpt2.c

llm.c/train_gpt2.c at master · karpathy/llm.c (github.com) 源码 /*This file trains the GPT-2 model.This version is the clean, minimal, reference. As such:- it runs on CPU.- it does not make the co

train_gpt2_fp32.cu

源程序 llm.c/test_gpt2_fp32.cu at master · karpathy/llm.c (github.com) #include <stdio.h>#include <stdlib.h>#include <math.h>#include <time.h>#include <assert.h>#include <float.h>#include <string

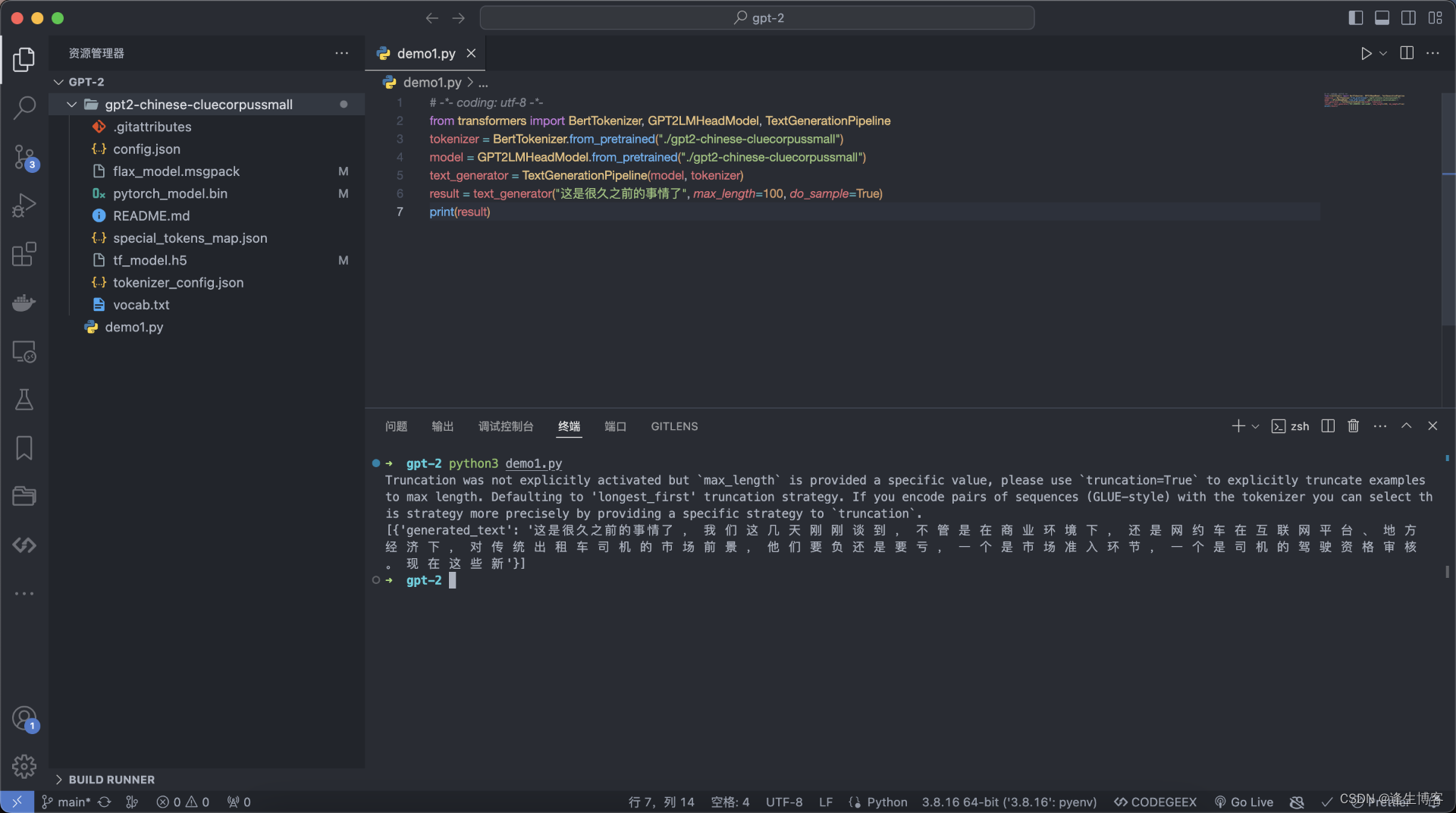

Mac 部署 GPT-2 预训练模型 gpt2-chinese-cluecorpussmall

文章目录 下载 GPT-2 模型快速开始 GPT-2 下载 GPT-2 模型 https://huggingface.co/uer/gpt2-chinese-cluecorpussmall git clone https://huggingface.co/uer/gpt2-chinese-cluecorpussmall# 或单独下载 LFSGIT_LFS_SKIP_SM

GPT2从放弃到入门(一)

引言 这是GPT系列的第二篇文章。在上篇文章中我们实现了GPT1并训练了一个小说生成器。 今天我们尝试实现GPT2来完成小说生成这件事。 模型架构 GPT2很大程度上遵循了GPT-1的细节,但做了一些优化/修改: 层归一化被移动到每个子块(sub-block)的输入处(Pre-LN);在最后一个块之后添加了一个额外的层归一化;使用了一种修改后的初始化方法,考虑了模型深度上残差路径的累

论文精读--GPT2

被BERT敲打了,但是仍然坚持解码器架构 Abstract Natural language processing tasks, such as question answering, machine translation, reading comprehension, and summarization, are typically approached with supervised

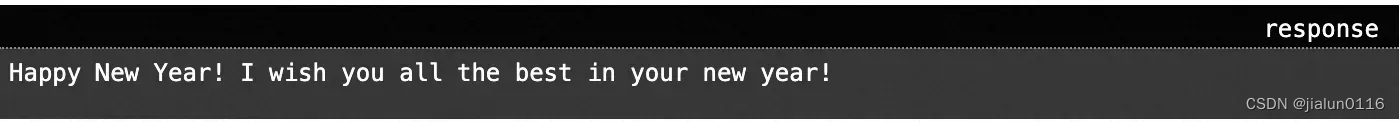

如何用 500 行 SQL 实现 GPT2学习

目录 理论背景实现过程GenerationTokenizerEmbeddingsAttention为什么我们需要有因果掩码?为什么矩阵是 Q,K 和 V? BlocksTokens为什么要使用 softmax 转换概率?Inference 俄罗斯有个大佬每年都会用 SQL 来实现一个挑战庆祝新年,已经坚持了 10 多年了。而 2023 年年底他完成了一件非常了不起的事情,即用

ColossalAI GPT2分布式训练调试配置—GPT系列训练与部署

本文为博主原创文章,未经博主允许不得转载。 本文为专栏《Python从零开始进行AIGC大模型训练与推理》系列文章,地址为“https://blog.csdn.net/suiyingy/article/details/130169592”。 本专栏之前文章详细介绍了Colossal-AI环境搭建及GPT2数据处理与训练。Colossal-AI框架

详解Keras3.0 KerasNLP Models: GPT2 GPT2Tokenizer

1、GPT2Tokenizer 用于将文本数据转换为适合训练和预测的格式,主要功能是将输入的文本进行分词、编码等操作,以便在神经网络中使用 keras_nlp.models.GPT2Tokenizer(vocabulary, merges, **kwargs) 参数说明 vocabulary:一个字典,包含词汇表的映射关系。键是单词,值是对应的索引。merges:一个列表,包含合并规则。

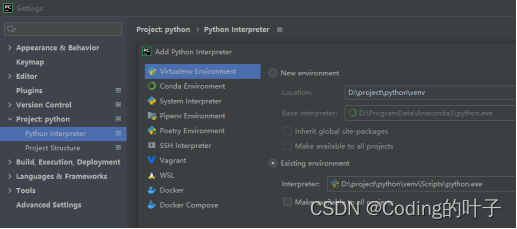

GPT2代码运行,个人文本生成助手,不依赖OpenAI API调用

0.前言: 感觉GPT很好玩,所以想要有个自己搭建GPT的写法,不依赖于OpenAI,需要翻墙太麻烦了,近日日本已经结合GPT4和机器,可以让他吓人,做出丰富的表情,如果自己训练的话,会塑造出什么样的机器人尚未可知…抱着好奇的心态,去github openai下载了个gpt2的模型来玩玩(其中遇到了许多坑),也尝试过其他开源的gpt模型(autogpt(还是调用openai的接口,但是以后可能在个

Word2Vec进阶 -GPT2

Word2Vec进阶 - GPT2 – 潘登同学的NLP笔记 文章目录 Word2Vec进阶 - GPT2 -- 潘登同学的NLP笔记 GPT2网络结构预训练任务机器翻译自动摘要生成阅读理解Zero-shot,One-shot,Few-shot问题来了 Bert与GPT2的区别Bert与GPT2的区别 GPT2网络结构 Bert是用了Transformer的Encoder层,

多图详解attention和mask。从循环神经网络、transformer到GPT2

transformer原理 文章目录 transformer原理1. Transformer的兴起2. 图解Attention2.1 seq2seq2.2 循环神经网络的不足:2.3 attention的引出(重点内容)2.3.1 经典seq2seq模型的改进2.3.2 为什么求内积之后除以 d \sqrt{d} d 2.4 Self-Attention2.4.1 Self-Att

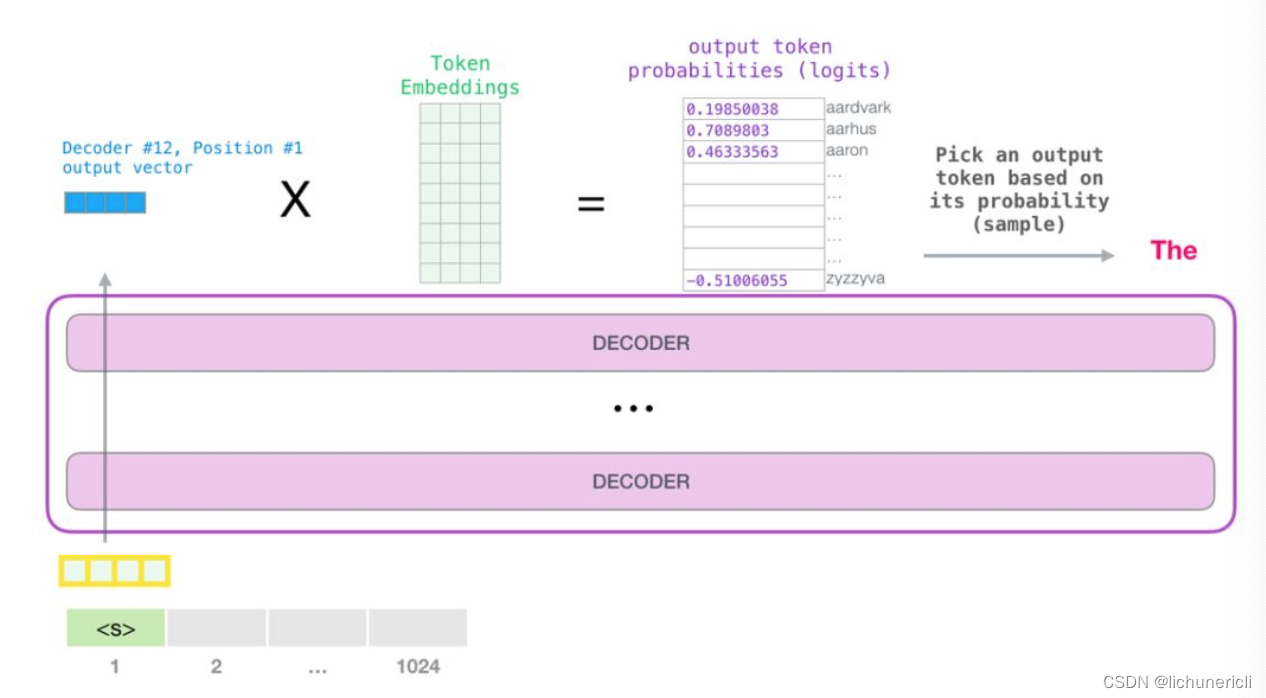

自然语言处理---Transformer机制详解之GPT2模型介绍

1 GPT2的架构 从模型架构上看, GPT2并没有特别新颖的架构, 它和只带有解码器模块的Transformer很像. 所谓语言模型, 作用就是根据已有句子的一部分, 来预测下一个单词会是什么. 现实应用中大家最熟悉的一个语言模型应用, 就是智能手机上的输入法, 它可以根据当前输入的内容智能推荐下一个要打的字. GPT2也是一个语言预测生成模型, 只不过比手机上应用的模型要大很多, 也

T5模型和GPT2模型初步对比

T5模型和GPT2模型初步对比 之前试着用GPT2模型训练了一个诗词对联生成程序( 训练诗词生成模型)。 这个周末初步试了一下用T5模型做同样的事,是想对比一下看看两个模型的区别。 这两种模型都是基于经典的 Transformer 模型该进来的,都比最初的 Transformer 强大复杂的多。最大的区别是 GPT2 只有解码器,T5 同时有编码器和解码器。理论上T5这种模型比

训练诗词生成模型(GPT2)的一点心得

训练诗词生成模型的一点心得 GPT2 一、诗词对比其它文体二、模型选择三、训练集选取四、损失函数五、训练时间六、生成结果七、模型擅长的诗文类型八、将来可做的事情九、模型生成样例 最近学习NPL的一些模型,训练了一个古诗生成模型作为练习。记录一些学习过程中的想法。在电脑上建了一个用于测试的网页,但条件有限,不确定能运行多久。https://www.qizhen.xyz/ 一、诗词

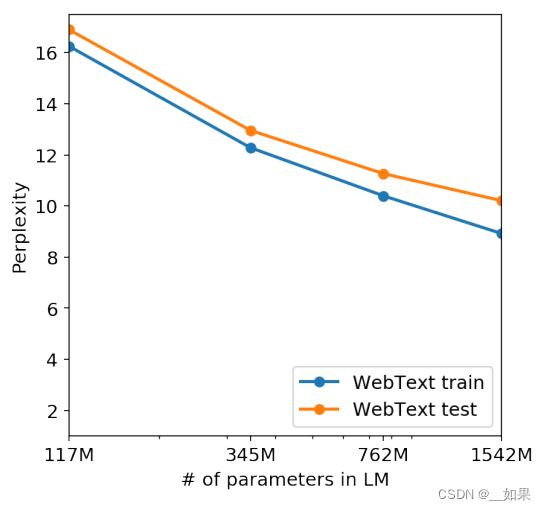

大力出奇迹——GPT系列论文学习(GPT,GPT2,GPT3,InstructGPT)

目录 说在前面1.GPT1.1 引言1.2 训练范式1.2.1 无监督预训练1.2.2 有监督微调1.3 实验 2. GPT22.1 引言2.2 模型结构2.3 训练范式2.4 实验 3.GPT33.1引言3.2 模型结构3.3 训练范式3.4 实验3.4.1数据集3.5 局限性 4. InstructGPT4.1 引言4.2 方法4.2.1 数据收集4.2.2 各部分模型 4.3 总结