本文主要是介绍Mac 部署 GPT-2 预训练模型 gpt2-chinese-cluecorpussmall,希望对大家解决编程问题提供一定的参考价值,需要的开发者们随着小编来一起学习吧!

文章目录

- 下载 GPT-2 模型

- 快速开始 GPT-2

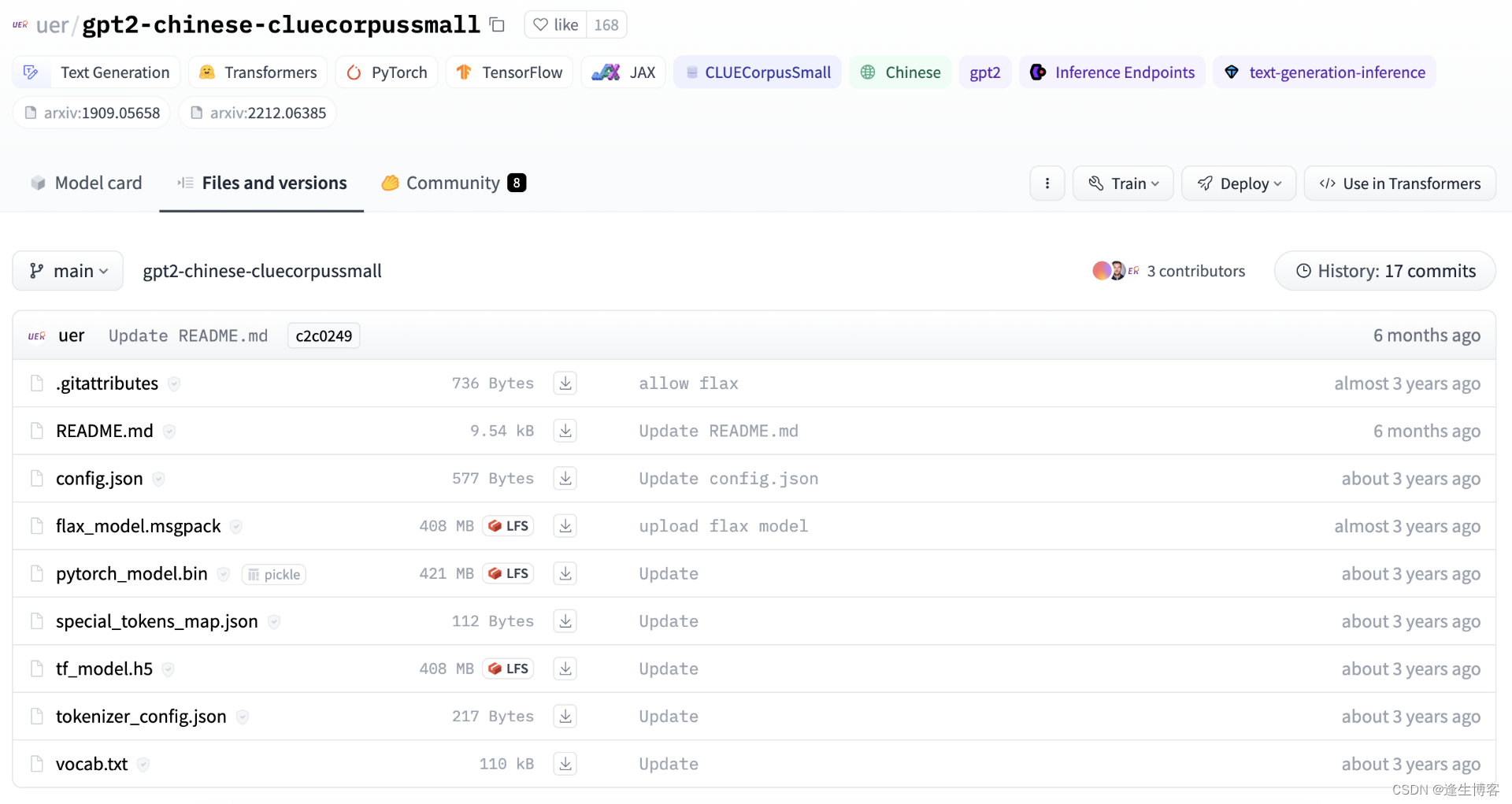

下载 GPT-2 模型

- https://huggingface.co/uer/gpt2-chinese-cluecorpussmall

git clone https://huggingface.co/uer/gpt2-chinese-cluecorpussmall

# 或单独下载 LFS

GIT_LFS_SKIP_SMUDGE=1 git clone https://huggingface.co/uer/gpt2-chinese-cluecorpussmall

快速开始 GPT-2

- 安装依赖

pip3 install torch torchvision torchaudio

pip3 install transformers

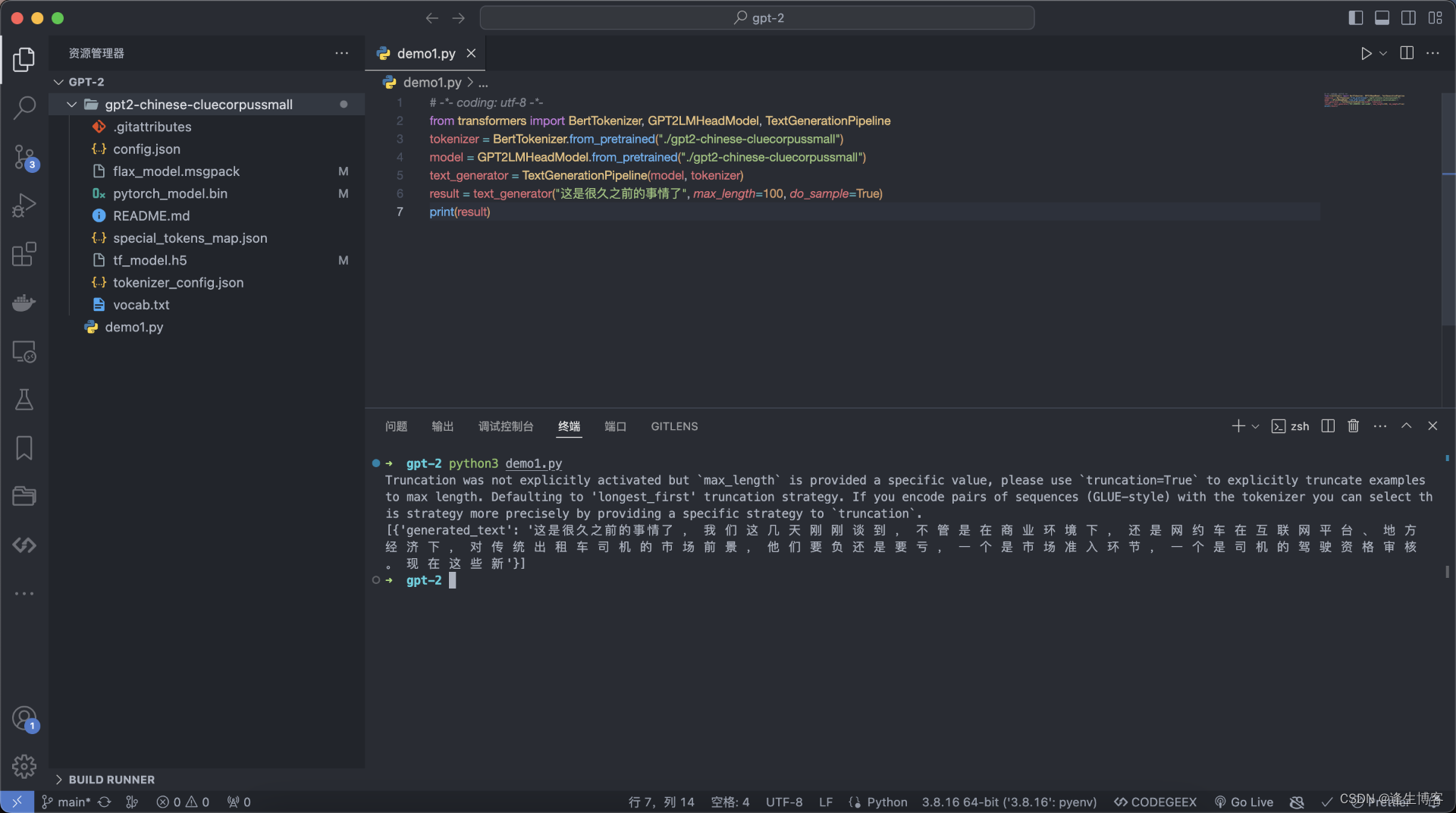

- python脚本

from transformers import BertTokenizer, GPT2LMHeadModel, TextGenerationPipeline

tokenizer = BertTokenizer.from_pretrained("./gpt2-chinese-cluecorpussmall")

model = GPT2LMHeadModel.from_pretrained("./gpt2-chinese-cluecorpussmall")

text_generator = TextGenerationPipeline(model, tokenizer)

result = text_generator("这是很久之前的事情了", max_length=100, do_sample=True)

print(result)

- 输出结果

这篇关于Mac 部署 GPT-2 预训练模型 gpt2-chinese-cluecorpussmall的文章就介绍到这儿,希望我们推荐的文章对编程师们有所帮助!