generative专题

深度学习--对抗生成网络(GAN, Generative Adversarial Network)

对抗生成网络(GAN, Generative Adversarial Network)是一种深度学习模型,由Ian Goodfellow等人在2014年提出。GAN主要用于生成数据,通过两个神经网络相互对抗,来生成以假乱真的新数据。以下是对GAN的详细阐述,包括其概念、作用、核心要点、实现过程、代码实现和适用场景。 1. 概念 GAN由两个神经网络组成:生成器(Generator)和判别器(D

【机器学习】生成对抗网络(Generative Adversarial Networks, GANs)详解

🌈个人主页: 鑫宝Code 🔥热门专栏: 闲话杂谈| 炫酷HTML | JavaScript基础 💫个人格言: "如无必要,勿增实体" 文章目录 生成对抗网络(Generative Adversarial Networks, GANs)详解GANs的基本原理GANs的训练过程GANs的发展历程GANs在实际任务中的应用小结 生成对

CMU 10423 Generative AI:HW0

由于找不到S24版数据集,所以HW0用的F24版的。 项目地址见:https://github.com/YM2025/CMU_10423_2024S 文章目录 0 作业概述1 阅读(3分)2 图像分类(43分)2.1 (3 分)【完成】2.2 (3 分)【完成】2.3 (4 分)【完成】2.4 (4 分)【完成】2.5【完成】2.5.a (3 分)2.5.b (2 分) 2.6 (2 分)

Self-Attention Generative Adversarial Networks解读+部分代码

Self-Attention Generative Adversarial Networks解读+部分代码 引言 这篇是文章是Ian goodfellow他们的新工作,在GAN中引入Attention。 在文章的摘要中作者主要突出了三点。 Self-Attention Generative Adversarial Network(SAGAN)是一个注意力驱动,长范围 关联模型(a

Generative AI原理本质、技术内核及工程实践之基于Vertex AI的大模型 (二)Generative AI on Vertex AI 概览

LlaMA 3 系列博客 基于 LlaMA 3 + LangGraph 在windows本地部署大模型 (一) 基于 LlaMA 3 + LangGraph 在windows本地部署大模型 (二) 基于 LlaMA 3 + LangGraph 在windows本地部署大模型 (三) 基于 LlaMA 3 + LangGraph 在windows本地部署大模型 (四) 基于 LlaMA 3

【机器学习】生成对抗网络 (Generative Adversarial Networks | GAN)

生成对抗网络 (Generative Adversarial Networks | GAN) 介绍 生成对抗网络 (Generative Adversarial Networks,简称GAN) 是一种强大的深度学习模型,用于生成具有逼真感的图像、音频和文本等内容。GAN 的核心理念是通过训练两个神经网络,生成器 (Generator) 和判别器 (Discriminator),它们相互对抗、相

Pytorch手把手实作-Generative Adversarial Network (GAN)

文章目录 一、说明二、GAN的介绍三、生成器和鉴别器四、代码实现 一、说明 前言废话免了,会进来看文章内容的只有四种人:1. 只想知道皮毛,GAN在干什么的 2. 想知道细节怎么把GAN训练起来;3. 收藏在收藏夹或是书签当作有看过了;4. 上课上到一定要点点进来。 二、GAN的介绍 GAN属于unsupervised learning。白话一点,GAN是用来生成资料。讲难听

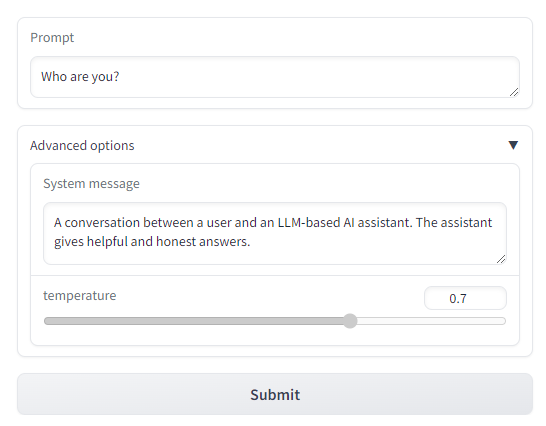

使用Gradio构建大模型应用:Building Generative AI Applications with Gradio

Building Generative AI Applications with Gradio 本文是学习 https://www.deeplearning.ai/short-courses/building-generative-ai-applications-with-gradio/ 这门课的学习笔记。 What you’ll learn in this course Join ou

【论文速读】GPT-1:Improving Language Understanding by Generative Pre-Training

摘要 自然语言理解包括广泛的不同的任务,如文本隐含、问题回答、语义相似性评估和文档分类。虽然大量的未标记文本语料库非常丰富,但用于学习这些特定任务的标记数据非常稀缺,这使得经过区别训练的模型要充分执行任务具有挑战性。我们证明,通过在不同的未标记文本语料库上对语言模型进行生成式预训练,然后对每个特定任务进行区分性微调,可以实现这些任务上的巨大收益。 构架 我们的训练过程包括两个阶段。第一阶段是

智能体之斯坦福AI小镇(Generative Agents: Interactive Simulacra of Human Behavior)

相关代码地址见文末 论文地址:Generative Agents: Interactive Simulacra of Human Behavior | Proceedings of the 36th Annual ACM Symposium on User Interface Software and Technology 1.概述 论文提出了一种多个智能体进行协同,进而模拟

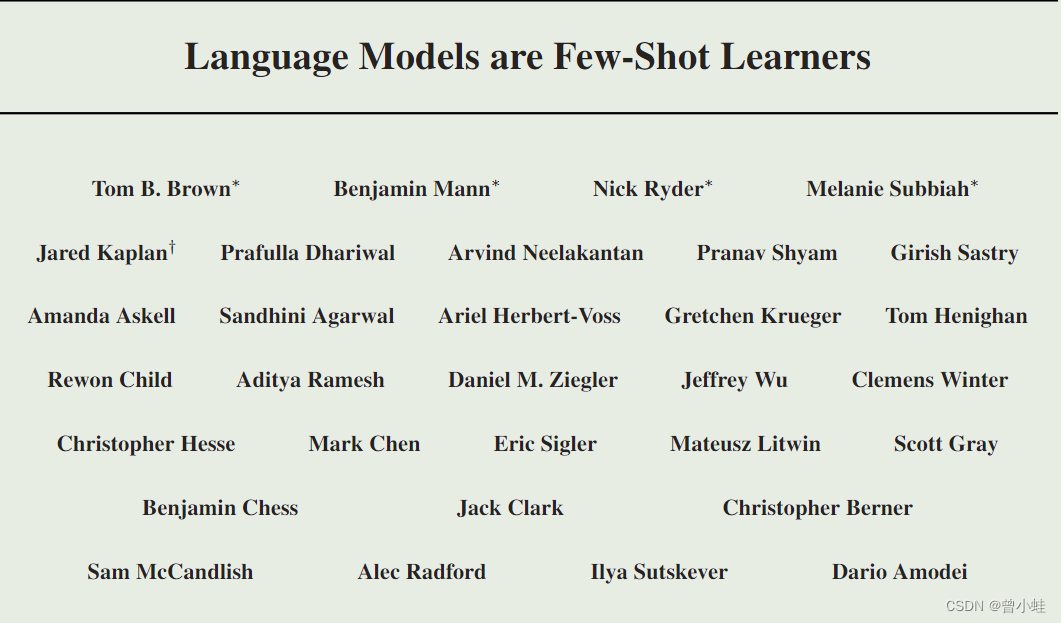

【无监督+自然语言】GPT,GPT-2,GPT-3 方法概述 (Generative Pre-Traning)

主要参考 【GPT,GPT-2,GPT-3 论文精读【李沐论文精读】-2022.03.04】 https://www.bilibili.com/video/BV1AF411b7xQ/ 大语言模型综述: http://t.csdnimg.cn/4obR4 发展节点 2017.06 Transformer: 所有大语言模型LLMs的基础结构 , Attention is all you nee

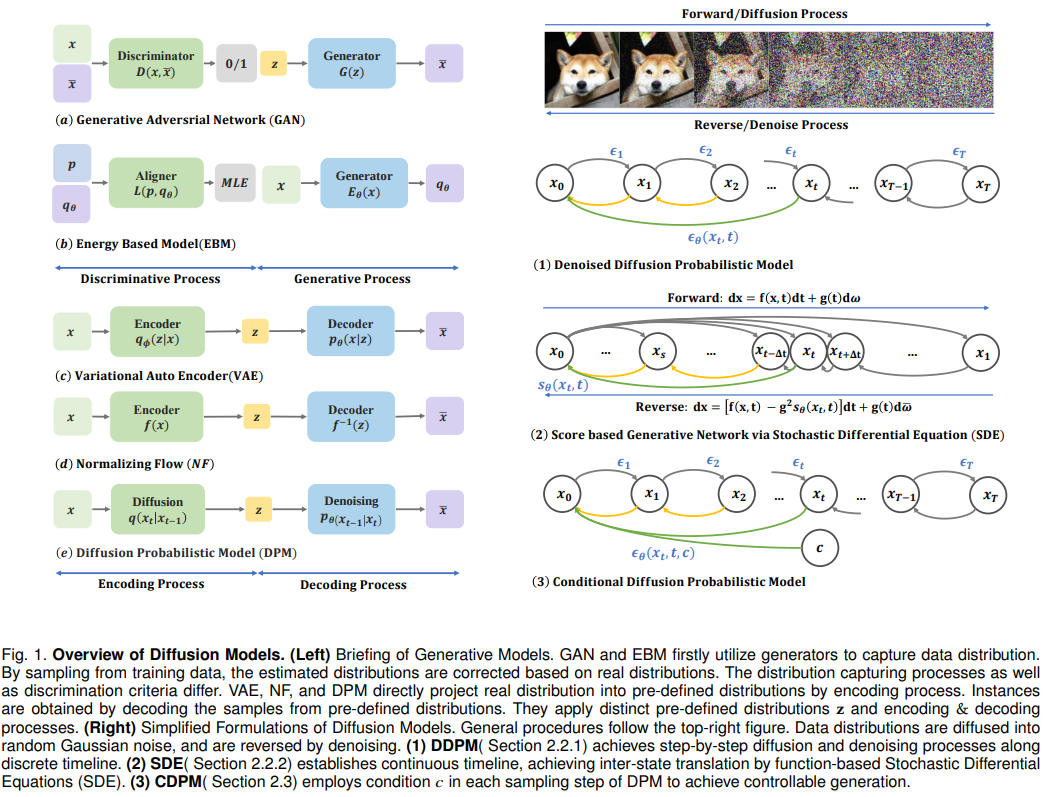

经典文献阅读之--A Survey on Generative Diffusion Models(扩散模型最新综述)

0. 简介 本文综述了深度生成模型,特别是扩散模型(Diffusion model),如何赋予机器类似人类的想象力。扩散模型在生成逼真样本方面显示出巨大潜力,克服了变分自编码器中的后分布对齐障碍,缓解了生成对抗网络中的对抗性目标不稳定性。 扩散模型包括两个相互连接的过程:一个将数据分布映射到简单先验分布的前向过程和一个相应的反向过程。前向过程类似于具有时变系数的简单布朗运动。神经网络通过使用去

AIGC实战——StyleGAN(Style-Based Generative Adversarial Network)

AIGC实战——StyleGAN 0. 前言1. StyleGAN1.1 映射网络1.2 合成网络1.3 自适应实例归一化层1.4 风格混合1.5 随机变化 2. StyleGAN 生成样本3. StyleGAN23.1 权重调制与解调3.2 路径长度正则化3.3 非渐进式增长 4. StyleGAN2 生成样本小结系列链接 0. 前言 StyleGAN (Style-Base

AIGC实战——ProGAN(Progressive Growing Generative Adversarial Network)

AIGC实战——ProGAN 0. 前言1. ProGAN2. 渐进式训练3. 其他技术3.1 小批标准差3.2 均等学习率3.3 逐像素归一化 4. 图像生成小结系列链接 0. 前言 我们已经学习了使用生成对抗网络 (Generative Adversarial Network, GAN) 解决各种图像生成任务。GAN 的模型架构和训练过程具有很高的灵活性,通过改进 GAN

Generative AI for Beginners

Generative AI for Beginners 微软推出的面向初学者的免费生成式人工智能课程。 课程章节相关教学内容学习目标课程介绍和学习环境设置学习环境配置和课程结构在学习本课程的同时帮助您取得成功生成式人工智能和 LLMs 介绍知识点: 生成式人工智能以及我们如何适应当前的技术格局了解什么是生成式人工智能 以及 LLMs 的工作原理。探索和比较不同的 LLMs知识点: 测试、迭代和比

生成对抗网络(GAN Generative Adversarial Nets )简介

常见神经网络形式 神经网络分很多种, 有普通的前向传播神经网络 , 有分析图片的 CNN 卷积神经网络 , 有分析序列化数据, 比如语音的 RNN 循环神经网络 , 这些神经网络都是用来输入数据, 得到想要的结果, 我们看中的是这些神经网络能很好的将数据与结果通过某种关系联系起来. 生成网络 但是还有另外一种形式的神经网络, 他不是用来把数据对应上结果的, 而是用来”凭空”捏造结

图像修复_LaFIn_Generative Landmark Guided Face Inpainting

Abstract 提出了一个深度学习策略来修复人脸图像,这个网络由两个部分组成,一个是人脸关键点预测子网络,该网络的目的是给另一个网络提供人脸的结构信息(破损人脸图像的人脸拓扑信息,表情信息)。另一个是图像修复网络,该网络的目的是修复出符合真实外观的人脸图像。该人脸图像修复方法在数据集CelebA-HQ和CelebA上进行了实验。 Introduction 人脸图像相比较海洋、草地等自然

论文学习 Generative Modeling by Estimating Gradients of the Data Distribution

论文学习 Generative Modeling by Estimating Gradients of the Data Distribution 前言前情提要分数匹配朗格文动力学 核心问题流形假设产生的问题 文章的解决方案 前言 个人认为,这篇Song Yang大佬的文章虽然被网上很多人吹,然而我们还是应该避免捧杀,认真了解一下其文章的内容和思想,以及试图理解他是如何想到这种思

科普文之五分钟轻松入门Generative AI

1. 引言 最近,生成式人工智能(Generative AI)在行业内带来了巨大的变动。还记得 2022 年 11 月推出的 ChatGPT 吗?在短时间内,它就成为了有史以来用户数量最快突破 1 亿的产品。 人工智能已经存在了很长一段时间,它可以做各种各样的事情。但 ChatGPT 之所以如此特别并吸引了人们的注意,是因为它能像人类一样聊天,并能根据简单的提示创建内容。这为企业带来了无限可能

AIGC实战——GPT(Generative Pre-trained Transformer)

AIGC实战——GPT 0. 前言1. GPT 简介2. 葡萄酒评论数据集3. 注意力机制3.1 查询、键和值3.2 多头注意力3.3 因果掩码 4. Transformer4.1 Transformer 块4.2 位置编码 5. 训练GPT6. GPT 分析6.1 生成文本6.2 注意力分数 小结系列链接 0. 前言 注意力机制能够用于构建先进的文本生成模型,Transfor

Learning Representations and Generative Models for 3D Point Clouds

转 计算机小白学习中查看完整翻译. 点击下载英文论文 Abstract Three-dimensional geometric data offer an excellent domain for studying representation learning and generative modeling. In this paper, we look at geometric data

【论文阅读】Elucidating the Design Space of Diffusion-Based Generative Models

Elucidating the Design Space of Diffusion-Based Generative Models 引用: Karras T, Aittala M, Aila T, et al. Elucidating the design space of diffusion-based generative models[J]. Advances in Neural Info

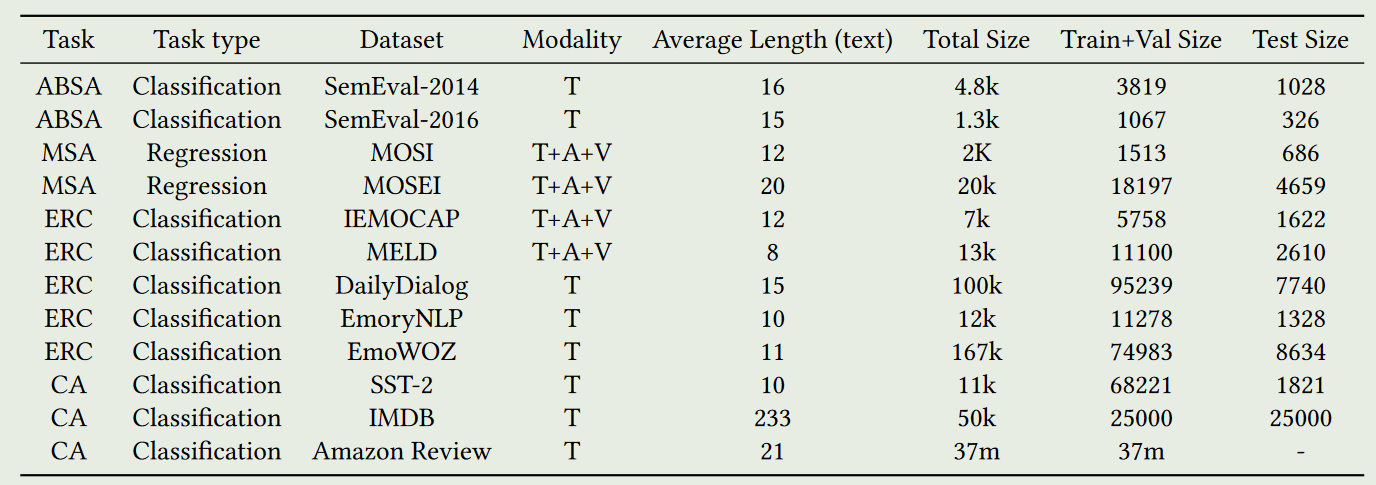

UniSA: Unified Generative Framework for Sentiment Analysis

文章目录 UniSA:统一的情感分析生成框架文章信息研究目的研究内容研究方法1.总体架构图2.基准数据集SAEval3.Task-Specific Prompt4.Modal Mask Training5.Pre-training Tasks5.1Mask Context Modeling5.2Sentiment Polarity Prediction5.3Coarse-grained La

李宏毅机器学习笔记(四)Classification: Probabilistic Generative Model

分类。概率生成模型 binary二进制 理想的做法 二分:大于0和小于0越好 损失函数 :错误次数越少 现有函数: perceptron感知机 SVM支持向量机 用回归来做二分不好的原因 数据偏移大时 结果不好分类 生成概率模型(GenerativeModel) 高斯分布 (Gaussian distribution

【论文笔记】Improving Language Understanding by Generative Pre-Training

Improving Language Understanding by Generative Pre-Training 文章目录 Improving Language Understanding by Generative Pre-TrainingAbstract1 Introduction2 Related WorkSemi-supervised learning for NLPUnsu