本文主要是介绍【无监督+自然语言】GPT,GPT-2,GPT-3 方法概述 (Generative Pre-Traning),希望对大家解决编程问题提供一定的参考价值,需要的开发者们随着小编来一起学习吧!

主要参考

【GPT,GPT-2,GPT-3 论文精读【李沐论文精读】-2022.03.04】 https://www.bilibili.com/video/BV1AF411b7xQ/

大语言模型综述: http://t.csdnimg.cn/4obR4

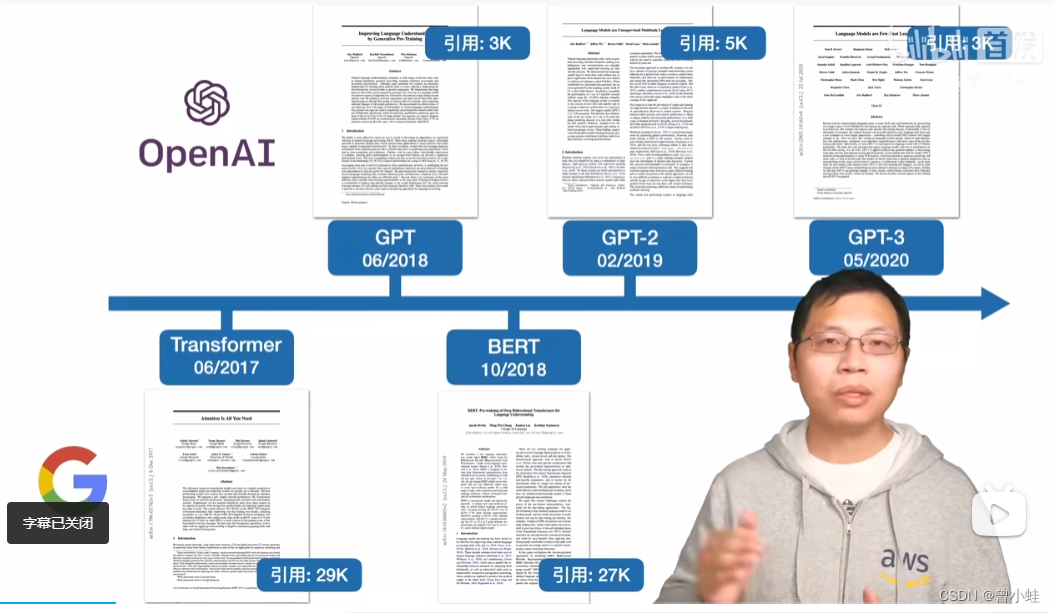

发展节点

2017.06 Transformer: 所有大语言模型LLMs的基础结构 , Attention is all you need !

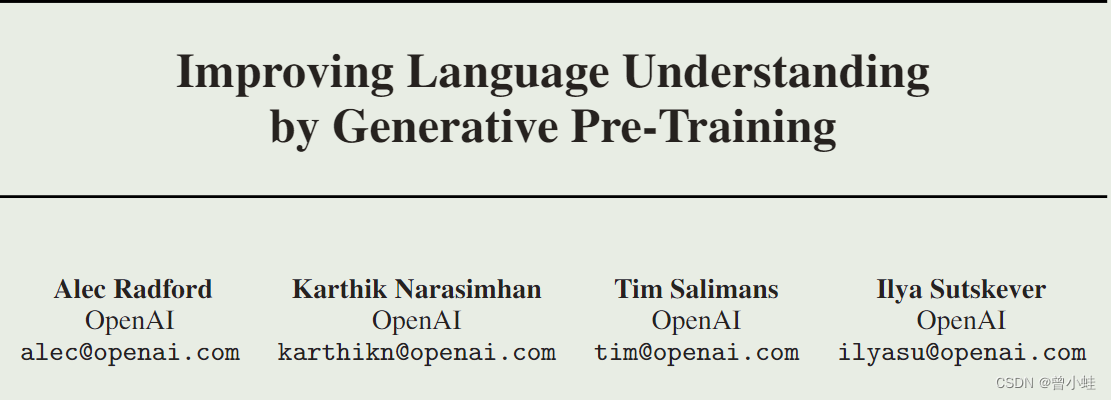

2018.06 GPT: 只用Transformer解码器,只预测未来:Improving language understanding by Generative Pre-Traning

2018.10 BERT:对标GPT,编解码结构,完型填空

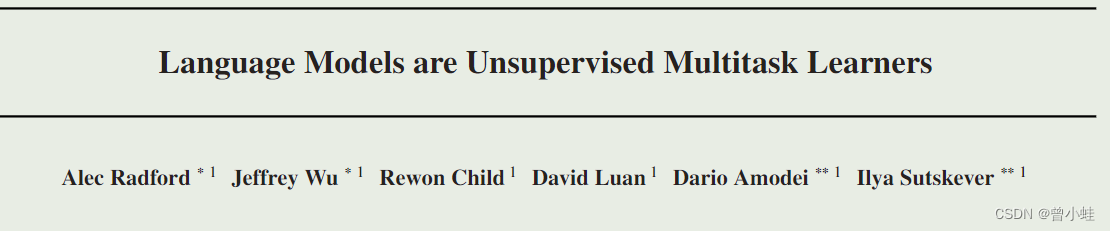

2019.02 GPT-2: 更大的数据集: Language Models are Unsupervised Multitast Learner

2020.05 GPT-3: 相对于GPT-2数据和模型都大了100倍 (极少数公司能做)

GPT-3:Language models are few-shot learners

一、GPT-1: 使用大量没有标记文本无监督训练 (Generative Pre-Traning )

论文:利用生成式预训练来提高自然语言理解

Improving language understanding by Generative Pre-Traning

二阶段训练模型:大量无标记文本 + 人工标注任务

通过在大规模无标签文本语料库上进行生成式预训练,并在每个特定任务上进行判别式微调,可以在多种自然语言理解任务上获得大幅度的提升

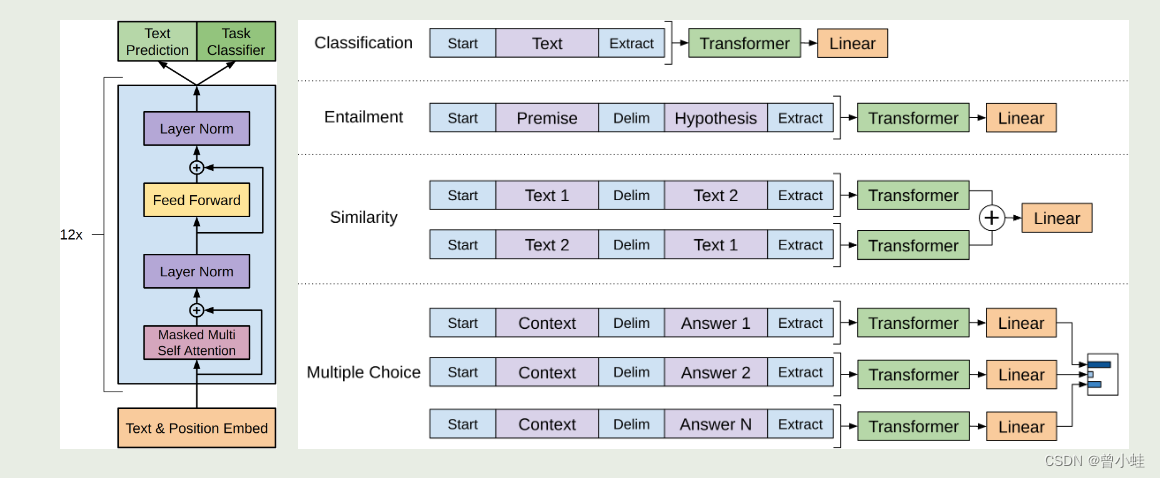

结构上,只用Transformer的编码器预测(预测未来)见下图左侧

损失函数上是与bert不同的

通过在大规模无标签文本语料库上进行生成式预训练,并在每个特定任务上进行判别式微调,可以在多种自然语言理解任务上获得大幅度的提升

结构与应用(预训练后,在有标注文本训练下流任务)

开始符号、结束符号、终止符

下图(左),表示Transformer架构和训练目标。

下图(右),表示 微调不同任务的输入转换示意。将所有结构化输入转换为由我们的预训练模型处理的标记序列,然后是线性+softmax 层。

其中,右侧绿色transformer块表示第一阶段得到的预训练模型

- “Extract” :指从模型的某个部分提取信息或特征的过程。模型会处理文本,提取和学习复杂的特征和模式。这个过程可以被视作是在“抽取”输入文本的语义和句法信息

- Delim”则可能是“Delimiter”的缩写,指的是分隔符。在自然语言处理任务中,分隔符用于区分文本中的不同部分

分隔符可以用来明确哪部分是前提(Premise),哪部分是假设(Hypothesis)。在处理输入数据时,模型会识别这些分隔符,以便正确地解析和处理各部分信息。

二、GPT-2: 语言模型是无监督的多任务学习器

论文:Language Models are Unsupervised Multitast Learner

参数15亿,Bert 1.3亿,参数相差大,但是性能差别不大, 主要创新点是zero-shot:

无监督训练后,不微调下游任务——没有任何参数或架构修改

输入更像自然语言

语言翻译:

(translate to french, english text, french text)

阅读理解

(answer the question, document, question, answer)

三、GPT-3 : 基于gpt-2,细节不明 (无监督训练,不需要参数更新就能学会各种任务)

20.05.Language models are few-shot learners

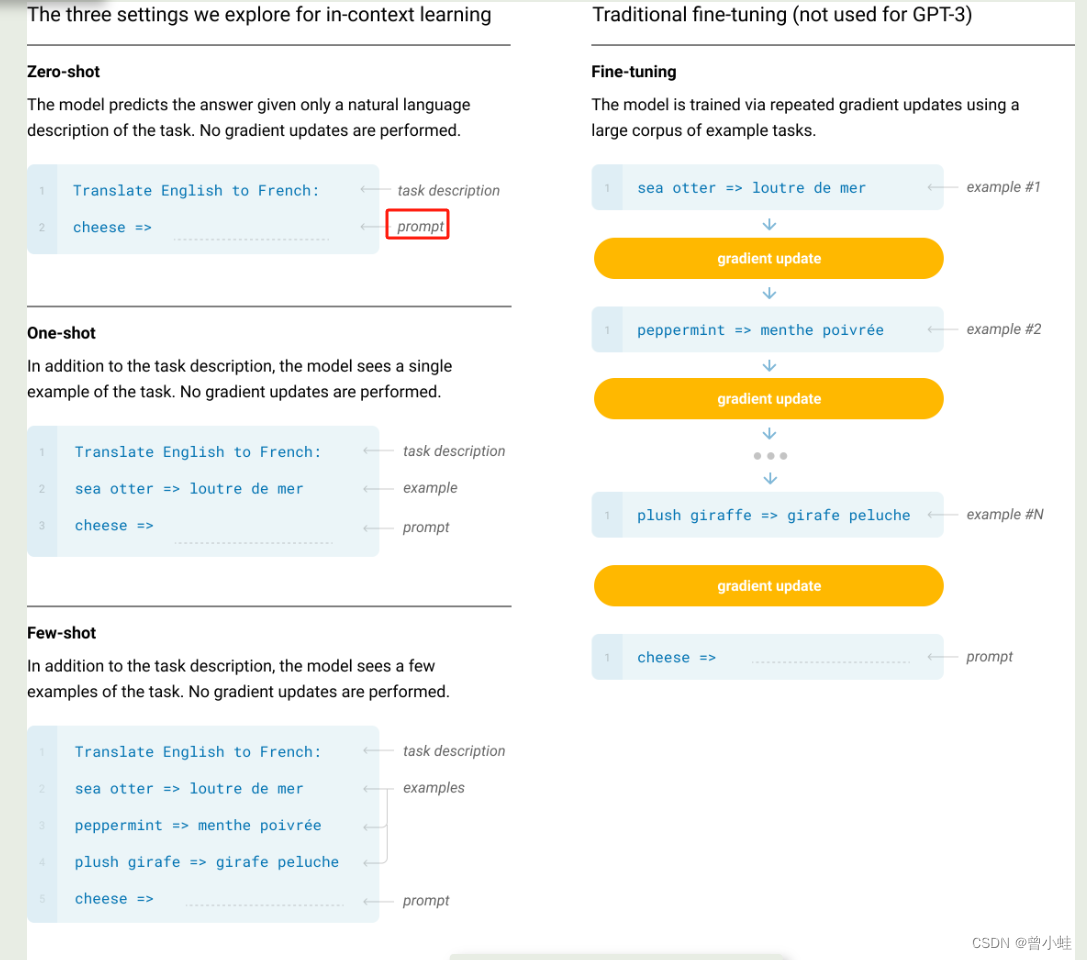

不用再进行模型参数更新,就能直接适应下游任务

零样本、少样本学习的关系

zero-shot:零样本:表示不训练,也不给示例,直接说一句功能(例如翻译英文到中文)

one-shot :一张范例:表示给出一个范例

few-show:给出多个范例

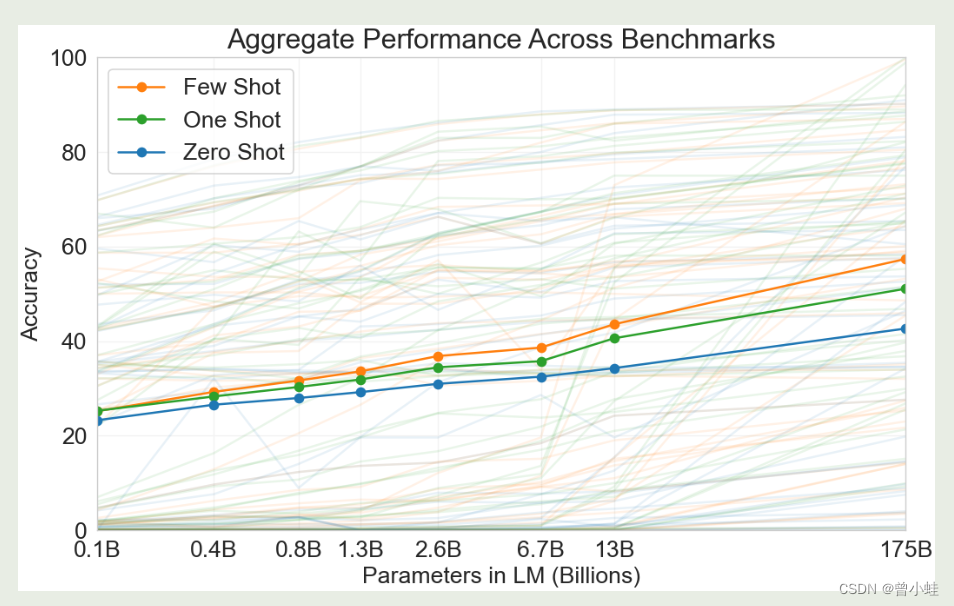

模型大小与少样本学习性能关系:少样本、零样本学习的准确率关系

实验表明:GPT3参数量扩大几百倍后,少量样本(few-shot)的学习,**准确率从20%左右到了50%**多

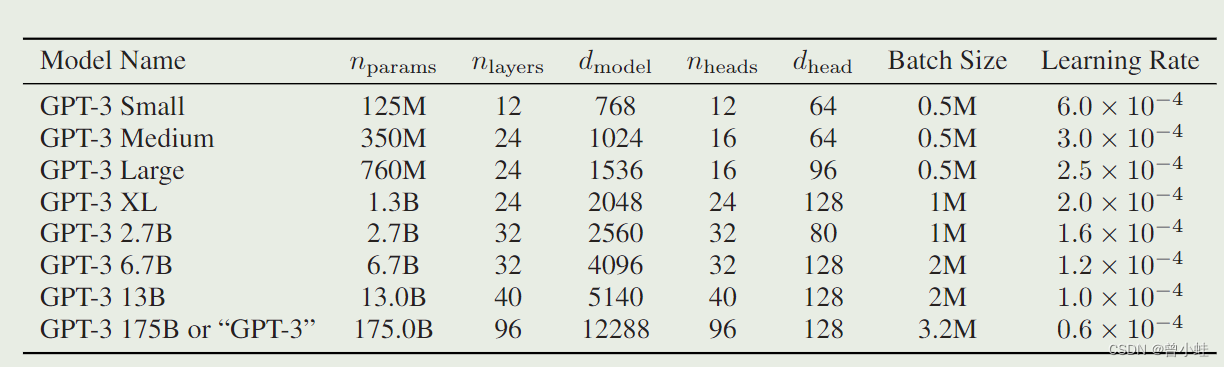

8个不同大小的模型

模型的大小、架构和学习超参数(令牌中的批量大小和学习率)。所有模型都训练了总共 300 亿个令牌。

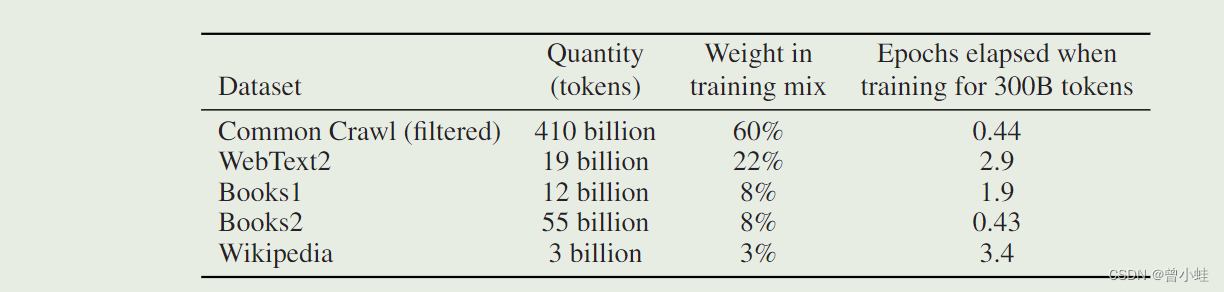

用的数据集

附录

作者信息

GPT-1

GPT-2

GPT-3

这篇关于【无监督+自然语言】GPT,GPT-2,GPT-3 方法概述 (Generative Pre-Traning)的文章就介绍到这儿,希望我们推荐的文章对编程师们有所帮助!