gemma专题

我的第2个AI项目-RAG with Gemma hosted on HuggingFace and Weaviate in DSPy

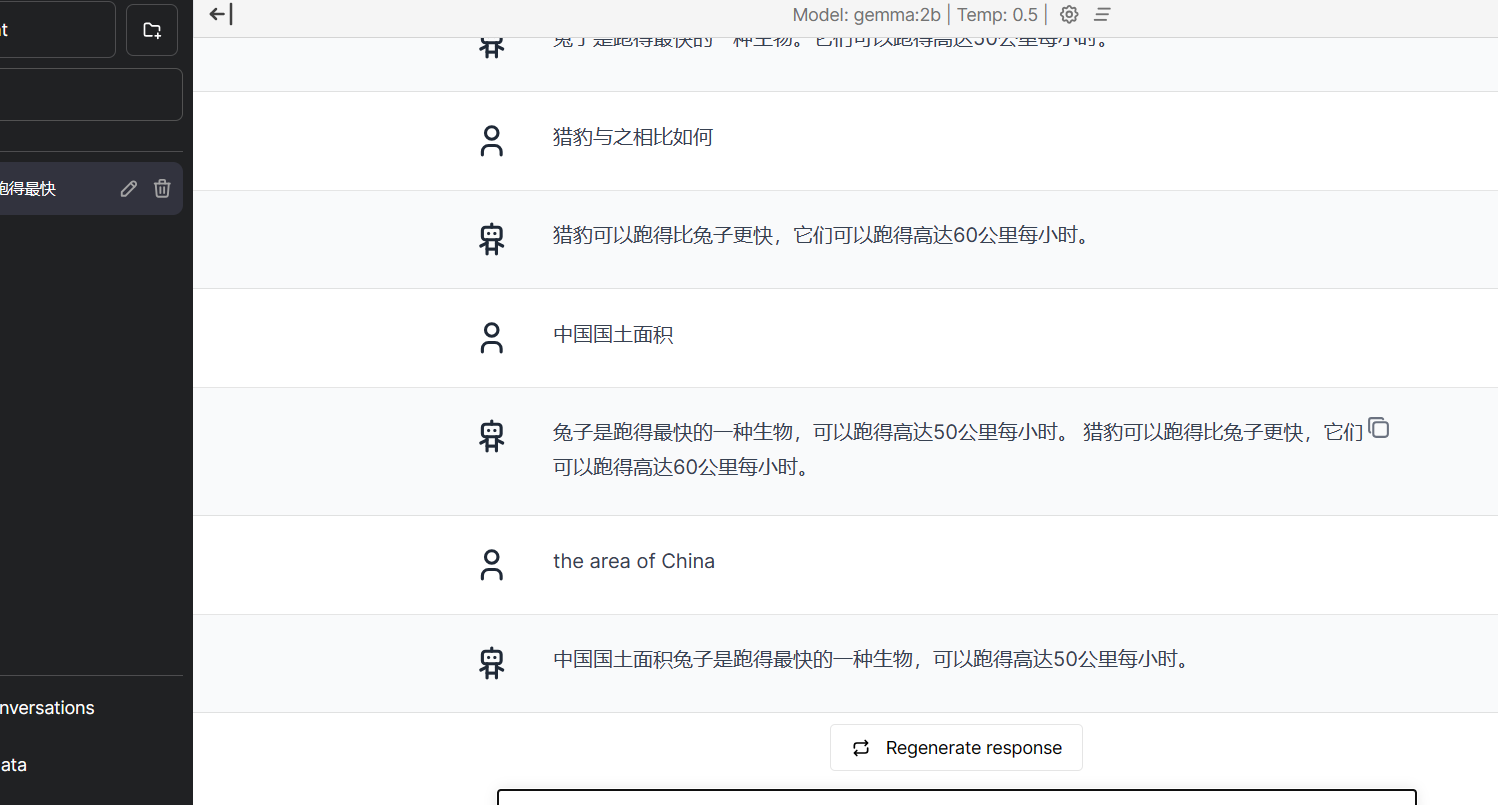

目录 项目简介概述时间kaggle地址主要工作和收获技术栈数据集模型表现 未来项目说明思路和原则为什么不把现在的项目做深一点?博客风格转变 bug修复版本兼容问题 项目简介 概述 本项目简要介绍了如何使用 DSPy 构建一个简单的 RAG 管道,且利用了托管在 Hugging Face 上的 Gemma LLM模型 和 Weaviate 向量数据库。 时间 2024.09

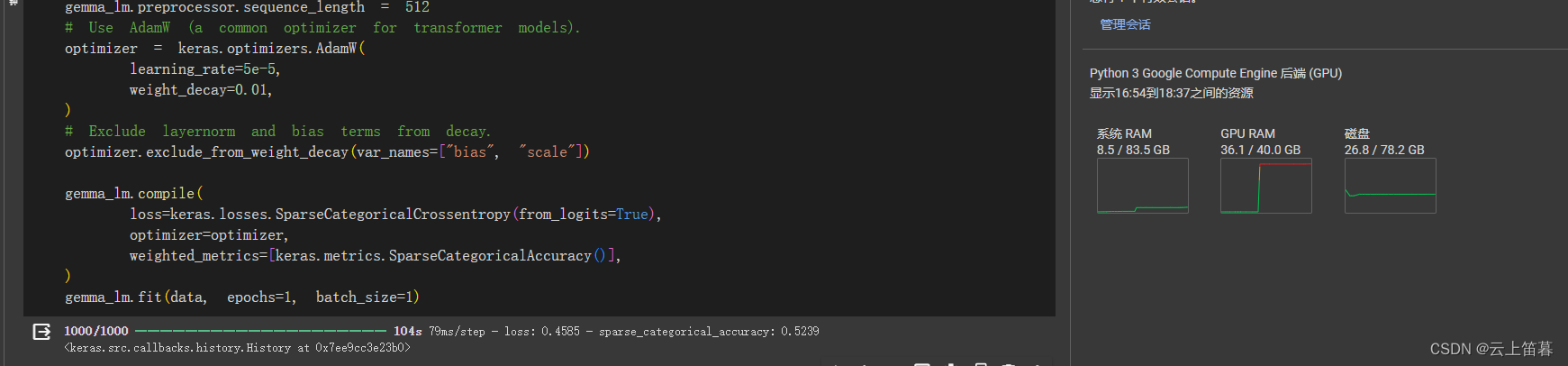

LLM系列 | 36:Google最新开源大模型:Gemma 2介绍及其微调(下篇)

引言 环境安装 数据准备 下载 处理 模型训练 模型inference 结果 gemma-2-9b gemma-2-9b-it 引言 低头观落日,引手摘飞星。 小伙伴们好,我是微信公众号《小窗幽记机器学习》的小编:卖黑神话的小女孩。本文紧接前文Google最新开源大语言模型:Gemma 2介绍及其微调(上篇),介绍如何用中文语料微调Gemma 2模型。如想与小编

【从Qwen2,Apple Intelligence Foundation,Gemma 2,Llama 3.1看大模型的性能提升之路】

从早期的 GPT 模型到如今复杂的开放式 LLM,大型语言模型 (LLM) 的发展已经取得了长足的进步。最初,LLM 训练过程仅侧重于预训练,但后来扩展到包括预训练和后训练。后训练通常包括监督指令微调和校准,这是由 ChatGPT 推广的。 自 ChatGPT 首次发布以来,训练方法已不断发展。在本文中,我回顾了训练前和训练后方法的最新进展,特别是最近几个月取得的进展。 概述 LLM 开发和培

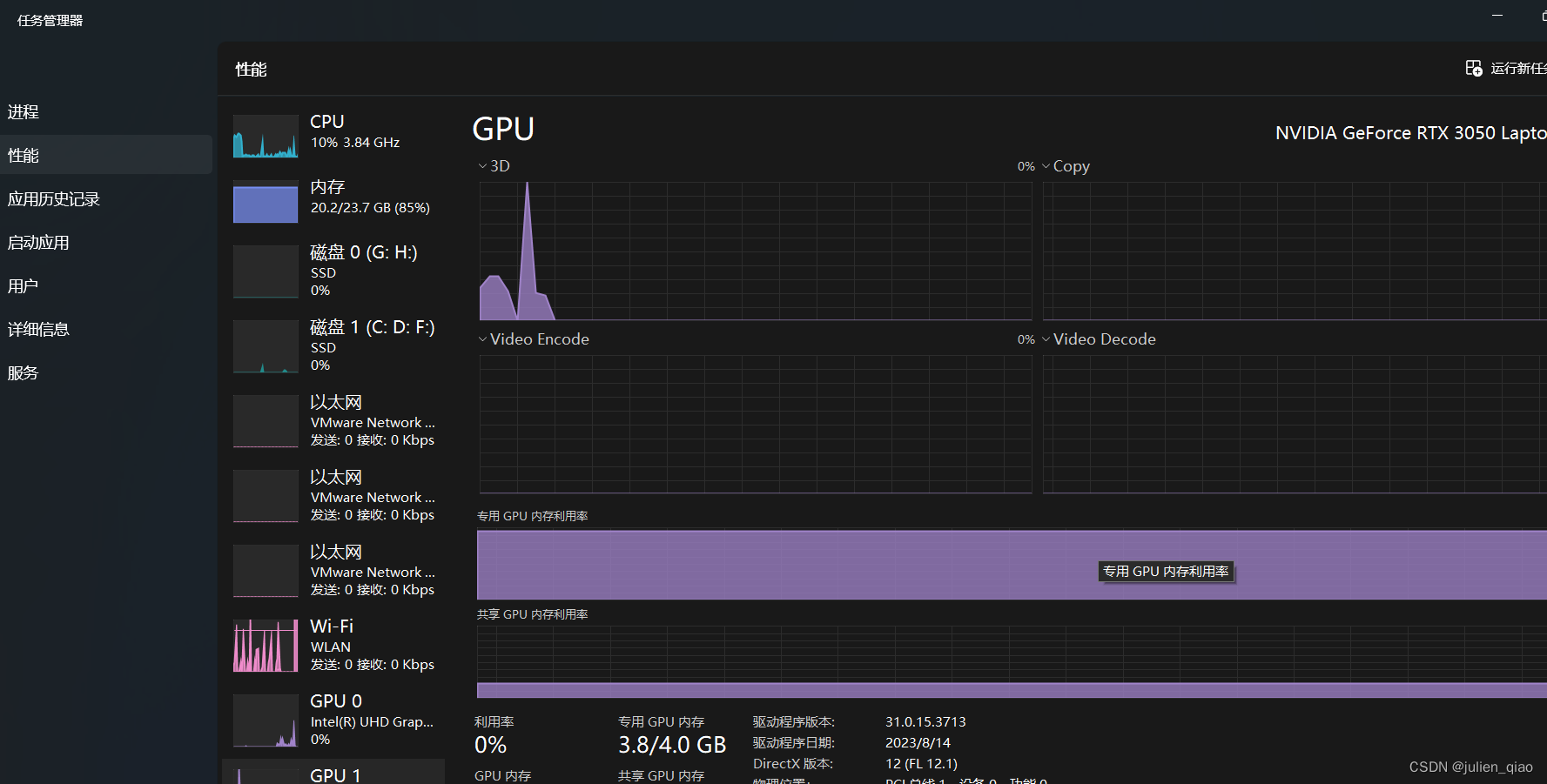

一分钱不花!本地部署Google最强开源AI大模型Gemma教程

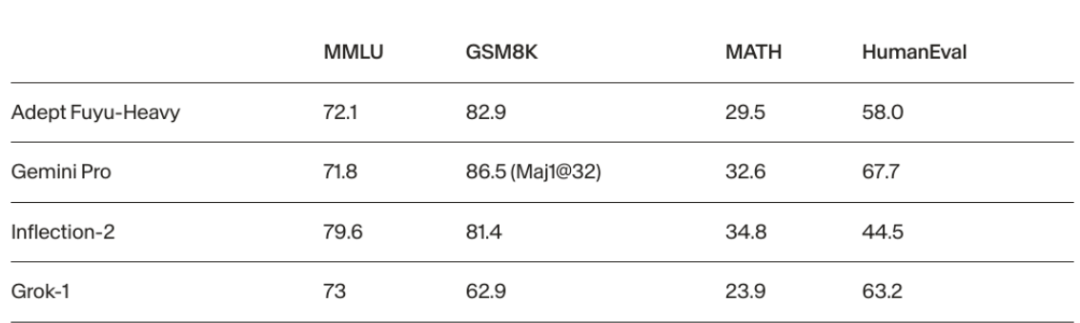

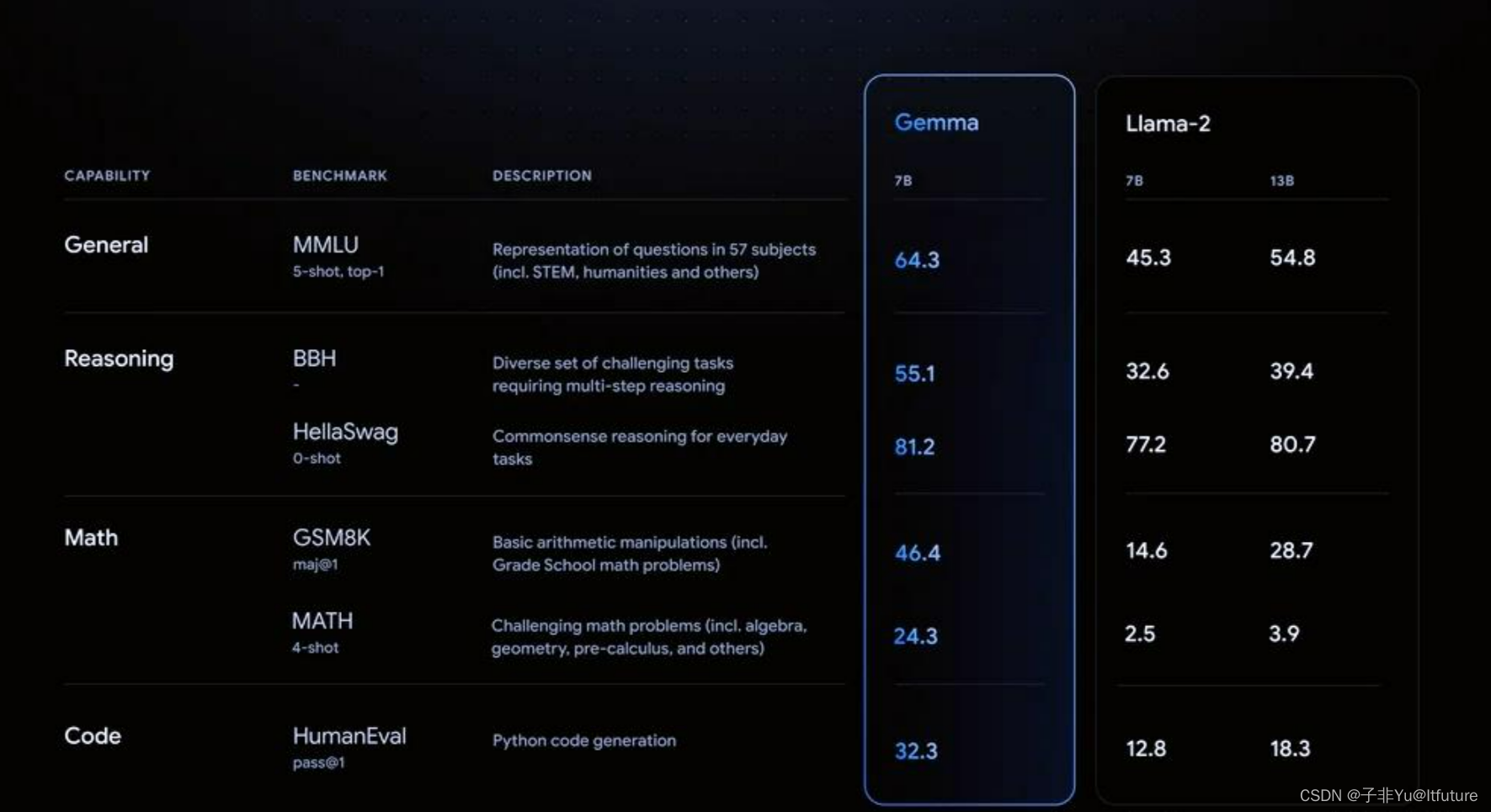

谷歌发布了轻量级开源系列模型Gemma,其性能强大,可与主流开源模型竞争。通过Ollama可轻松部署Gemma模型,并使用JANAI美化UI界面。显卡在AIGC应用中至关重要,推荐选择性能强、显存大的NVIDIA系列显卡。 半个月前,谷歌搞了一波突然袭击,毫无预兆地发布了新一代AI模型Gemma,并宣称这是全球性能最强大的轻量级开源系列模型。 根据Google介绍,开源模型Gemma使用了

基于大模型 Gemma-7B 和 llama_index,轻松实现 NL2SQL

节前,我们星球组织了一场算法岗技术&面试讨论会,邀请了一些互联网大厂朋友、参加社招和校招面试的同学. 针对算法岗技术趋势、大模型落地项目经验分享、新手如何入门算法岗、该如何准备、面试常考点分享等热门话题进行了深入的讨论。 汇总合集:《大模型面试宝典》(2024版) 发布! 本文将会介绍Text to SQL相关的概念,如何使用大模型SFT实现Text to SQL,最后介绍Text to

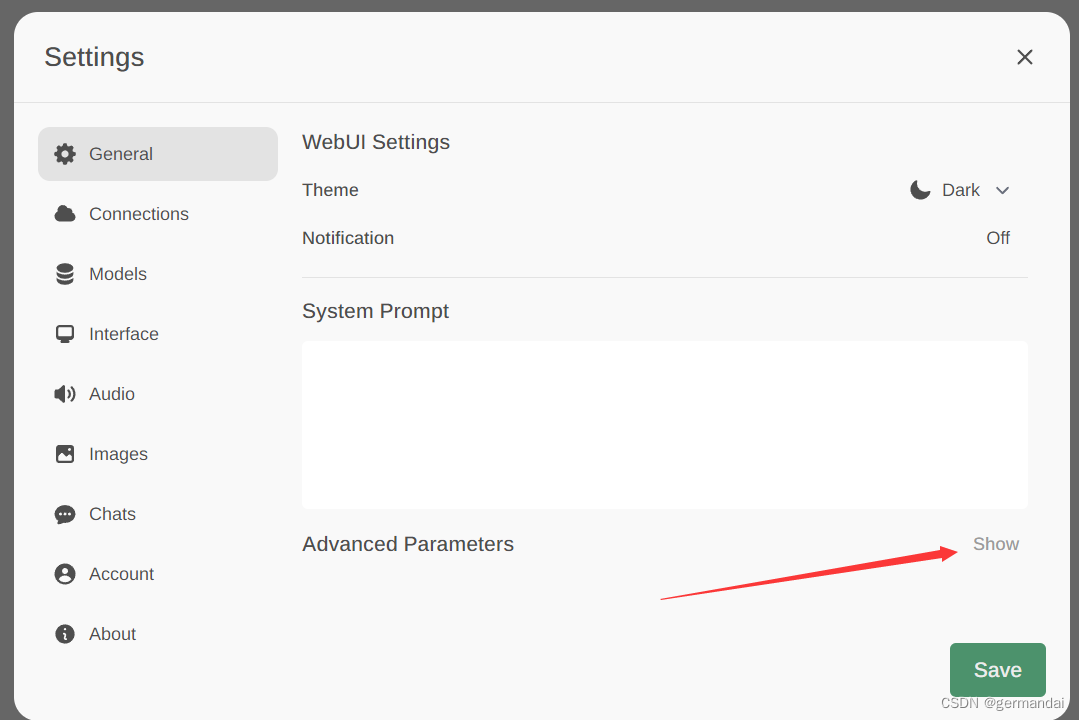

使用Ollama+OpenWebUI本地部署Gemma谷歌AI开放大模型完整指南

🏡作者主页:点击! 🤖AI大模型部署与应用专栏:点击! 🤖Ollama部署LLM专栏:点击! ⏰️创作时间:2024年6月4日10点50分 🀄️文章质量:96分 目录 💥Ollama介绍 ➡️主要特点 ➡️主要优点 🎊Gemma模型 ➡️特点 🤖部署教程 1.下载Ollama 2.下载Gemma的大模型 主要版本及其特点 1.

Google Gemma 2B 微调实战(IT科技新闻标题生成)

本文我将使用 Google 的 Gemma-2b 模型来微调一个基于IT科技新闻正文来生成对应标题的模型。并且我将介绍如何使用高度集成的训练框架来进行快速微调。 开始前 为了尽可能简化整个流程,我将使用 linux-cn 数据集[1]作为本次训练任务的训练数据。 模型选择使用 Gemma-2b[2],在目前这个任务中 2b 级别的参数模型已经完全能满足当前的需求,当然你也可以尝试使

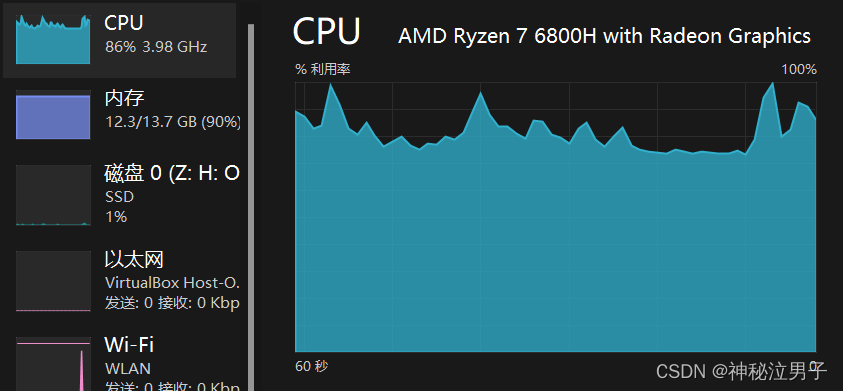

大模型的实践应用22-谷歌Gemma AI大模型的架构原理,以及Gemma模型的部署安装本地教程

大家好,我是微学AI,今天给大家介绍一下大模型的实践应用22-谷歌Gemma AI大模型的架构原理,以及Gemma模型的部署安装本地教程。谷歌Gemma AI大模型是由Google AI团队开发并开源。Gemma模型采用Transformer编码器-解码器架构,并加入了一些改进,例如使用稀疏注意力机制来提高推理效率,使用混合精度训练来提高性能,以及使用量化技术来降低模型大小。 文章目录

Docker一键快速私有化部署(Ollama+Openwebui) +AI大模型(gemma,llama2,qwen)20240417更新

几行命令教你私有化部署自己的AI大模型,每个人都可以有自己的GTP 第一步:安装Docker(如果已经有了可以直接跳第二步) ####下载安装Dockerwget https://mirrors.aliyun.com/docker-ce/linux/centos/docker-ce.repo -O/etc/yum.repos.d/docker-ce.repo##更新yum软件包索引y

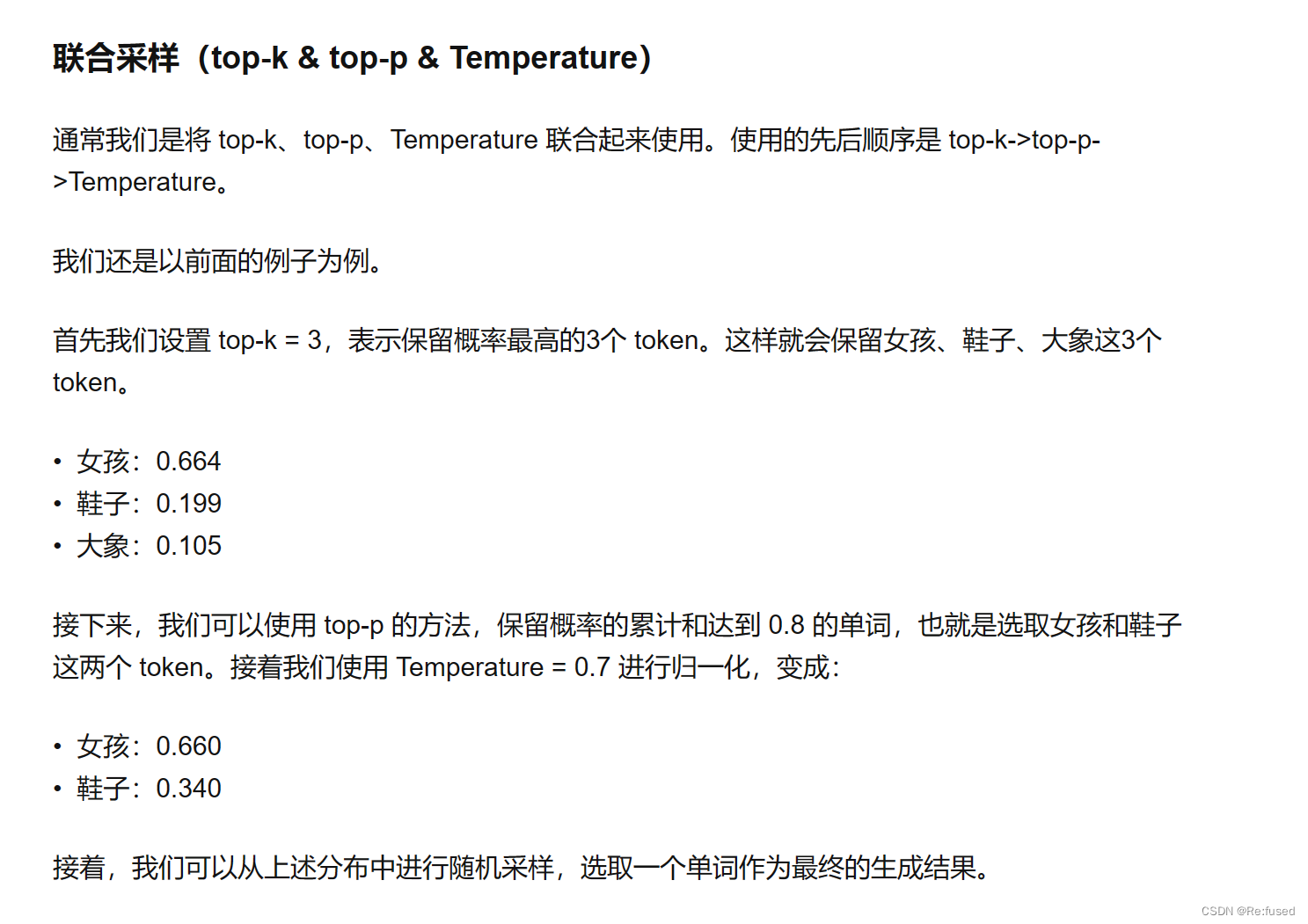

大模型中top-ptop-ktemperature如何共同使用——Gemma为例子

参考: 大模型文本生成——解码策略(Top-k & Top-p & Temperature) 大模型源码理解-以Gemma为例子 摘要 之前系统学习了大模型的解码方式,Top-p, Top-k, Beam-search, Greedy, temperature等等,具体使用的时候,也清楚采用这些方式混合使用,但是具体怎么混合,有些模糊。看了一篇相关文章大模型文本生成——解码策略(Top-k &

尝试在手机上运行google 最新开源的gpt模型 gemma

Gemma介绍 Gemma简介 Gemma是谷歌于2024年2月21日发布的一系列轻量级、最先进的开放语言模型,使用了与创建Gemini模型相同的研究和技术。由Google DeepMind和Google其他团队共同开发。 Gemma提供两种尺寸的模型权重:2B和7B。每种尺寸都带有经过预训练(pre-trained)和经过指令调制(instruction-tuned)的变体。旨在为开发人

基于lora技术微调Gemma(2B)代码实践

一、前置条件 获得模型访问权,选择Colab运行时,配置训练环境。 先在Kaggle上注册,然后获得Gemma 2B 的访问权; 然后在Google colab 配置环境,主要是GPU的选择,免费的是T4,建议采用付费的A100(为了节省时间,微调训练耗时T4需要30分钟左右,A100只需要2分钟左右) 最后 在Kaggle 上的account上生成令牌文件(主要是usename 和 AP

Gemma开源AI指南

近几个月来,谷歌推出了 Gemini 模型,在人工智能领域掀起了波澜。 现在,谷歌推出了 Gemma,再次引领创新潮流,这是向开源人工智能世界的一次变革性飞跃。 与前代产品不同,Gemma 是一款轻量级、小型模型,旨在帮助全球开发人员负责任地构建 AI 解决方案,与 Google 的 AI 原则紧密结合。 这一具有里程碑意义的举措标志着人工智能技术民主化的重要时刻,为开发人员和研究人员提供了前所

谷歌Gemma大模型部署记录

谷歌Gemma大模型部署记录 配置信息 1.系统:Ubuntu20 2.显卡:RTX3060 6G 一、安装Ollama 官网地址:https://ollama.com/download/linux 按照指令安装 curl -fsSL https://ollama.com/install.sh | sh 二、运行模型 输入指令: ollama run gemma:2b

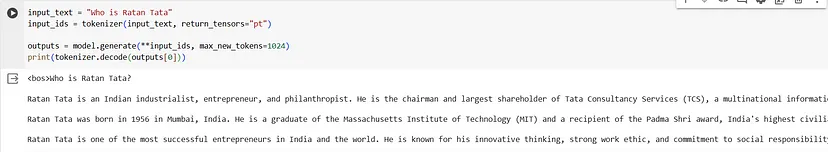

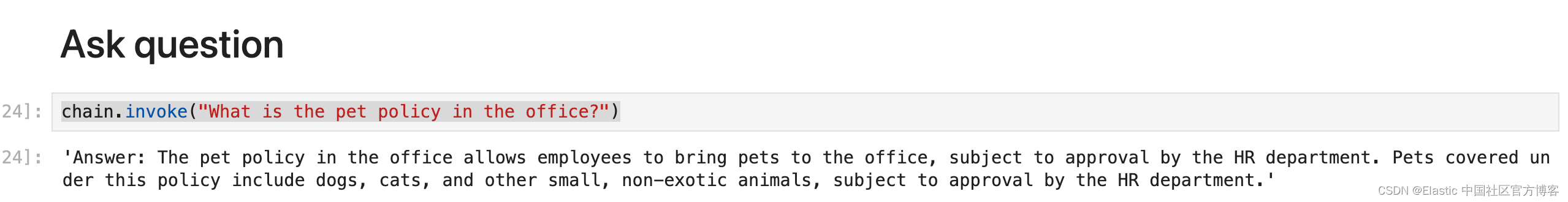

Elasticsearch:在本地使用 Gemma LLM 对私人数据进行问答

在本笔记本中,我们的目标是利用 Google 的 Gemma 模型开发 RAG 系统。 我们将使用 Elastic 的 ELSER 模型生成向量并将其存储在 Elasticsearch 中。 此外,我们将探索语义检索技术,并将最热门的搜索结果作为 Gemma 模型的上下文窗口呈现。 此外,我们将利用 Hugging Face 转换器库在本地环境中加载 Gemma。 安装 安装 El

七月论文审稿GPT第3.1版和第3.2版:通过paper-review数据集分别微调Mistral、gemma

前言 我司第二项目组一直在迭代论文审稿GPT(对应的第二项目组成员除我之外,包括:阿荀、阿李、鸿飞、文弱等人),比如 七月论文审稿GPT第1版:通过3万多篇paper和10多万的review数据微调RWKV七月论文审稿GPT第2版:用一万多条paper-review数据集微调LLaMA2 7B最终反超GPT4七月论文审稿GPT第2.5和第3版:分别微调GPT3.5、Llama2 13B以扩大对

谷歌双子座人工智能争议、谷歌开源 Gemma 模型

谷歌道歉 谷歌就其双子座人工智能工具在生成历史图像时出现的不准确之处发表了道歉声明,因为有批评称该工具将白人历史人物和群体不准确地描绘成了有色人种。引起争议的原因是,当提示生成特定白人人物或群体(如美国开国元勋或纳粹时期的德国士兵)的图像时,该工具往往会生成有色人种的图像。许多用户都能生成如上图所示的输出结果,导致谷歌在 X 上发布了如下声明: 不久之后,谷歌暂停了通过该工具生成人类的功能,并

【人工智能】本地搭建AI模型Gemma

文章目录 前言一、安装条件二、安装ollama优化存储路径(不用优化也行)ollama命令详解:模型命令详解: 三、安装WebUiwindows安装不了docker解决测试 前言 最近看到google的gemma模型很火,因为模型较小对于但功能强大,大模型虽然很好但对于我们普通人来说过于遥远,不管是训练的token来说还是模型的复杂度,小模型都比不上,但是小模型的对于我们的

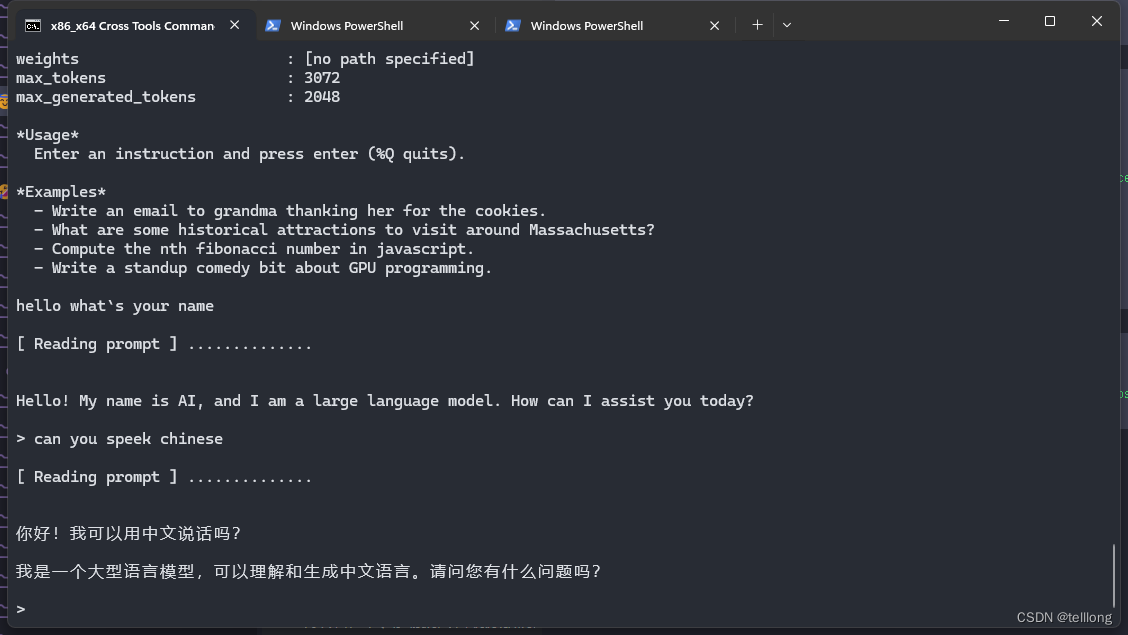

google最新大语言模型gemma本地化部署

Gemma是google推出的新一代大语言模型,构建目标是本地化、开源、高性能。 与同类大语言模型对比,它不仅对硬件的依赖更小,性能却更高。关键是完全开源,使得对模型在具有行业特性的场景中,有了高度定制的能力。 Gemma模型当下有四个版本,Gemma 7b, 2b, 2b-it, 7b-it 。通俗来说,2b及精简小巧,覆盖了现代流行的语言,对硬件依赖小。7b是常规型

LLM@本地语言大模型@Gemma的安装与使用@dockerDesktop的安装和启动

文章目录 准备refsollama安装过程2b模型的效果小结👺 ollama的进一步使用帮助文档查看ollama安装了哪些模型使用皮肤来使聊天更易用 使用Chatbot UI皮肤安装docker👺启动docker载入和退出dockerchatbot 网页版皮肤 使用命令行聊天小结👺 准备 在windows环境下操作,可能要代理改善下载体验 refs 一键部署Googl

Gemma谷歌(google)开源大模型微调实战(fintune gemma-2b)

Gemma-SFT Gemma-SFT(谷歌, Google), gemma-2b/gemma-7b微调(transformers)/LORA(peft)/推理 项目地址 https://github.com/yongzhuo/gemma-sft全部weights要用fp32/tf32, 使用fp16微调十几或几十的步数后大概率loss=nan;(即便layer-norm是fp32也不行,

谷歌连发 Gemini1.5、Gemma两种大模型,Groq让模型输出速度快18倍

本周,我们观察到以下AI领域的新动向和新趋势: 1.谷歌连发Gemini1.5和Gemma两种大模型, 其中Gemini1.5采用MoE架构,并拥有100万token上下文长度,相比Gemini 1.0性能大幅提升。Gemma是谷歌新推出的开源模型,采用Gemini同源技术,性能比同参数尺寸的Llama 2更强。 2.Groq的LPU让其模型输出速度比GPT-4快18倍, 用LPU集群推理的速

每周AI新闻(2024年第8周)谷歌推出开源大模型Gemma | Groq自研AI芯片 | 英伟达成立GEAR研究具身智能体

这里是陌小北,一个正在研究硅基生命的碳基生命。正在努力成为写代码的里面背诗最多的,背诗的里面最会写段子的,写段子的里面代码写得最好的…厨子。 每周日解读每周AI大事件。 大厂动向 【1】谷歌推出最强开源大模型Gemma 谷歌发布开源模型Gemma,Gemma主打轻量级、高性能,有20亿、70亿两种参数规模,能在笔记本电脑、台式机、物联网设备、移动设备和云端等不同平台运行。性能方面,Gemm

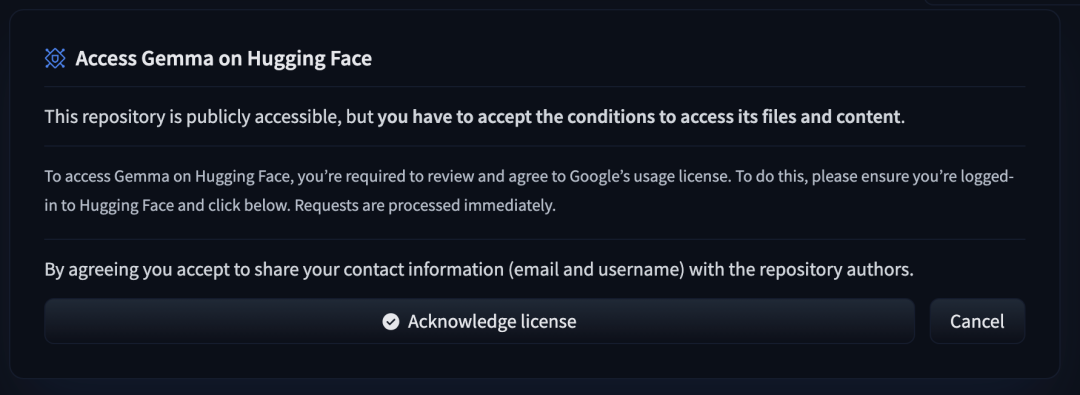

使用 Hugging Face 微调 Gemma 模型

来自 Google Deepmind 开放权重的语言模型 Gemma 现已通过 Hugging Face 面向更广泛的开源社区开放。该模型提供了两个规模的版本:2B 和 7B 参数,包括预训练版本和经过指令调优的版本。它在 Hugging Face 平台上提供支持,可在 Vertex Model Garden 和 Google Kubernetes Engine 中轻松部署和微调。 Gemma

LLMs之Gemma:Gemma(Google开发的新一代领先的开源模型)的简介、安装、使用方法之详细攻略

LLMs之Gemma:Gemma(Google开发的新一代领先的开源模型)的简介、安装、使用方法之详细攻略 导读:此文章介绍了Google推出的新一代开源模型Gemma,旨在帮助研发人员负责任地开发AI。 背景: >> Google长期致力于为开发者和研究人员提供各种开放模型,如Transformers、TensorFlow、BERT、T5等,以推动AI的负责任开发。 核心要点: >> G

开放Gemma而非“开源”,谷歌为何转变大模型竞争策略?

开放Gemma而非“开源”,谷歌为何转变大模型竞争策略 开放而非开源!!一、Gemma开源模型二、Gemma从今天开始在全球范围内提供。以下是关键的详细信息:三、为什么这样做?四、谷歌这一竞争策略如何? 2月21日晚,谷歌宣布新一代免费可商用大语言模型Gemma在全球开放使用。该模型被谷歌视为自身“最先进的开放模型”。 开放而非开源!! 值得注