本文主要是介绍使用Ollama+OpenWebUI本地部署Gemma谷歌AI开放大模型完整指南,希望对大家解决编程问题提供一定的参考价值,需要的开发者们随着小编来一起学习吧!

🏡作者主页:点击!

🤖AI大模型部署与应用专栏:点击!

🤖Ollama部署LLM专栏:点击!

⏰️创作时间:2024年6月4日10点50分

🀄️文章质量:96分

目录

💥Ollama介绍

➡️主要特点

➡️主要优点

🎊Gemma模型

➡️特点

🤖部署教程

1.下载Ollama

2.下载Gemma的大模型

主要版本及其特点

1. Gemma Latest

2. Gemma 7B

3. Gemma 2B

4. Gemma Instruct

5. Gemma Text

6. Gemma v1.1

🎁第一种下载方式

🎁第二种方式下载

🎁注意事项

💥Ollama介绍

Ollama是一个开源框架,专为在本地机器上便捷部署和运行大型语言模型(LLM)而设计。它提供了一套简单的工具和命令,使任何人都可以轻松地启动和使用各种流行的LLM,例如GPT-3、Megatron-Turing NLG和WuDao 2.0。

➡️主要特点

简化部署: Ollama 使用 Docker 容器技术来简化大型语言模型的部署和管理。用户只需简单的命令即可启动和停止模型,而无需担心底层的复杂性。

丰富的模型库: Ollama 提供了丰富的预训练模型库,涵盖了各种自然语言处理任务,如文本生成、翻译、问答等。用户可以轻松地选择和使用所需的模型。

跨平台支持: Ollama 支持多种操作系统,包括 Windows、macOS 和 Linux,使其能够满足不同用户的需求。

灵活的自定义: Ollama 提供了灵活的自定义选项,允许用户根据自己的需求调整模型的行为。

➡️主要优点

离线使用: Ollama 可以让用户在离线环境下使用LLM,这对于隐私敏感或网络连接不稳定的情况非常有用。

降低成本: Ollama 可以帮助用户降低使用LLM的成本,因为它避免了云服务的高昂费用。

提高安全性: Ollama 可以提高LLM使用的安全性,因为它允许用户完全控制自己的数据和模型。

应用场景

研究和教育: Ollama 可以用于自然语言处理、机器翻译、人工智能等领域的教学和研究。

开发和测试: Ollama 可以用于开发和测试新的自然语言处理应用程序。

个人使用: Ollama 可以用于个人创作、娱乐等目的

示例模型

以下只是部分模型:

| Model | Parameters | Size | Download |

|---|---|---|---|

| Llama 3 | 8B | 4.7GB | ollama run llama3 |

| Llama 3 | 70B | 40GB | ollama run llama3:70b |

| Phi 3 Mini | 3.8B | 2.3GB | ollama run phi3 |

| Phi 3 Medium | 14B | 7.9GB | ollama run phi3:medium |

| Gemma | 2B | 1.4GB | ollama run gemma:2b |

| Gemma | 7B | 4.8GB | ollama run gemma:7b |

| Mistral | 7B | 4.1GB | ollama run mistral |

| Moondream 2 | 1.4B | 829MB | ollama run moondream |

| Neural Chat | 7B | 4.1GB | ollama run neural-chat |

| Starling | 7B | 4.1GB | ollama run starling-lm |

| Code Llama | 7B | 3.8GB | ollama run codellama |

| Llama 2 Uncensored | 7B | 3.8GB | ollama run llama2-uncensored |

| LLaVA | 7B | 4.5GB | ollama run llava |

| Solar | 10.7B | 6.1GB | ollama run solar |

🎊Gemma模型

谷歌的Gemma AI模型是一个多版本的开放式人工智能系统,旨在处理各种复杂的任务,如自然语言处理、计算机视觉、生成模型等。Gemma AI模型在不同版本之间具有不同的功能和性能,以满足不同的需求和计算资源。

➡️特点

高性能:Gemma在多个基准测试中展现出优秀的性能,能够生成高质量的自然语言内容。

多任务学习:Gemma通过在多个任务上进行联合训练,学习到了通用的语言理解和生成能力。

安全可靠:Gemma被设计具有较高的安全性,可以避免产生有害或不恰当的输出。

可解释性:Gemma模型的内部工作机制相对更加透明,便于理解和分析。

开放获取:Gemma模型的一些版本已经对外开放,研究人员和开发者可以获取使用。

🤖部署教程

1.下载Ollama

官网地址:点击跳转!

下一步默认下载即可过程十分简单就不演示了

2.下载Gemma的大模型

点击官网的右上角Models

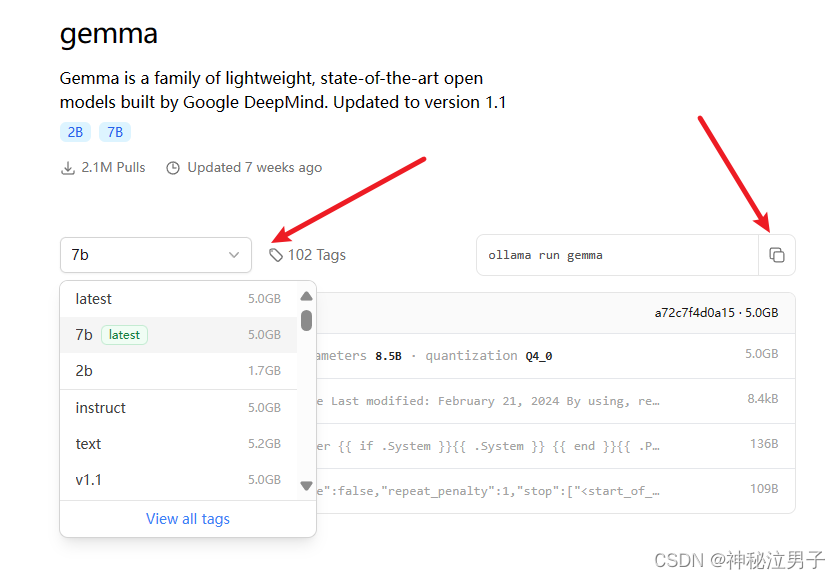

选择对应的模型根你的电脑|服务器性能来选择,这里我选择7b的模型来测试

主要版本及其特点

1. Gemma Latest

- 描述:最新版本的Gemma AI模型,包含最新的优化和改进。

- 性能:通常是所有版本中性能最强的,能够处理最复杂的任务。

- 应用场景:适用于需要高精度和高效率的任务,如实时语言翻译、复杂的对话系统、详细的文本分析等。

- 硬件要求:

- CPU:多核高性能处理器(如Intel Xeon或AMD EPYC)

- 内存:64GB RAM或更多

- 存储:至少1TB的可用存储空间

- GPU:顶级显卡

2. Gemma 7B

- 描述:参数量为70亿的模型版本,平衡了性能和计算资源需求。

- 性能:适合中等规模的任务,能够提供高质量的输出,但对计算资源的要求较低。

- 应用场景:用于中等复杂度的任务,如高级文本生成、图像识别和中等规模的数据处理。

- 硬件要求:

- CPU:八核处理器(如Intel i7或AMD Ryzen 7)

- 内存:16GB RAM

- 存储:至少200GB的可用存储空间

- GPU:中高端显卡

3. Gemma 2B

- 描述:参数量为20亿的模型版本,适用于基础的AI任务。

- 性能:可以高效地处理基础任务,资源消耗较少。

- 应用场景:适用于简单的文本生成、基础数据分析和基本对话系统。

- 硬件要求:

- CPU:四核处理器(如Intel i5或AMD Ryzen 5)

- 内存:8GB RAM

- 存储:至少100GB的可用存储空间

- GPU:入门级显卡

4. Gemma Instruct

- 描述:专门优化用于指令跟随任务的模型版本。

- 性能:在任务指令执行和精确回答问题方面表现优异。

- 应用场景:用于构建高效的对话系统、问答系统和智能助理。

- 硬件要求:

- CPU:六核处理器(如Intel i7或AMD Ryzen 5)

- 内存:16GB RAM

- 存储:至少150GB的可用存储空间

- GPU:中端显卡(如NVIDIA RTX 3060)

5. Gemma Text

- 描述:专注于文本生成和自然语言处理任务的模型版本。

- 性能:在生成高质量文本和处理语言任务方面表现卓越。

- 应用场景:用于自动写作、内容生成、文本摘要和语言翻译。

- 硬件要求:

- CPU:六核处理器(如Intel i7或AMD Ryzen 5)

- 内存:16GB RAM

- 存储:至少150GB的可用存储空间

- GPU:中端显卡

6. Gemma v1.1

- 描述:Gemma模型的第一个主要版本更新,包含显著改进和优化。

- 性能:相比初始版本具有更好的性能和更高的效率。

- 应用场景:广泛应用于各类任务,包括文本生成、数据分析和对话系统。

- 硬件要求:

- CPU:八核处理器(如Intel i7或AMD Ryzen 7)

- 内存:16GB RAM

- 存储:至少200GB的可用存储空间

- GPU:中高端显卡

以上只作为参考建议,具体根据官网查

这里我选择7b的模型来测试

有两种下载方式你可以通过

🎁第一种下载方式

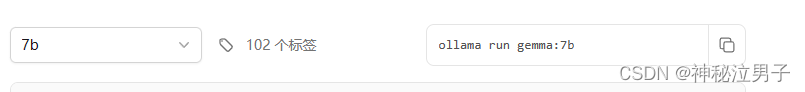

命令行(打开cmd)输入官网复制的命令

在命令行输入 以下命令 等待时长即可下载完成

ollama run gemma:7b🎁第二种方式下载

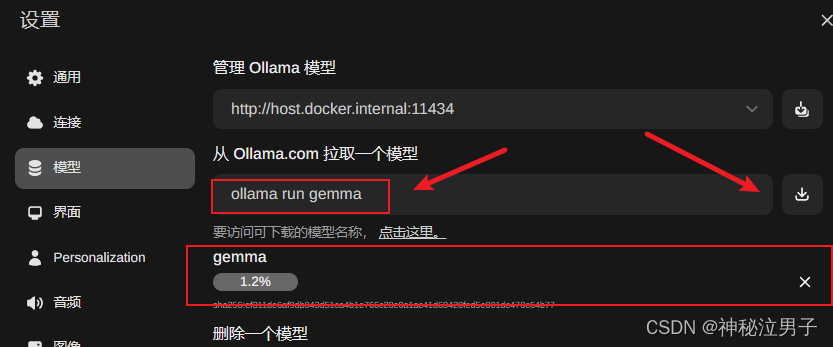

基于OpenWebUI下载

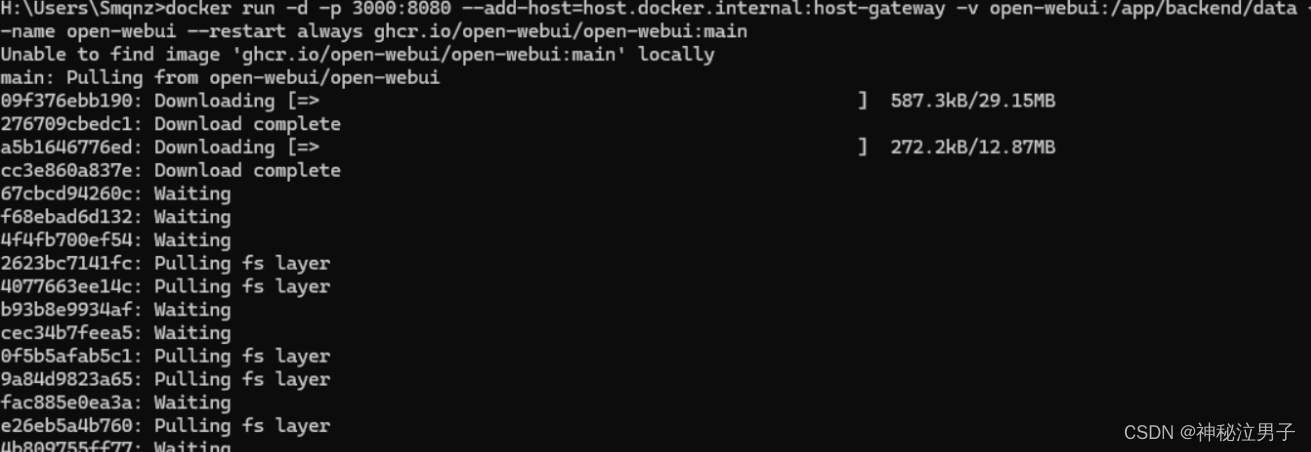

首先需要安装Docker容器(自行了解安装,去官网下载步骤也是十分的简单)

复制这条命令( Ollama 在您的计算机上使用以下命令)

不同的条件下,有不同的命令,详细见开源地址所述

官网地址:点击跳转!

docker run -d -p 3000:8080 --add-host=host.docker.internal:host-gateway -v open-webui:/app/backend/data --name open-webui --restart always ghcr.io/open-webui/open-webui:main

等待完成即可

安装完成之后访问本地的3000端口

也可以点击自己的Docker,点击访问即可

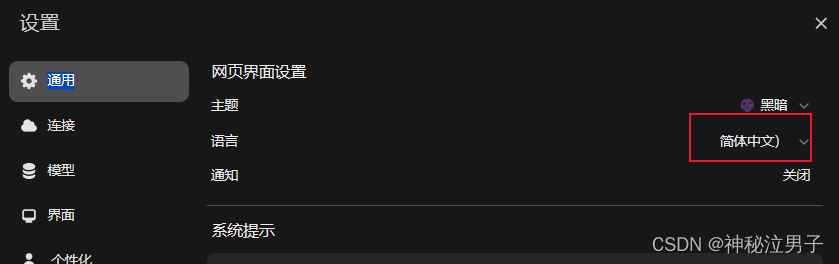

先点击左下角的设置改为中文简体(方便观看)

点击模型这边下载Gemma 复制官网的运行地址也就是命令输入的命令

此刻只需等待完成即可

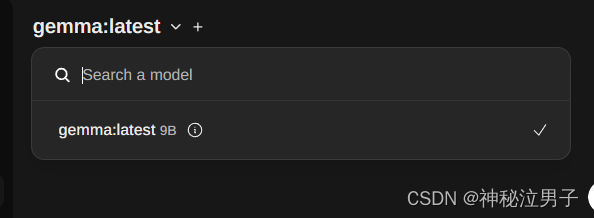

下载完成之后上边会显示(你所下载的大模型)

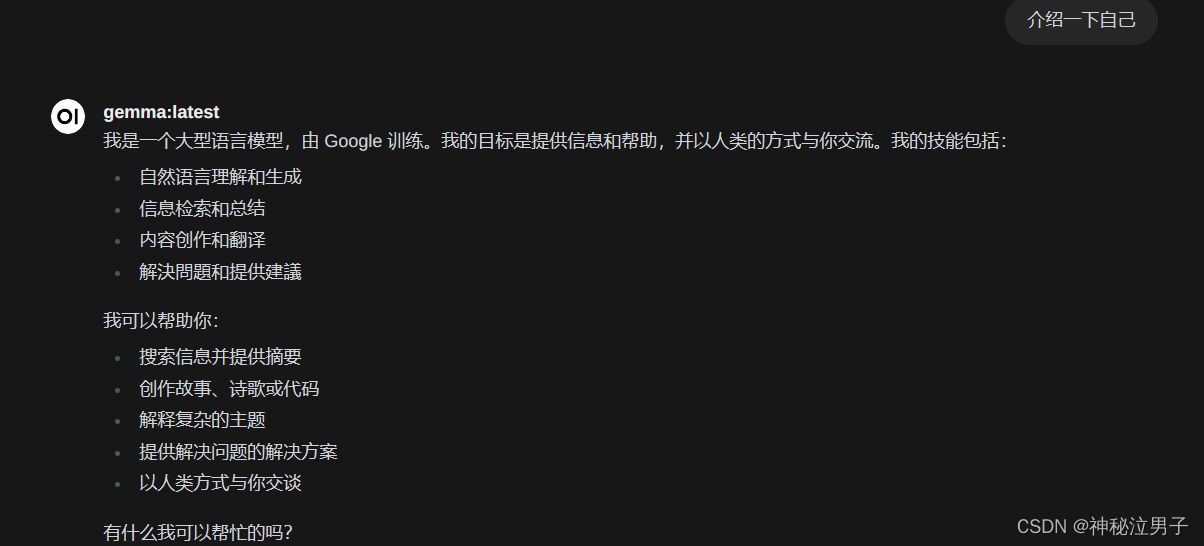

简单的提问

电脑性能越高回答的速度就越快

问题:谈谈你对于AI大爆发的看法

回答

工智能大爆发的看法:人工智能(AI)大爆发将对人类社会产生深远的影响,并带来各种机遇和挑战。积极影响:**提高生产力:**AI工具可以自动化许多任务,提高工作效率和生产力。**提高生活水平:**AI技术可以提供个性化医疗保健、交通和购物体验。**解决重大问题:**AI可以帮助解决全球性挑战,例如气候变化和疾病。**创造新就业机会:**AI技术将创造新的就业机会,以支持新技术和创新。负面影响:**就业损失:**AI工具可能会导致某些工作被自动化,并导致就业损失。**社会影响:**AI技术可能会导致社会分化和个人数据隐私问题。**伦理问题:**AI工具的应用引入了伦理问题,例如 bias 和可持续性。**人类社会:**AI技术可能会对人类社会产生深远的影响,并改变人类与机器的互动方式。可能性:**混合工作模式:**AI技术可以与人类工作相辅相成,以提高效率和生产力。**个人定制:**AI技术可以提供个性化产品和服务,以满足个人的需求和喜好。**社会协作:**AI技术可以帮助人类解决复杂的问题,并改善人类生活。结论:AI大爆发将对人类社会产生深远的影响,既有积极的影响也有负面影响。重要的是要负责任地应用 AI 技术,以最大限度地提高其益处,同时缓解潜在的风险。可以看出回答的也是十分的全面详细,并且做出相应的总结

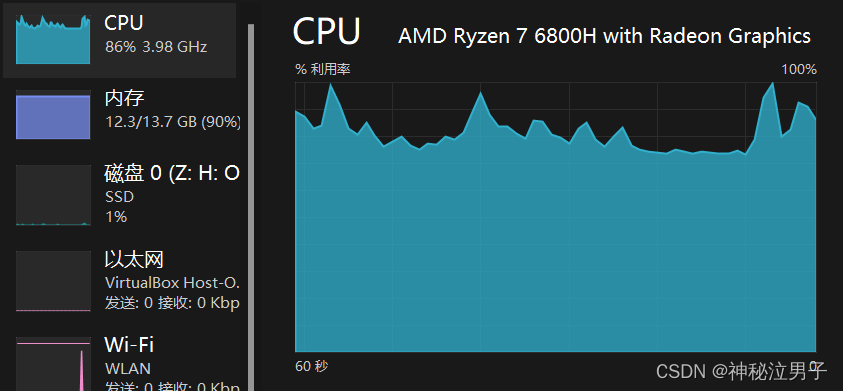

但是在回答问题的过程中会占用你的CPU和内存

🎁注意事项

根据电脑性能,来下载对应的大模型

如果是服务器的话,可根据开源地址所说明下载

这篇关于使用Ollama+OpenWebUI本地部署Gemma谷歌AI开放大模型完整指南的文章就介绍到这儿,希望我们推荐的文章对编程师们有所帮助!