encoders专题

论文研读:Transformers Make Strong Encoders for Medical Image Segmentation

论文:TransUNet:Transformers Make Strong Encoders for Medical Image Segmentation 目录 Abstract Introduction Related Works 各种研究试图将自注意机制集成到CNN中。 Transformer Method Transformer as Encoder 图像序列化 Pat

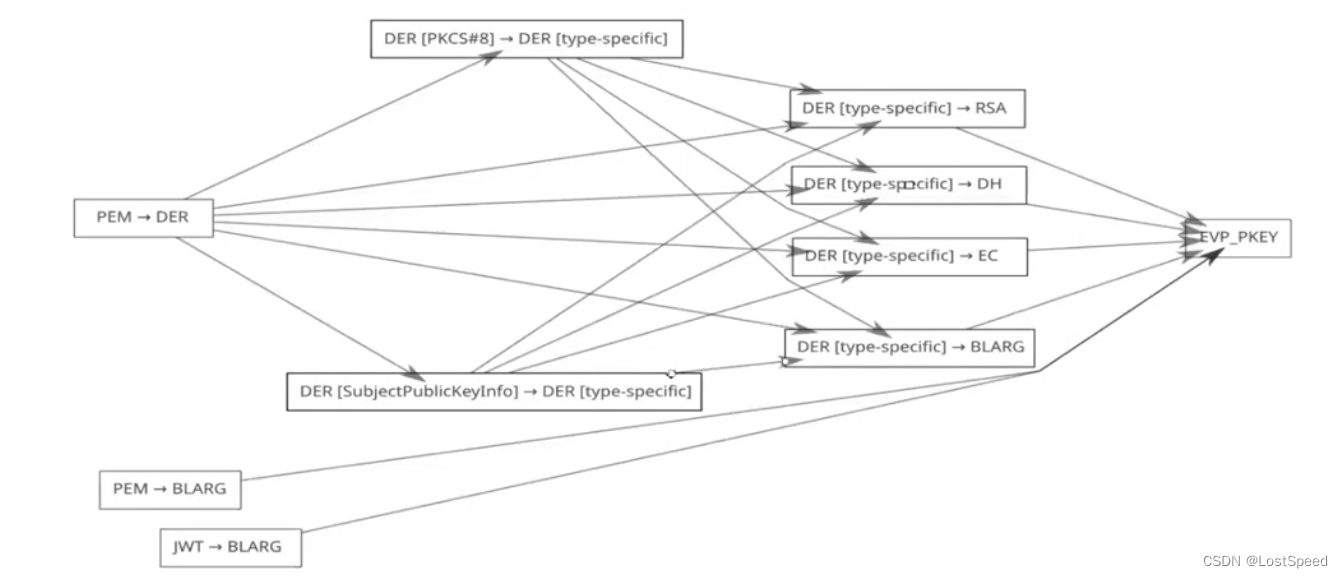

openssl3.2 - note - Decoders and Encoders with OpenSSL

文章目录 openssl3.2 - note - Decoders and Encoders with OpenSSL概述笔记编码器/解码器的调用链OSSL_STORE 编码器/解码器的名称和属性OSSL_FUNC_decoder_freectx_fnOSSL_FUNC_encoder_encode_fn官方文档END openssl3.2 - note - Decoders a

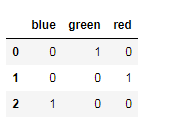

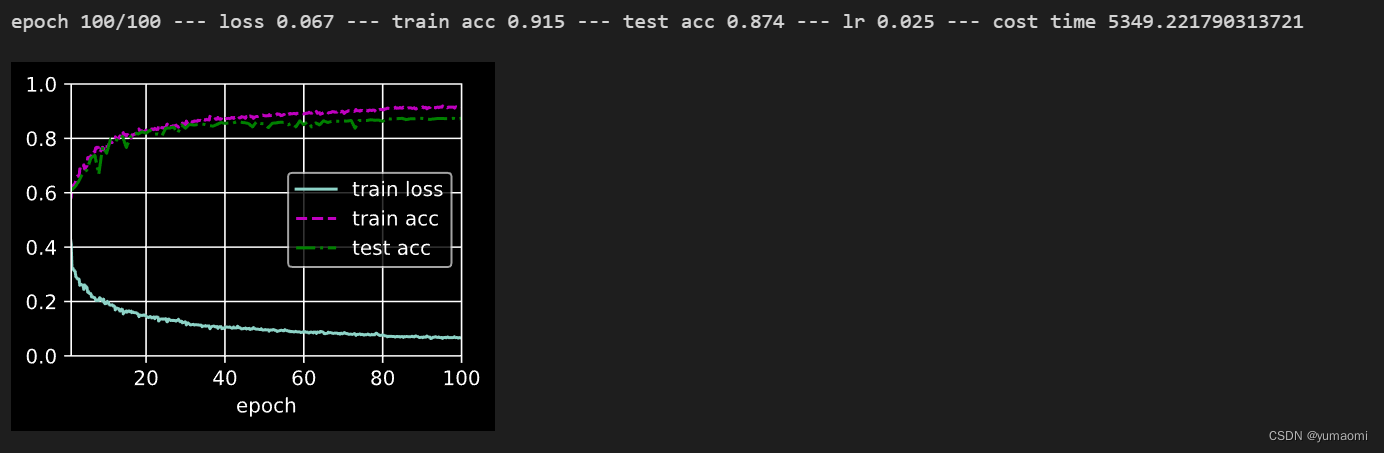

sklearn:机器学习 分类特征编码category_encoders

文章目录 category_encoders简介OrdinalEncoder 序列编码OneHotEncoder 独热编码TargetEncoder 目标编码Binary Encoder 二进制编码BaseNEncoder 贝叶斯编码LeaveOneOutEncoder 留一法HashingEncoder 哈希编码CatBoostEncoder catboost目标编码CountEncode

第10章: 明星级轻量级高效Transformer模型ELECTRA: 采用Generator-Discriminator的Text Encoders解析及ELECTRA模型源码完整实现

1,GAN:Generative Model和Discriminative Model架构解析 2,为什么说ELECTRA是NLP领域轻量级训练模型明星级别的Model? 3,使用replaced token detection机制规避BERT中的MLM的众多问题解析 4,以Generator-Discriminator实现的ELECTRA预训练架构解析 5,ELECTRTA和GAN的在数

sklearn中多种编码方式——category_encoders(one-hot多种用法)

文章目录 1 Ordinal Encoding 序数编码2 One-hot Encoding 独热编码3 Target Encoding 目标编码4 BinaryEncoder 编码5 CatBoostEncoder编码6 WOEEncoder编码9 效果对比与使用心得额外:10 用pandas的get_dummies进行one-hot额外:11 文本one_hot的方式 离散

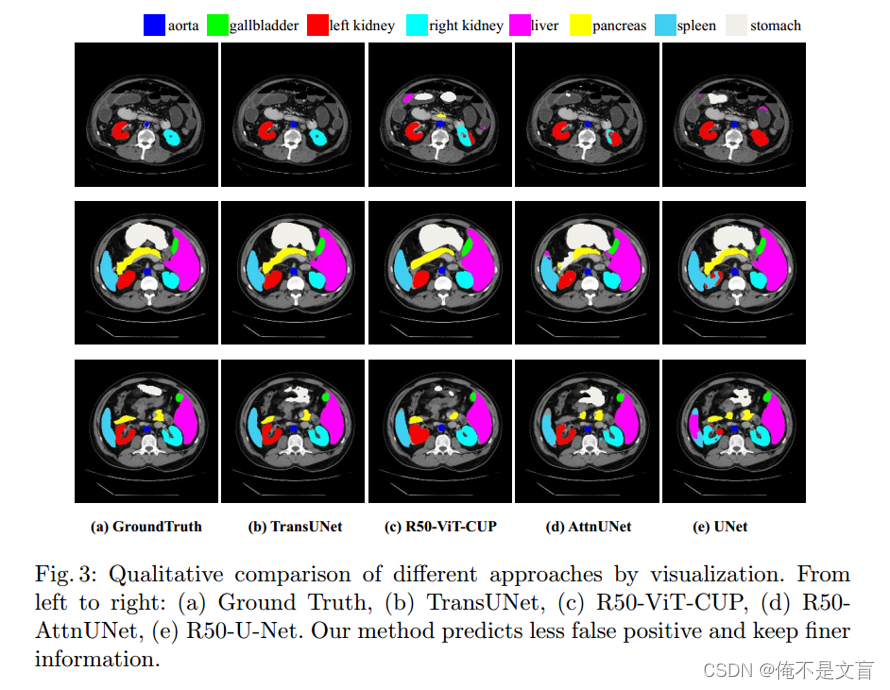

医学图像分割2 TransUnet:Transformers Make Strong Encoders for Medical Image Segmentation

TransUnet:Transformers Make Strong Encoders for Medical Image Segmentation 这篇文章中你可以找到一下内容:- Attention是怎么样在CNN中火起来的?-Non Local- Transformer结构带来了什么?-Multi Head Self Attention- Transformer结构为何在CV中如此流

Chapter 5: Encoders

What is an encoder 编码器负责将事件转化为字节数组,并将字节数组转换成一个OutputStream 。 Encoder ---> Byte[] ---> OutputStream 在0.9.19版本之前,大多数的appender都依赖layout布局组件将事件转换为字符串String 在使用java.io.Writer将其写入到文件 在0.9.19版本之前,对FileApp

论文解读《TransUNet: Transformers Make Strong Encoders for Medical Image Segmentation》

论文解读《TransUNet: Transformers Make Strong Encoders for Medical Image Segmentation》 TransUNet:用于医学图像分割的变压器强编码器 发表期刊:CVPR2021 代码:代码链接 论文:论文链接 一、摘要: 在各种医学图像分割任务上,u形架构(也称为U-Net)已成为事实上的标准并取得了巨大的成功。但是,由于

【转载】Arduino关于旋转编码器程序的介绍(Reading Rotary Encoders)

转载:https://blog.csdn.net/xuanyuanlei1020/article/details/51725653 在原文基础上稍加整理,对原作者 轩辕泪1020表示敬意!! 1. 介绍 旋转或编码器是一个角度测量装置. 他用作精确测量电机的旋转角度或者用来控制控制轮子(可以无限旋转,而电位器只能旋转到特定位置)。其中有一些还安装了一个可以在轴上按的按钮,就像音乐播放器的控制按

TSP: Temporally-Sensitive Pretraining of Video Encoders for Localization Tasks论文阅读笔记

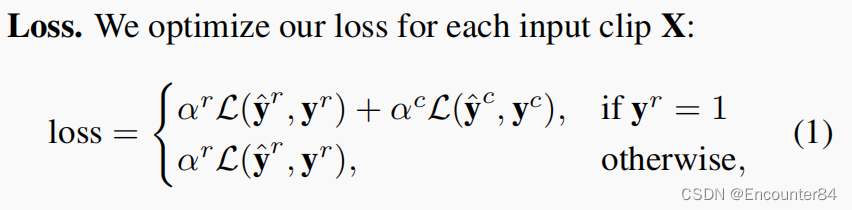

Abstract 由于未修剪的视频占用大量的内存空间,目前SOTA的TAL方法使用了预先处理好的视频特征。这些特征是从视频编码器中提取出来的,它们通常被用于动作分类任务的训练,这使得这些特征不一定适合于时序动作检测。在这项工作中,我们提出了一种新的用于视频片段特征的有监督预训练范式,它不仅训练活动分类活动,还考虑背景剪辑和全局视频信息,以提高时间敏感度。大量的实验表明,使用我们的新的预训练策略训

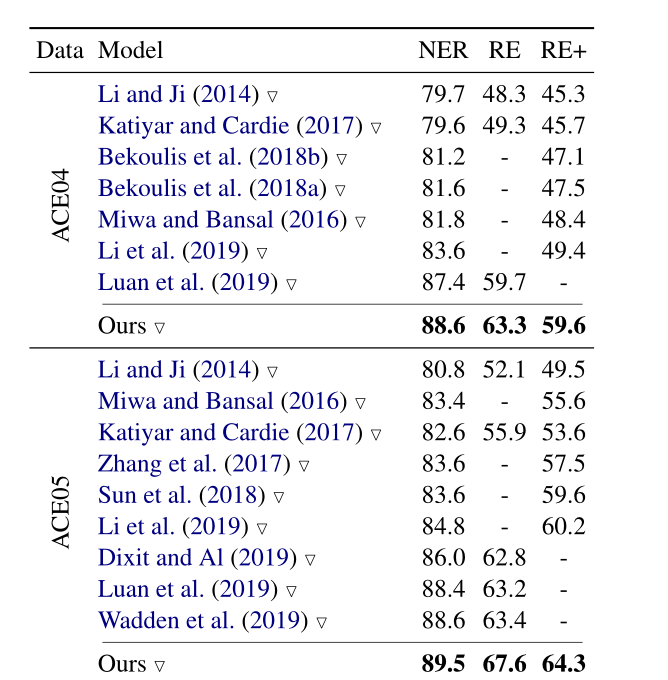

Two are Better than One Joint Entity and Relation Extraction with Table-Sequence Encoders

Two are Better than One: Joint Entity and Relation Extraction with Table-Sequence Encoders 两个都比一个好:表序编码器的联合实体和关系提取 code Abstract 对于联合实体关系抽取,许多研究者将联合任务归结为一个填表问题,他们主要专注于学习单个编码器来捕获同一空间内的两个任务所需的信息

论文Bridging Vision and Language Encoders: Parameter-Efficient Tuning for Referring Image Segmentation

RIS 系列 Bridging Vision and Language Encoders: Parameter-Efficient Tuning for Referring Image Segmentation 论文阅读笔记 一、Abstract二、引言三、相关工作Vision-Language Models (VLMs)Parameter-efficient Tuning (PET)Ref

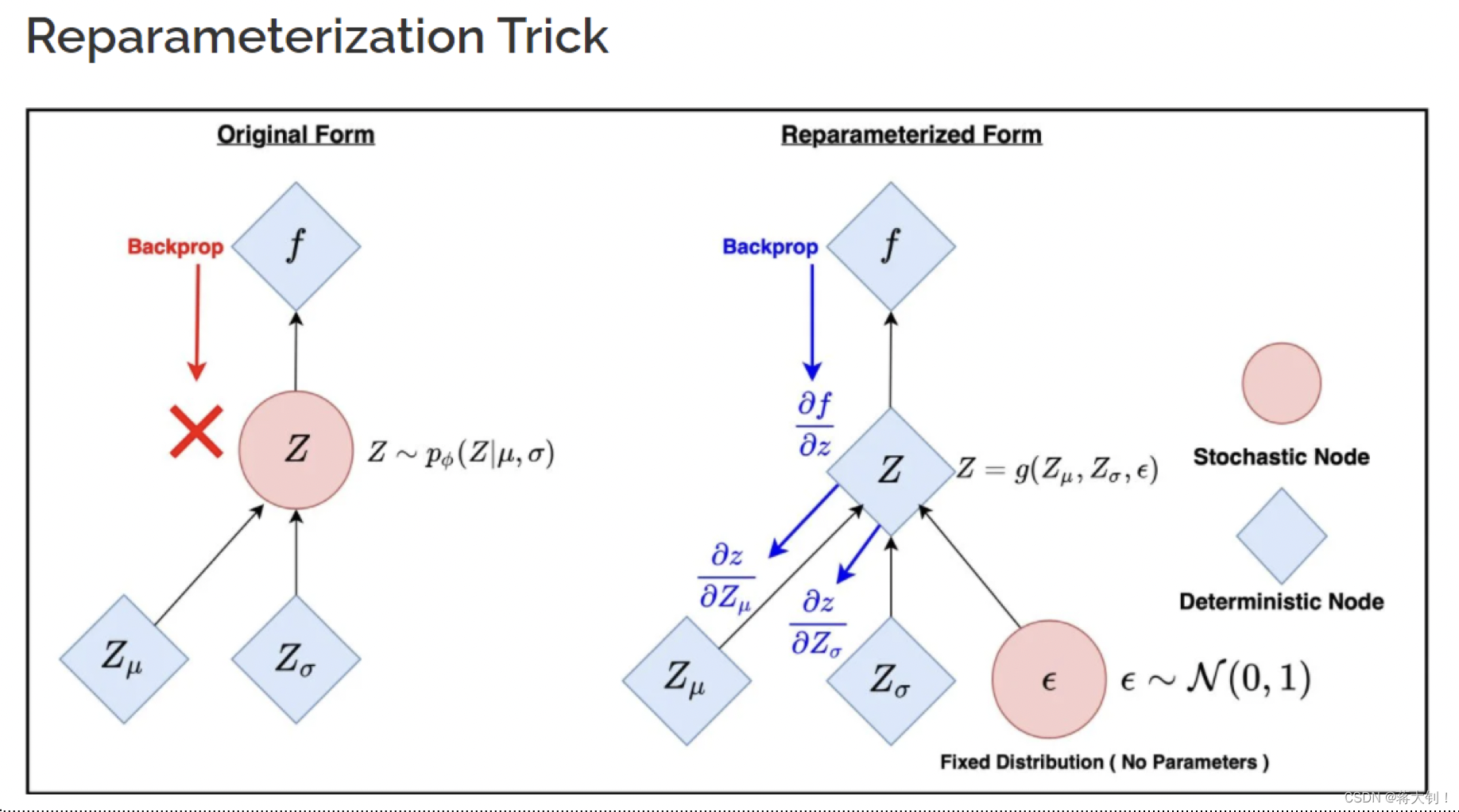

高级人工智能之自编码器Auto-encoders

文章目录 Traditional (Vanilla/Classical) AutoencoderVariational AutoencoderKullback–Leibler divergenceReparameterization 这章讲述模型框架和概念的时间较多,好像并没有涉及过多的运算,重在一些概念的理解。 Traditional (Vanilla/Classical)

BadEncoder: Backdoor Attacks to Pre-trained Encoders in Self-Supervised Learning-基于自监督学习预训练编码器的后门攻击

BadEncoder: Backdoor Attacks to Pre-trained Encoders in Self-Supervised Learning 摘要 本文提出了 BadEncoder,这是针对自监督学习的第一个后门攻击方法。用 BadEncoder 将后门注入到预训练的图像编码器中,基于该编码器进行微调的不同下游任务会继承该后门行为。我们将 BadEncoder 描述为一个优