cot专题

[LLM][Prompt Engineering]:思维链(CoT)

思维链 思维链1. 思维链提示方法和增强策略1.1 简单的思维链提示1.2 示例形式的思维链提示1.3 思维链提示的后处理方案1.4 拓展推理结构 2. CoT的能力来源:为什么思维链提示能显著提升大语言模型在推理任务上的效果? 强大的逻辑推理是大语言模型“智能涌现”出的核心能力之一。 推理:一般指根据几个已知的前提推导得出新的结论的过程,区别于理解,推理一般是一个“多

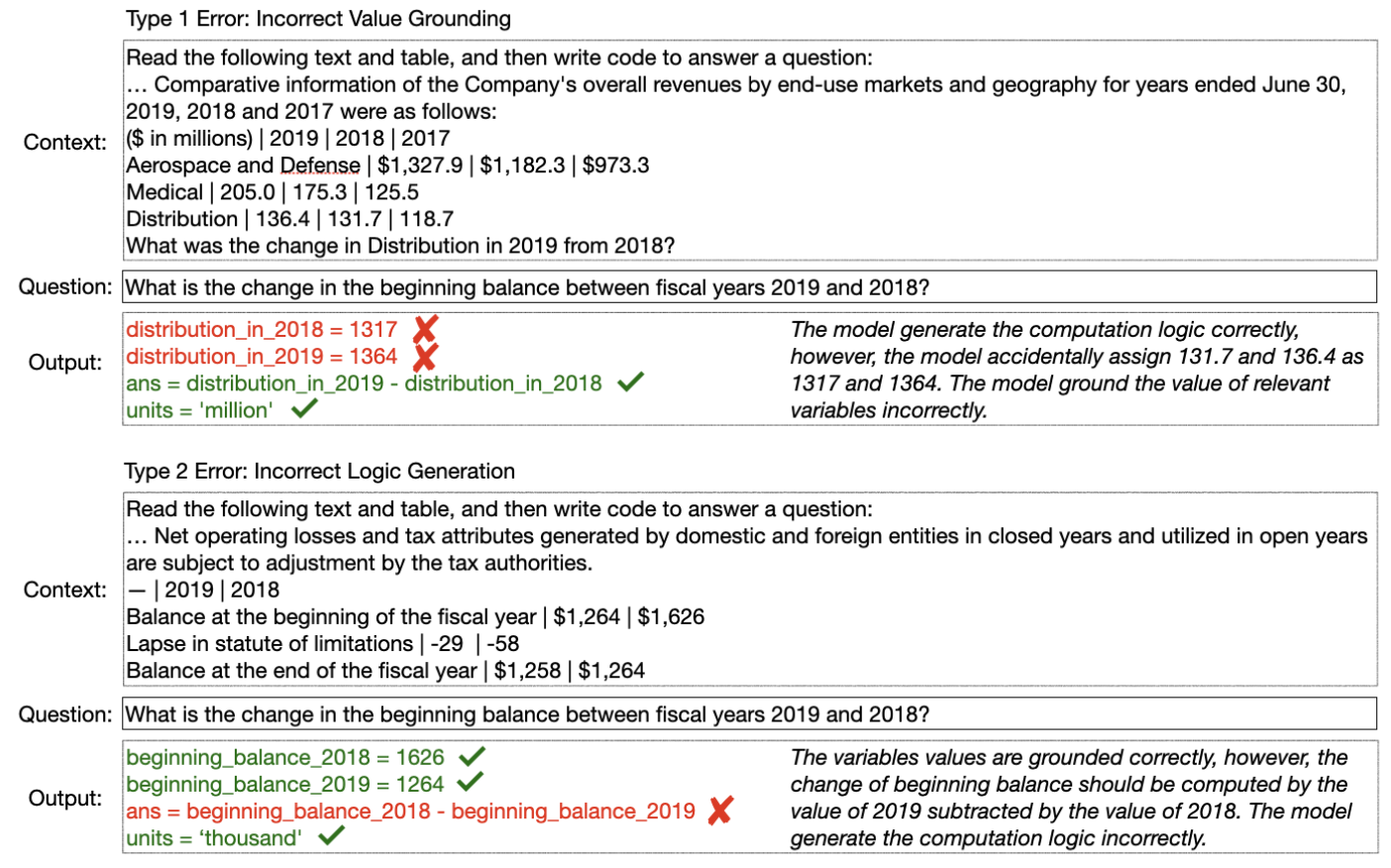

Program-of-Thoughts(PoT):结合Python工具和CoT提升大语言模型数学推理能力

Program of Thoughts Prompting:Disentangling Computation from Reasoning for Numerical Reasoning Tasks github:https://github.com/wenhuchen/Program-of-Thoughts 一、动机 数学运算和金融方面都涉及算术推理。先前方法采用监督训练的形式,但这种方

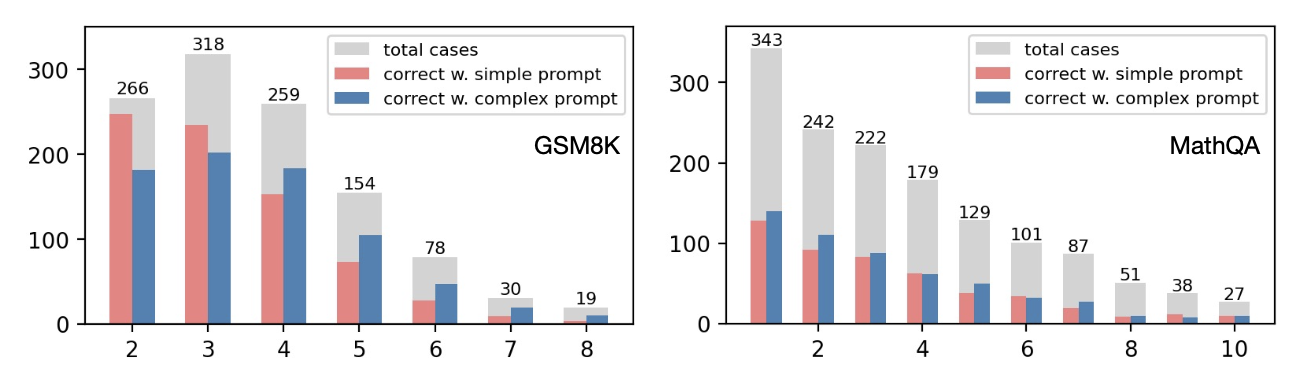

越复杂的CoT越有效吗?Complexity-Based Prompting for Multi-step Reasoning

Complexity-Based Prompting for Multi-step Reasoning 论文:https://openreview.net/pdf?id=yf1icZHC-l9 Github:https://github.com/FranxYao/chain-of-thought-hub 发表位置:ICLR 2023 Complexity-Based Prompting for

总结:大模型之CoT

一、CoT是什么? Chain-of-Thought(CoT)是一种在人工智能和机器学习领域中使用的技术,特别是在自然语言处理(NLP)任务中。它旨在通过模拟人类的思维过程来提高模型的理解和推理能力。CoT技术通常涉及以下几个方面: 思维链构建:在处理复杂问题时,CoT技术会引导模型逐步构建一个逻辑链,这个链由一系列相关的推理步骤组成,每个步骤都是基于前一步的结果。 逐步推理:模型不是直接

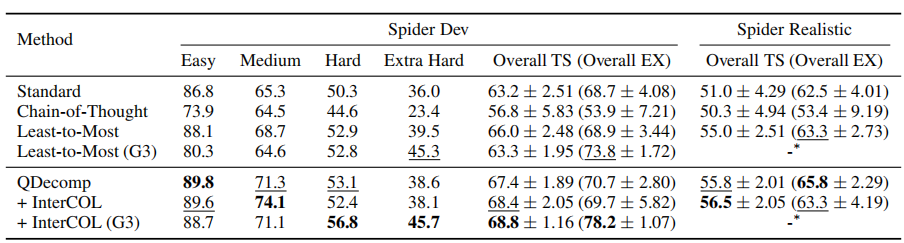

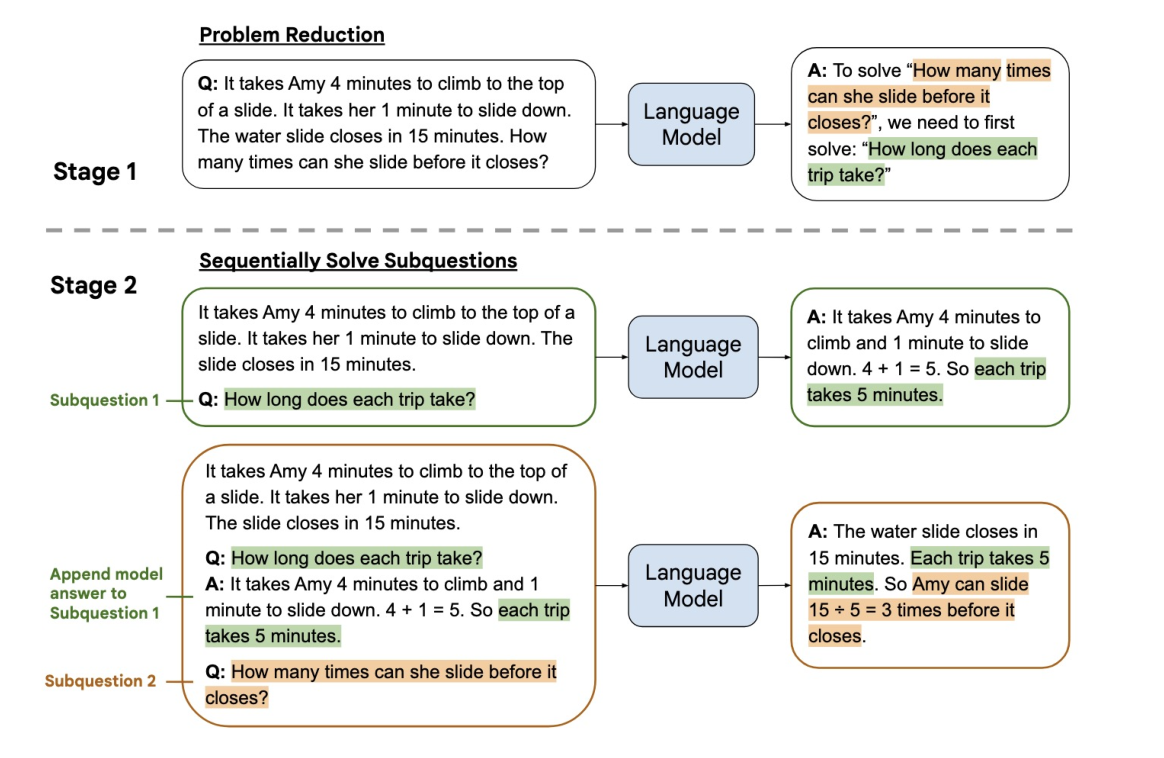

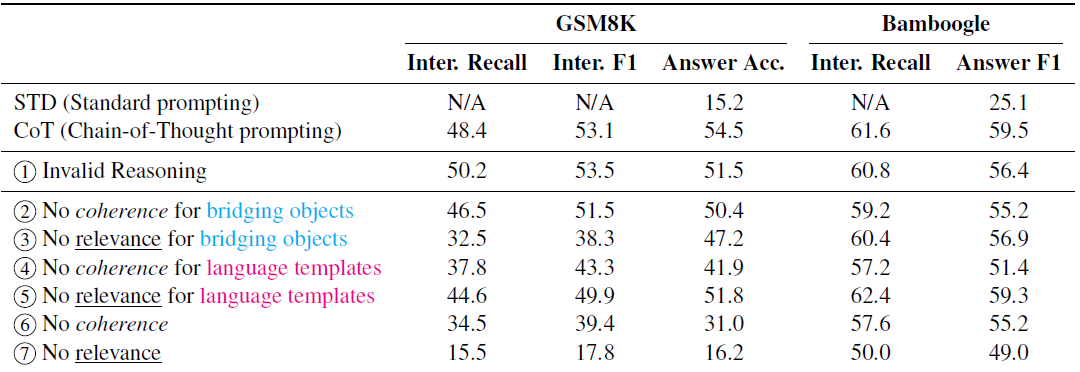

【Text2SQL 论文】QDecomp:探索 CoT-style 的 prompt 来解决 Text2SQL

论文:Exploring Chain of Thought Style Prompting for Text-to-SQL ⭐⭐⭐⭐ EMNLP 2023, arXiv:2305.14215 一、论文速读 本文通过对 LLM 使用 CoT-style 的 prompting 方法来解决 Text2SQL 问题,试图回答下面两个问题: 哪种 prompting style 更好:在一个

创新实训2024.05.28日志:记忆化机制、基于MTPE与CoT技术的混合LLM对话机制

1. 带有记忆的会话 1.1. 查询会话历史记录 在利用大模型自身能力进行对话与解答时,最好对用户当前会话的历史记录进行还原,大模型能够更好地联系上下文进行解答。 在langchain chat chat的chat函数中,通过实现langchain框架提供的ChatMemory。就可以建立一个对话记录的缓冲区,随后读取历史会话记录到缓冲区,在对话时作为memory参数传入。 memory

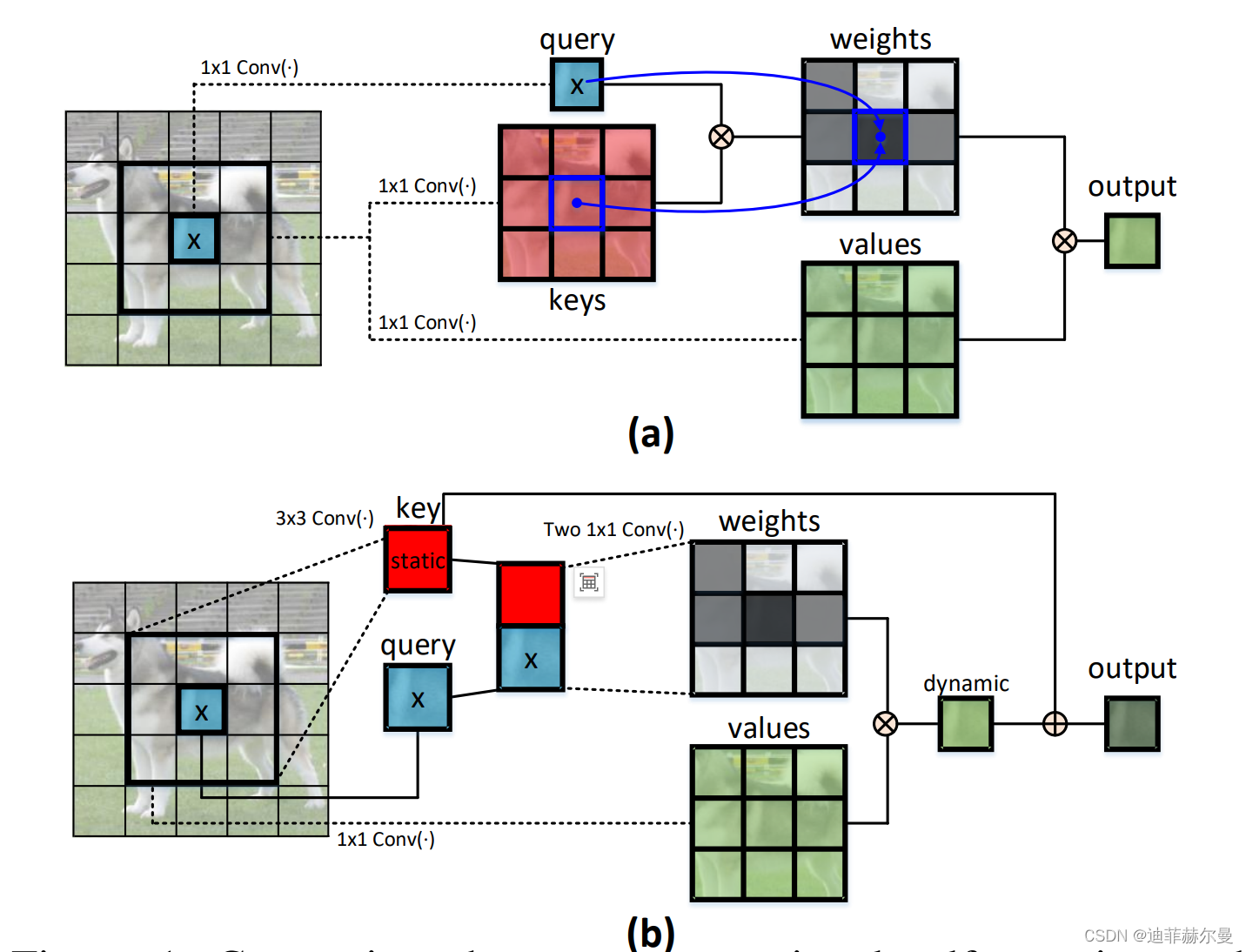

上下文注意力 CoT Attention | Contextual Transformer Networks for Visual Recognition

论文名称:《Contextual Transformer Networks for Visual Recognition》 论文地址:https://arxiv.org/pdf/2107.12292.pdf 代码地址:https://github.com/JDAI-CV/CoTNet 具备自注意力机制的 Transformer 已经引领了自然语言处理领域的革命,并且最近也在许多计算机

提示词工程技术:类比、后退、动态少样本、自动生成CoT

类比提示 “类比提示”利用类比推理的概念,鼓励模型生成自己的例子和知识,从而实现更灵活和高效的解决问题。 后退提示 “后退提示”专注于抽象,引导模型推导出高级概念和原理,进而提高其推理能力。 使用一个基本的数学问题来展示“后退提示”技术: Original Question: If a train travels at a speed of 60 km/h and covers a di

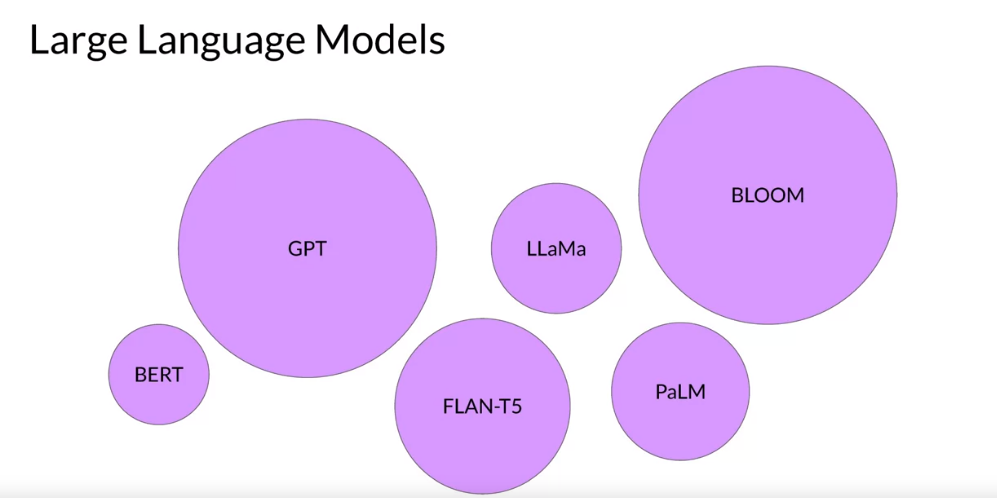

LLM 和生成式 AI 简介:LLM 架构、提示词工程和 LLM 配置 大型语言模型中的思维链(CoT):介绍和应用

Source : Generative AI with Large Language Models | Coursera 资料来源:https://www.coursera.org/learn/generative-ai-with-llms 目录 The Rise of LLMs AI大模型的兴起 Prompts and Completion 提示和完成 Text Gen

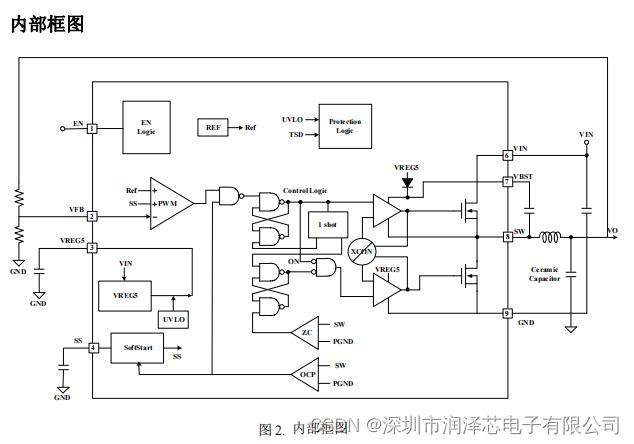

国产替代兼容TPS54628DDAR 18V 6A COT同步降压转换器

简述 DTS54628DDAR替代兼容TPS54628DDAR,DTS54628DDAR是一款采用固定导通时间控制技术(COT)的同步降压转换器。 DTS54628DDAR的主控制环路采用COT模式控制,可使用低ESR的陶瓷电容,无需外部补偿组件便可实现快速瞬态响应,1.05V输出情况下,0A到6A负载跳变Dropout电压仅为70mV。 固定导通时间控制技术可实现重载状态下工作在PWM 模式,

如何提升大模型的推理和规划能力:思维链 CoT + 由少至多提示 Least-to-Most Prompting

如何提升大模型的推理和规划能力 思维链 - CoT思维链改进:Auto-CoT、小冰链(X-CoTA) 由少至多提示 - Least-to-Most Prompting 思维链 - CoT 最初的语言模型都是基于经验的,只能根据词汇之间的相关性输出答案,根本没有思考能力…… 但是从使用思维链后,大模型已经是有思考能力的。能进行一定的推理。 2021年,OpenAI在训练神经

模型复杂推理-思维链COT基础和进阶玩法

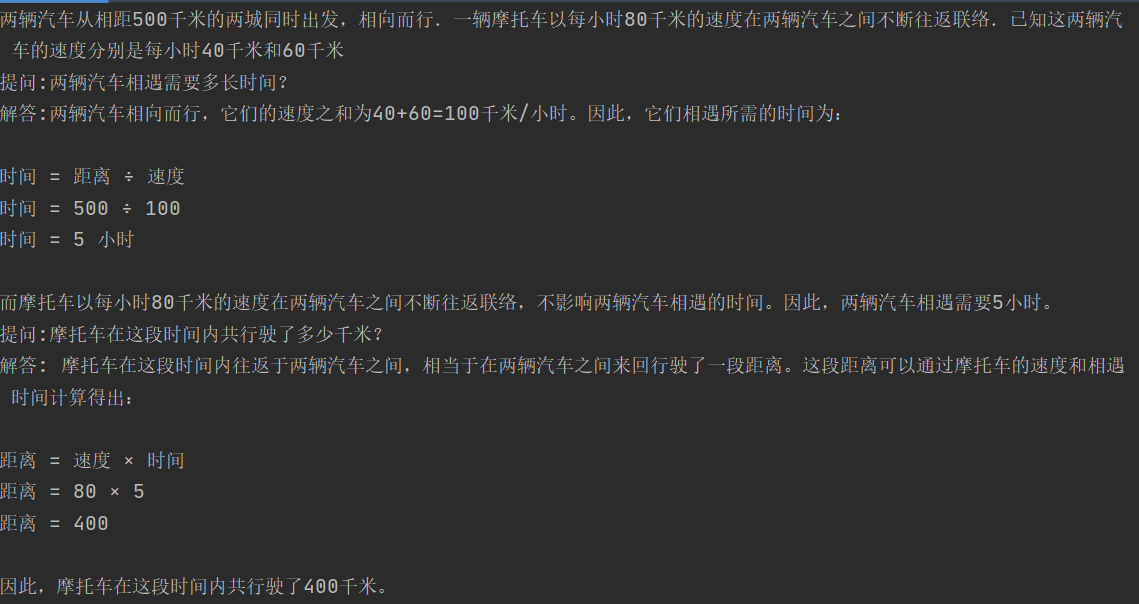

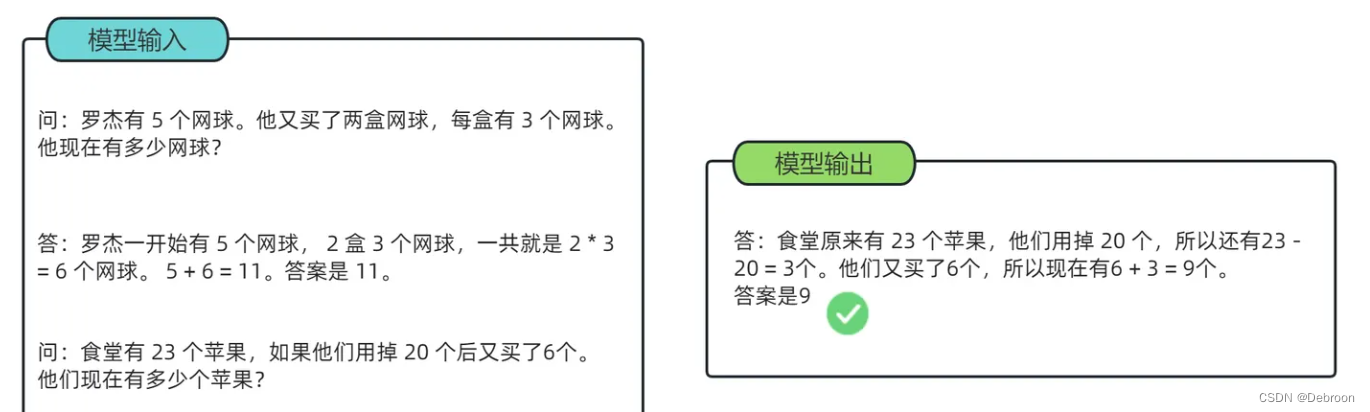

COT基础用法 Few-shot COT Chain of Thought Prompting Elicits Reasoning in Large Language Models 开篇自然是COT小王子的成名作,也是COT的开山之作,单看引用量已经是一骑绝尘。 论文的核心是通过Few-shot的方案,来引导模型生成中间推理过程,并最终提高模型解决复杂问题的能力。核心逻辑

一文读懂「Chain of Thought,CoT」思维链

前言: 思维链,在人工智能领域,是一个非常非常新的概念。强大的逻辑推理是大语言模型“智能涌现”出的核心能力之一,好像AI有了人的意识一样。而推理能力的关键在于——思维链(Chain of Thought,CoT)。 相关概念: 语言智能可以被理解为“使用基于自然语言的概念对经验事物进行‘理解’以及在概念之间进行‘推理’的能力”,随着参数量的飞升,以Transformer 为基础架构的大规模语言

【解决复杂链式任务打造全能助手】大模型思维链 CoT 应用:langchain 大模型 结合 做 AutoGPT

大模型思维链 CoT 应用:langchain 大模型 结合 做 AutoGPT,解决复杂链式任务打造全能助手 思维链 CoTlangchainlangchain 大模型结合打造 AutoGPT 思维链 CoT 最初的语言模型都是基于经验的,只能根据词汇之间的相关性输出答案,根本没有思考能力…… 但是从使用思维链后,大模型已经是有思考能力的。能进行一定的推理。 2

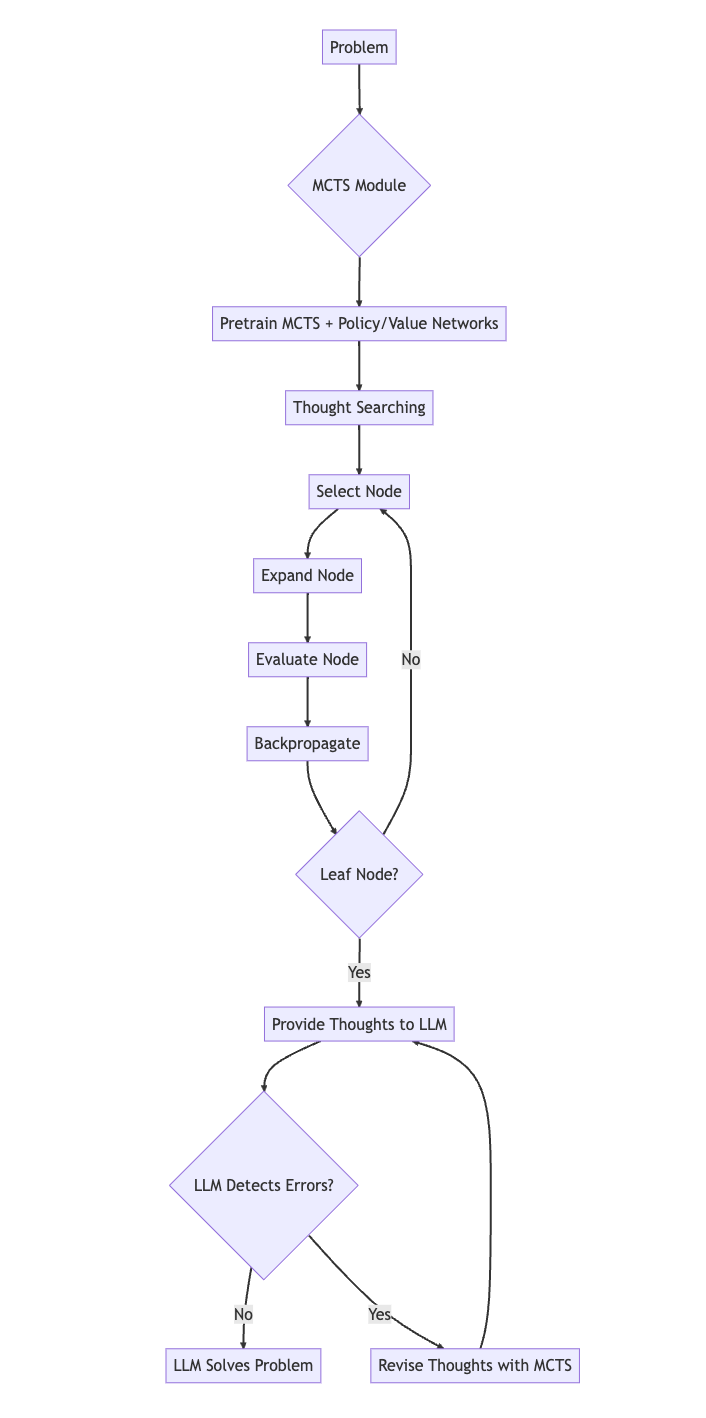

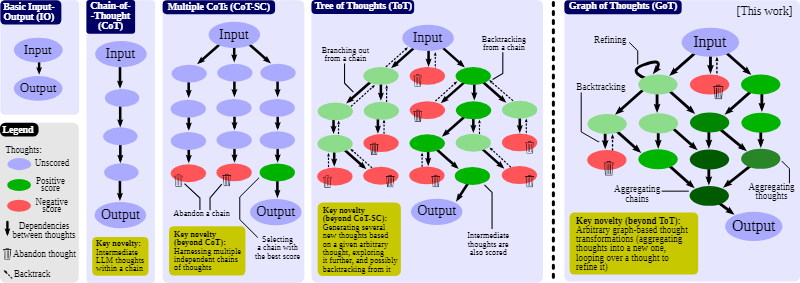

LLM之Prompt(三)| XoT:使用强化学习和蒙特卡罗树搜索将外部知识注入Prompt中,性能超过CoT,ToT和GoT

论文地址:https://arxiv.org/pdf/2311.04254.pdf 一、当前Prompt技术的局限性 LLM使用自然语言Prompt可以将复杂的问题分解为更易于管理的“thought”可以回复用户的问题。然而,大多数现有的Prompt技术都有局限性: 输入输出(IO)Prompt:仅适用于具有单步解决方案的简单问题,它缺乏灵活性;思维链(CoT):能够

思维链(CoT)提出者 Jason Wei:关于大语言模型的六个直觉

文章目录 一、前言二、主要内容三、总结 🍉 CSDN 叶庭云:https://yetingyun.blog.csdn.net/ 一、前言 Jason Wei 的主页:https://www.jasonwei.net/ Jason Wei,一位于 2020 年从达特茅斯学院毕业的杰出青年,随后加盟了 Google Brain 团队。在那里他作为研究科学家,为大语言模型

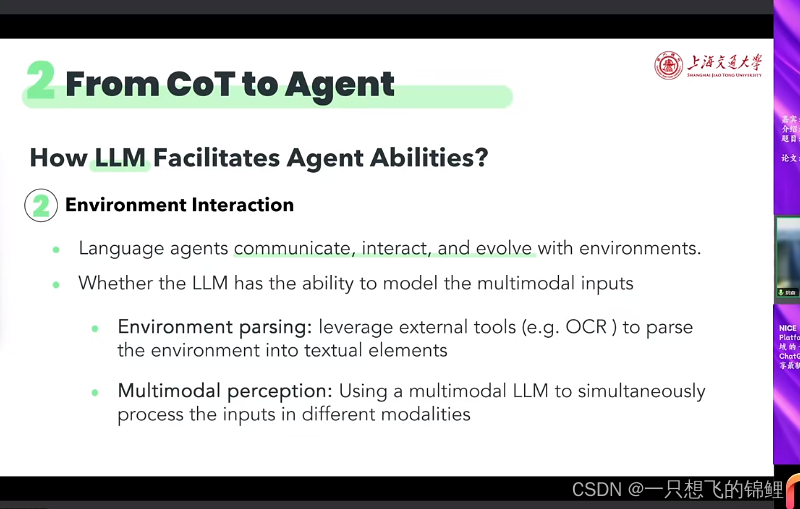

从cot到agent的survey视频笔记

参考视频: 从CoT到Agent的列车即将发车,请各位旅客尽快上车 姚杳 由于总结不易,所以暂时都是粉丝可见,如果总结的不好见谅。 核心理解点总结: paradigm shifts of cot when cot?推理多的任务时 how cot? 挖掘知识串起来 remark. llm本身就有推理能力,cot只是帮助他或者告诉他输出形式,引导他推理(所以不是教哦,他本来就会呢)。

NLP中 大语言模型LLM中的思维链 Chain-of-Thought(CoT) GoT

文章目录 介绍思路CoT方法Few-shot CoTCoT Prompt设计CoT投票式CoT-自洽性(Self-consistency)使用复杂的CoT自动构建CoTCoT中示例顺序的影响Zero-shot CoT 零样本思维链 GoT,Graph of Thoughts总结 介绍 在过去几年的探索中,业界发现了一个现象,在增大模型参数量和训练数据的同时,在多数任务上,模型的

NLP中 大语言模型LLM中的思维链 Chain-of-Thought(CoT) GoT

文章目录 介绍思路CoT方法Few-shot CoTCoT Prompt设计CoT投票式CoT-自洽性(Self-consistency)使用复杂的CoT自动构建CoTCoT中示例顺序的影响Zero-shot CoT 零样本思维链 GoT,Graph of Thoughts总结 介绍 在过去几年的探索中,业界发现了一个现象,在增大模型参数量和训练数据的同时,在多数任务上,模型的

CoT: 思路链提示促进大语言模型的多步推理

CoT 总览摘要1 引言2 Chain-of-Thought Prompting3 算术推理 (Arithmetic Reasoning)3.1 实验设置3.2 结果3.3 消融实验3.4 CoT的鲁棒性 4 常识推理 (Commonsense Reasoning)5 符号推理 (Symbolic Reasoning)附录A.1 为什么增加模型的规模,能提升CoT的能力?A.2 提示词工作的

性能强劲又通用!Meta-CoT: 混合问题场景下的自适应思维链推理

©PaperWeekly 原创 · 作者 | 邹安妮 单位 | 上海交通大学 研究方向 |NLP,大模型推理 大语言模型(LLMs)通过思维链(CoT)提示技术,生成中间推理链作为得出答案的依据。然而,当前的 CoT 方法要么采用简单的通用提示(例如“让我们一步一步思考”),要么依赖人工制定且任务特定的样本示例来获得更好的性能,从而在性能和通用性之间产生了巨大的鸿沟。为了弥补这一鸿沟,本文提出

CoT 的方式使用 LLM 设计测试用例实践

##前期准备 import SparkApiimport osfrom dotenv import load_dotenv, find_dotenv#以下密钥信息从控制台获取_=load_dotenv(find_dotenv())appid = os.getenv("SPARK_APP_ID")api_secret=os.getenv("SPARK_APP_SECRET")api_ke

![[LLM][Prompt Engineering]:思维链(CoT)](https://img-blog.csdnimg.cn/img_convert/641e41c292cc42c3da7d6ab1a727de2c.png)