autograd专题

pytorch自动求梯度autograd的实现

《pytorch自动求梯度autograd的实现》autograd是一个自动微分引擎,它可以自动计算张量的梯度,本文主要介绍了pytorch自动求梯度autograd的实现,具有一定的参考价值,感兴趣... autograd是pytorch构建神经网络的核心。在 PyTorch 中,结合以下代码例子,当你

8、AUTOGRAD MECHANICS

本笔记将概述 autograd 如何工作并记录操作。 理解所有这些并不是绝对必要的,但我们建议熟悉它,因为它会帮助您编写更高效、更干净的程序,并可以帮助您进行调试。 How autograd encodes the history Autograd 是反向自动微分系统。 从概念上讲,autograd 会记录一个图形,记录在您执行操作时创建数据的所有操作,为您提供一个有向无环图,其叶子是输入张量

7、TORCH.AUTOGRAD

torch.autograd 提供了实现任意标量值函数自动微分的类和函数。它需要对现有代码进行最少的更改 - 您只需要声明 Tensors,应使用 requires_grad=True 关键字为其计算梯度。截至目前,我们仅支持浮点张量类型(half、float、double 和 bfloat16)和复杂张量类型(cfloat、cdouble)的 autograd。 backward 计算给定张

深度学习小笔记05-扩展autograd-摘抄自《深度学习框架PyTorch:入门与实践》陈云-附个人书评

为什么摘抄这一段,因为我认为这里是一个非常有用的部分,看完autograd就想去问答区提问: 然后发现没有c币,于是乎暂时作罢,结果发现答案就在下一小节(先看完再想问题,不然浪费了一个好问题),没办法我就是这么热爱思考的一个人,看完立刻就有问题,等不到再看一段书。 — 我是分界线— p94:目前,绝大多数函数都可以使用autograd实现反向求导,但如果需要自己写一个复杂的函数,不支持自动

Pytorch学习笔记_2_Autograd自动求导机制

Autograd 自动求导机制 PyTorch 中所有神经网络的核心是 autograd 包。 autograd 包为张量上的所有操作提供了自动求导。它是一个在运行时定义的框架,可以通过代码的运行来决定反向传播的过程,并且每次迭代可以是不同的。 通过一些示例来了解 Tensor 张量 torch.tensor是这个包的核心类。 设置.requires_grad为True,会追踪所有对于

PyTorch 的 Autograd、计算图、叶子张量、inplace 操作、动态图,静态图(来自知乎)

本博文来自:https://zhuanlan.zhihu.com/p/69294347 非常感谢此博主! PyTorch 作为一个深度学习平台,在深度学习任务中比 NumPy 这个科学计算库强在哪里呢?我觉得一是 PyTorch 提供了自动求导机制,二是对 GPU 的支持。由此可见,自动求导 (autograd) 是 PyTorch,乃至其他大部分深度学习框架中的重要组成部分。 了解自动求导背

pytorch教程之自动求导机制(AUTOGRAD)-从梯度和Jacobian矩阵讲起

文章目录 1. 梯度和Jacobian矩阵2. pytorch求变量导数的过程 1. 梯度和Jacobian矩阵 设 f ( x ) ∈ R 1 f(x)\in R^1 f(x)∈R1是关于向量 x ∈ R n x\in R^n x∈Rn的函数,则它关于 x x x的导数定义为: d f ( x ) d x : = [ ∂ f ( x ) ∂ x i ] ∈ R n (1-

自动微分运算TORCH.AUTOGRAD

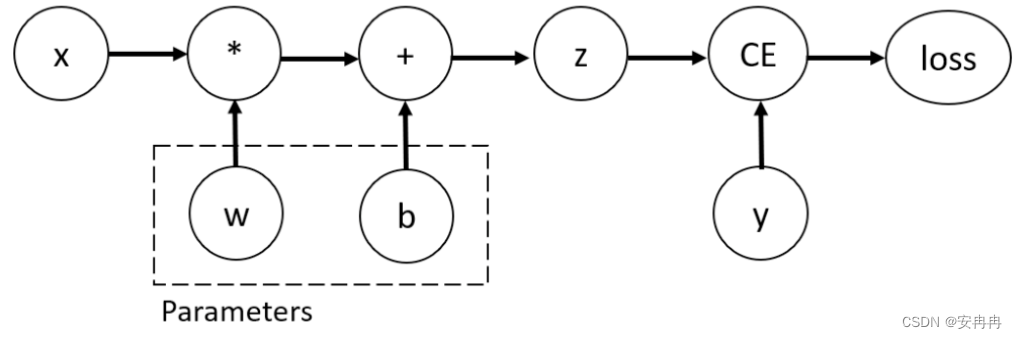

Tensor、函数和计算图 反向传播算法中,模型参数根据相对于每个给定参数的损失函数的梯度来调整。 为了计算这些梯度,PyTorch 有一个内置的微分运算引擎叫 torch.autograd。它支持对任何计算图自动计算梯度。 考虑一个最简单的单层神经网络,它有输入值 x、参数 w 和 b、和一些损失函数。它可以在 PyTorch 中这么定义: import torchx = torch.

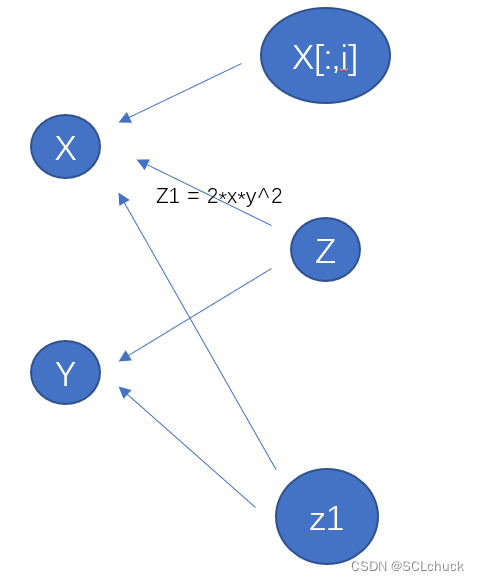

pytorch的梯度图与autograd.grad和二阶求导

前向与反向 这里我们从 一次计算 开始比如 z=f(x,y) 讨论若我们把任意对于tensor的计算都看为函数(如将 a*b(数值) 看为 mul(a,b)),那么都可以将其看为2个过程:forward-前向,backward-反向在pytorch中我们通过继承torch.autograd.Function来实现这2个过程,详细的用法和扩展参考:https://pytorch.org/doc

AI学习(5):PyTorch-核心模块(Autograd):自动求导

1.介绍 在深度学习中,自动求导是一项核心技术,它使得我们能够方便地计算梯度并优化模型参数。PyTorch 提供了一个强大的自动求导模块(Autograd),它可以自动计算张量的导数得出梯度信息,同时也支持高阶导数计算。 1.1 概念词 在学习PyTorch的过程中,经常会看到这些词汇: 自动求导、梯度计算、前向传播、反向传播、动态计算图等,下面是一些简单介绍: 自动求导:PyTor

PyTorch框架----torch.autograd

文章目录 一、Variable二、torch.autograd三、torch.autograd.backward(variables, grad_variables, retain_variables=False)四、自动求导机制1、从后向中排除子图2、自动求导如何编码历史信息 一、Variable Variable是PyTorch中的一个类,它封装了张量(Tensor)并

【PyTorch简介】5.Autograd 自动微分

5.Autograd 自动微分 文章目录 5.Autograd 自动微分Automatic Differentiation with `torch.autograd` 自动微分与`torch.autograd`Tensors, Functions and Computational graph 张量、函数和计算图笔记 Computing Gradients 计算梯度Note 笔记Disab

自动求导的原理(Autograd, Auto Differentiation)

知乎话题 TensorFlow的求导,实际上是先提供每一个op求导的数学实现(人手工写的函数代码),然后使用链式法则自动求出整个表达式的导数。 op的forward和backward,都是用矩阵做输入和输出的,便于GPU调库加速。 很好的示例代码: miniflow; 开源计算图示例(1);开源计算图示例(2);开源计算图示例(3) 四种求导方式的介绍;论文:Automatic Dif

[Pytorch] torch.autograd.profiler细节

官网使用说明; Python部分: 核心类class profile:用户侧用with来创建和退出之;self.function_events成员是核心数据;缺点:DataLoader发起的多进程调用,其无法get到其他进程的操作的cuda时间; 成员函数__enter__: with开始时调用,调用C++底层的torch.autograd._enable_profiler开始统计;

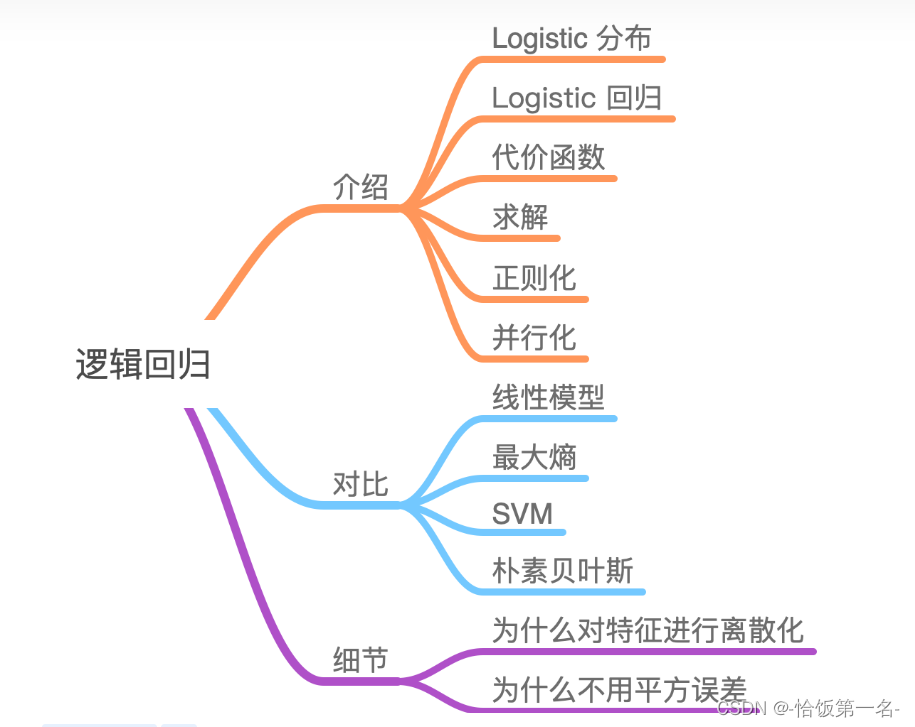

autograd与逻辑回归

一、autograd—自动求导系统 torch.autograd.backward() torch.autograd.backward()是PyTorch中用于计算梯度的函数。以下是对该函数的参数的解释: 功能:自动求取梯度 • tensors: 用于求导的张量,如 loss • retain_graph : 保存计算图 • create_graph : 创建导数计算图,用于高阶求导 • g

Week1:[任务三] 第二节 autograd与逻辑回归

【目录】 自动求导系统 逻辑回归 1、自动求导系统 torch.autograd.backward()方法 张量中的y.backward方法实际调用的是torch.autograd.backward()方法 同一个张量反向传播的迭代,需要将y.backward(retain_graph)设置为True tensors为用于求导的张量,如loss;loss.backgr

pytorch框架是如何autograd简易实现反向传播算法的?

import torchx = torch.randn(3,4,requires_grad=True) #对指定的X进行求导b = torch.randn(3,4,requires_grad=True)t = x+by=t.sum()print(y)y.backward() #执行反向传播print(b.grad)print(x.requires_grad, b.requires_g

![Week1:[任务三] 第二节 autograd与逻辑回归](https://img-blog.csdnimg.cn/20210805113025542.png?x-oss-process=image/watermark,type_ZmFuZ3poZW5naGVpdGk,shadow_10,text_aHR0cHM6Ly9ibG9nLmNzZG4ubmV0L3FxXzQyMjYxMDky,size_16,color_FFFFFF,t_70)