attentional专题

Co-scale conv-attentional image transformer代码

首先这次主要看CoaT-Lite small的代码。因为他还有CoaT代码,等下一步再看。 代码地址:代码每一步debug后的维度都批注在代码后面。 mlpc-ucsd/CoaT: (ICCV 2021 Oral) CoaT: Co-Scale Conv-Attentional Image Transformers (github.com) """ CoaT architecture.

论文翻译:Attentional Feature Fusion

Attentional Feature Fusion 摘要1 引言2 Related Work3. Multi-scale Channel Attention(多尺度通道的关注)4. 注意力特征融合 Attentional Feature Fusion5. Experiments6. Conclusion 注意力特征融合 作者:Yimian Dai1 Fabian Gieseke

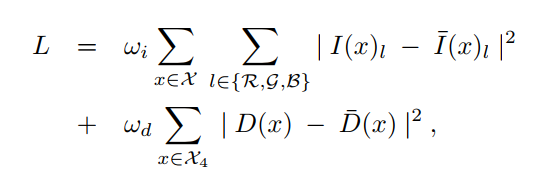

论文阅读:Depth-attentional Features for Single-image Rain Removal

2019 CVPR:DAF-Net 这是2019CVPR的一篇文章,主要创新点是引入了深度信息完成去雨。 本篇文章首先指出了现有的方法由于忽略了物理特性,导致去雨的有效性较低。同时分析了雨图成像机理,指出远处的物体更多地是被雾遮挡,近处的则是雨纹,分析了受场景深度影响的雨的视觉效果,并共同制定了一个带有雨条纹和雾的雨成像模型;然后,并准备了一个新的数据集。然后设计了一个端到端的深度神经网络

Attentional Feature Fusion中所提的注意力模块的代码

最近看了Attentional Feature Fusion这篇文章,对其提出的注意力机制模块很感兴趣,所以就上github找了一下,为了方便自己记录和使用,所以就复制到这里了。 源代码的github的网址:https://github.com/YimianDai/open-aff/aff_pytorch/aff_net/fusion.py 论文的下载地址:https://arxiv.org/

【6】卷积神经网络之Attentional Feature Fusion

最近看到一篇比较不错的特征融合方法,基于注意力机制的 AAF ,与此前的 SENet 、SKNet 等很相似,但 AFF 性能优于它们,并且适用于更广泛的场景,包括短和长跳连接以及在 Inception 层内引起的特征融合。AFF 是由南航提出的注意力特征融合,即插即用! 1、特征融合 1.1、什么是特征融合 特征融合是模式识别领域的一种重要方法,计算机视觉领域的图像识别问题作为一种特殊的模

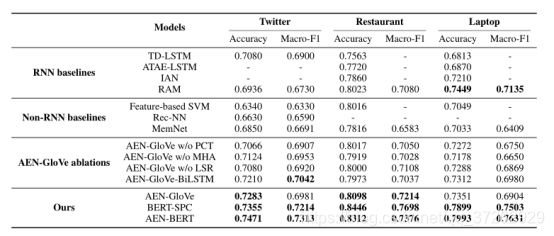

ABSA1: Attentional Encoder Network for Targeted Sentiment Classification

ABSA1: Attentional Encoder Network for Targeted Sentiment Classification 论文标题: Attentional Encoder Network for Targeted Sentiment Classification(点击可下载pdf) 论文源码:ABSA模型库(PyTorch版) 一、引言 以往而言,对于 ABSA 问

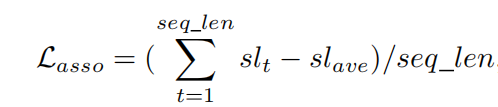

Attentional Encoder Network for Targeted Sentiment Classification(2019)

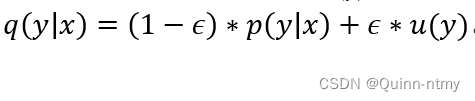

Attentional Encoder Network for Targeted Sentiment Classification(2019) 面向的问题: 以前的大多数方法都是用RNN和注意力来模拟语境和目标词。然而,RNN很难并行化,并且随时间截断的反向传播给记忆长期模式带来了困难。 创新: 1.本文提出了一种避免重复出现的注意编码网络(AEN),并采用基于注意的编码器对上下文和目标进行建

方面级情感分析论文泛09:Attentional Encoder Network for Targeted Sentiment Classification

提示1:原文链接 提示2:代码链接 文章目录 前言一、论文信息二、笔记要点2.1 目前存在的问题2.2 目前解决方法2.3 本文方法和创新点2.4 模型结构2.5 实验结果2.6 总结和展望 总结 前言 本篇博客主要是对《Attentional Encoder Network for Targeted Sentiment Classification》进行了泛读,并对其

推荐算法模型 ----- Attentional Factorization Machines 论文阅读笔记

论文名字:Attentional Factorization Machines:Learning the Weight of Feature Interactions via Attention Network 论文地址:http://staff.ustc.edu.cn/~hexn/papers/ijcai17-afm.pdf 若有错误或不足,烦请各位dalao指教 AFM模型提出的目的和

【推荐系统论文精读系列】(十三)--Attentional Factorization Machines Learning the Weight of Feature Interactions

文章目录 一、摘要二、介绍三、Attentional Factorization Machines3.1 模型3.1.1 Pair-wise Interaction Layer3.1.2 Attention-based Pooling Layer 3.2 学习3.2.1 防止过拟合 References 论文名称:Attentional Factorization Machi

Temporally Identity-Aware SSD with Attentional LSTM 论文学习

多目标跟踪常用的是tracking by detection,这种方法就是将每帧中所有感兴趣的目标物体均检测出来,然后与前一帧检测出来的目标进行关联,从而实现跟踪效果。这种方法的前提就是要拥有一种表现好的目标检测算法还有好的关联方法。 具体流程是: step1:使用目标检测算法将每帧中感兴趣的目标检测出来,得到对应的(坐标,分类,可信度),假设检测出来的目标个数为M step2:通过某种方式