本文主要是介绍【跟马少平老师学AI】-【神经网络是怎么实现的】(九)长短期记忆网络,希望对大家解决编程问题提供一定的参考价值,需要的开发者们随着小编来一起学习吧!

一句话归纳:

1)RNN也会存在梯度消失的问题。

2)同一句话,对于不同的任务,句中不同的词起的作用也不一样。

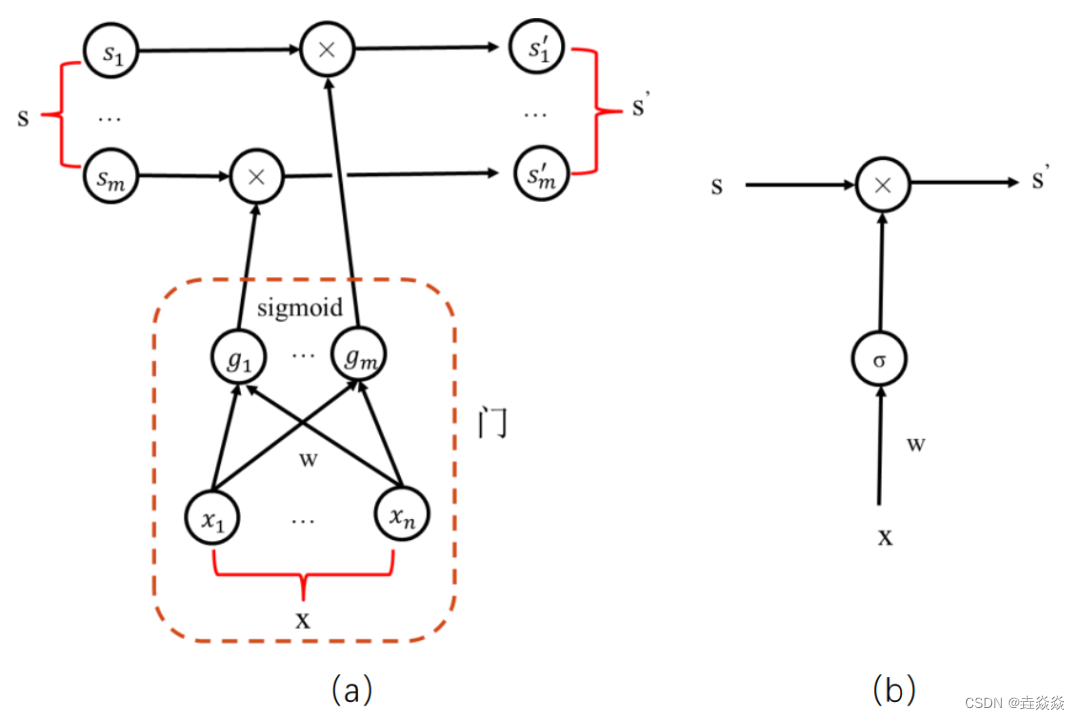

3)LSTM(长短期记忆)子网络:

- 门,让输入经过运算,得到在[0,1]区间内的输出值。

- 元素S与门的输出进行相乘运算,便可以控制S通过的量。

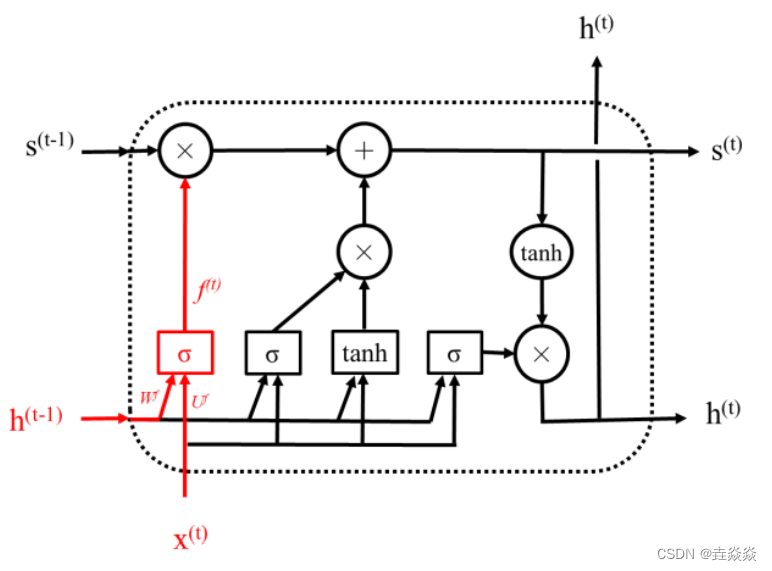

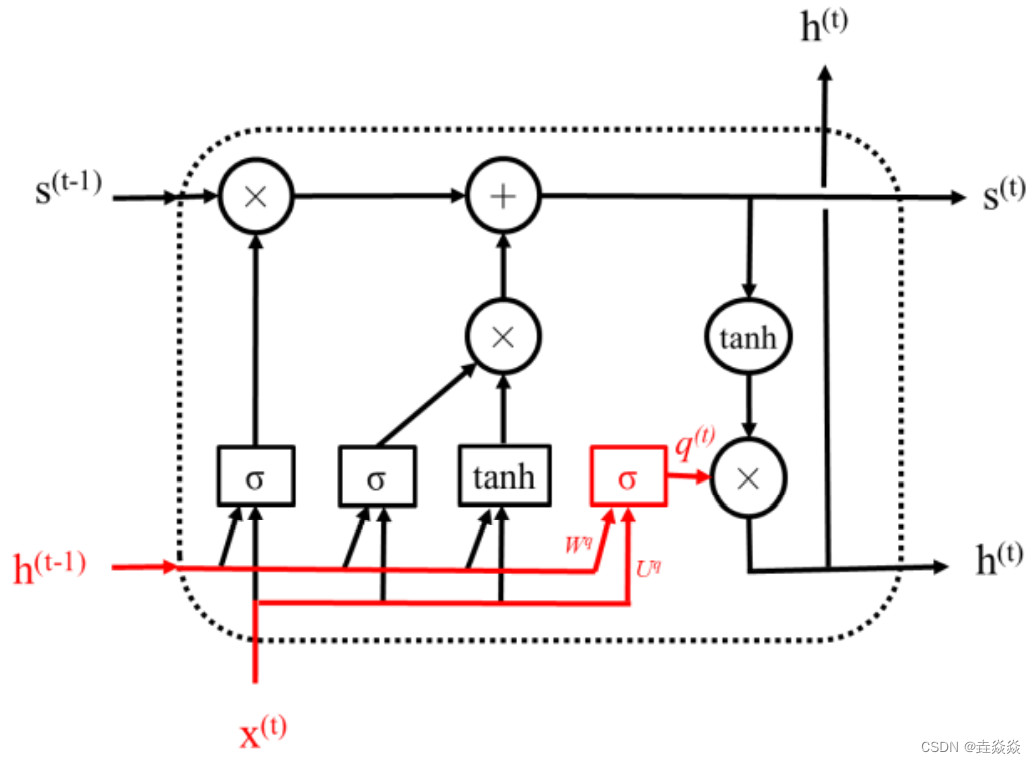

4)LSTM神经网络:

- 遗忘门,输入是h(t-1),x(t),输出f(t)。

- 前一个状态s(t-1)和遗忘门的输出相乘。

- 输入处理单元的输出和输入门相乘。

- 相加后得得到新的状态s(t),即s(t)=f(t)*s(t-1)+g(t)*i(t)。

- 输出门的输入与遗忘门一样。

- h(t)=q(t)*tanh(s(t))。

这篇关于【跟马少平老师学AI】-【神经网络是怎么实现的】(九)长短期记忆网络的文章就介绍到这儿,希望我们推荐的文章对编程师们有所帮助!