马少平专题

【跟马少平老师学AI】-【神经网络是怎么实现的】(五)梯度消失问题

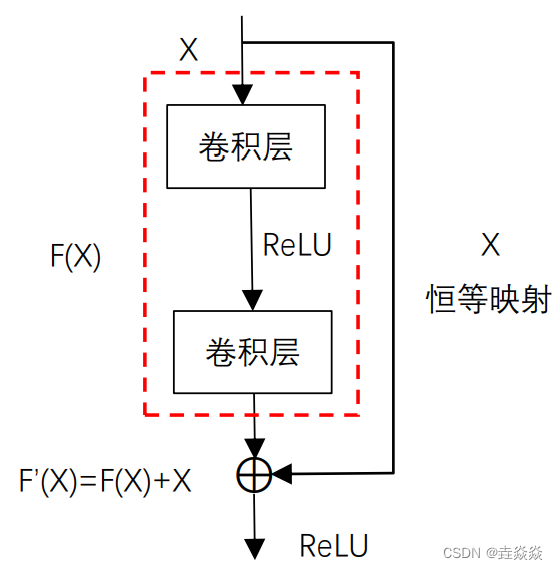

一句话归纳: 1)用sigmoid激活函数时,BP算法更新公式为: 用sigmoid函数,O取值为0~1,O(1-O)最大值为0.25,若神经网络层数多,则会造成更新项趋近于0,称为梯度消失。 2)GooLeNet解决梯度消失的问题: 在不同的深度构造了3个输出。inception模块: 其中,1*1卷积起到改变维度的作用,减少参数个数,比如,输入为19

【跟马少平老师学AI】-【神经网络是怎么实现的】(七-2)word2vec模型

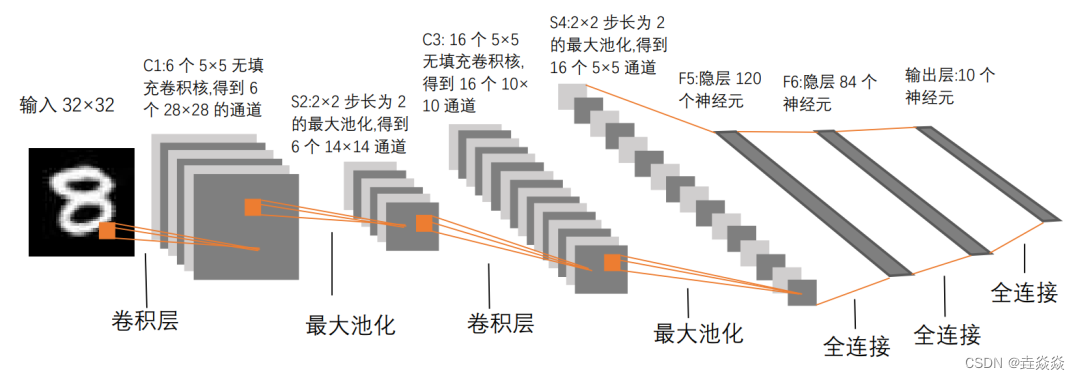

一句话归纳: 1)CBOW模型: 2c个向量是相加,而不是拼接。 2)CBOW模型中的哈夫曼树: 从root开始,向左为1,向右为0。叶子结点对应词有中的一个词。每个词对应唯一的编码。词编码不等长。 3)CBOW模型输出为到达哈夫曼树每一个非叶子结点时向右走的概率。 计算每个叶子结点的概率,以图为例W2的概率为 取对数取反,作损失函数

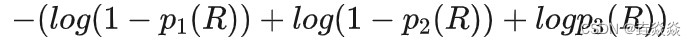

【跟马少平老师学AI】-【神经网络是怎么实现的】(四)卷积神经网络

一句话归纳: 1)用1个小粒度的模式,逐个与图像的局部区域进行运算,运算结果反映模式与区域的匹配程度。 2)卷积神经网络与全连接神经网络的区别: 卷积神经网络的输出只与局部输入有连接。参数较少,按图示为3*3+1=10个。模式叫做卷积神经网络 的卷积核。 3)卷积计算举例,“口”字与“橫”模式进行运算: 运算结果: 横的上边缘概率为1

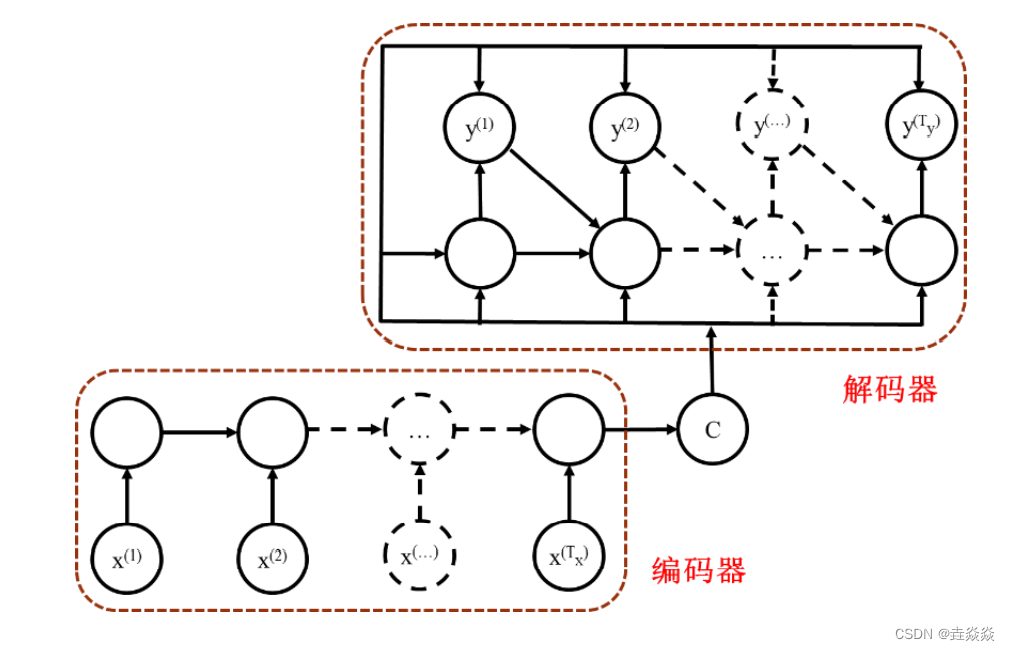

【跟马少平老师学AI】-【神经网络是怎么实现的】(八)循环神经网络

一句话归纳: 1)词向量与句子向量的循环神经网络: x(i)为词向量。h(i)为含前i个词信息的向量。h(t)为句向量。 2)循环神经网络的局部。 每个子网络都是标准的全连接神经网络。 3)对句向量增加全连接层和激活函数。 每个子网络中的参数w、u、v都是一样的,相当于同一个神经网络。 4)不止最后一个子网络可以添加全连接层,每个子网

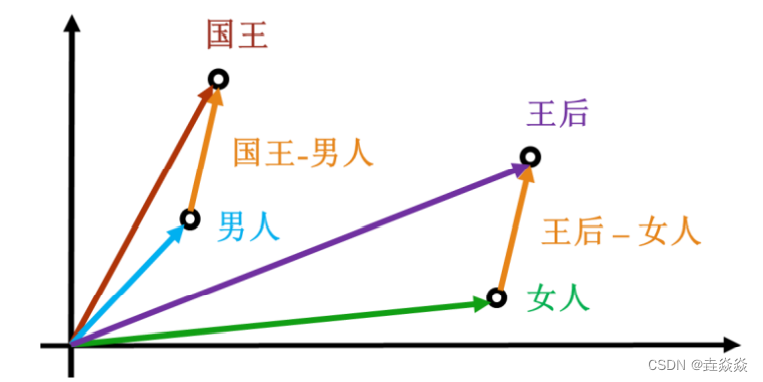

【跟马少平老师学AI】-【神经网络是怎么实现的】(七-1)词向量

一句话归纳: 1)神经网络不仅可以处理图像,还可以处理文本。 2)神经网络处理文本,先要解决文本的表示(图像的表示用像素RGB)。 3)独热编码词向量: 词表:{我,在,清华大学,读书,生活,美丽的,清华园,中}词向量: 清华大学=[0,0,1,0,0,0,0,0] 清华园=[0,0,0,0,0,0,1,0] 美丽的=[0,0,0,0,0,1,0,0] 特点

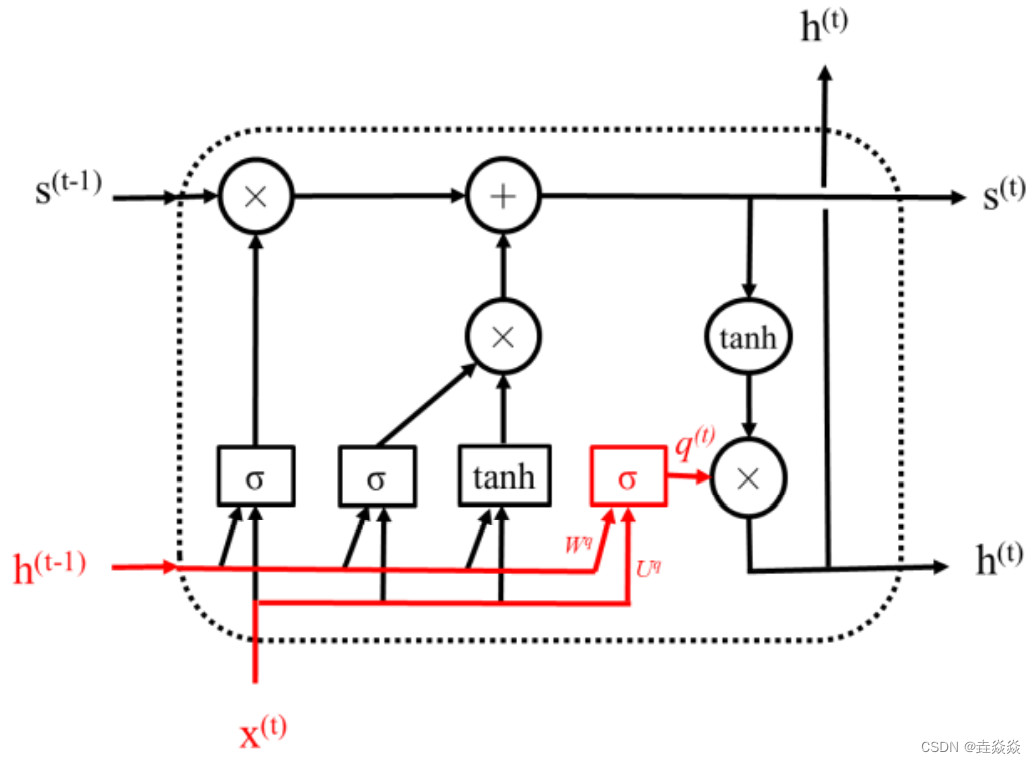

【跟马少平老师学AI】-【神经网络是怎么实现的】(九)长短期记忆网络

一句话归纳: 1)RNN也会存在梯度消失的问题。 2)同一句话,对于不同的任务,句中不同的词起的作用也不一样。 3)LSTM(长短期记忆)子网络: 门,让输入经过运算,得到在[0,1]区间内的输出值。元素S与门的输出进行相乘运算,便可以控制S通过的量。 4)LSTM神经网络: 遗忘门,输入是h(t-1),x(t),输出f(t)。前一个状态s