本文主要是介绍【跟马少平老师学AI】-【神经网络是怎么实现的】(五)梯度消失问题,希望对大家解决编程问题提供一定的参考价值,需要的开发者们随着小编来一起学习吧!

一句话归纳:

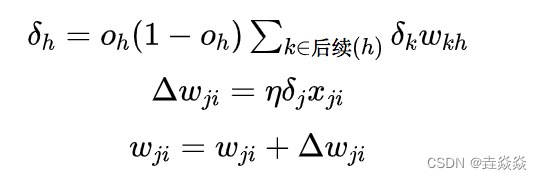

1)用sigmoid激活函数时,BP算法更新公式为:

用sigmoid函数,O取值为0~1,O(1-O)最大值为0.25,若神经网络层数多,则会造成更新项趋近于0,称为梯度消失。

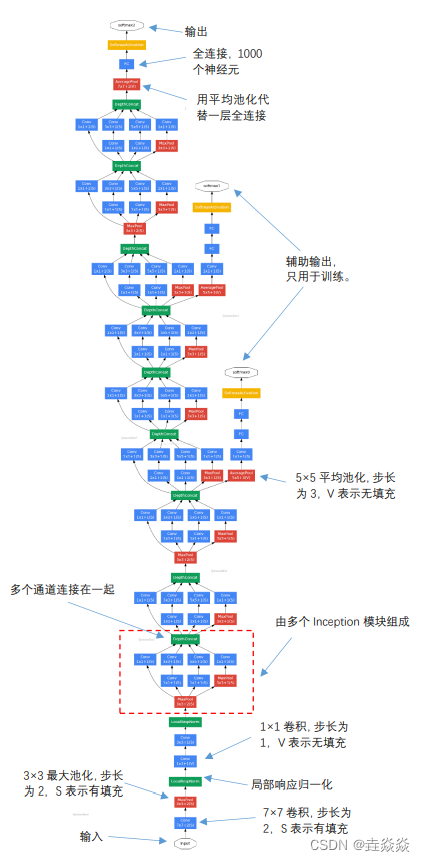

2)GooLeNet解决梯度消失的问题:

- 在不同的深度构造了3个输出。

- inception模块:

- 其中,1*1卷积起到改变维度的作用,减少参数个数,比如,输入为192个通道,经过32个1*1卷积核运算,即可以将通道数降为32。

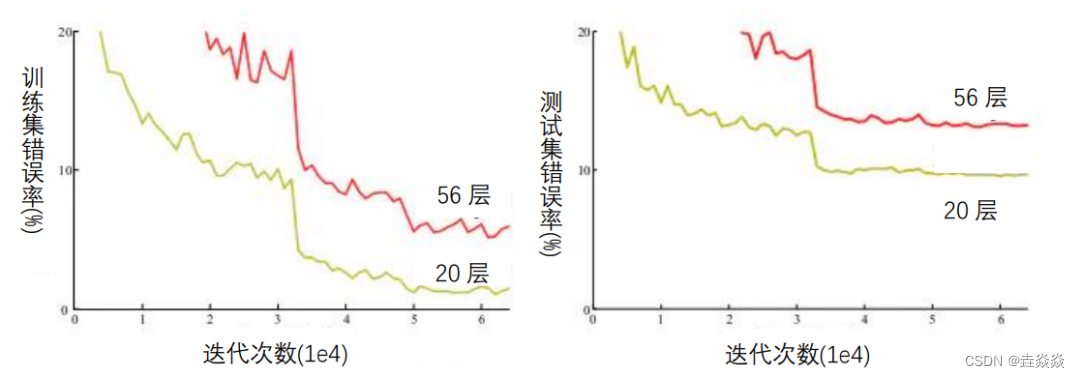

3)神经网络并不完全随着深度的增加提高正确率。

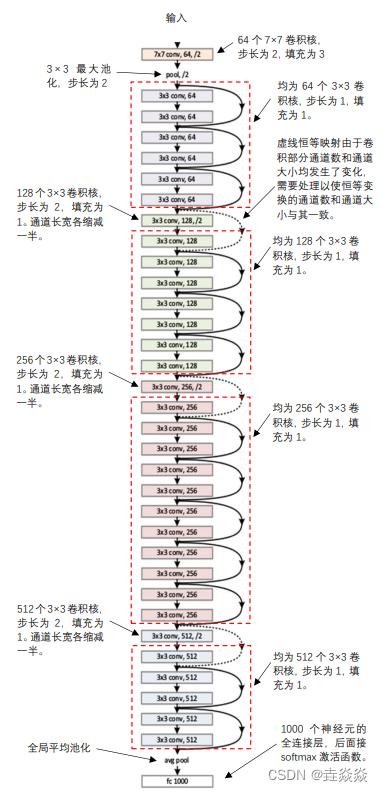

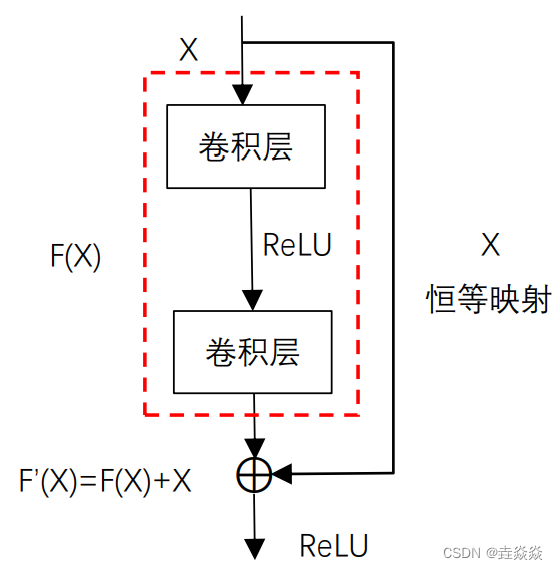

4)残差网络(ResNet):

残差块:

- 通过恒等映射,梯度无衰减传递,消除梯度消失。

- 解决网络退化问题。

- 虚线恒等映射,在恒等映射的基础上,加个卷积层,以和F(X)同等大小、同样通道数的映射。

- 全局平均池化层,经过池化,每个通道变成一个平均数。

这篇关于【跟马少平老师学AI】-【神经网络是怎么实现的】(五)梯度消失问题的文章就介绍到这儿,希望我们推荐的文章对编程师们有所帮助!