本文主要是介绍7、OpenCompass 大模型评测实战(homework),希望对大家解决编程问题提供一定的参考价值,需要的开发者们随着小编来一起学习吧!

基础作业

- 使用 OpenCompass 评测 internlm2-chat-1_8b 模型在 C-Eval 数据集上的性能

0、环境安装

studio-conda -o internlm-base -t opencompass

source activate opencompass

git clone -b 0.2.4 https://github.com/open-compass/opencompass

cd opencompass

pip install -e .pip install -r requirements.txt1、数据准备

cp /share/temp/datasets/OpenCompassData-core-20231110.zip /root/opencompass/

unzip OpenCompassData-core-20231110.zip2、查看支持的数据集和模型

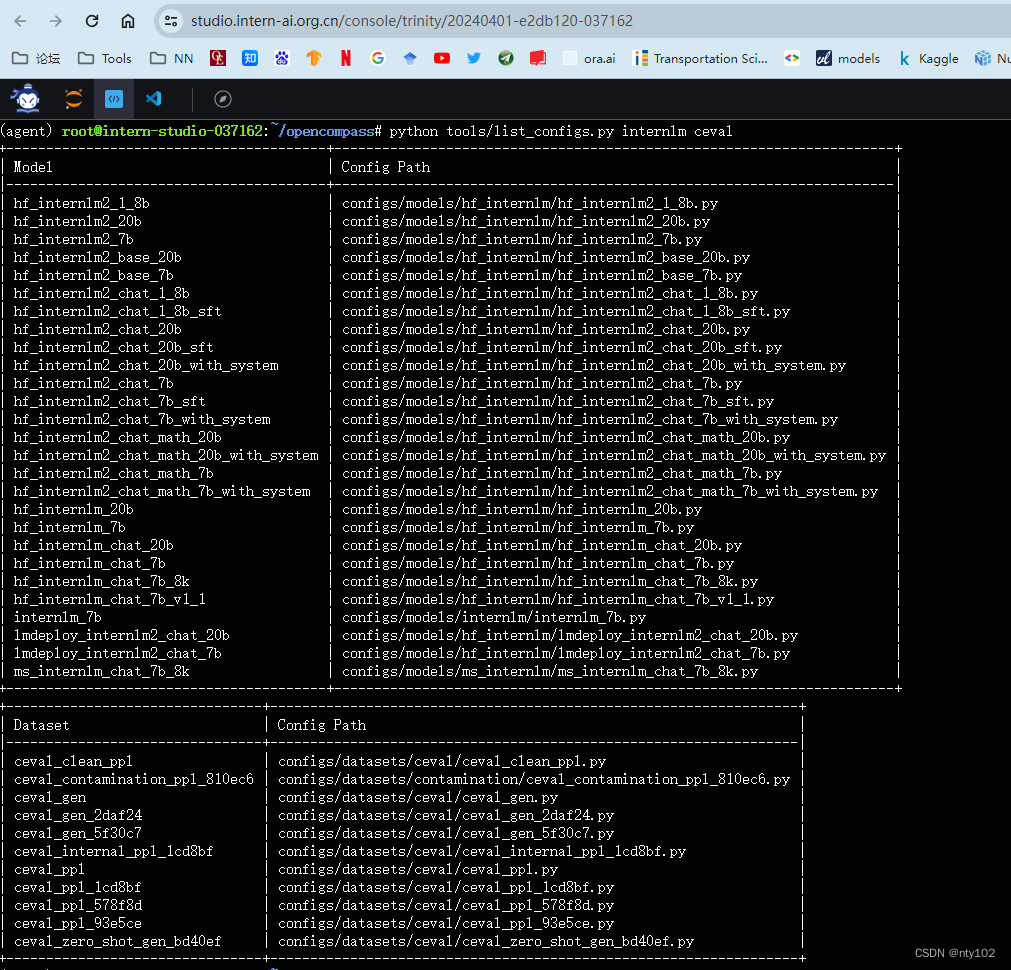

列出所有跟 InternLM 及 C-Eval 相关的配置

python tools/list_configs.py internlm ceval3、启动评测

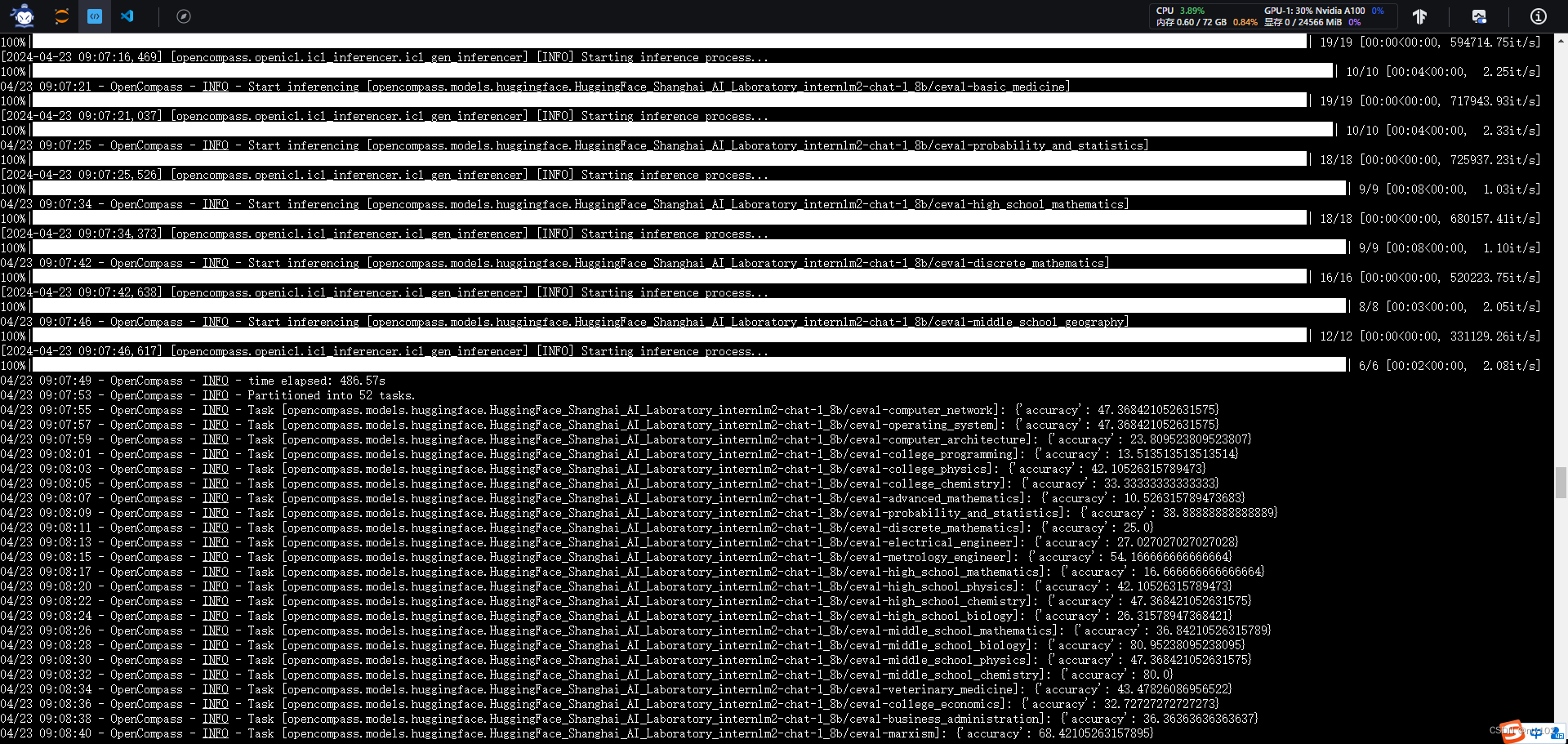

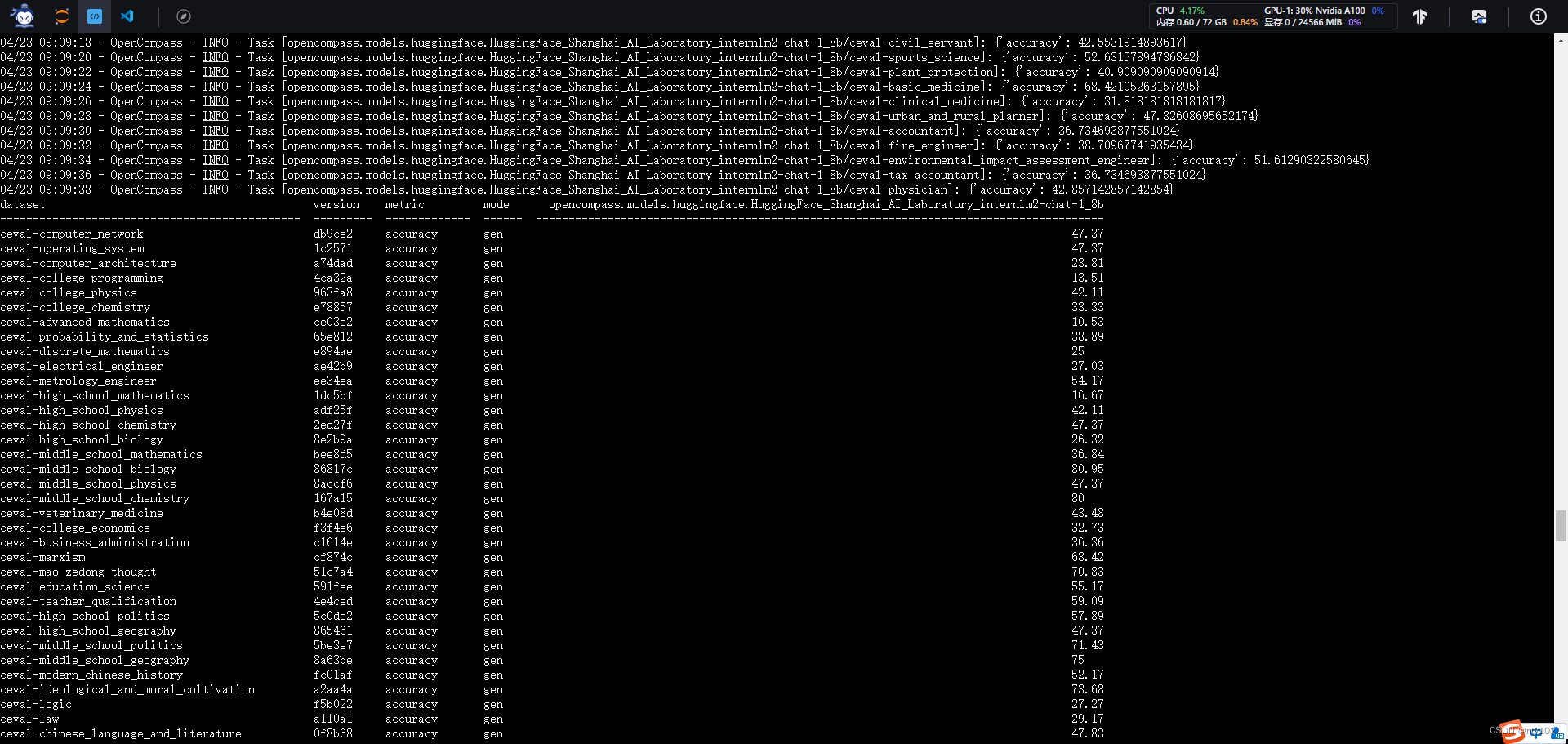

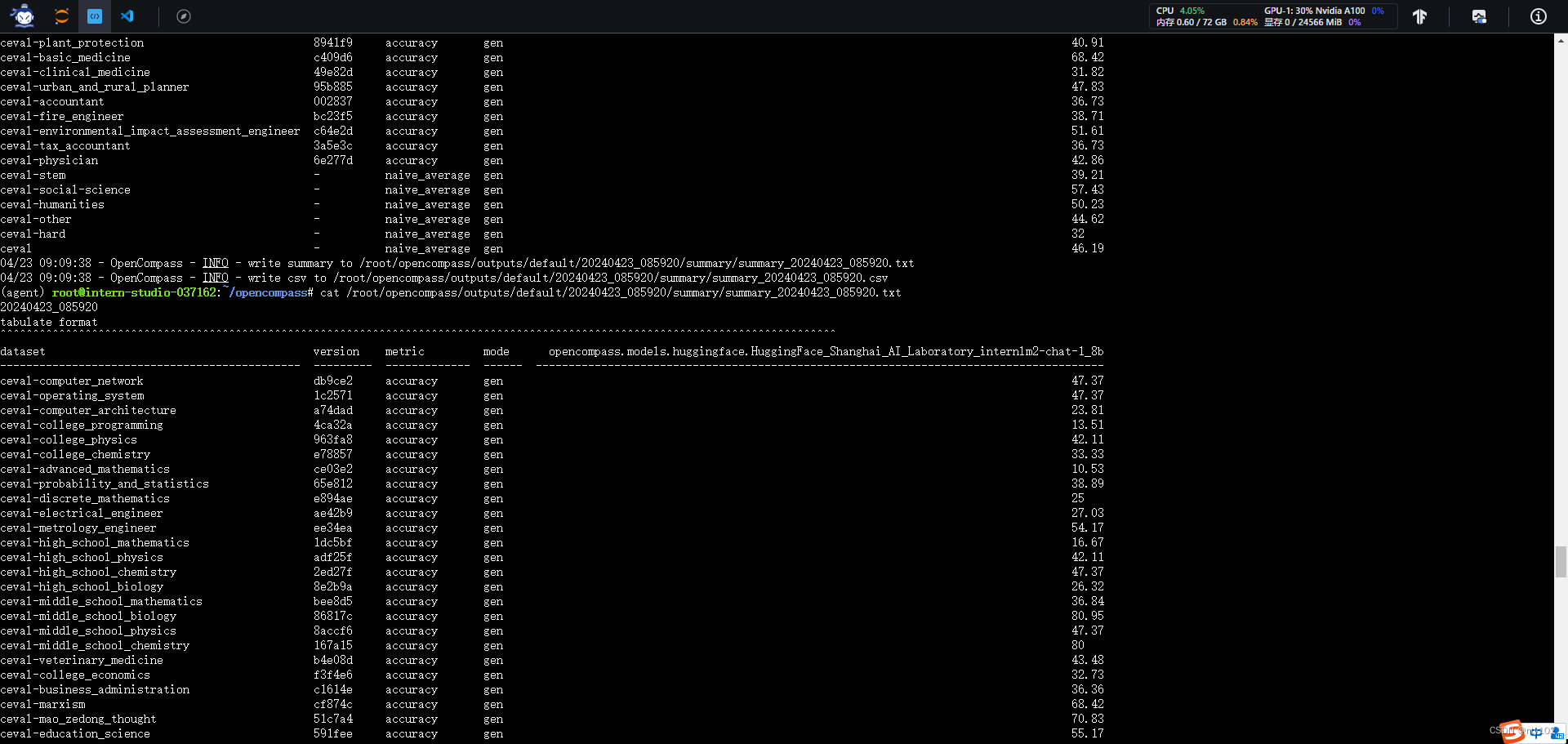

确保按照上述步骤正确安装 OpenCompass 并准备好数据集后,可以通过以下命令评测 InternLM2-Chat-1.8B 模型在 C-Eval 数据集上的性能。由于 OpenCompass 默认并行启动评估过程,我们可以在第一次运行时以 --debug 模式启动评估,并检查是否存在问题。在 --debug 模式下,任务将按顺序执行,并实时打印输出。

python run.py

--datasets ceval_gen \

--hf-path /share/new_models/Shanghai_AI_Laboratory/internlm2-chat-1_8b \ # HuggingFace 模型路径

--tokenizer-path /share/new_models/Shanghai_AI_Laboratory/internlm2-chat-1_8b \ # HuggingFace tokenizer 路径(如果与模型路径相同,可以省略)

--tokenizer-kwargs padding_side='left' truncation='left' trust_remote_code=True \ # 构建 tokenizer 的参数

--model-kwargs device_map='auto' trust_remote_code=True \ # 构建模型的参数

--max-seq-len 1024 \ # 模型可以接受的最大序列长度

--max-out-len 16 \ # 生成的最大 token 数

--batch-size 2 \ # 批量大小

--num-gpus 1 # 运行模型所需的 GPU 数量

--debug

进阶作业

- 将自定义数据集提交至OpenCompass官网

这篇关于7、OpenCompass 大模型评测实战(homework)的文章就介绍到这儿,希望我们推荐的文章对编程师们有所帮助!