本文主要是介绍本地部署 Meta Llama3-8b 和 Llama3-70b,希望对大家解决编程问题提供一定的参考价值,需要的开发者们随着小编来一起学习吧!

本地部署 Meta Llama3-8b 和 Llama3-70b

- 0. 引言

- 1. Meta对Llama 3的目标

- 2. Llama 3的性能

- 3. 下载和安装 Ollama

- 4. 使用 Ollama 运行 Llama3

0. 引言

今天,Meta 正式介绍Meta Llama 3,Meta 开源大型语言模型的下一代产品。

这次发布包括具有80亿(8B)和700亿(70B)参数的预训练和经过指令细化训练的语言模型,可以支持广泛的应用场景。

Llama 3模型将很快在AWS、Databricks、Google Cloud、Hugging Face、Kaggle、IBM WatsonX、Microsoft Azure、NVIDIA NIM和Snowflake上提供,并得到AMD、AWS、Dell、Intel、NVIDIA和Qualcomm提供的硬件平台的支持。

Meta 致力于以负责任的方式发展Llama 3,并提供各种资源帮助他人也能负责任地使用它。这包括随Llama Guard 2、Code Shield和CyberSec Eval 2一起引入的新的信任与安全工具。

在接下来的月份里,Meta 期望推出新的功能、更长的上下文窗口、额外的模型尺寸以及提升的性能,并且Meta 将分享Llama 3的研究论文。 以Llama 3技术构建的Meta AI现已成为世界领先的AI助手之一,能够增强您的智慧并减轻您的负担——帮助您学习、完成任务、创作内容以及连接,以充分利用每一刻。

1. Meta对Llama 3的目标

在Llama 3项目中,Meta致力于打造最佳的开源模型,使其能够与当今可用的最优质的私有模型相媲美。Meta希望解决开发者的反馈,以提高Llama 3的整体帮助度,同时继续在大规模语言模型(LLMs)的负责任使用和部署方面发挥领导作用。Meta拥抱开源精神,即尽早并经常发布中间产品,以便社区能够在这些模型仍然在开发中时获得访问权限。今天Meta发布的基于文本的模型是Llama 3集合中的第一批模型。在不远的将来,Meta的目标是使Llama 3成为一个多语言和多模态的模型,具有更长的上下文记忆力,并在核心LLM能力(如推理和编程)上继续提高整体性能。

2. Llama 3的性能

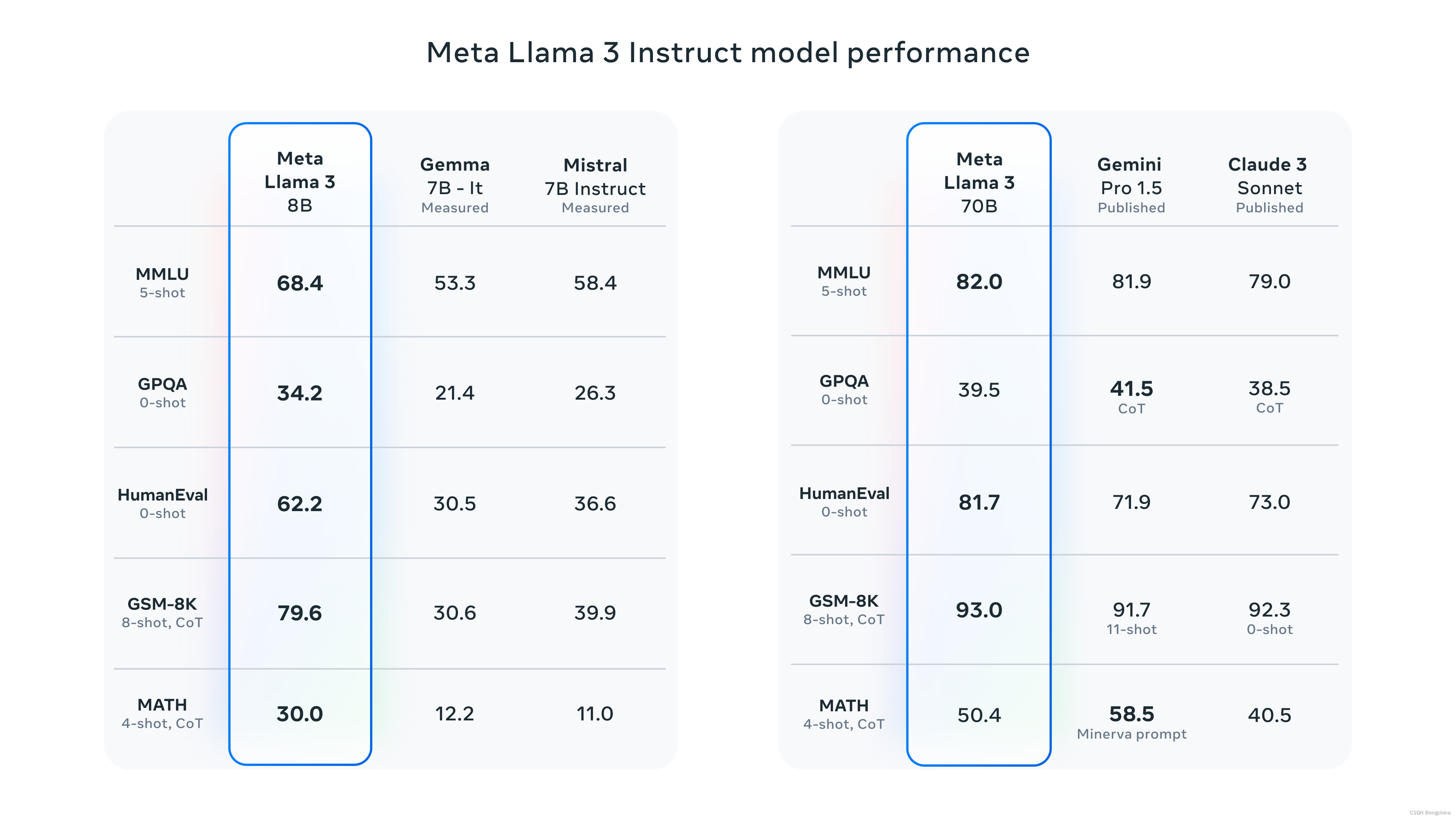

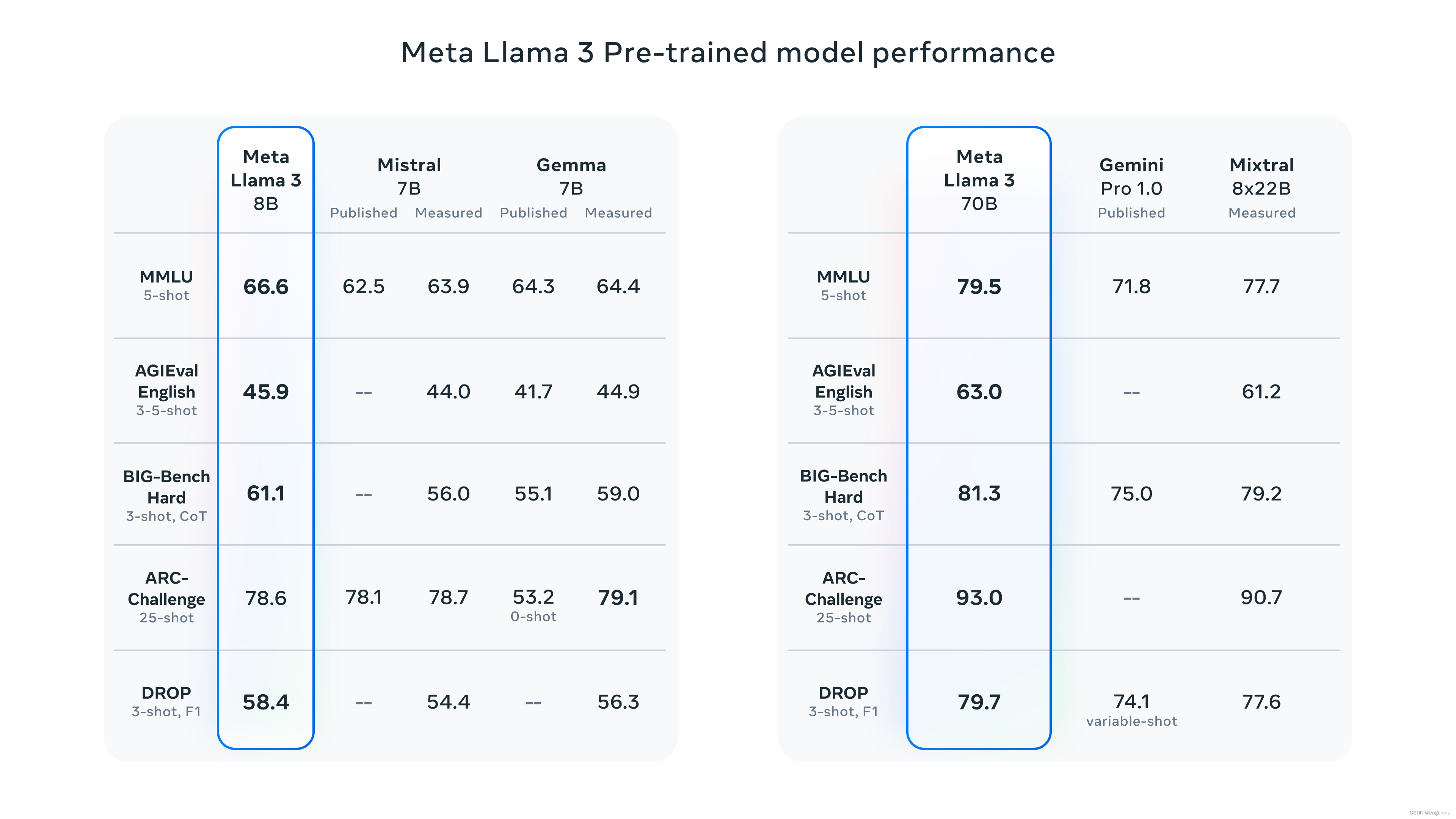

Meta新的80亿和700亿参数的Llama 3模型相对于Llama 2迈出了重大飞跃,并在那些规模上建立了新的LLM模型的最先进水平。感谢Meta在预训练和后训练方面的改进,Meta的预训练模型和基于指令微调的模型是当今最好的存在于80亿和700亿参数规模的模型。Meta在后训练程序中的改进显著降低了错误拒绝率,提高了对齐度,并增加了模型回应的多样性。Meta还看到了像推理、代码生成和指令遵循等能力的显著改善,使得Llama 3更具可操作性。

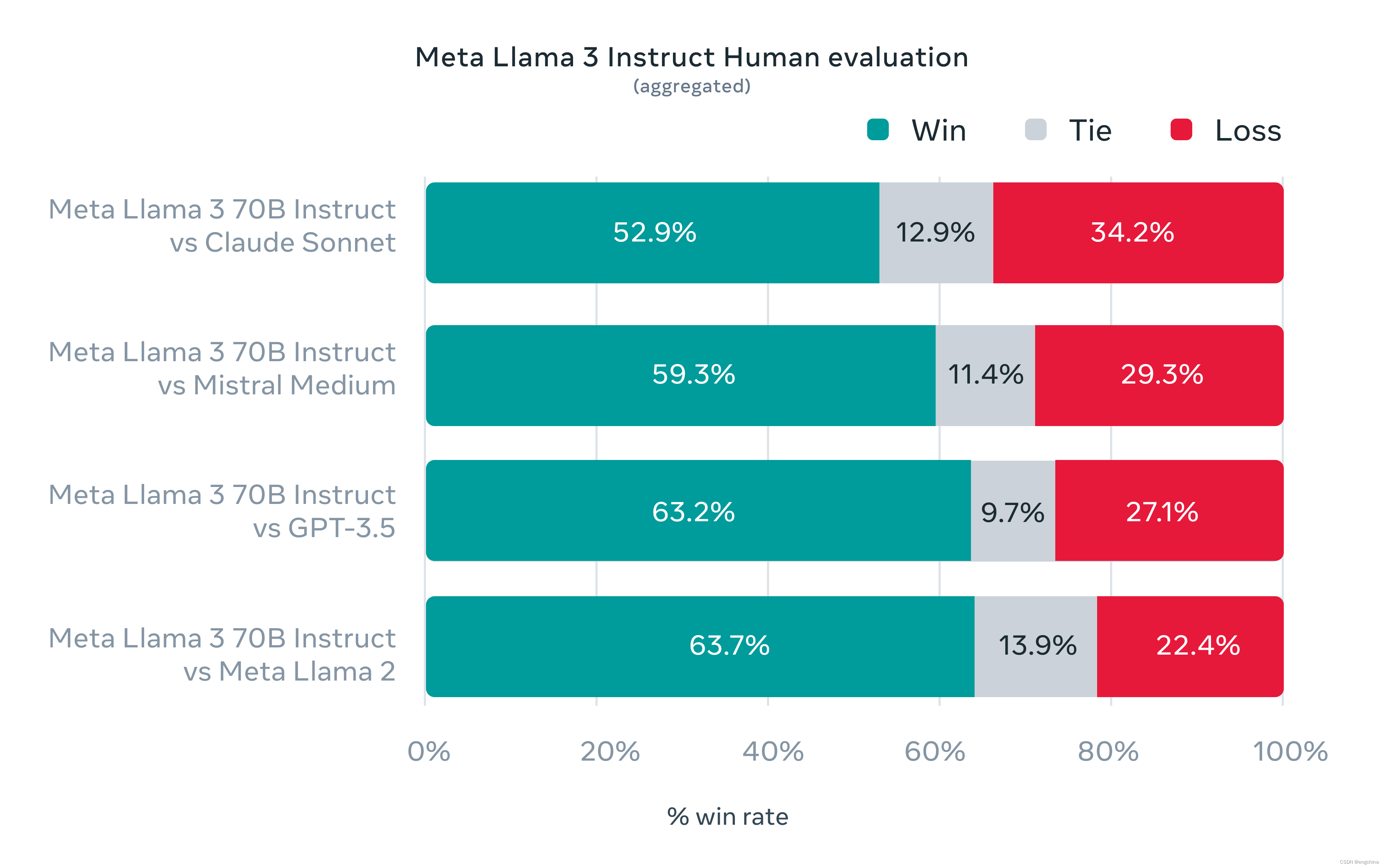

在开发Llama 3的过程中,Meta不仅考察了模型在标准基准测试上的表现,还致力于优化真实场景下的性能。为此,Meta开发了一个新的高质量的人工评估数据集。这个评估数据集包含1800个提示,涵盖了12个关键使用案例:寻求建议、头脑风暴、分类、封闭性问题解答、编程、创意写作、信息提取、扮演角色/人格、开放性问题解答、推理、改写和摘要。为了防止Meta的模型在这个评估数据集上无意中过度拟合,即使是Meta自己的建模团队也没有访问权限。下面的图表展示了Meta的人工评估结果在这些类别和提示 across of these categories and prompts (越过这些类别和提示) aggregated results(汇总结果),与Claude Sonnet、Mistral Medium和GPT-3.5的对比。

人类标注者根据这套评估数据集所做的偏好排名强调了Meta的70B指令遵循模型在与同尺度竞争模型相比的现实场景中表现出色的性能。

我们预训练的模型还在那个规模内为大型语言模型(LLM)设定了新的最先进水平。

3. 下载和安装 Ollama

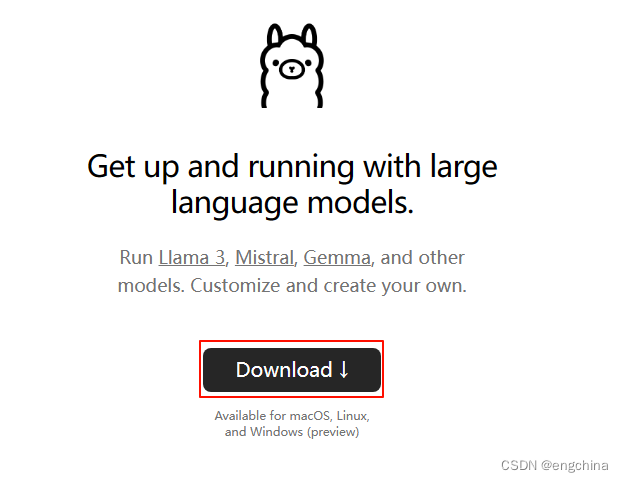

访问 https://ollama.com/,点击 “Download”,

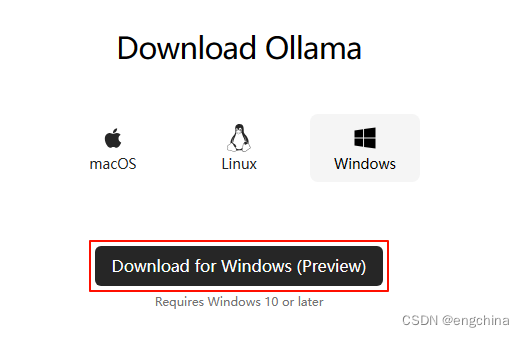

根据你的操作系统,下载相应的版本,例如,“Download for Windows (Preview)”,

双击 “OllamaSetup.exe”,进行安装。

4. 使用 Ollama 运行 Llama3

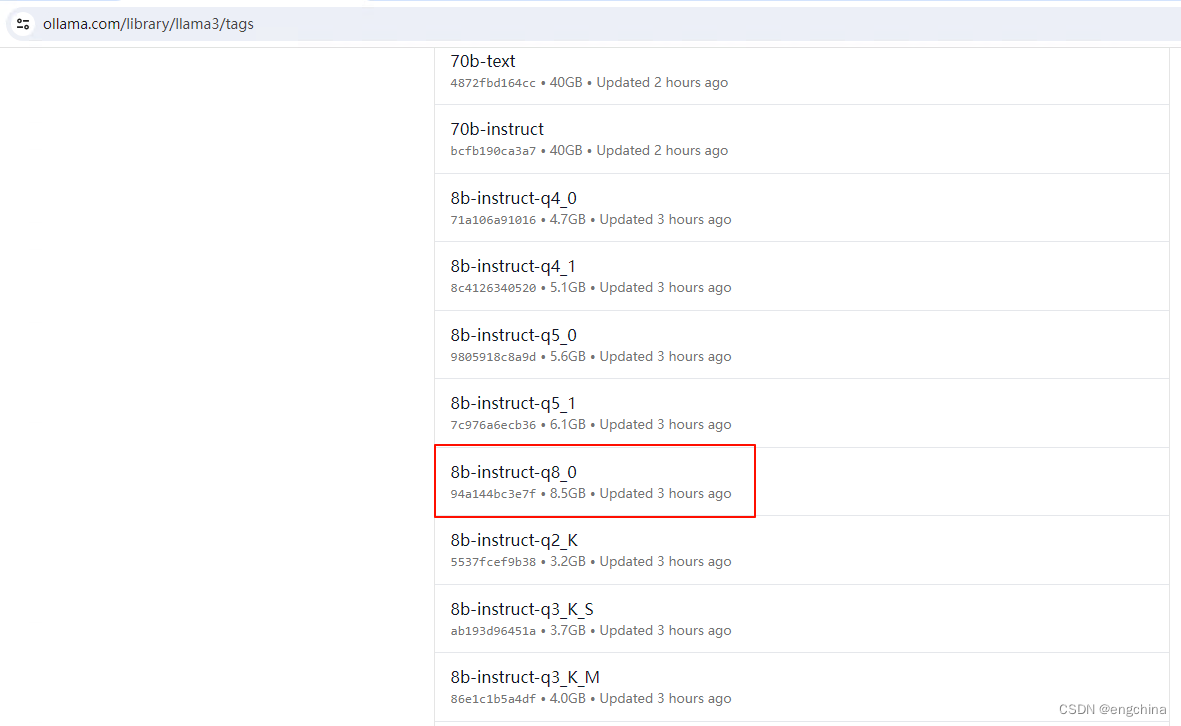

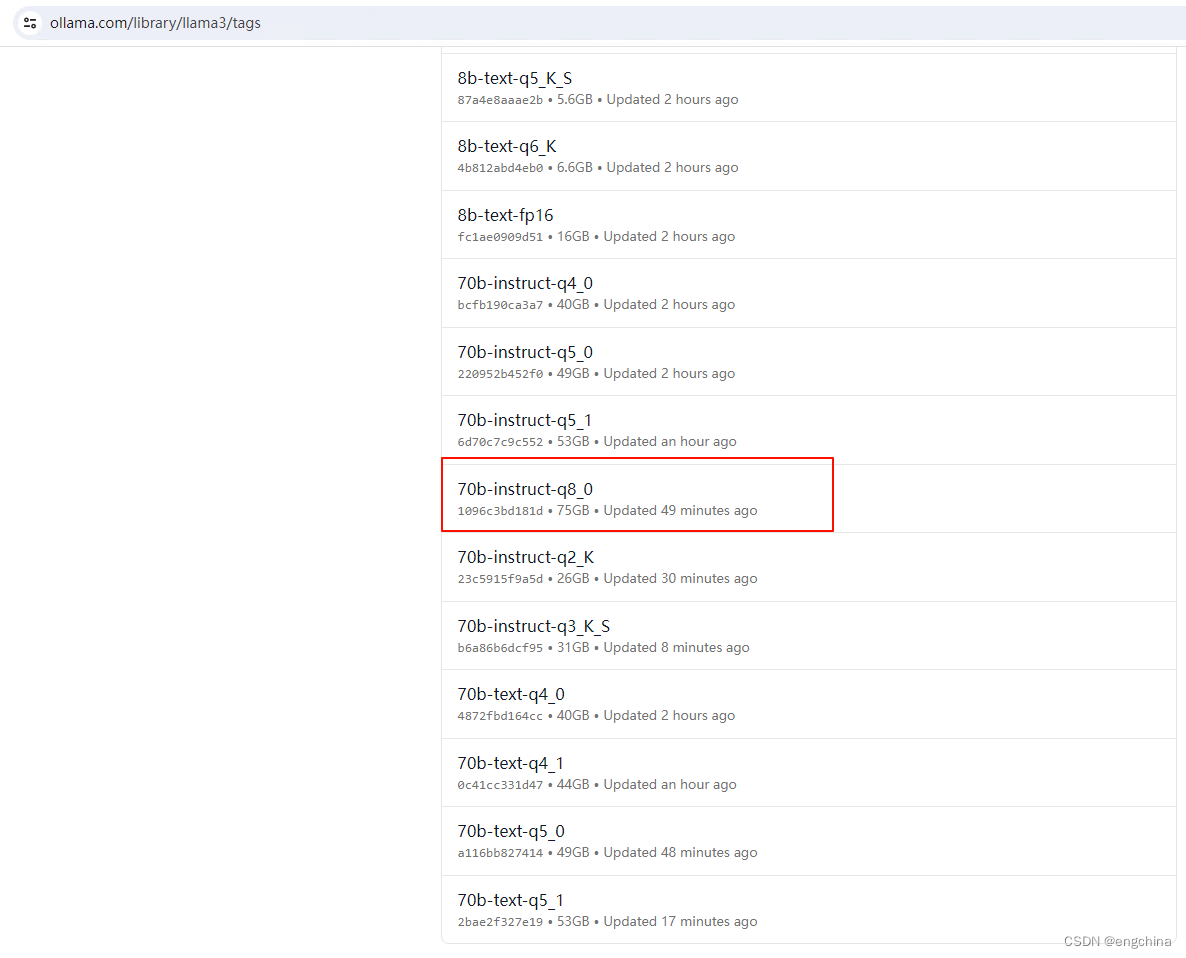

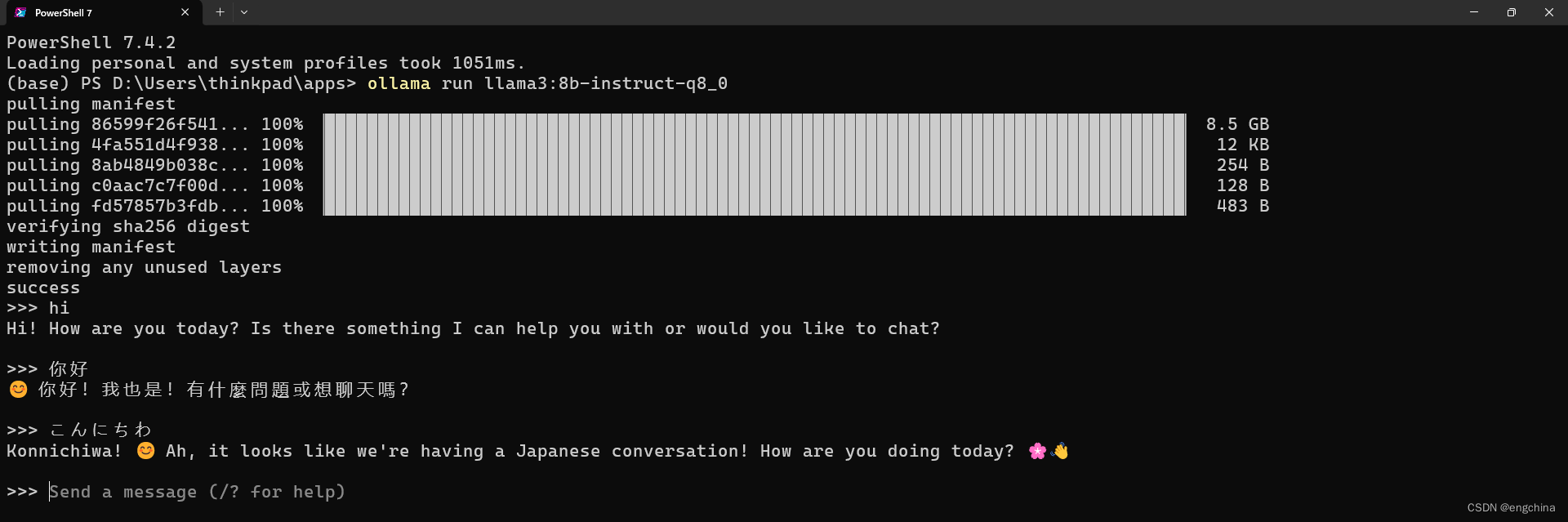

访问 https://ollama.com/library/llama3/tags,选择你想运行的模型,例如,8b-instruct-q8_0 或者70b-instruct-q8_0,

下面以8b-instruct-q8_0为例,拷贝运行命令,ollama run llama3:8b-instruct-q8_0,

Llama3运行起来后,我们就可以和他正常聊天了。

完结!

这篇关于本地部署 Meta Llama3-8b 和 Llama3-70b的文章就介绍到这儿,希望我们推荐的文章对编程师们有所帮助!