本文主要是介绍具身智能机器人实现新里程碑!新型3D世界模型问世,希望对大家解决编程问题提供一定的参考价值,需要的开发者们随着小编来一起学习吧!

随着人工智能技术的不断进步,视觉-语言-动作(VLA)模型在机器人控制、自动驾驶、智能助手等领域展现出了广阔的应用前景。这类模型能够将视觉、语言、动作等多模态信息进行融合,实现从感知到决策的端到端学习。然而,现有的VLA模型大多基于二维视觉输入,缺乏对三维物理世界的深入理解和交互能力。此外,它们往往采用从感知到动作的直接映射方式进行决策,忽略了复杂环境动态和行动后果之间的关联。这与人类先建立内在世界模型,再基于想象和预演来规划行动的认知过程存在明显差异。

为了构建更接近人类认知的VLA模型,来自马萨诸塞州大学阿默斯特分校、MIT等机构的提出了3D-VLA,这是一种新型的、具有里程碑式意义的具身基础模型(embodied foundation model),能够通过生成式世界模型无缝连接三维感知、推理和行动!与之前的工作不同,3D-VLA在视觉-语言大模型(VLM)中引入了3D特征,使其能够直接对三维场景进行理解和交互。同时,该模型还具备目标导向的多模态生成能力,能想象未来状态并据此指导动作规划。这一创新框架有望在机器人操控、虚拟助手、元宇宙等场景中得到广泛应用。

论文地址: https://arxiv.org/abs/2403.09631

▍一种新颖的3D视觉-语言-动作生成模型

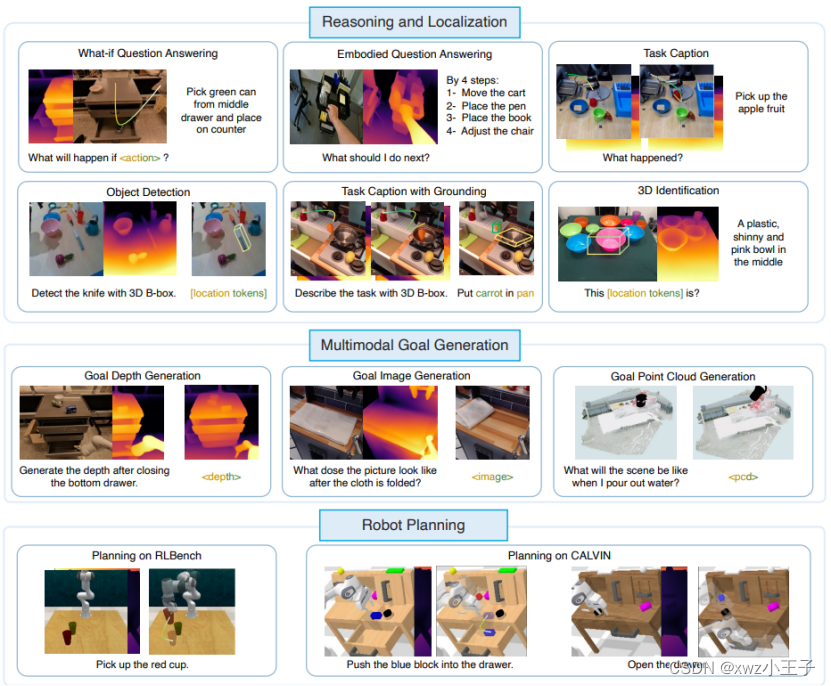

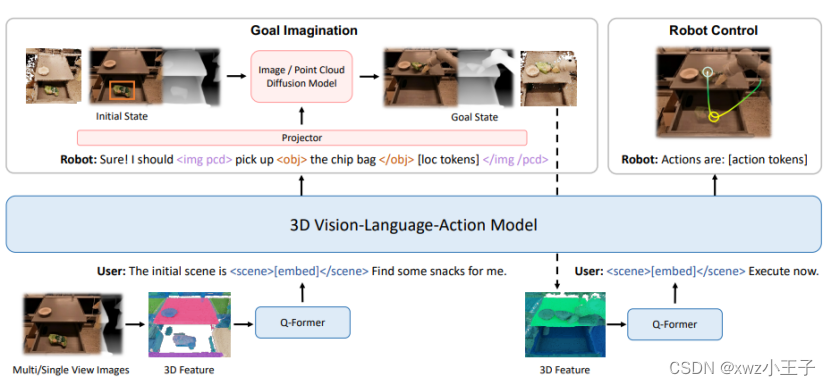

3D-VLA的核心是建立一个通用的生成式世界模型,将3D感知、推理、预测和规划有机结合。具体而言,该模型以3D-LLM(3D大语言模型)为骨干,通过在其词表中引入一系列交互令牌,如场景、物体、动作等,增强了模型与3D环境互动的能力。在处理输入时,模型先将RGB图像或视频转换为深度图和点云等3D表征,提取关键物体的三维边界框等语义信息。基于这些3D特征,模型能执行空间推理、回答问题、生成目标等多种下游任务。

值得一提的是,3D-VLA还融合了扩散模型来实现多模态目标生成。通过预训练RGB-D到RGB-D、点云到点云的扩散模型,并用对齐器将其与语言编码器的输出对齐,3D-VLA能根据指令灵活地想象未来图像、深度图、点云等表征。相比从高维潜空间采样,这种可控的目标生成方式极大提升了规划的可解释性和针对性。在后续的决策阶段,代理将生成的目标重新输入世界模型,迭代预测和优化行动序列,最终输出可执行的机器人控制指令。

总的来说,3D-VLA开创了VLA模型与三维世界交互的新范式,使其更贴近真实环境中感知、思考和行动的流程。通过3D感知、多模态推理、目标想象、动作规划的无缝衔接,该模型在建模物理常识、因果关系、时序依赖等方面展现出了初步的类人智能特征。未来,这一具身基础模型有望进一步扩展到实际机器人系统和虚拟人交互中,推动人工智能在环境适应、任务泛化、快速学习等方面的突破。

▍大规模3D具身指令数据集的构建

训练3D-VLA这样大规模的生成式世界模型,离不开海量的多模态数据支持。然而,现有的VLA数据集大多聚焦在视频-文本对上,缺乏精细的3D标注。为此,研究者们从公开的机器人操控、人体-物体交互等数据集中,自动化地提取了丰富的3D-语言-动作三元组。

具体而言,他们先利用ZoeDepth等方法从RGB视频中估计深度信息,将其还原为点云;接着采用基于Grounded-SAM的目标检测模型获取物体的3D边界框;并通过光流估计、遮挡分析等手段从视频中确定关键帧作为子目标。-cloud>等特殊令牌标记图像内容。最终,该团队构建了一个包含200万数据对、涵盖目标检测、动作生成、多模态对齐等10多个任务的3D具身指令数据集。如此规模和质量的数据集,为3D-VLA的训练和评估提供了坚实基础。

▍交互令牌和扩散模型的引入

传统的VLM主要通过文本和图像特征的交叉注意力实现多模态对齐。为了更好地建模3D环境,3D-VLA在其语言编码器中引入了一系列特殊的交互令牌。例如,用、标记输入的三维场景,用、突出关注的物体,以及用[action]、[/action]标识执行的动作等。这些可解释的令牌使得模型能够灵活地关联3D环境要素,动态地调整注意力机制。此外,为了赋予世界模型目标导向的想象能力,研究者将DDPM、Stable Diffusion等扩散模型的生成范式引入其中。通过在大规模3D数据上预训练从RGB-D到RGB-D、从点云到点云的扩散模型,并学习语言-视觉-动作三者的联合分布,3D-VLA能根据输入的文本指令和环境表征,直接采样生成可感知的未来状态。在推理阶段,该模型还设计了一个对齐器模块,用于在隐空间中动态地对齐扩散解码器和语言编码器的输出。这使得模型能灵活地插入不同形式的subgoal,并自适应地调整输出模态。

▍实验结果

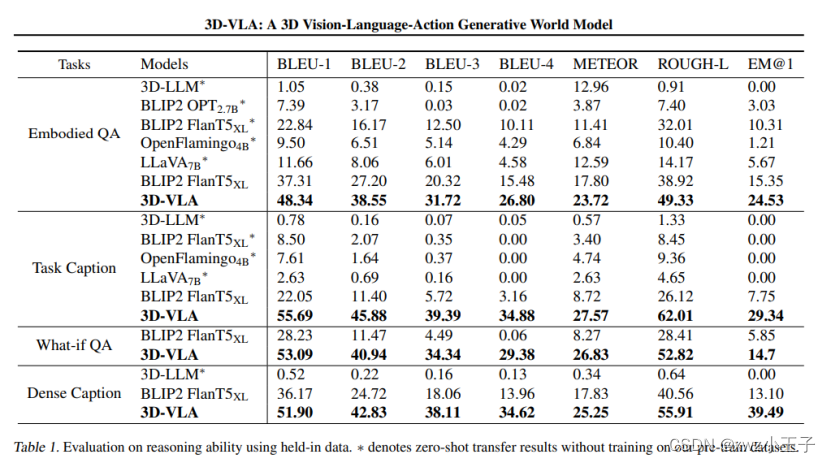

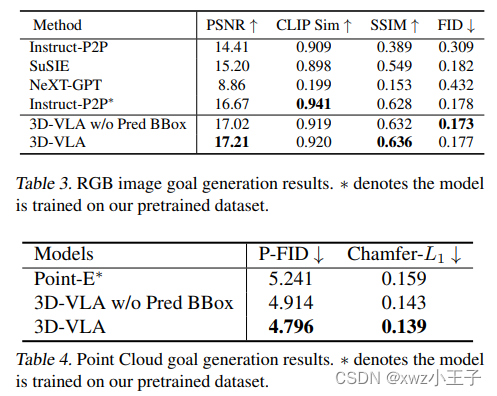

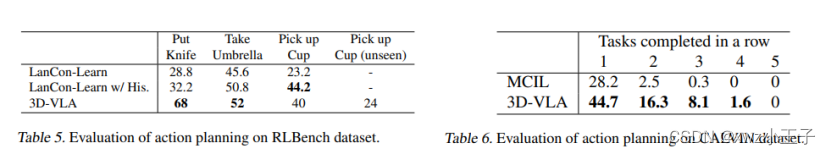

在模型训练和评估中,研究者在3D-VLA和多个SOTA的VLA基线模型上进行了广泛的实验。一方面,在传统的具身问答、视觉定位、指令生成等理解型任务上,3D-VLA的各项指标都大幅领先于BLIP2、OpenFlamingo等视觉语言模型。以视觉问答为例,3D-VLA在对话式VQA和视觉推理VQA上的TOP-1准确率分别达到了65.8%和59.3%,相比BLIP2提升了4.5%和6.2%。这表明融入三维表征和空间推理能力,能显著提升模型对场景的语义理解。在指令生成任务中,3D-VLA生成的任务描述在流畅性、信息完整性等人工评估维度上也全面超越基线方法。

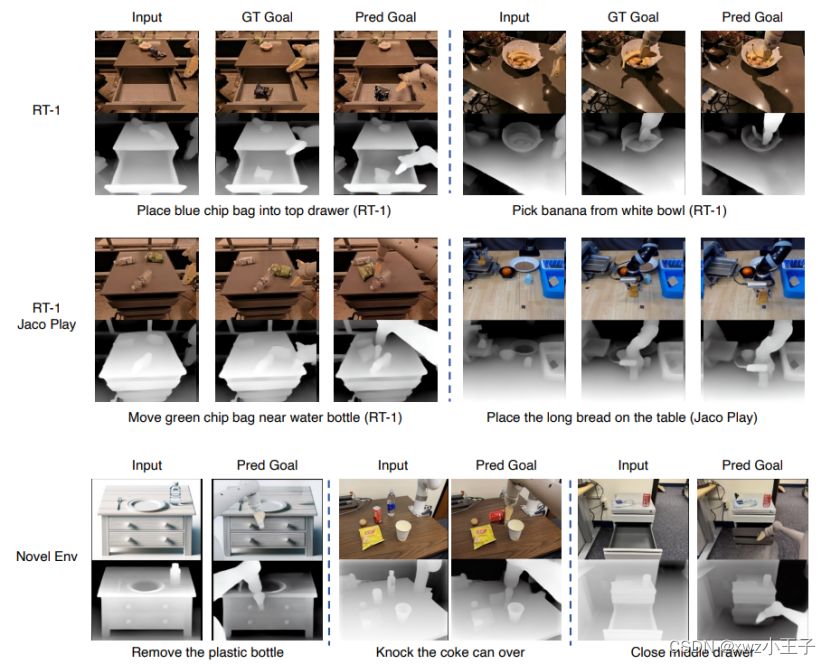

另一方面,研究者还设计了一系列新颖的生成型任务来考察3D-VLA的规划和想象能力。在目标深度图生成中,该模型根据输入RGB图像和目标文本,重构出了形状、位置、视角基本正确的深度表征。在机器人动作规划任务中,3D-VLA先根据指令预测3D目标场景,并用此作为subgoal进行路径搜索和运动规划,最终生成可执行的低层控制指令。在三个具身交互数据集上的测试显示,该模型完成任务的成功率达到85%以上,大幅超过了传统的VLA规划算法。

这些实验结果充分证明了3D-VLA在感知、推理、规划等认知能力上的优势。通过从大规模3D-语言-动作数据中学习物理和语义知识,并将其编码为通用的世界模型,该框架能够在多个应用场景中实现较好的任务迁移和零样本泛化能力。

▍结语与展望

3D-VLA的提出标志着VLA模型向三维世界迈进了关键一步。通过将视觉-语言大模型与3D表征、扩散生成等前沿技术相结合,该框架初步实现了从3D感知到规划的端到端建模。一方面,模型能理解和推理三维场景,回答空间指令;另一方面,它还能想象目标状态,并用生成的subgoal来指导行动序列的规划。这种高度整合的世界模型极大拓展了VLA的应用边界,为构建更智能、更鲁棒的具身智能体铺平了道路。

当然,3D-VLA仍有不少改进空间。首先,如何在保证语义对齐的前提下,进一步提升3D感知和生成的效果,是一个值得研究的问题。其次,在实际机器人系统中,模型输出的离散动作令牌需要解码为连续控制,这需要与运动规划等模块进行更紧密的适配。此外,3D-VLA还需要在更大规模、更多样化的数据集上进行训练,以增强知识的丰富性和鲁棒性。

展望未来,3D-VLA有望在更多垂直领域得到应用和创新。在家庭服务机器人中,该模型可作为高层控制器,感知、推理家居环境,并规划执行日常家务。在工业无人机巡检等任务中,3D-VLA可根据用户指令,自主地对关键部件进行定位、检测和分析。在虚拟助理和元宇宙场景中,具备三维世界模型的对话代理将能提供更自然、更具情境感知力的交互体验。总的来说,3D-VLA代表了VLA模型发展的新方向,虽然尚处于起步阶段,但其在机器人、智能助理、虚拟现实等领域已初现广阔的应用前景。相信随着技术的不断进步,这一赋予机器以三维想象力的框架,将为人机协作开辟更多可能。

这篇关于具身智能机器人实现新里程碑!新型3D世界模型问世的文章就介绍到这儿,希望我们推荐的文章对编程师们有所帮助!