本文主要是介绍Science Robotics 逼真面部表情的机器人,希望对大家解决编程问题提供一定的参考价值,需要的开发者们随着小编来一起学习吧!

人类可以产生数千种不同的面部表情来传达无数微妙的情绪状态,这种能力是人类社会互动中最有效和最有效的界面之一。在 2019 年冠状病毒病流行期间,口罩使社交互动变得尴尬,因为它们掩盖了面部表情。同时,当摄像机打开时,远程会议变得更加有效。同样,一旦机器人能够展现出丰富的三维(3D)面部表情,它们就可以增强他们的沟通能力,更有利于与人类建立信任。

当前大型语言模型正在推动机器人语言交流的快速发展,但非语言交流却没有跟上步伐。物理人形机器人主要依靠语音,难以使用面部运动进行表达和交流。这里的挑战是有两个方面:首先,驱动一个富有表现力的多功能机器人面部在机械上具有挑战性。第二个挑战是知道要生成什么表情,以便机器人看起来自然、及时和真实。

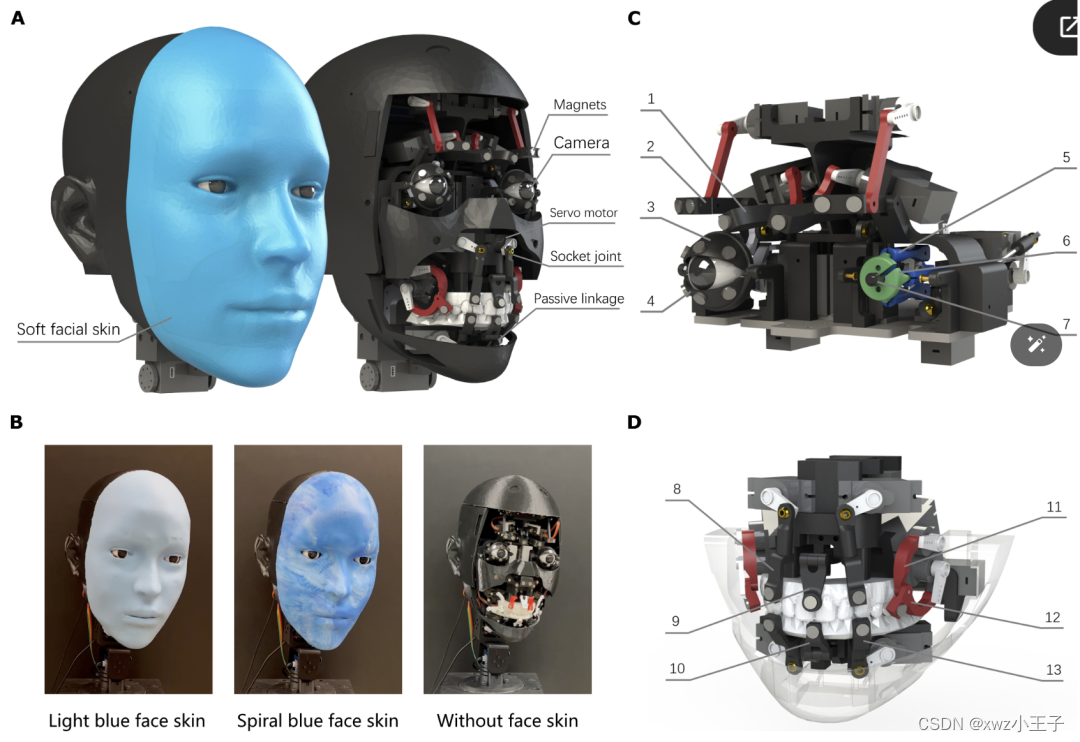

近期哥伦比亚大学研制了拟人表情的机器人。它有 26 个驱动器和可互换的柔软面部皮肤。整个面部皮肤由硅胶制成,并使用 30 块磁铁连接到机器人硬件上。机器人面部皮肤可以用替代设计代替,以获得不同的外观和皮肤维护。

眼部模块控制眼球、眉毛和眼睑的运动。每个眼框都配有高分辨率RGB摄像头。眼架由两个电机通过两个俯仰和偏航轴的平行四边形机构分别驱动。这种设计的优点是它在眼框的中心创造了更多的空间,能够将相机模块安装在与人类瞳孔相对应的自然位置。这种设计促进了机器人和人类之间更自然的面对面互动。

嘴巴的运动很复杂。虽然大多数电子动画机器人的面部通常只表现出简单的下颌运动,但我们的目标是通过机械结构复制人类嘴唇的复杂运动。为了解决这一挑战,设计了几种被动接头和连杆,以便在机器人嘴移动时,柔软的皮肤可以在机械结构的被动自由度上弯曲,形成复杂而自然的变形。口部有9条运动链。其中六个具有被动关节控制上唇和下唇。两个五连杆控制嘴角的运动,最后的连杆机构控制下颌的运动。

进一步提出了一个自我监督的学习过程来训练面部机器人生成人类的面部表情,而无需明确的动作编排。在该方法中,机器人可以通过在镜子中观察自己来学习运动命令与由此产生的面部表情之间的关系。

研究发现,机器人可以在人类微笑前约839毫秒学习预测即将到来的微笑,并使用学习的逆运动学面部自我模型,与人类同时表达微笑。使用包含 26 个自由度的机器人面部展示了这种能力,这种表达面部表情的能力可以改善人机交互。

这篇关于Science Robotics 逼真面部表情的机器人的文章就介绍到这儿,希望我们推荐的文章对编程师们有所帮助!