本文主要是介绍基于深度学习的海洋鱼类识别算法matlab仿真,希望对大家解决编程问题提供一定的参考价值,需要的开发者们随着小编来一起学习吧!

目录

1.算法运行效果图预览

2.算法运行软件版本

3.部分核心程序

4.算法理论概述

5.算法完整程序工程

1.算法运行效果图预览

2.算法运行软件版本

MATLAB2022a

3.部分核心程序

............................................................

% 对测试集进行分类预测

[Predicted_Label, Probability] = classify(net, Resized_Testing_Dataset);

% 计算分类准确率

accuracy = mean(Predicted_Label == Testing_Dataset.Labels);

% 随机选择一些图像进行可视化

index = randperm(numel(Resized_Testing_Dataset.Files), 50);

figurefor i = 1:25subplot(5,5,i)I = readimage(Testing_Dataset, index(i));% 从测试数据集中读取图像imshow(I)% 预测的标签label = Predicted_Label(index(i));% 显示预测的标签和置信度if double(label)==1name='鱼类1';end if double(label)==2name='鱼类2';end if double(label)==3name='鱼类3';end if double(label)==4name='鱼类4';end if double(label)==5name='鱼类5';end title(name);

endfigurefor i = 1:25subplot(5,5,i)I = readimage(Testing_Dataset, index(i+25));% 从测试数据集中读取图像imshow(I)% 预测的标签label = Predicted_Label(index(i+25));% 显示预测的标签和置信度if double(label)==1name='鱼类1';end if double(label)==2name='鱼类2';end if double(label)==3name='鱼类3';end if double(label)==4name='鱼类4';end if double(label)==5name='鱼类5';end title(name);

end

1174.算法理论概述

深度学习在海洋鱼类识别中常采用卷积神经网络(Convolutional Neural Networks, CNNs)。CNN由多个层级组成,包括卷积层、池化层、全连接层以及分类层。典型流程如下:

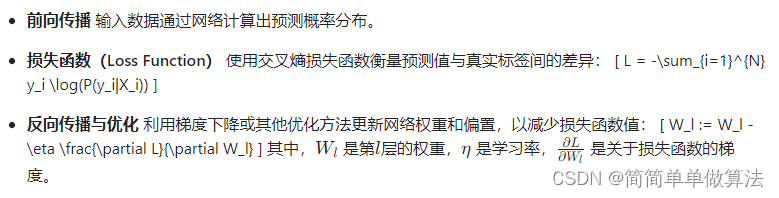

训练CNN的过程涉及前向传播、损失计算和反向传播:

为了提高模型性能,常常采用数据增强技术(如旋转、翻转、裁剪等)增加训练样本多样性。此外,也可利用预训练模型进行迁移学习,如在ImageNet上预训练的ResNet、VGG等网络作为基础模型,针对特定的海洋鱼类识别任务微调顶层网络参数。

模型训练完成后,在验证集和测试集上进行评估,常用的评估指标包括准确率、精确率、召回率以及F1分数等。

综上所述,基于深度学习的海洋鱼类识别算法主要通过构建和训练深度卷积神经网络,从大量标注的海洋鱼类图像中学习特征,进而对未知图像进行准确的鱼类种类识别。这个过程涉及到复杂的数学运算和优化策略,体现了深度学习在图像识别领域的强大能力。

5.算法完整程序工程

OOOOO

OOO

O

这篇关于基于深度学习的海洋鱼类识别算法matlab仿真的文章就介绍到这儿,希望我们推荐的文章对编程师们有所帮助!