本文主要是介绍思维线索(Thread of Thought)-ThoT梳理混乱的语境,希望对大家解决编程问题提供一定的参考价值,需要的开发者们随着小编来一起学习吧!

Thread of Thought Unraveling Chaotic Contexts

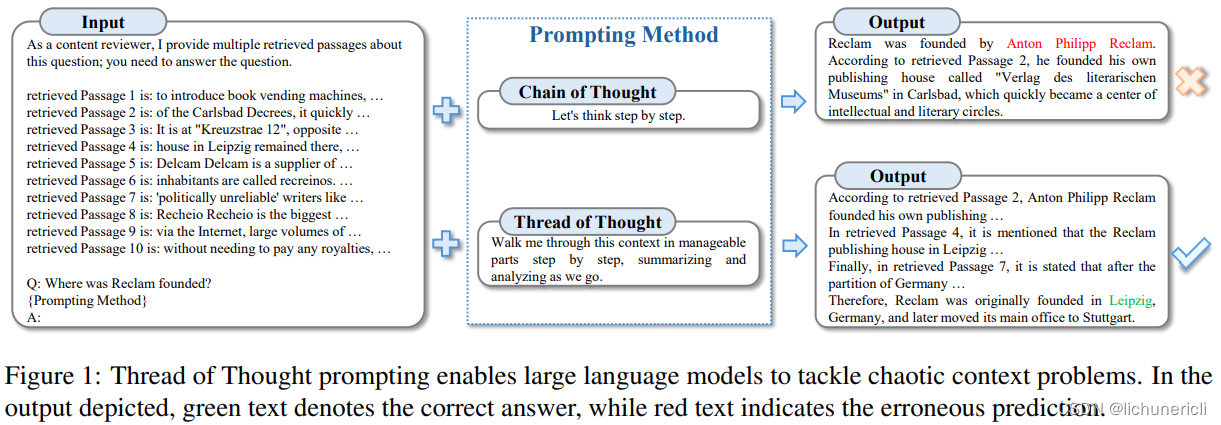

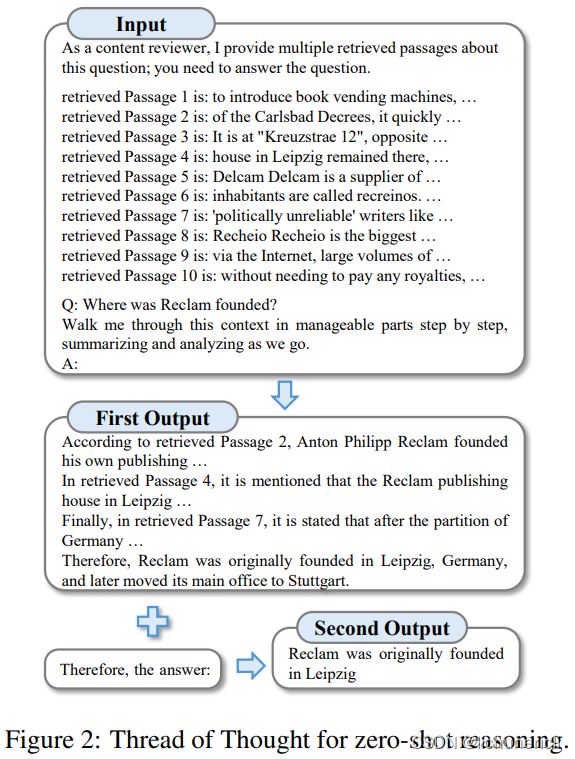

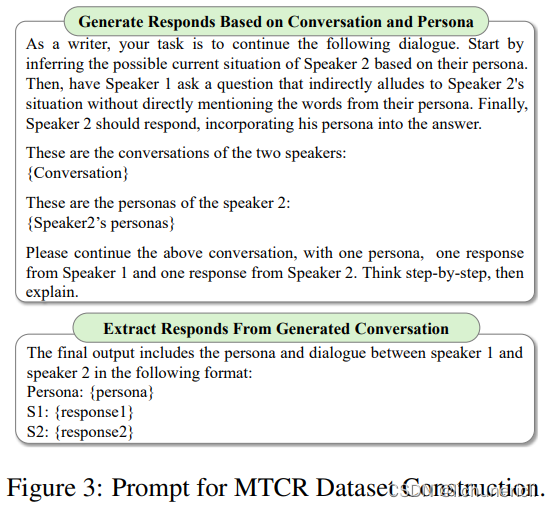

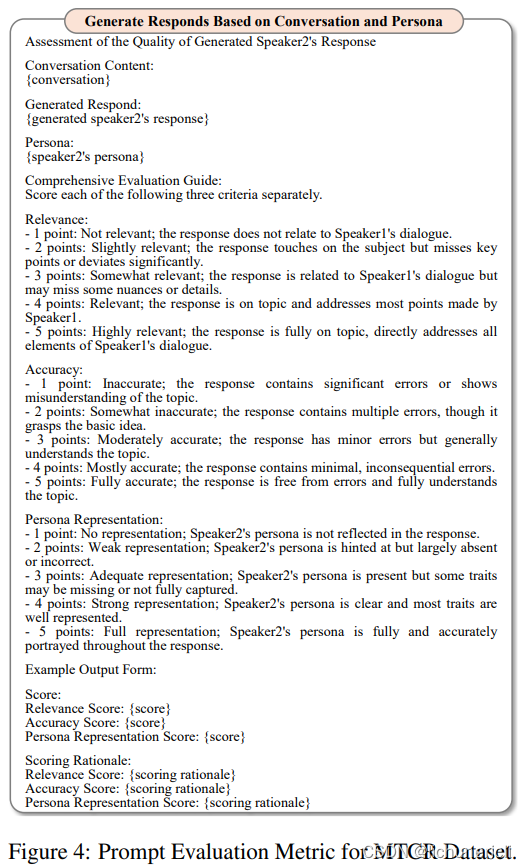

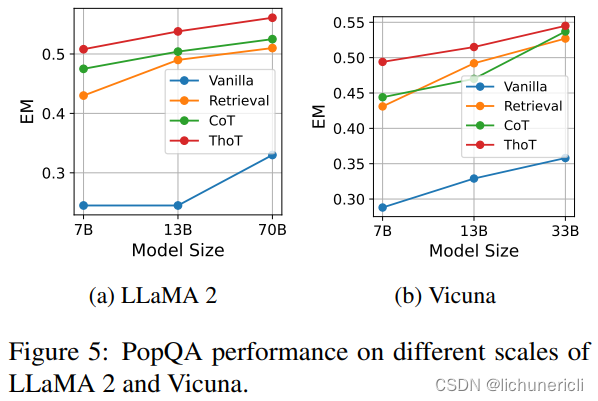

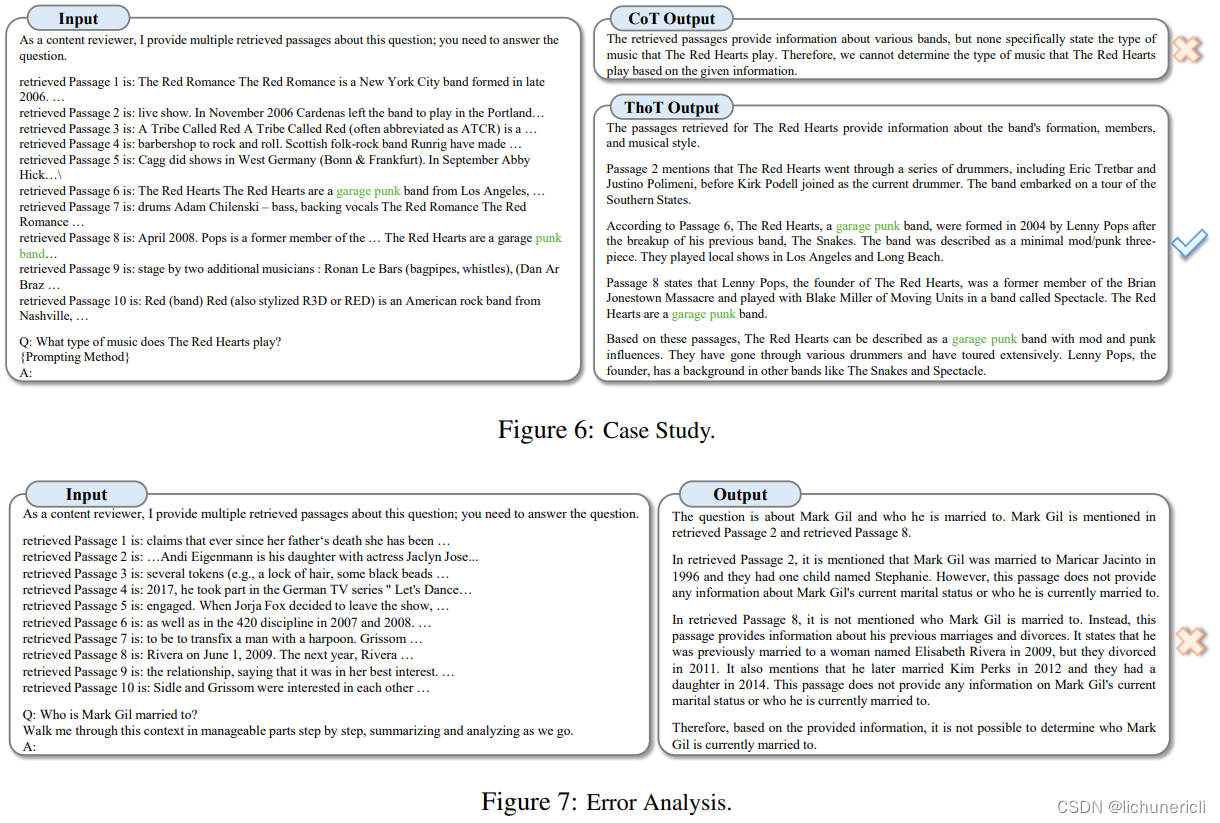

大型语言模型(LLMs)在自然语言处理领域开启了一个变革的时代,在文本理解和生成任务上表现出色。然而,当面对混乱的上下文环境(例如,干扰项而不是长的无关上下文)时,它们会遇到困难,导致无意中忽略了混乱上下文中的某些细节。为了应对这些挑战,我们引入了“思维线索”(Thread of Thought,ThoT)策略,该策略受到人类认知过程的启发。ThoT策略能够系统地分段和分析扩展的上下文,同时巧妙地选择相关信息。这个策略作为一个多功能的“即插即用”模块,可以与各种LLMs和提示技术无缝集成。在实验中,我们使用了PopQA和EntityQ数据集,以及我们收集的多轮对话响应数据集(MTCR),来说明ThoT策略在推理性能上显著优于其他提示技术。

本文提出了一种名为“思维线索”(Thread of Thought,ThoT)的新策略,旨在提高大型语言模型(LLMs)在处理混乱上下文信息时的性能。ThoT受人类认知过程的启发,显著提升了LLMs分段和分析扩展上下文的能力。我们将ThoT与现有方法进行了比较,后者通常需要复杂的重新训练、微调,或者在处理大量复杂信息时存在局限性。相比之下,ThoT提供了一个更为直接和高效的解决方案。它作为一个“即插即用”的模块,可以与各种预训练的语言模型和提示策略无缝集成,无需复杂的程序。ThoT的有效性通过使用长尾问答数据集(如PopQA和EntityQ)以及基于日常对话的多轮对话响应数据集进行了严格测试。这些评估的结果是明确的:ThoT不仅在处理混乱上下文方面表现出色,而且还增强了LLMs的推理能力。

这篇关于思维线索(Thread of Thought)-ThoT梳理混乱的语境的文章就介绍到这儿,希望我们推荐的文章对编程师们有所帮助!

![[机缘参悟-222] - 系统的重构源于被动的痛苦、源于主动的精进、源于进化与演进(软件系统、思维方式、亲密关系、企业系统、商业价值链、中国社会、全球)](https://i-blog.csdnimg.cn/direct/fd1df13932fb4df09c34297f62f78bf0.png)

![[项目][CMP][Thread Cache]详细讲解](https://i-blog.csdnimg.cn/direct/9b45402cc79244b08d14c60f1767084e.png)