本文主要是介绍在Meteor Lake平台上使用NPU进行AI推理加速,希望对大家解决编程问题提供一定的参考价值,需要的开发者们随着小编来一起学习吧!

在Meteor Lake平台上,英特尔通过神经处理单元 (NPU) 将人工智能直接融入芯片中,实现桌面电脑平台的AI推理功能。神经处理单元 (NPU) 是一种专用人工智能引擎,专为运行持续的人工智能推理工作负载而设计。与即将推出的支持深度人工智能集成的 Windows 版本(预计将于 2024 年夏季推出)搭配,Meteor Lake 可能预示着人工智能 PC 时代的开始,计算机可以利用人工智能来简化我们的计算体验,并使笔记本电脑和台式机的功能呈指数级增长。本文主要介绍在Ubuntu系统上如何启用NPU功能加速AI推理的运算。

1. 安装ubuntu22.04

按照Ubuntu官网的文档,先安装好Ubuntu 22.04。如果已经安装好,则直接跳过此步骤。https://ubuntu.com/download/desktop

2. 升级内核

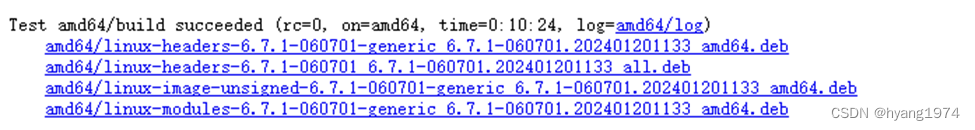

参考Intel OpenVINO文档,在Ubuntu里启用NPU功能需要Linux kernel版本在6.6以上。因为Ubuntu 22.04 apt源中没有6.5以上的内核,所以到mainline下载,选择最新的6.7.1。

2.1 下载Kernel 6.7.1

mkdir -p /tmp/mtl

cd /tmp/mtl

wget https://kernel.ubuntu.com/mainline/v6.7.1/amd64/linux-headers-6.7.1-060701-generic_6.7.1-060701.202401201133_amd64.deb

wget https://kernel.ubuntu.com/mainline/v6.7.1/amd64/linux-headers-6.7.1-060701_6.7.1-060701.202401201133_all.deb

wget https://kernel.ubuntu.com/mainline/v6.7.1/amd64/linux-image-unsigned-6.7.1-060701-generic_6.7.1-060701.202401201133_amd64.deb

wget https://kernel.ubuntu.com/mainline/v6.7.1/amd64/linux-modules-6.7.1-060701-generic_6.7.1-060701.202401201133_amd64.deb2.2 安装6.7.1 kernel packages

sudo dpkg -I *.deb可能会出现如下的报错,linux-headers-6.7.1-060701-generic_6.7.1-060701.202401201133_amd64.deb安装报错。可忽略,不影响下面的使用。

2.3 重启并验证kernel里NPU的支持

sudo reboot

sudo apt-get install --fix-broken

sudo dmesg | grep vpu![]()

能看到intel_vpu的字样说明内核能识别NPU,在内核中可能是延续以前定义,NPU被叫做VPU。而在OpenVINO中则被叫做NPU。

3. 安装Intel compute-runtime

3.1 添加intel的apt源

wget -qO - https://repositories.intel.com/gpu/intel-graphics.key | \

sudo gpg --dearmor --output /usr/share/keyrings/intel-graphics.gpg

echo "deb [arch=amd64,i386 signed-by=/usr/share/keyrings/intel-graphics.gpg] https://repositories.intel.com/gpu/ubuntu jammy client" | \

sudo tee /etc/apt/sources.list.d/intel-gpu-jammy.list

sudo apt update执行完上述的命令后,会创建/etc/apt/source.list.d/intel-gpu-jammy.list文件,内容如下:

deb [arch=amd64,i386 signed-by=/usr/share/keyrings/intel-graphics.gpg] https://repositories.intel.com/gpu/ubuntu jammy client3.2 下载Intel compute-runtime及其它依赖组件

wget https://github.com/intel/intel-graphics-compiler/releases/download/igc-1.0.15770.11/intel-igc-core_1.0.15770.11_amd64.deb

wget https://github.com/intel/intel-graphics-compiler/releases/download/igc-1.0.15770.11/intel-igc-opencl_1.0.15770.11_amd64.deb

wget https://github.com/intel/compute-runtime/releases/download/23.52.28202.14/intel-level-zero-gpu-dbgsym_1.3.28202.14_amd64.ddeb

wget https://github.com/intel/compute-runtime/releases/download/23.52.28202.14/intel-level-zero-gpu_1.3.28202.14_amd64.deb

wget https://github.com/intel/compute-runtime/releases/download/23.52.28202.14/intel-opencl-icd-dbgsym_23.52.28202.14_amd64.ddeb

wget https://github.com/intel/compute-runtime/releases/download/23.52.28202.14/intel-opencl-icd_23.52.28202.14_amd64.deb

wget https://github.com/intel/compute-runtime/releases/download/23.52.28202.14/libigdgmm12_22.3.11_amd64.deb3.3 安装Intel compute-runtime

sudo dpkg -i *.deb如果安装出现问题,请按照错误提示安装所需的其它依赖项,例如:

apt install ocl-icd-libopencl1比较新的硬件最好使用compute-runtime最新的release,但有时最新的有可能无法匹配安装的系统,可以安装能用的最新版本。如果以后硬件平台驱动成熟可以完全按intel官网教程安装驱动。

3.4 验证NPU驱动安装成功

lsmod | grep vpu显示如下的内容则表示NPU驱动加载成功。

![]()

在/lib/firmware/intel/vpu目录下会有MTL NPU firmware的bin文件

ls /lib/firmware/intel/vpu/此目录里会有如下的bin文件:mtl_vpu_v0.0.bin vpu_37xx_v0.0.bin

NPU会使用如下的设备文件

ls -l /dev/accel/

crw------- 1 root root 261, 0 2月 7 11:03 accel0

3.5 安装iGPU相关驱动

集成显卡也需要安装compute-runtime才能正常加速,具体可以参考此文档。

sudo apt install -y \intel-opencl-icd intel-level-zero-gpu level-zero \intel-media-va-driver-non-free libmfx1 libmfxgen1 libvpl2 \libegl-mesa0 libegl1-mesa libegl1-mesa-dev libgbm1 libgl1-mesa-dev libgl1-mesa-dri \libglapi-mesa libgles2-mesa-dev libglx-mesa0 libigdgmm12 libxatracker2 mesa-va-drivers \mesa-vdpau-drivers mesa-vulkan-drivers va-driver-all vainfo hwinfo clinfo3.6 验证iGPU驱动安装成功

成功安装iGPU驱动后系统会存在以下设备文件:

ls /dev/dri/render*

/dev/dri/renderD1283.7 NPU/iGPU驱动权限设置

如果当前用户要使用npu和gpu加速,必须保证对以上设备节点的访问权限。如果没有正确设置访问权限时访问NPU则会出现以下错误:

设置NPU访问权限一般可以用groupadd添加一个group,这里是mtl_npu,usermod -aG 把用户加到组中,然后chown和chmod赋予设备文件组访问权。

sudo groupadd mtl_npu

sudo usermod -aG mtl_npu xxx # user name for NPU acceleration

groups # 查看groupchown改变文件所属的用户和组:

sudo chown root:mtl_npu /dev/accel/accel0

sudo chmod 660 /dev/accel/accel0这里的660是赋予文件所属用户和组读写权限,因为当前用户属于mtl_npu组,而mtl_gpu组拥有对此文件的读写权限,所以当前用户拥有此文件的读写访问权限。

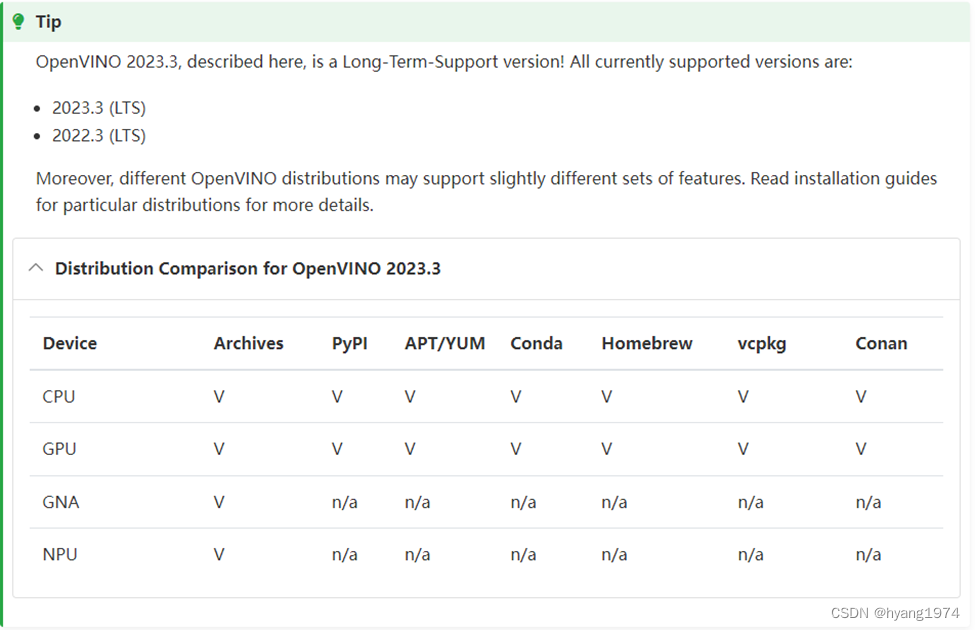

4. 安装OpenVINO 2023.3

4.1 下载与安装

访问OpenVINO官网,下载OpenVINO 2023.3.0。按照下面的链接安装OpenVINO:

https://docs.openvino.ai/2023.3/openvino_docs_install_guides_installing_openvino_from_archive_linux.html

安装的过程在OpenVINO的文档里写得非常详细,这里就不再赘述。

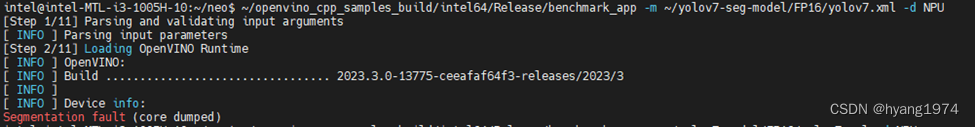

4.2 运行sample apps

cd openvino_dir/samples/cpp

./buildsample.sh会在当前目录下生成openvino_cpp_samples_build目录。在此目录的/intel64/Release/下面有一些可执行的测试程序比如benchmark_app。运行这些程序即可进行sample验证。

![]()

cd ./intel64/Release

./benchmark_app注意事项:目前版本的OpenVINO 2023.3在Python模式下不包含NPU plugin。尝试NPU功能请使用C++ sample applications。Python支持会在后续加入。

欢迎访问作者个人Blog原文:在Meteor Lake平台上使用NPU进行AI推理加速 - HY's Blog

这篇关于在Meteor Lake平台上使用NPU进行AI推理加速的文章就介绍到这儿,希望我们推荐的文章对编程师们有所帮助!