本文主要是介绍使用自己的TUM数据集来实现ORBSLAM稠密建图,希望对大家解决编程问题提供一定的参考价值,需要的开发者们随着小编来一起学习吧!

简介

- 项目链接:https://github.com/LeonardoDiCaprio1/Map_ORBSLAM_ROS

- 奥比中光ROS功能驱动包:https://github.com/LeonardoDiCaprio1/astra_camera

- 笔者参照很多大佬的文章和相关代码并添加了一些功能而且最终编译出来,现在分享给大家

硬件设备

- 奥比中光深度相机(Astra)

- 笔记本电脑(AMD)

操作环境

- Ubuntu 20.04

- ROS Noetic

额外依赖

- pcl-1.13

- Pangolin-0.6

- boost-1.79.0

- realsense2

注:Ubuntu 20.04 ROS Noetic自带OpenCV-4.2.0

安装依赖

1.安装git,g++,python

- ORBSLAM3需要C++11和C++0x 编译器

sudo apt-get install git

sudo apt install g++

sudo apt install libpython2.7-dev

2.安装EIGEN库

sudo apt-get install libeigen3-dev

- 检查是否安装成功

cat /usr/include/eigen3/Eigen/src/Core/util/Macros.h

3.安装Pangolin-0.6

- 安装依赖

sudo apt install libgl1-mesa-dev

sudo apt install libglew-dev

sudo apt install libpython2.7-dev

sudo apt install pkg-config

sudo apt install libegl1-mesa-dev libwayland-dev libxkbcommon-dev wayland-protocols

- 编译与安装

cd Pangolin-0.6

mkdir build

cd build

cmake ..

make

sudo make install

- 卸载说明

cd build

sudo make uninstall

- 查看是否安装成功

cd examples/HelloPangolin

./HelloPangolin

- 注:pcl-1.13的编译与下载和Pangolin-0.6操作相同,后续不在叙述

4.安装OpenCV依赖

sudo apt-get install build-essential libgtk2.0-dev libgtk-3-dev libavcodec-dev libavformat-dev libjpeg-dev libswscale-dev libtiff5-dev

sudo apt install python3-dev python3-numpy

sudo apt install libgstreamer-plugins-base1.0-dev libgstreamer1.0-dev

sudo apt install libpng-dev libopenexr-dev libtiff-dev libwebp-dev

- 检查OpenCV版本号

pkg-config --modversion opencv4

5.安装boost库

- 链接

sudo ./bootstrap.sh

sudo ./b2 install

6.安装realsense2

- 注册public key

sudo apt-key adv --keyserver keyserver.ubuntu.com --recv-key F6E65AC044F831AC80A06380C8B3A55A6F3EFCDE || sudo apt-key adv --keyserver hkp://keyserver.ubuntu.com:80 --recv-key F6E65AC044F831AC80A06380C8B3A55A6F3EFCDE

- 添加apt源

sudo add-apt-repository "deb https://librealsense.intel.com/Debian/apt-repo $(lsb_release -cs) main" -u

- 安装

sudo apt install librealsense2-dkms librealsense2-utils librealsense2-dev

7.安装编译Map_ORBSLAM_ROS

cd Map_ORBSLAM_ROS

chmod +x *.sh

./build.sh

注:这里为了防止线程卡死,你可以在build.sh文件中将其相关代码改为make

8.TUM数据集稠密建图

./run_rgb_mapping.sh

或者

source build/devel/setup.bash

roslaunch orb_slam3 rgbd_mapping_1.launch

制作TUM数据集

- 奥比中光bag包录制

rosbag record -O image.bag /camera/rgb/image_raw /camera/depth/image_raw

- 查看奥比中光订阅话题

rosbag info image.bag

- 首先创建rgb和depth文件夹和txt文件

mkdir rgb

mkdir depth

touch rgb.txt

touch depth.txt

- 使用脚本get_TUM_better.py或者get_TUM.py或者get_tum.py获取深度图和彩色图并分别得到txt文件

- 若是TUM官方数据集的bag文件请使用TUM_official.py文件

python3 get_TUM_better.py

- 使用官方脚本得到associate.txt文件

python3 associate.py rgb.txt depth.txt > associate.txt

- 执行指令例子

./Examples/RGB-D/rgbd_tum Vocabulary/ORBvoc.txt Examples/RGB-D/TUM1.yaml /home/zhao/script /home/zhao/script/associate.txt

-

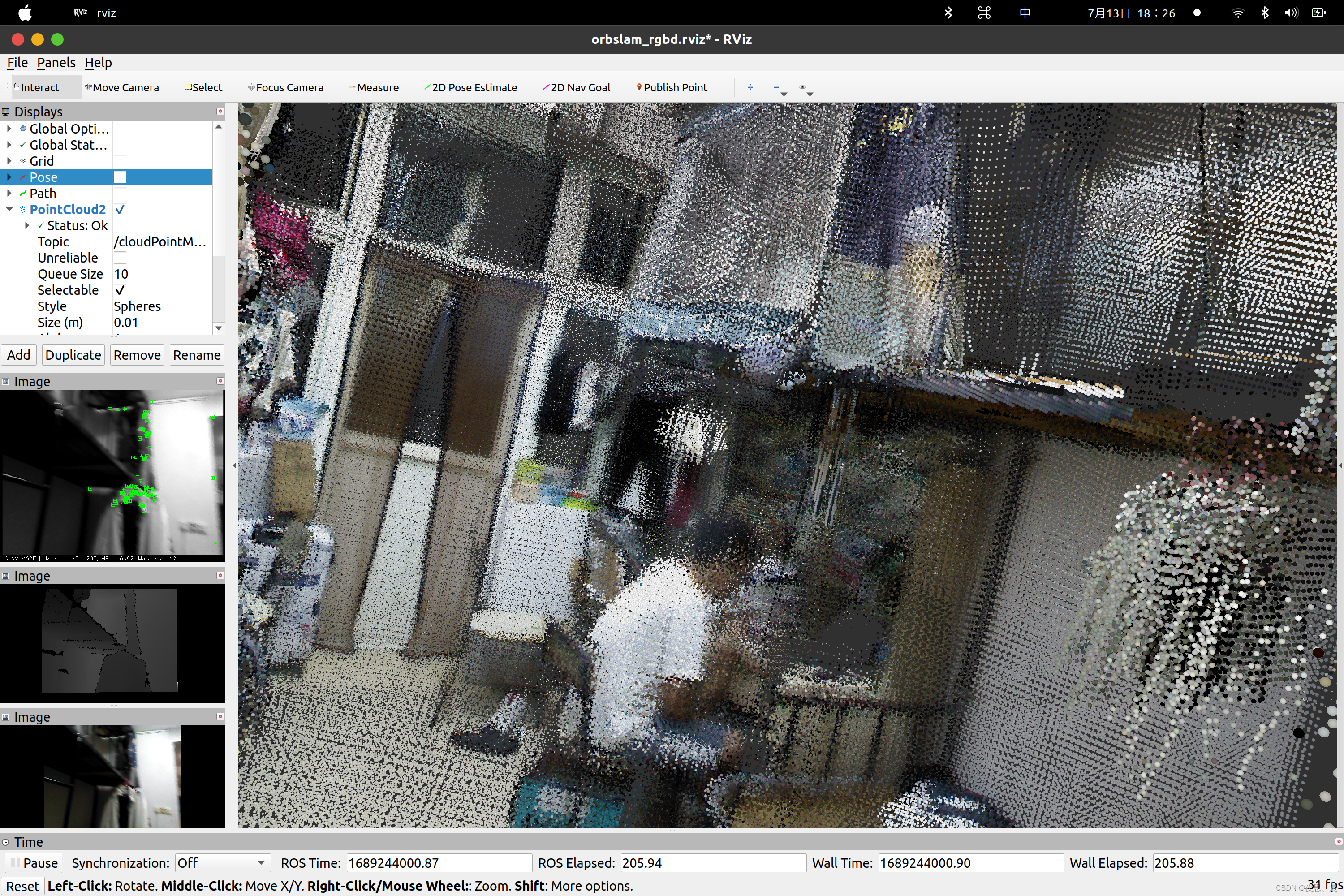

效果展示

-

TUM官方数据集bag文件信息

注:你可以使用其他的深度相机制作TUM数据集,但要注意相机的规格参数,实验过程中使用的是奥比中光深度相机,TUM官方数据集给的bag文件除了相机深度话题和彩色话题以外还有imu和tf话题。

制作TUM数据集-稠密建图

- 首先在当级目录下创建rgb.txt和depth.txt以及rgb和depth文件夹

mkdir rgb

mkdir depth

touch rgb.txt

touch depth.txt

- 运行scripts中的get_TUM.py文件或者get_TUM_better.py文件

python3 get_TUM_better.py

- 若是TUM官方数据集的bag文件请使用scripts中的TUM_official.py文件

python3 TUM_official.py

- 运行associate.py得到associate.txt文件

python3 associate.py rgb.txt depth.txt > associate.txt

- 使用自己的数据集稠密建图

./run_rgb_mapping.sh

- 运行样例

稠密建图效果

- 建完图后pcd文件默认保存在.ros隐藏文件夹中

- Ctrl + H 能够快速的调出隐藏文件

- 安装pcl工具

sudo apt-get install libpcl-dev pcl-tools

- pcl查看建图效果

pcl_viewer vslam.pcd

- 开源项目scripts文件夹中有matlab脚本

- 你也可以使用CouldCompare软件打开pcd文件

- 笔者默认使用matlab打开pcd文件

效果展示

相机内参标定

- 将以下的照片打印在A4纸上,拍摄20张左右的图片

- 可以通过rosbag录制1-2秒,用get_tum.py或者get_TUM.py获取彩色图像

- 存放在cameraCalib.py同一级目录下

- 执行代码

python3 cameraCalib.py

- 注:例子Example.yaml在scripts里

使用EVO测评TUM官方数据集

- evo_ape:计算绝对位姿误差(absolute pose error),用于整体评估整条轨迹的全局一致性

- evo_rpe:计算相对位姿误差(relative pose error),用于评价轨迹局部的准确性

- -a轨迹对齐,-s尺度缩放,-p绘制误差相关曲线,-v开启详细的输出或日志记录

- 在执行完以下指令后可以获得CameraTrajectory.txt和KeyFrameTrajectory.txt

./Examples/RGB-D/rgbd_tum Vocabulary/ORBvoc.txt Examples/RGB-D/TUM1.yaml /home/zhao/script /home/zhao/script/associate.txt

- 注意事项:本文是针对CameraTrajectory.txt和KeyFrameTrajectory.txt进行评估的,因为后面评估自己的TUM数据集只有这两个文件,groundtruth.txt可能需要特殊处理来生成,笔者暂时没有方法去实现,这可能需要额外的设备去获取相对位姿

- 如果出现以下情况请不要担心!

max 0.000000mean 0.000000median 0.000000min 0.000000rmse 0.000000sse 0.000000std 0.000000

- 一般而言可以使用groundtruth.txt和CameraTrajectory.txt或者KeyFrameTrajectory.txt进行对比评估

- 以下是一个样例

evo_ape tum groundtruth.txt CameraTrajectory.txt -p --plot -s --correct_scale -a --align -v

- pip安装evo工具

pip install evo --upgrade --no-binary evo

绘制多条轨迹

- evo_traj绘制轨迹

evo_traj tum CameraTrajectory.txt KeyFrameTrajectory.txt -p --plot_mode=xyz

- TUM数据集有groundtruth.txt文件,可以执行以下指令:

evo_traj tum CameraTrajectory.txt KeyFrameTrajectory.txt groundtruth.txt -p --plot_mode=xyz

- trajectories

- xyz_view

- rpy_view

- 欧拉角(roll,pitch,yaw)分别表示滚动角,俯仰角,偏航角

评估绝对位姿误差

- evo_ape评估绝对位姿误差指令

evo_ape tum CameraTrajectory.txt KeyFrameTrajectory.txt -p --plot -s --correct_scale -a --align -v --save_results ~/path/to/ape.zip

- 当然你可以省略–save_results ~/path/to/ape.zip

evo_ape tum CameraTrajectory.txt KeyFrameTrajectory.txt -p --plot -s --correct_scale -a --align -v

结果展示

- APE平均百分误差

- rmse均方根误差

- median中位数

- mean算术平均数

- std标准差

评估相对位姿误差

- evo_rpe评估相对误差指令

evo_rpe tum CameraTrajectory.txt KeyFrameTrajectory.txt -p -a -s -v --save_results ~/path/to/rpe.zip

- 当然你可以省略–save_results ~/path/to/rpe.zip

evo_rpe tum CameraTrajectory.txt KeyFrameTrajectory.txt -p -a -s -v

结果展示

- APE平均百分误差

- rmse均方根误差

- median中位数

- mean算术平均数

- std标准差

- 输出ape结果进行比较

evo_res ape.zip -p --save_table ape.csv

- 当然你可以省略–save_table ape.csv

evo_res ape.zip -p

结果展示

使用EVO工具测评自己的TUM数据集

- evo_traj绘制多条轨迹指令如下:

evo_traj tum CameraTrajectory.txt KeyFrameTrajectory.txt -p --plot_mode=xyz

- trajectories

- xyz_view

- rpy_view

注:evo评估自己的TUM数据集结果不做过多演示,后续可以自己操作并输出自己的TUM数据集的评估结果

项目链接展示

-

TUM官方数据集-哔哩哔哩

-

自己的TUM数据集-哔哩哔哩

-

主要参考链接

- https://blog.csdn.net/kuvinxu/article/details/125992909

- https://blog.csdn.net/kuvinxu/article/details/126233165

- https://github.com/lturing/ORB_SLAM3_ROS

- https://blog.csdn.net/peng_258/article/details/127414959

- https://blog.csdn.net/zardforever123/article/details/127138151

- https://blog.csdn.net/weixin_47074246/article/details/109134740

- https://blog.csdn.net/qq_43265072/article/details/104715515

这篇关于使用自己的TUM数据集来实现ORBSLAM稠密建图的文章就介绍到这儿,希望我们推荐的文章对编程师们有所帮助!