本文主要是介绍【智能优化算法-灰狼算法】基于基于随机收敛因子和差分变异改进灰狼优化算法求解单目标优化问题附matlab代码,希望对大家解决编程问题提供一定的参考价值,需要的开发者们随着小编来一起学习吧!

✅作者简介:热爱科研的Matlab仿真开发者,修心和技术同步精进,matlab项目合作可私信。

🍎个人主页:Matlab科研工作室

🍊个人信条:格物致知。

更多Matlab仿真内容点击👇

智能优化算法 神经网络预测 雷达通信 无线传感器

信号处理 图像处理 路径规划 元胞自动机 无人机

⛄ 内容介绍

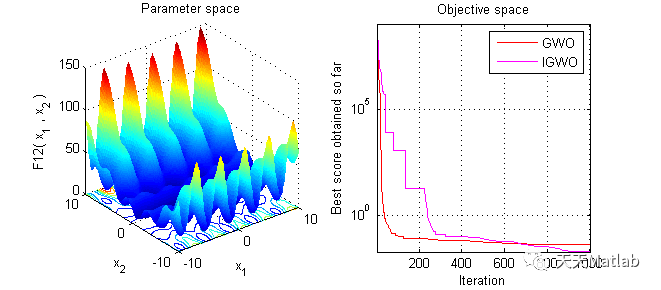

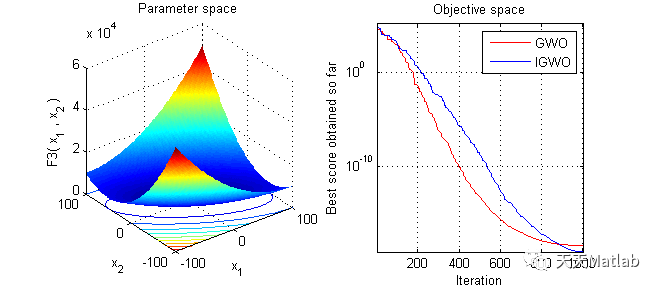

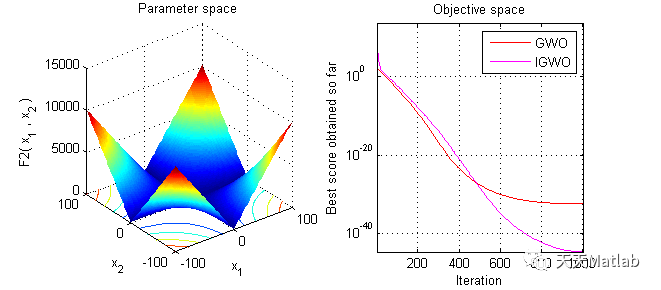

针对基本灰狼优化算法在求解高维复杂优化问题时存在解精度低和易陷入局部最优的缺点,提出一种改进的灰狼优化算法.受粒子群优化算法的启发,设计一种收敛因子a随机动态调整策略以协调算法的全局勘探和局部开采能力;为了增强种群多样性和降低算法陷入局部最优的概率,受差分进化算法的启发,构建一种随机差分变异策略产生新个体.选取6个标准测试函数进行仿真实验.结果表明:在相同的适应度函数评价次数条件下,此算法在求解精度和收敛速度上均优于其他算法.

⛄ 部分代码

%___________________________________________________________________%

% Grey Wold Optimizer (GWO) source codes version 1.0 %

% %

% Developed in MATLAB R2011b(7.13) %

% %

% Author and programmer: Seyedali Mirjalili %

% %

% e-Mail: ali.mirjalili@gmail.com %

% seyedali.mirjalili@griffithuni.edu.au %

% %

% Homepage: http://www.alimirjalili.com %

% %

% Main paper: S. Mirjalili, S. M. Mirjalili, A. Lewis %

% Grey Wolf Optimizer, Advances in Engineering %

% Software , in press, %

% DOI: 10.1016/j.advengsoft.2013.12.007 %

% %

%___________________________________________________________________%

% Grey Wolf Optimizer

function [Alpha_score,Alpha_pos,Convergence_curve]=GWO(SearchAgents_no,Max_iter,lb,ub,dim,fobj)

% initialize alpha, beta, and delta_pos

Alpha_pos=zeros(1,dim);

Alpha_score=inf; %change this to -inf for maximization problems

Beta_pos=zeros(1,dim);

Beta_score=inf; %change this to -inf for maximization problems

Delta_pos=zeros(1,dim);

Delta_score=inf; %change this to -inf for maximization problems

%Initialize the positions of search agents

Positions=initialization(SearchAgents_no,dim,ub,lb);

Convergence_curve=zeros(1,Max_iter);

l=0;% Loop counter

% Main loop

while l<Max_iter

for i=1:size(Positions,1)

% Return back the search agents that go beyond the boundaries of the search space

Flag4ub=Positions(i,:)>ub;

Flag4lb=Positions(i,:)<lb;

Positions(i,:)=(Positions(i,:).*(~(Flag4ub+Flag4lb)))+ub.*Flag4ub+lb.*Flag4lb;

% Calculate objective function for each search agent

fitness=fobj(Positions(i,:));

% Update Alpha, Beta, and Delta

if fitness<Alpha_score

Alpha_score=fitness; % Update alpha

Alpha_pos=Positions(i,:);

end

if fitness>Alpha_score && fitness<Beta_score

Beta_score=fitness; % Update beta

Beta_pos=Positions(i,:);

end

if fitness>Alpha_score && fitness>Beta_score && fitness<Delta_score

Delta_score=fitness; % Update delta

Delta_pos=Positions(i,:);

end

end

% a decreases linearly fron 2 to 0

a=sin(((l*pi)/Max_iter)+pi/2)+1;

% Update the Position of search agents including omegas

for i=1:size(Positions,1)

for j=1:size(Positions,2)

r1=rand(); % r1 is a random number in [0,1]

r2=rand(); % r2 is a random number in [0,1]

A1=2*a*r1-a; % Equation (3.3)

C1=2*r2; % Equation (3.4)

D_alpha=abs(C1*Alpha_pos(j)-Positions(i,j)); % Equation (3.5)-part 1

X1=Alpha_pos(j)-A1*D_alpha; % Equation (3.6)-part 1

r1=rand();

r2=rand();

A2=2*a*r1-a; % Equation (3.3)

C2=2*r2; % Equation (3.4)

D_beta=abs(C2*Beta_pos(j)-Positions(i,j)); % Equation (3.5)-part 2

X2=Beta_pos(j)-A2*D_beta; % Equation (3.6)-part 2

r1=rand();

r2=rand();

A3=2*a*r1-a; % Equation (3.3)

C3=2*r2; % Equation (3.4)

D_delta=abs(C3*Delta_pos(j)-Positions(i,j)); % Equation (3.5)-part 3

X3=Delta_pos(j)-A3*D_delta; % Equation (3.5)-part 3

Positions(i,j)=(X1+X2+X3)/3;% Equation (3.7)

end

end

l=l+1;

Convergence_curve(l)=Alpha_score;

end

⛄ 运行结果

⛄ 参考文献

[1]徐松金, 龙文. 基于随机收敛因子和差分变异的改进灰狼优化算法[J]. 科学技术与工程, 2018, 18(23):5.

❤️ 关注我领取海量matlab电子书和数学建模资料

❤️部分理论引用网络文献,若有侵权联系博主删除

这篇关于【智能优化算法-灰狼算法】基于基于随机收敛因子和差分变异改进灰狼优化算法求解单目标优化问题附matlab代码的文章就介绍到这儿,希望我们推荐的文章对编程师们有所帮助!