本文主要是介绍Principled Instructions Are All You Need for Questioning LLaMA-1/2, GPT-3.5/4,希望对大家解决编程问题提供一定的参考价值,需要的开发者们随着小编来一起学习吧!

Q: 这篇论文试图解决什么问题?

A: 这篇论文旨在简化查询和提示大型语言模型(LLMs)的过程,提出了26个指导原则,以增强用户对不同规模LLMs行为的理解。这些原则旨在改善LLMs的提示设计,提高LLMs在各种任务中的表现,尤其是在生成问题答案时。论文的目标是为研究人员提供更好的指导,以便在提示LLMs时能够获得更高质量的响应。

Q: 有哪些相关研究?

A: 这篇论文提到了以下相关研究: 1. 语言模型的演变,如BERT、T5、GPT-1、GPT-2、GPT-3、Gopher、LLaMA系列和Mistral。 2. 提示工程,包括Ask-Me-Anything提示、Chain-of-Thought方法、least-to-most提示、解释性提示、few-shot提示、输出引导提示等。 3. 提示工程技术目录,强调了在软件开发和教育中提高LLM性能的重要性。 4. 方向性刺激提示,提出了一种使用可调策略模型生成辅助提示的新框架,指导LLMs实现特定期望结果。

Q: 论文如何解决这个问题?

A: 论文通过以下方式解决这个问题: 1. 提出了26个原则,以改善LLMs的提示质量。这些原则涵盖了提示结构和清晰度、特定性、用户互动和参与、内容和语言风格以及复杂任务和编码提示等方面。 2. 在ATLAS基准测试上进行了实验,这是一个手动制作的基准测试,包含针对每个原则的多个问题。实验结果表明,与标准提示相比,应用这些原则的提示可以显著提高LLMs响应的质量和准确性。 3. 分析了不同规模的LLMs(如LLaMA-1/2和GPT-3.5/4)在应用这些原则时的表现。结果表明,随着模型规模的增加,性能提升更加明显。

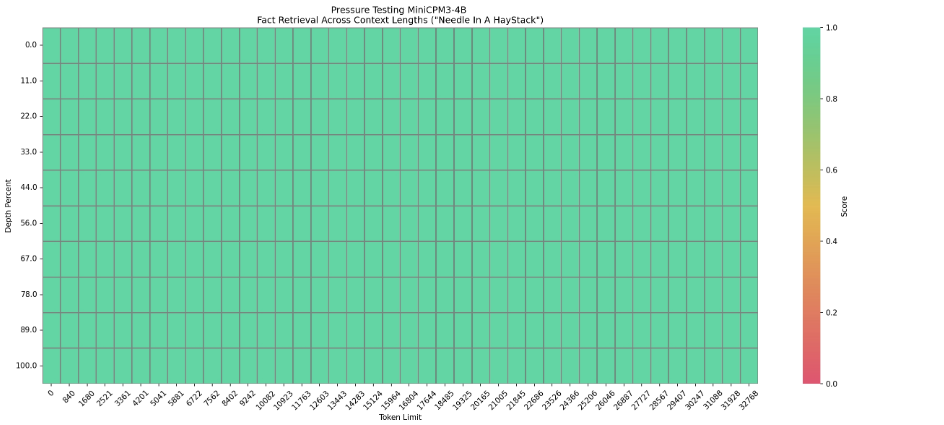

Q: 论文做了哪些实验?

A: 论文在ATLAS基准测试上进行了实验,这是一个手动制作的基准测试,包含针对每个原则的多个问题。实验分为两个部分:提升和正确性。通过人类评估来衡量LLMs输出的质量提升和准确性。实验使用了以下模型:LLaMA-1-{7, 13}, LLaMA-2-{7, 13}, LLaMA-2-70B-chat, GPT-3.5 (ChatGPT) 和 GPT-4。这些模型分为不同的规模:小型(7B模型)、中型(13B)和大型(70B, GPT-3.5/4)。实验结果表明,应用这些原则的提示可以显著提高LLMs响应的质量和准确性。

Q: 有什么可以进一步探索的点?

A: 论文提出了以下未来探索方向: 1. 使用替代策略(如微调、强化学习、直接偏好优化或使用生成的数据集的不同提示方法)来进一步优化基础模型,使其更好地符合原则性指导。 2. 将成功的策略整合到标准的LLM操作中,例如使用原始/原则性提示作为输入,经过优化的原则性响应作为训练目标进行微调。 3. 在未来的研究中扩展问题集,以获得更普遍的发现并深入了解每个原则的适用性。

Q: 总结一下论文的主要内容

A: 这篇论文提出了26个原则,旨在改善大型语言模型(LLMs)在回答问题时的表现。这些原则涵盖了提示的结构和清晰度、特定性、用户互动和参与、内容和语言风格以及复杂任务和编码提示等方面。论文在ATLAS基准测试上进行了实验,评估了不同规模的LLMs(如LLaMA-1/2和GPT-3.5/4)在应用这些原则时的表现。实验结果表明,应用这些原则的提示可以显著提高LLMs响应的质量和准确性。此外,论文还讨论了未来的研究方向,如使用替代策略进一步优化模型,将成功的策略整合到标准的LLM操作中,以及扩展问题集以获得更普遍的发现。

这篇关于Principled Instructions Are All You Need for Questioning LLaMA-1/2, GPT-3.5/4的文章就介绍到这儿,希望我们推荐的文章对编程师们有所帮助!