need专题

hdu1203--D - I NEED A OFFER!(转化01背包)

D - I NEED A OFFER! Time Limit:1000MS Memory Limit:32768KB 64bit IO Format:%I64d & %I64u Submit Status Description Speakless很早就想出国,现在他已经考完了所有需要的考试,准备了所有要准备的材料,于是,便需要去申请学校了。要申请国外

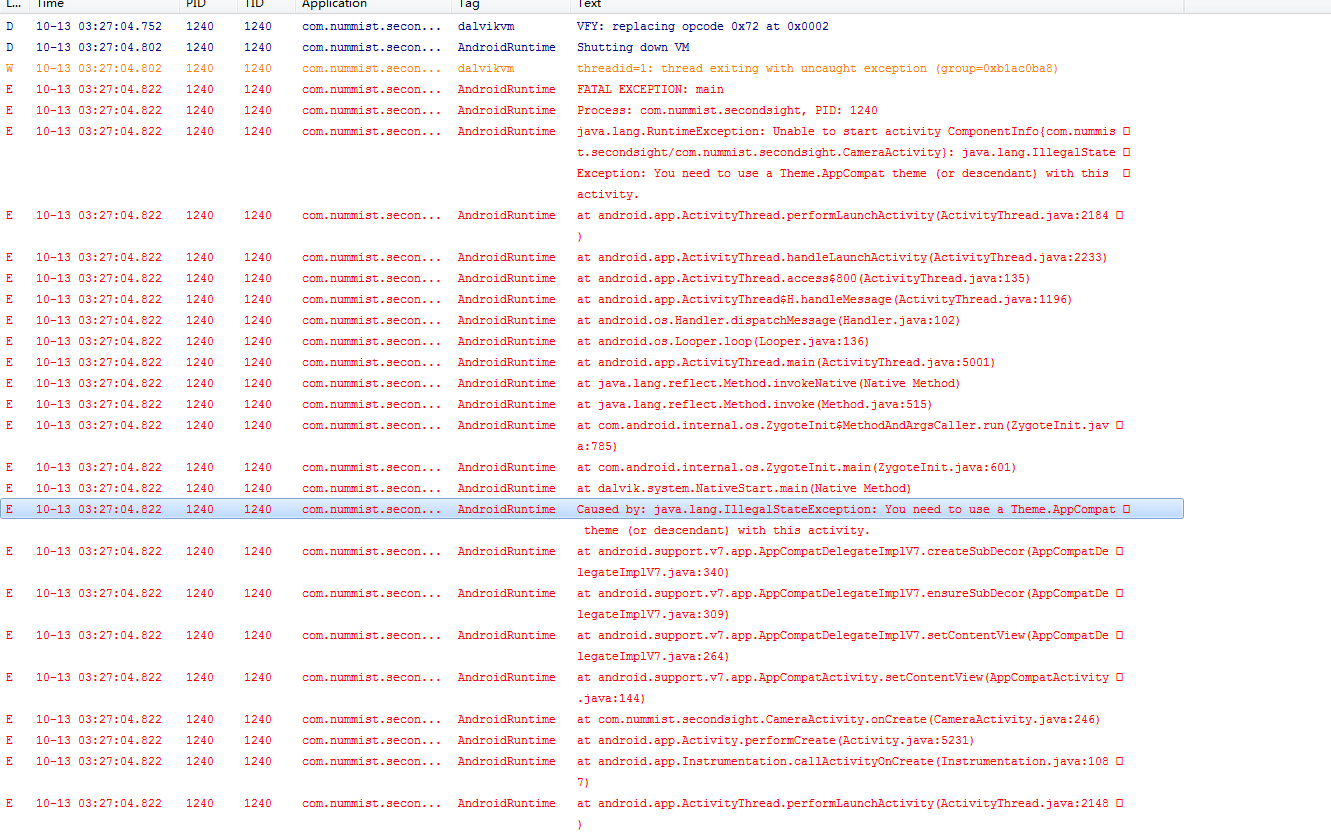

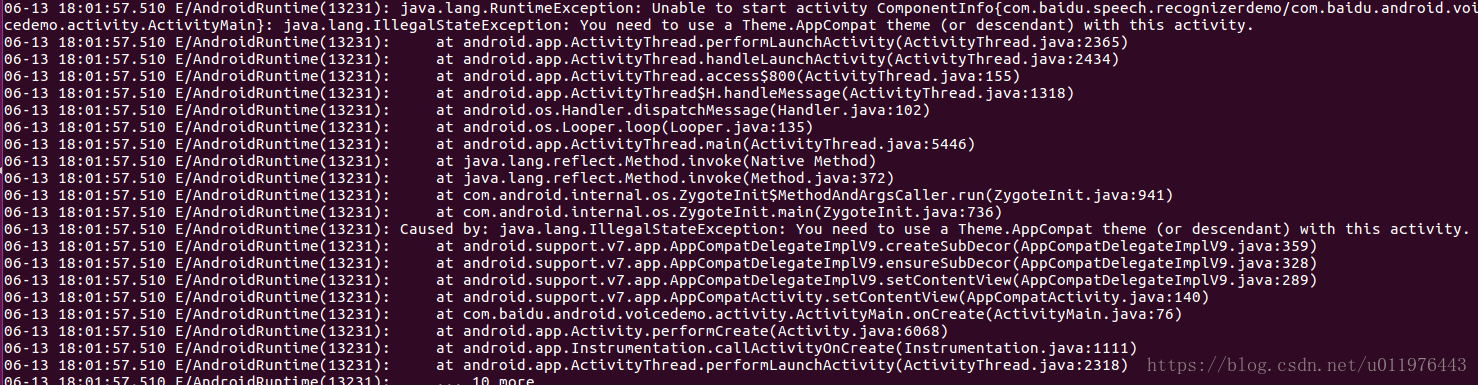

解决:You need to use a Theme.AppCompat theme (or descendant) with this activity

1.问题如下: 解决办法: 将MainActivity改为继承自Activity即可,但是这样修改可能无法兼容老版本样式,暂时先用这个方法解决,后续在补充

Attention Is All You Need详解

一.背景。 在此模型之前,序列到序列的任务(如机器翻译、文本摘要等)通常采用循环神经网络(RNN)或卷积神经网络(CNN)。然而,RNN 在处理长距离依赖时存在一定的局限性(举个例子:处理第Kt个词时,需要用到K1到Kt-1的词的输出作为输入),训练时也比较耗时。而 CNN 在处理序列数据时难以捕捉到全局的依赖关系。然而这篇文章介绍的模型Transformer完全基于注意力机制,与CNN,RNN

[论文笔记]Are Large Language Models All You Need for Task-Oriented Dialogue?

引言 今天带来论文Are Large Language Models All You Need for Task-Oriented Dialogue?的笔记。 主要评估了LLM在完成多轮对话任务以及同外部数据库进行交互的能力。在明确的信念状态跟踪方面,LLMs的表现不及专门的任务特定模型。然而,如果为它们提供了正确的槽值,它们可以通过生成的回复引导对话顺利结束。 1. 总体介绍 本篇工

HDU1203,I NEED A OFFER!

I NEED A OFFER! Time Limit: 2000/1000 MS (Java/Others) Memory Limit: 65536/32768 K (Java/Others) Total Submission(s): 15988 Accepted Submission(s): 6350 Problem Description Speakless

论文笔记 | Attention Is All Y ou Need for Chinese Word Segmentation

作者:景 单位:燕山大学 论文来源:EMNLP2020 代码地址 关于分词任务 中文分词(CWS)是在句子中划分单词边界的任务,对于中文和许多其他东亚语言来说,这是一项基本和必要的任务——对于中文来说,进行交流的基本单位是汉字,每个汉字均有各自的意思,且当不同的汉字进行组合后还会产生新的含义。英语中词的最基本单位是字母(letter),但英语日常使用的基本单位是词(word)

Unknown host 'services.gradle.org'. You may need to adjust the proxy settings in Gradle.

File ——> Settings ——> Appearance & Behavior ——> System Settings ——> HTTP Proxy 选中 Auto-detect proxy settings Like this:

Life is short, You need Python

简述 『Life is short, You need Python』中文译为:『人生苦短,我用 Python』 作为一个 Pythonista,这句话再熟悉不过了,一起用心来感受下吧! | 版权声明:一去、二三里,未经博主允许不得转载。 起源 『Life is short, You need Python』原话在 sebsauvage: “Life is short (You ne

java.lang.IllegalStateException: You need to use a Theme.AppCompat theme

翻译自:http://stackoverflow.com/questions/21814825/you-need-to-use-a-theme-appcompat-theme-or-descendant-with-this-activity 中Bobbake4的回答: The reason you are having this problem is because the activ

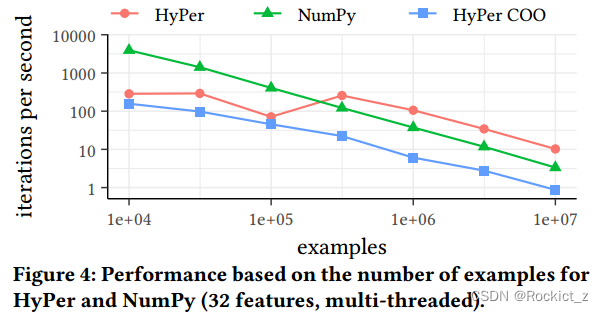

【论文阅读】Machine Learning, Linear Algebra, and More: Is SQL All You Need?

文章目录 摘要一、介绍二、SQL算法原语2.1、Variables2.2、Functions2.3、Conditions2.4、Loops2.5、Errors 三、案例研究3.1、对数据库友好的SQL映射3.2、性能结果 四、结论以及未来工作 摘要 尽管SQL在简单的分析查询中无处不在,但它很少用于更复杂的计算,如机器学习、线性代数和其他计算密集型算法。这些算法通常以过程

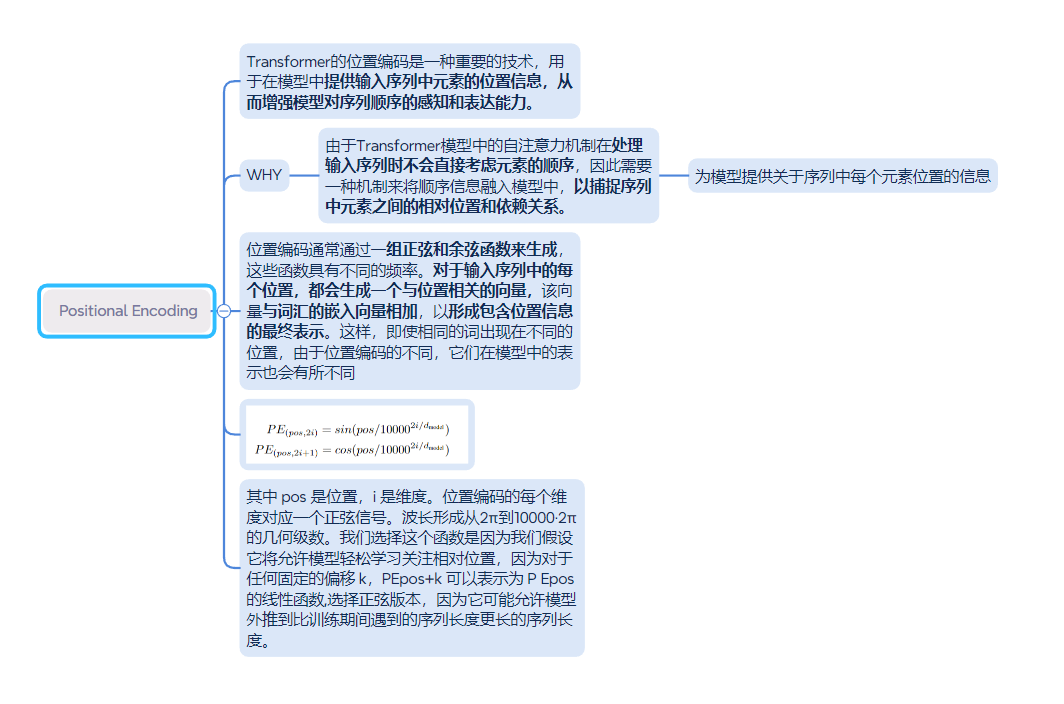

论文 学习 Transformer : Attention Is All You Need

目录 概述: 对摘要的理解: 框架解析 按比例缩放的点积注意力 多头注意力机制 前馈神经网络与位置编码 概述: transformer 是一个encoder ——decoder 结构的用于处理序列到序列转换任务的框架,是第一个完全依赖自注意力机制,计算其输入输出表示的转换模型,核心是采用了注意力机制用于捕获输入序列不同位置之间的依赖关系,帮助模型在生成输出时能够

安装redis错误解决办法,You need tcl 8.5 or newer in order to run the Redis test.

安装Redis,运行make test的时候出错: wget http://downloads.sourceforge.net/tcl/tcl8.6.1-src.tar.gz sudo tar xzvf tcl8.6.1-src.tar.gz -C /usr/local/ cd /usr/local/tcl8.6.1/unix/ sudo ./configure sudo make s

跟TED演讲学英文:Teachers need real feedback by Bill Gates

Teachers need real feedback Link: https://www.ted.com/talks/bill_gates_teachers_need_real_feedback Speaker: Bill Gates Date: May 2013 文章目录 Teachers need real feedbackIntroductionVocabularyTra

Error:Unknown host 'jcenter.bintray.com'. You may need to adjust the proxy settings in Gradle.

Android studio 报以下错误: Error:Unknown host 'jcenter.bintray.com'. You may need to adjust the proxy settings in Gradle.Enable Gradle 'offline mode' and sync Learn about configuring HTTP proxies in Grad

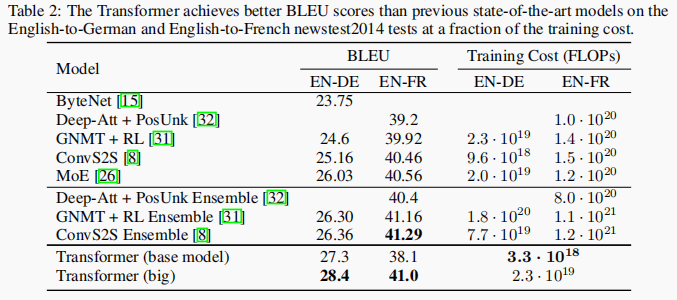

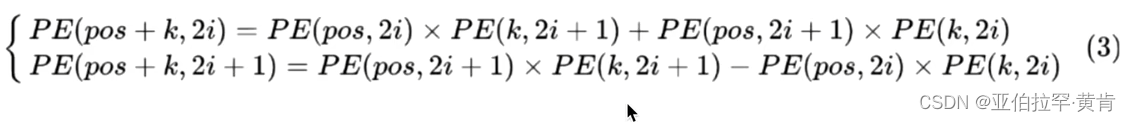

论文精度-Attention Is All You Need

文章目录 论文精读-Transformer(Attention is All You Need)1.Transformer 整体结构2. Transformer 的输入2.1 单词 Embedding2.2 位置 Embedding 3. Self-Attention(自注意力机制)3.1 Self-Attention 结构3.2 Q, K, V 的计算3.3 Self-Attention

hdu 1203 dp(0,1 背包) I NEED A OFFER!

0,1背包。。。只不过,概率问题。。所有费用为背包,。 题目说至少一个学校,那么反过来算,一个学校都没有的话,它的最少概率。 dp[i][j]表示第i个学校有j的费用的时候最少概率。 dp[i][j]=min(dp[i-1][j],dp[i-1][j-a[i]]*(1-b[i])) #include<iostream>using namespace std;float dp[1

论文笔记(四十五)Attention Is All You Need

Attention Is All You Need 文章概括摘要1. 介绍2. 背景3. 模型架构3.1 编码器和解码器堆栈3.2 Attention3.2.1 按比例点积Attention3.2.2 Multi-Head Attention3.2.3 注意力在模型中的应用 3.3 定位前馈网络3.4 嵌入与 Softmax3.5 位置编码 4 为什么 Self-Attention5. Tr

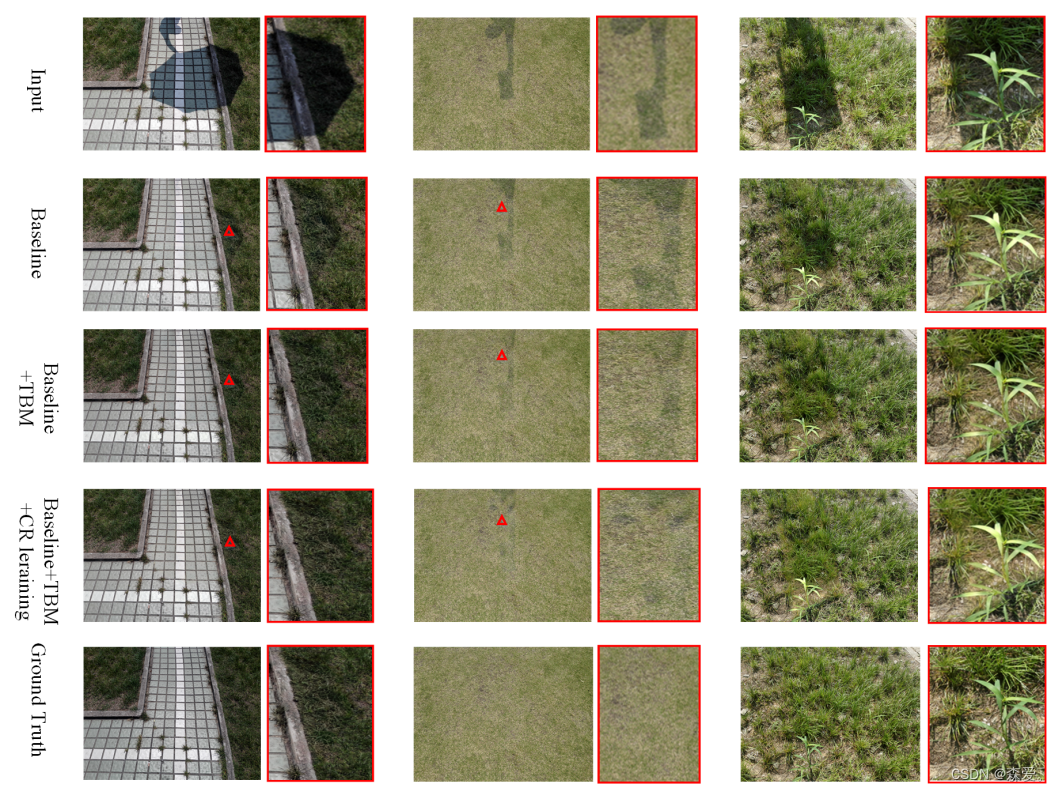

【图像超分】论文精读:CAMixerSR: Only Details Need More “Attention“

第一次来请先看这篇文章:【超分辨率(Super-Resolution)】关于【超分辨率重建】专栏的相关说明,包含专栏简介、专栏亮点、适配人群、相关说明、阅读顺序、超分理解、实现流程、研究方向、论文代码数据集汇总等) 文章目录 前言Abstract1. Introduction2. Related Work3. Method3.1. Content-Aware Mixing3.2. Netw

git--merge失败,you need to resolve your current index first

https://blog.csdn.net/wenwenxiong/article/details/47813277 从一个分支A切换到另一个分支B后,对切换后的B分支进行pull操作,因为pull操作实际上包含了fetch+merge操作,在执行 merge操作时,由于很长时间没有对B分支执行过pull/merge操作,本地的B分支库与remote中的B分支库中的差异很大(且这些差异是其他

Memory augment is All You Need for image restoration 论文翻译

目录 一.介绍 二.实际工作 A.图像阴影去除 B.图像去雨 C.存储模块的开发 三.网络结构 A.内存扩充 B.损失函数设计 四.实验 A.与最先进方法的比较 B.MemoryNet消融研究 五.结论 CVPR2023 MemoryNet 记忆增强是图像恢复所需要的一切 论文地址https://arxiv.org/abs/2309.01377 摘要

论文笔记:Attention Is All You Need

谷歌发表的文章,针对nlp里的机器翻译问题,提出了一种基于注意力机制的的网络结构–Transformer。 https://blog.csdn.net/songbinxu/article/details/80332992 以往nlp里大量使用RNN结构和encoder-decoder结构,RNN及其衍生网络的缺点就是慢,问题在于前后隐藏状态的依赖性,无法实现并行,而文章提出的”Transform

attention-is-all-you-need-pytorch 源码阅读

文章目录 训练数据流train.train_epochTransformerEncoderEncoderLayerMultiHeadAttentionScaledDotProductAttention PositionwiseFeedForward DecoderDecoderLayer PredictTODO 训练数据流 train.train_epoch 对training

天佑鲍比 I need you to listen Marty Haugen

I need you to listen, I need you to answer. 我需要您的倾听,我需要您来解惑! Oh, God I need you too, I want to see your face. 噢,上帝,我也需要你, 我想见见你! It is this love I have, It make me search for you. 这是我所拥有的爱,它让我寻找

LLM - Ruozhiba <Quality> is All You Need

目录 引言 1.COIG-CQIA Data 2.Ruozhiba Performance 3.Ruozhiba Data 4.More Ruozhiba Data 5.Some thoughts 引言 近期弱智吧 [后续以 Ruozhiba 代替] 的数据集在中文 LLM 场景的 Fine-Tuning 效果大火。众所周知,在当前 LLM 的大环境下,足够优秀的数据对

![[论文笔记]Are Large Language Models All You Need for Task-Oriented Dialogue?](https://img-blog.csdnimg.cn/img_convert/a9a583c33a94ba4467be7e9b1b88712b.png)