本文主要是介绍开发者实战 | 用英特尔独立显卡训练AI智能收银机分类模型,希望对大家解决编程问题提供一定的参考价值,需要的开发者们随着小编来一起学习吧!

文章作者:罗宏裕,张晶;

英特尔独立显卡技术指导:唐文凯

本文将介绍在英特尔® 独立显卡上训练 AI 智能收银机分类模型的全流程,在下一篇中将介绍基于 OpenVINO™ 工具套件在 AIxBoard 上部署训练好的模型,快速实现 AI 智能收银机解决方案基于英特尔平台从模型训练到部署的端到端的关键技术验证。

在阅读本文前,请先在 Ubuntu 22.04 上安装英特尔锐炫™ 独立显卡驱动程序。

01

什么是 AI 智能收银机

“看”一眼就能结账的 AI 智能收银机极大提升了零售店智能化水平和结算效率,推动无人结算零售店时代的到来。以食堂应用场景为例,就餐者自助取餐选菜后,直接将餐盘放在智能结算台上, AI 可以自动识别菜品的种类以及对应价格,然后自动计算出整餐金额,整个过程不到一秒钟。

本文将以 AI 食物图片分类为例,详细介绍在英特尔锐炫™ 独立显卡上训练 PyTorch 版 ResNet 50模型的整个过程。

02

英特尔锐炫™ 独立显卡简介

英特尔锐炫™ 显卡基于 Xe-HPG 微架构, Xe HPG GPU 中的每个 Xe 内核都配置了一组 256 位矢量引擎,旨在加速传统图形和计算工作负载,以及新的 1024 位矩阵引擎或 Xe 矩阵扩展,旨在加速人工智能工作负载。

03

搭建基于英特尔锐炫™ 独立显卡

训练 PyTorch 模型的开发环境

3.1 环境要求

在 Ubuntu 22.04 上基于英特尔独立显卡训练 PyTorch 模型,需要依次安装:

1.英特尔独立显卡的驱动程序

2.英特尔® oneAPI Base Toolkit 2023.0

3.torch 1.13.0a0 和 torchvision 0.14.1a0

4.intel-extension-for-pytorch

3.2 安装英特尔独立显卡的驱动程序

请参考《在 Ubuntu 22.04上安装英特尔锐炫™ 独立显卡驱动程序》完成英特尔独立显卡的驱动安装。安装成功后,可以在 About 窗口 Graphics 一栏看到英特尔独立显卡的型号。

3.3 下载并安装

英特尔® oneAPI Base Toolkit

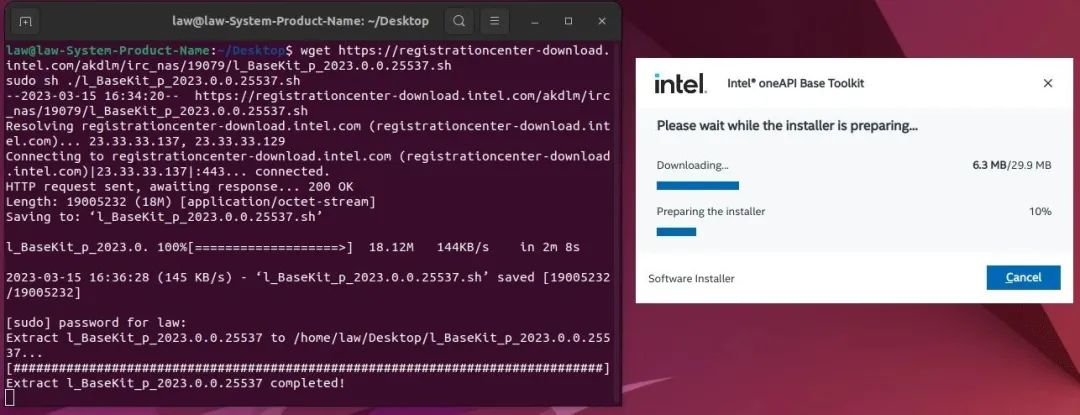

第一步,通过下面的命令下载英特尔® oneAPI Base Toolkit并启动安装程序:

wget https://registrationcenter-download.intel.com/akdlm/irc_nas/19079/l_BaseKit_p_2023.0.0.25537.sh

sudo sh ./l_BaseKit_p_2023.0.0.25537.sh向右滑动查看完整代码

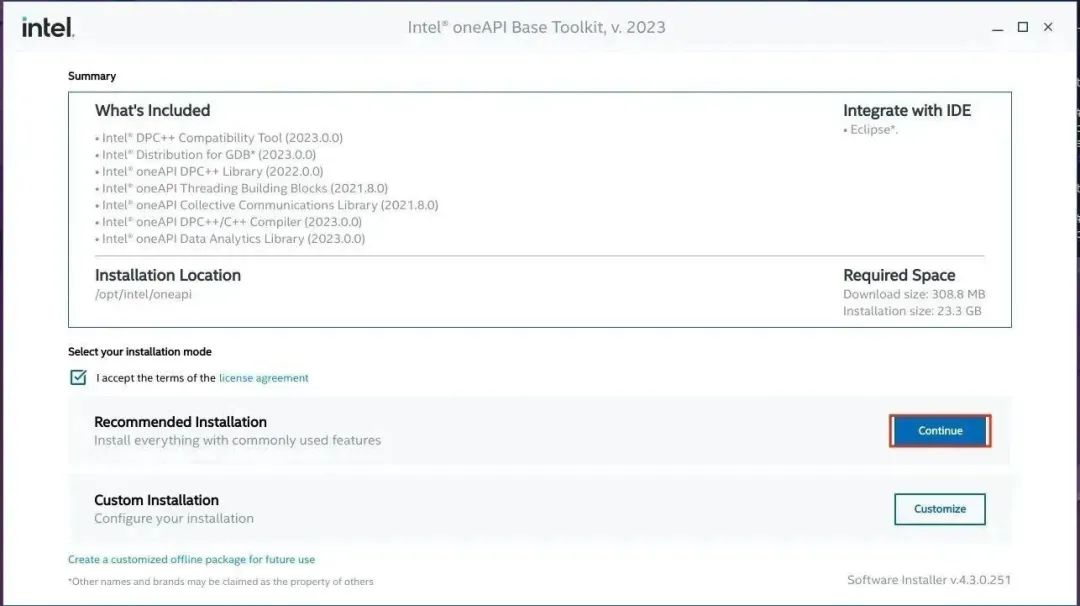

第二步,保持默认选项,完成英特尔® oneAPIBase Toolkit安装

3.4 安装

intel-extension-for-pytorch

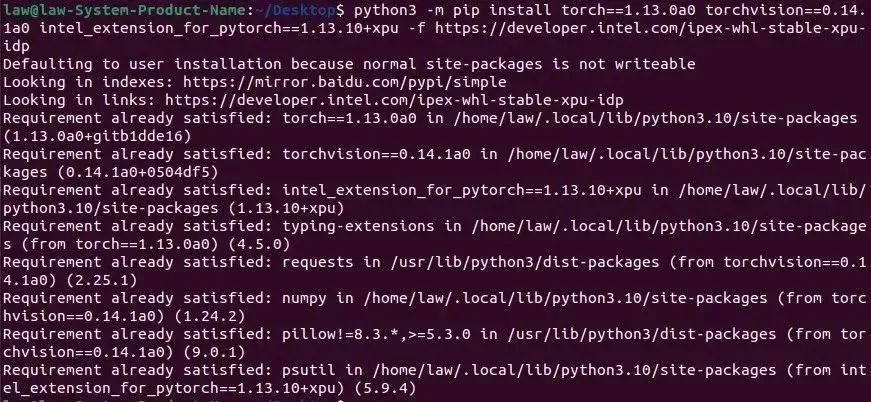

使用命令安装torch、torchvision和intel-extension-for-pytorch:

python -m pip install torch==1.13.0a0 torchvision==0.14.1a0 intel_extension_for_pytorch==1.13.10+xpu -f https://developer.intel.com/ipex-whl-stable-xpu向右滑动查看完整代码

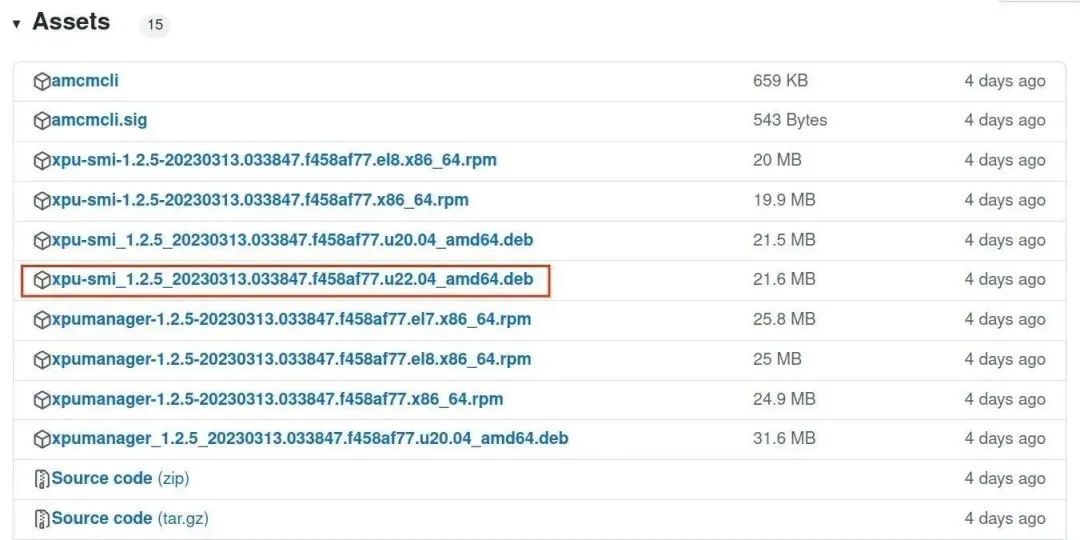

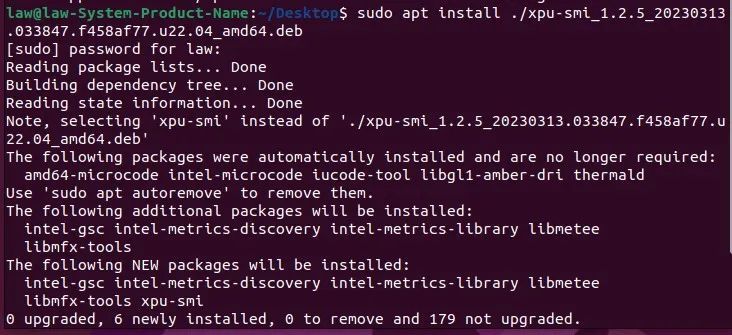

3.5 安装xpu-smi(可选)

英特尔® XPU 管理器是一个免费的开源工具,类似 nvidia-smi,用于监测英特尔独立显卡的运行信息(例如,温度、功耗、频率、显存容量等),也可以用于诊断独立显卡的问题。

安装包下载网站:

https://github.com/intel/xpumanager/releases

然后,通过下面的命令进行安装

sudo apt install ./xpu-smi_1.2.5_20230313.033847.f458af77.u22.04_amd64.deb向右滑动查看完整代码

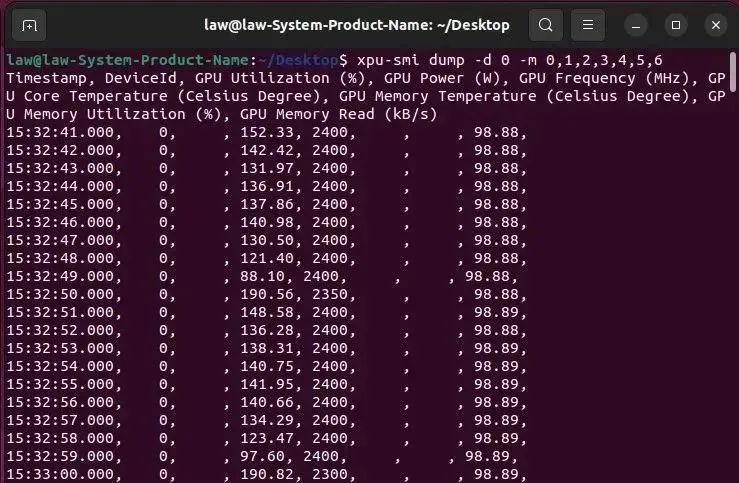

xpu-smi 的使用示例如下所示:

xpu-smi dump -d 0 -m 0,1,2,3,4,5,6向右滑动查看完整代码

到此,在 Ubuntu 平台上用英特尔独立显卡训练 PyTorch 模型的开发环境配置完毕。

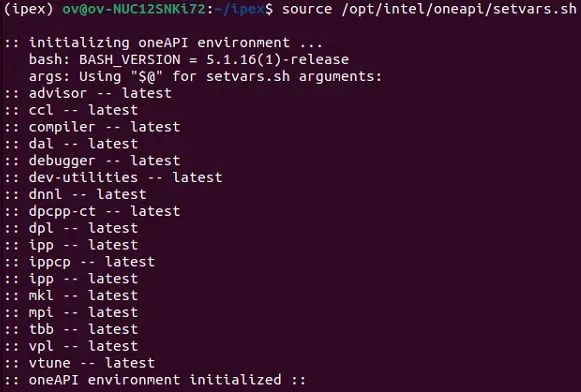

第一步,请通过以下命令激活oneAPI环境:

source /opt/intel/oneapi/setvars.sh向右滑动查看完整代码

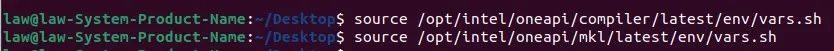

第二步,请通过以下命令激活 DPC++ 编译器和 oneMKL 环境:

source /opt/intel/oneapi/compiler/latest/env/vars.sh

source /opt/intel/oneapi/mkl/latest/env/vars.sh向右滑动查看完整代码

第三步,

请下载 training_on_Intel_dGPU_bf16_ipex.py 并运行,该范例代码使用了 PyTorch 自带的 Food101 数据集和 resnet50 预训练模型参数。

下载地址:

https://gitee.com/ppov-nuc/training_on_intel_GPU/blob/main/training_on_Intel_dGPU_bf16_ipex.py

核心代码片段:

model = torchvision.models.resnet50(weights='IMAGENET1K_V2',num_classes=101)

model = model.to('xpu')

criterion = torch.nn.CrossEntropyLoss()

optimizer = torch.optim.SGD(model.parameters(), lr = LR, momentum=0.9)

model.train()

model, optimizer = ipex.optimize(model, optimizer=optimizer, dtype=torch.bfloat16)

# 训练循环

for epoch in range(epochs):tloss,vloss = 0.0, 0.0top1,top5 = 0.0, 0.0pbar = tqdm(enumerate(train_loader),total=len(train_loader), bar_format=TQDM_BAR_FORMAT)for i, (data, target) in pbar:model.train()data = data.to('xpu')target = target.to('xpu')with torch.xpu.amp.autocast():output = model(data)loss = criterion(output, target)loss.backward()optimizer.step()optimizer.zero_grad()tloss = (tloss*i + loss.item()) / (i+1)if i == len(pbar) - 1:pred,targets,vloss = [], [], 0n = len(val_loader)# 评估训练精度model.eval()with torch.xpu.amp.autocast():for d, (images, labels) in enumerate(val_loader):images = images.to('xpu') labels = labels.to('xpu')y = model(images)pred.append(y.argsort(1, descending=True)[:, :5])targets.append(labels) vloss += criterion(y, labels).item()向右滑动查看完整代码

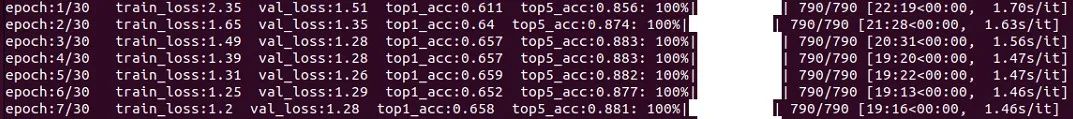

运行结果,如下图所示:

05

总结

本文详细介绍了在 Ubuntu 22.04下使用英特尔独立显卡进行 PyTorch 模型训练,此外,基于单卡英特尔 A750 和 Ubuntu 22.04 的环境,笔者还分别测试了基于 Food101 数据集的 Resnet50 模型和 Resnet101 模型各自的 BF16 格式和 FP32 格式的最大 batch_size 及其训练时的最大显存使用率,方便读者对 batch_size 进行修改,具体结果如下表所示。

_ | BF16 | FP32 |

Resnet50 | batch_size:128 显存使用率:92.09% | batch_size:64 显存使用率:90.41% |

Resnet101 | batch_size:96 显存使用率:98.95% | batch_size:48 显存使用率:96.77% |

--END--

你也许想了解(点击蓝字查看)⬇️➡️ 以AI作画,祝她节日快乐;简单三步,OpenVINO™ 助你轻松体验AIGC

➡️ 还不知道如何用OpenVINO™作画?点击了解教程。➡️ 如何给开源项目做贡献? | 开发者节日福利➡️ 几行代码轻松实现对于PaddleOCR的实时推理,快来get!➡️ 使用OpenVINO 在“端—边—云”快速实现高性能人工智能推理➡️ 图片提取文字很神奇?试试三步实现OCR!➡️【Notebook系列第六期】基于Pytorch预训练模型,实现语义分割任务➡️使用OpenVINO™ 预处理API进一步提升YOLOv5推理性能扫描下方二维码立即体验

OpenVINO™ 工具套件 2022.3点击 阅读原文 立即体验OpenVINO 2022.3

文章这么精彩,你有没有“在看”?

这篇关于开发者实战 | 用英特尔独立显卡训练AI智能收银机分类模型的文章就介绍到这儿,希望我们推荐的文章对编程师们有所帮助!