本文主要是介绍英伟达狂卖50万台GPU!AI爆火背后,是显卡的争夺,希望对大家解决编程问题提供一定的参考价值,需要的开发者们随着小编来一起学习吧!

据市场跟踪公司Omdia的统计分析,英伟达在第三季度大约卖出了50万台H100和A100 GPU!

此前,Omdia通过英伟达第二季度的销售额,估计其大概卖出了900吨GPU!

大语言模型火爆的背后,英伟达建立起了强大的显卡帝国。

在人工智能的大潮之下,GPU成为了各机构、公司,甚至是国家在全球范围内争夺的对象。

在本财年第三季度,Nvidia在数据中心硬件上获得了145亿美元的收入,比去年同期几乎翻了两番。

——这显然得益于随着人工智能和高性能计算(HPC)的发展而变得炙手可热的H100 GPU。

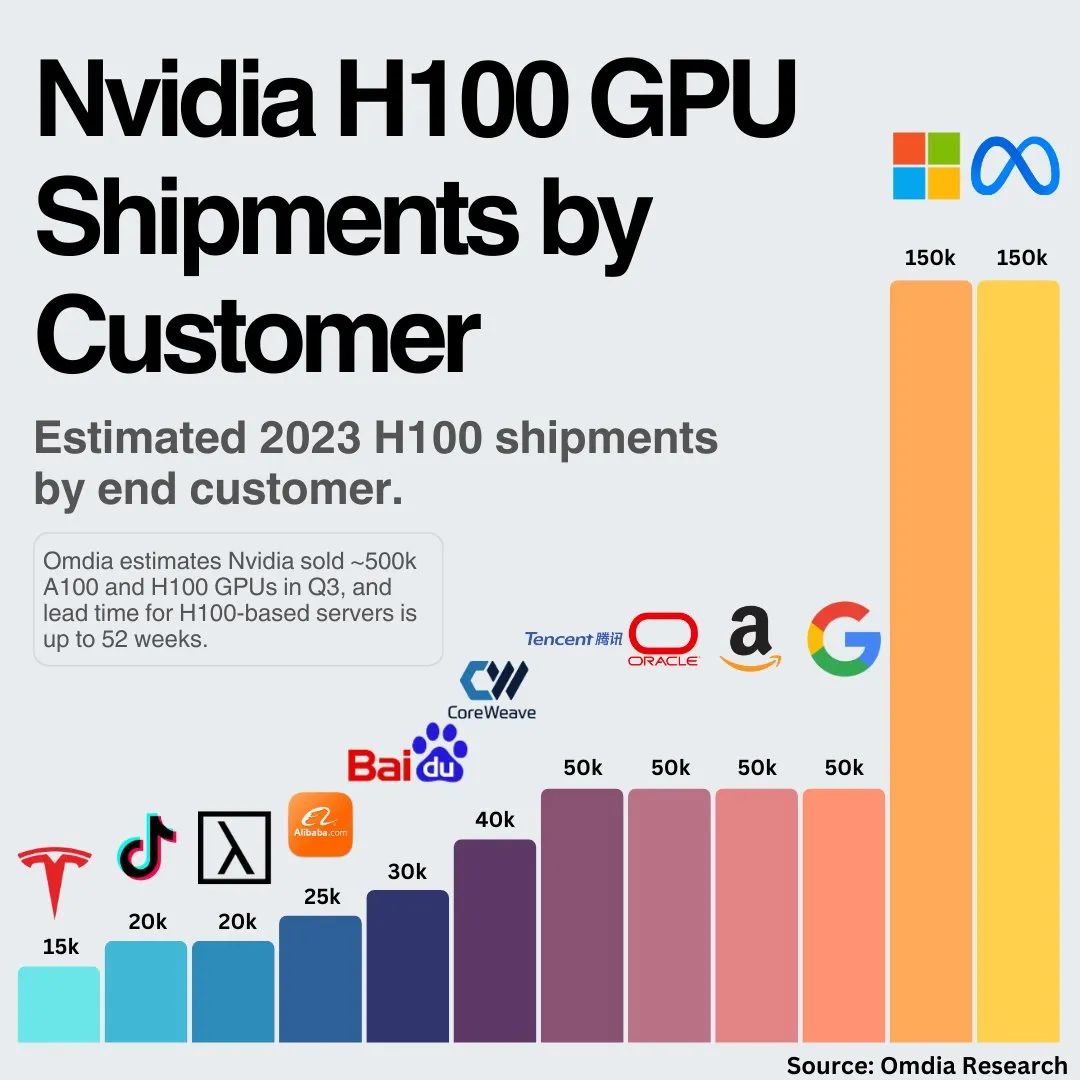

市场跟踪公司Omdia表示,Nvidia售出了近50万个A100和H100 GPU,庞大的需求量也导致了,基于H100的服务器需要36~52周的时间才能交付。

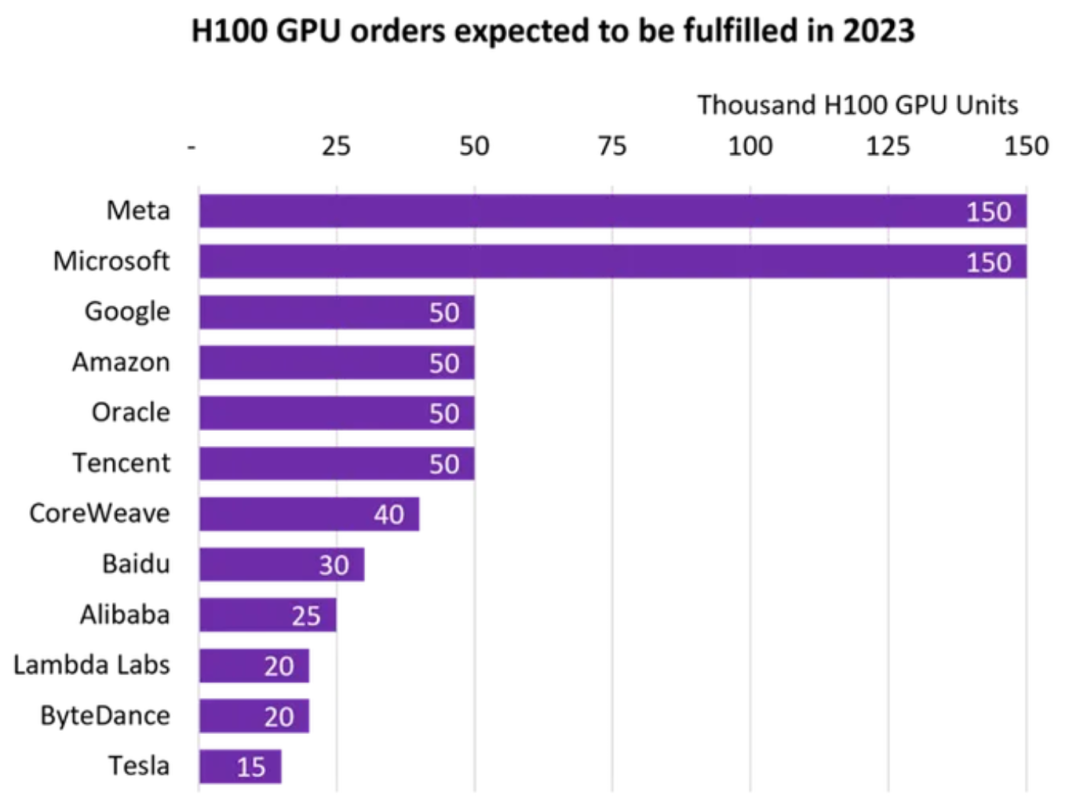

从上图可以看出,Meta和微软是最大买家。它们各自采购了多达15万个H100 GPU,大大超过了谷歌、亚马逊、甲骨文和腾讯采购的数量(各5万个)。

值得注意的是,大多数服务器GPU都供应给了超大规模云服务提供商。而服务器原始设备制造商(如戴尔、联想、HPE)目前还无法获得足够的AI和HPC GPU。

Omdia预计,到2023年第四季度,Nvidia的H100和A100 GPU的销量将超过50万台。

不过,几乎所有大量采购Nvidia H100 GPU的公司都在为人工智能、HPC和视频工作负载开发定制自己的芯片。

因此,随着他们转向使用自己的芯片,对Nvidia硬件的采购量可能会逐渐减少。

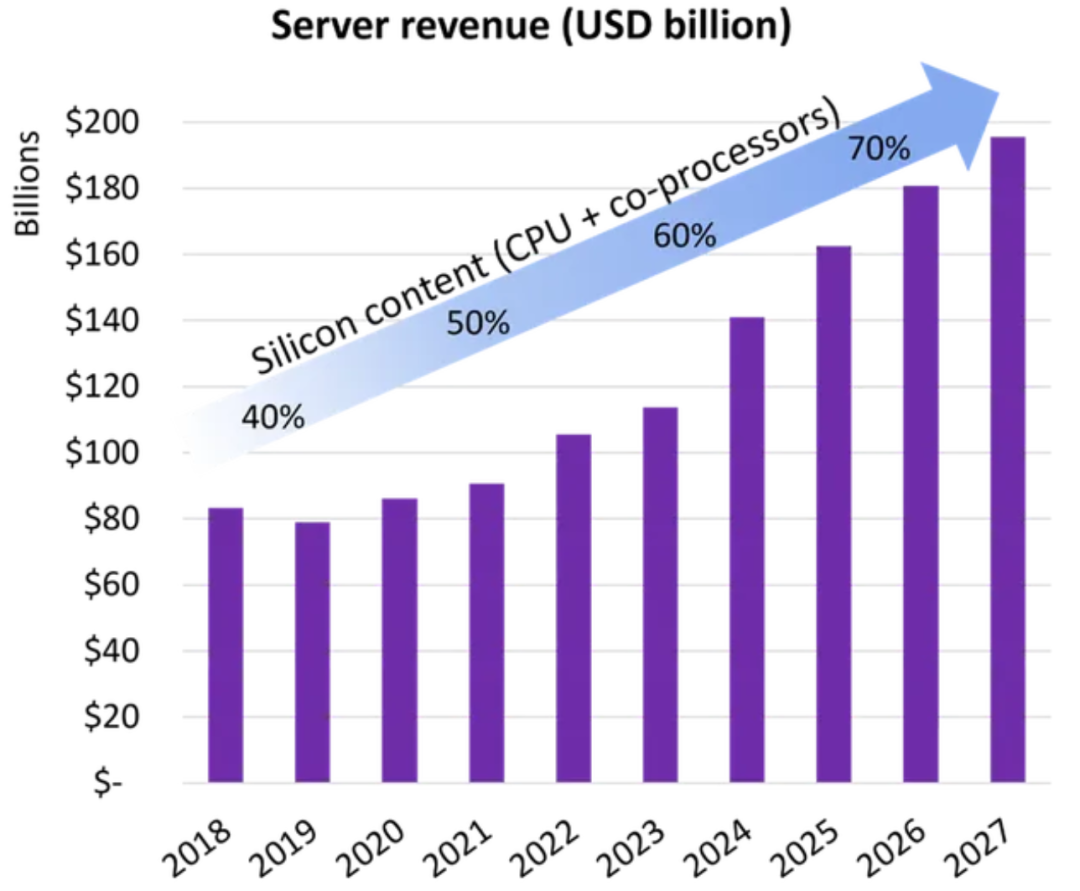

上图统计了服务器的情况,2023年服务器出货量同比下跌了17%到20%,而服务器收入则同比上涨了6%到8%。

Omdia云和数据中心研究实践总监Vlad Galabov和数据中心计算和网络首席分析师Manoj Sukumaran预计,到2027年,服务器市场价值将达到1956亿美元,比十年前翻一番多。

随着大公司纷纷转向超异构计算,或使用多协处理器来优化服务器配置,服务器处理器和协处理器的需求将持续增长。

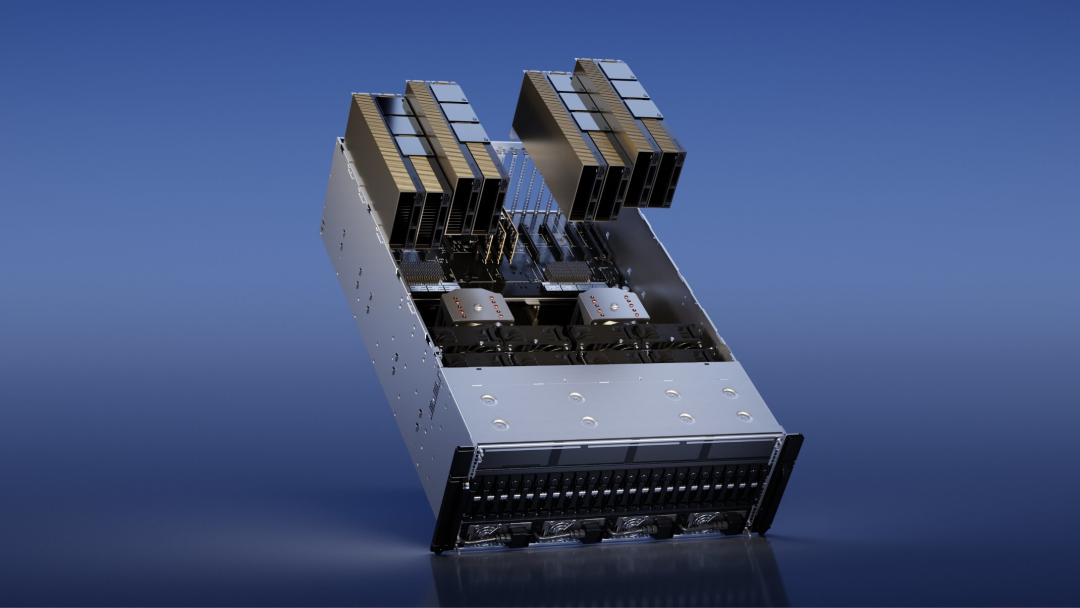

目前,就运行人工智能训练和推理的服务器而言,用于大型语言模型训练的最流行服务器是配置了8个H100/A100 GPU的Nvidia DGX服务器,以及亚马逊的配置了16个定制协处理器(Inferentia 2)的AI推理服务器。

而对于配备了许多定制协处理器的视频转码服务器,最流行的是拥有20个VCU(视频编码单元)的谷歌视频转码服务器,以及使用了12个可扩展视频处理器的Meta视频处理服务器。

随着一些应用的需求逐渐成熟,构建优化定制处理器的成本效益会越来越高。

媒体和人工智能会是超异构计算的早期受益者,之后数据库和网络服务等其他工作负载也会出现类似的优化。

Omdia的报告指出,高度配置的人工智能服务器的增加正在推动数据中心物理基础设施的发展。

例如,今年上半年的机架配电收入比去年增长了17%,在需要液体冷却解决方案的趋势之下,数据机柜热管理收入有望在2023年实现17%的增长。

另外,随着生成式人工智能服务的普及,企业将广泛采用AI,而当前人工智能部署速度的瓶颈可能是电力供应。

热情的买家们

除了上面提到的巨头们,「民间」也有各种组织和公司纷纷采购NVIDIA的H100,以发展自己的业务,或者投资未来。

Bit Digital是一家提供数字资产和云计算服务的可持续数字基础设施平台,总部位于纽约。公司已与客户签订条款,开展Bit Digital AI业务,为客户的GPU加速工作负载提供支持。

根据协议,Bit Digital将为客户提供最少1024个、最多4096个GPU的租赁服务。

同时,Bit Digital公司已同意购买1056块NVIDIA H100 GPU,并已支付了首笔定金。

由美国公司Del Complex创建的BlueSea Frontier Compute Cluster(BSFCC)本质上是一艘巨大的驳船,包含 10000个Nvidia H100 GPU,总价值5亿美元。

据路透社报道,一家名为Voltage Park的非营利组织以5亿美元的价格收购了24000个Nvidia H100芯片。

Volatage Park是一家人工智能云计算组织,由亿万富翁Jed McCaleb资助,计划为人工智能项目租赁计算能力。

Voltage Park提供的GPU价格低至每GPU每小时1.89美元。按需租赁的客户可以租用1到8个GPU,希望租用更多GPU的用户则需要保证一定的租赁期限。

与之相比,亚马逊通过8台H100的P5节点为用户提供按需服务,但价格要贵得多。

以8卡的节点来计算,AWS的收费为每小时98.32美元,而Voltage Park的收费为每小时15.12美元。

在人工智能的热潮之下,英伟达也是雄心勃勃。

据英国《金融时报》报道,这家硅谷芯片巨头希望提高H100处理器的产量,目标是明年出货150万至200万台。

由于ChatGPT等大型语言模型的爆火,今年5月,Nvidia市值飙升,成功跻身万亿美元俱乐部。

作为开发大型语言模型的基础组件,GPU成为了人工智能公司,甚至是国家在全球范围内争夺的对象。

《金融时报》称,沙特阿拉伯和阿联酋已经购买了数千台英伟达的H100处理器。

与此同时,有富裕资金的风险投资公司,也忙着为投资组合中的初创公司购买GPU,以建立自己的人工智能模型。

GitHub前首席执行官Nat Friedman和Daniel Gross曾支持过GitHub、Uber和其他许多成功的初创公司,他们购买了数千个GPU,并建立了自己的人工智能云服务。

这个名为仙女座集群(Andromeda Cluster)的系统,拥有2512个H100 GPU,能够在大约10天内训练出一个650亿参数的人工智能模型。虽然不是目前最大的模型,但也相当可观。

尽管只有两位投资人支持的初创企业,才能使用这些资源。此举还是受到了好评。

Anthropic的联合创始人Jack Clark表示,个人投资者在支持计算密集型初创企业方面所做的工作超过了大多数政府。

相比于第三季度的145亿,第二季度,Nvidia售出了价值103亿美元的数据中心硬件。

对于这个成绩,Omdia曾作出估计:一个带有散热器的Nvidia H100计算GPU的平均重量超过3公斤(6.6 磅),而Nvidia在第二季度出货了超过30万台 H100,算下来总重量超过900吨(180 万磅)。

让我们把这900吨具象化一点,它相当于:

4.5架波音747

11架航天飞机轨道飞行器

215827加仑水

299辆福特F150

181818台PlayStation 5s

32727只金毛猎犬

有网友对此表示:

不过也有媒体觉得这个估计不太准确。因为Nvidia H100有三种不同的外形,重量也各不相同。

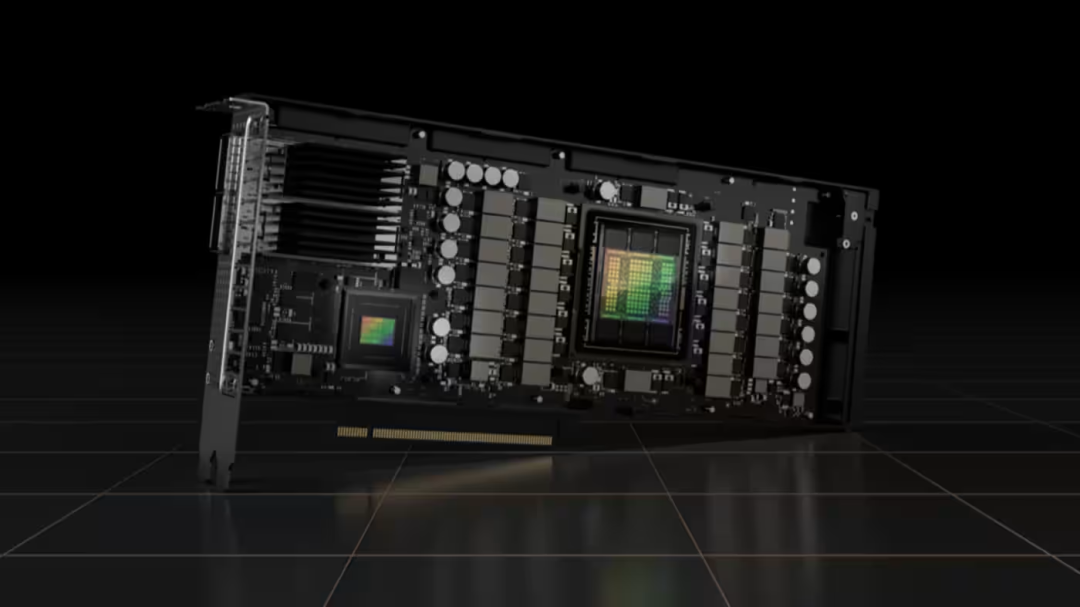

Nvidia H100 PCIe显卡重1.2千克,而带散热片的OAM模块的最高重量为2千克。

假设Nvidia H100出货量的80%是模块,20%是显卡,那么单个H100的平均重量约为1.84千克左右。

不管怎样吧,这都是一个惊人的数字。而且英伟达在第三季度的销量是显著增长的,如果按照50万块GPU每块2千克,那么总重量就是1000吨。

——现在的显卡都是按吨卖的了,不知道大家怎么看?

这篇关于英伟达狂卖50万台GPU!AI爆火背后,是显卡的争夺的文章就介绍到这儿,希望我们推荐的文章对编程师们有所帮助!