本文主要是介绍人工智能基础_机器学习050_对比sigmoid函数和softmax函数的区别_两种分类器算法的区别---人工智能工作笔记0090,希望对大家解决编程问题提供一定的参考价值,需要的开发者们随着小编来一起学习吧!

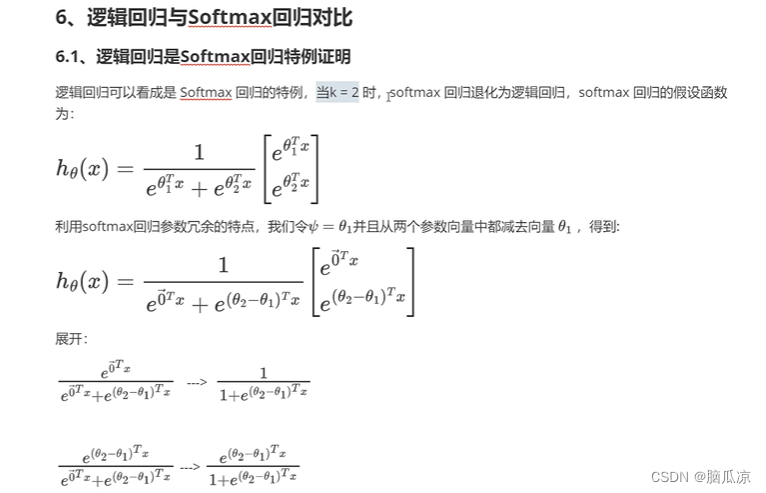

可以看到最上面是softmax的函数对吧,但是如果当k = 2 那么这个时候softmax的函数就可以退化为sigmoid函数,也就是 逻辑斯蒂回归了对吧

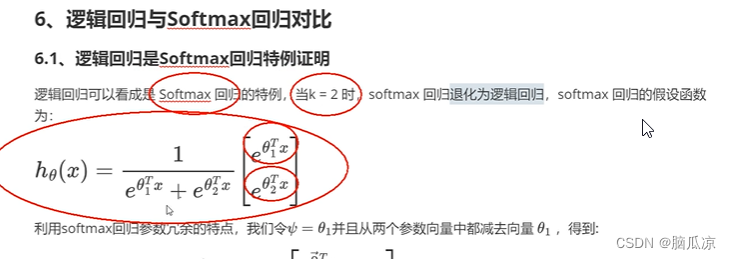

我们来看一下推导过程,可以看到上面是softmax的函数

可以看到k=2 表示,只有两个类别对吧,两个类别的分类不就是sigmoid函数嘛对吧,所以说

如果k=2 那么softmax就退化为sigmoid函数了,来处理二分类了

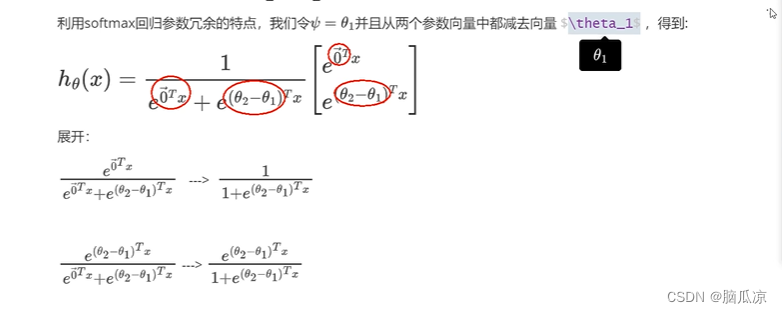

可以看到上面有个theta1对吧

softmax函数是一种激活函数,它可以将一个数值向量归一化为一个概率分布向量,且各个概率之和为1。在多分类问题中,softmax函数可以将其压缩为长度为KKK,值在[0,1][0,1][0,1]范围内,并且向量中元素的总和为1的实向量。其中k表示分类的类别个数。因此,softmax函数的k=2表示有2个分类类别。

可以看到我们让两边都减去一个向量theta1对吧,也就是减掉一个theta类别,然后

我们看看公式就发生了变化对吧,这里的etheta1现在就可以写成e0了

这篇关于人工智能基础_机器学习050_对比sigmoid函数和softmax函数的区别_两种分类器算法的区别---人工智能工作笔记0090的文章就介绍到这儿,希望我们推荐的文章对编程师们有所帮助!