本文主要是介绍利用BeautifulSoup库爬取虎扑湖区评论并且制作词云(二),希望对大家解决编程问题提供一定的参考价值,需要的开发者们随着小编来一起学习吧!

通过之前使用request库和BeautifulSoup库爬取得到了虎扑湖区前几页的帖子评论,接下里就要通过这些评论来制作词云。

1利用中文分词库jieba来分词

要想从评论中获取话题热度最高的词汇,我们需要将这些评论分成一个个的词汇,中文分词不像英文那般简单,还好jieba为我们提供了这样的功能。

首先通过pip安装jieba库,管理员权限打开cmd,输入pip install jieba

jieba安装好之后,对我之前爬取的评论进行分词,一开始发现效果并不是很好,通过查阅资料知道,一般在分词的时候我们还要载入一个停用词表,以此来剔除一些常见的时间,地点状语和一些连接词,口气词以及标点符号。停用词表百度就可以直接下载别人所停供的常见的停用词。

此外,由于在NBA打球的一些球星的名字和外号都是jieba词库中没有的,我们需要手工加入一些球星的姓名,外号以及一些常见的NBA术语。代码如下:

import jieba.analyse

from wordcloud import WordCloud

import PIL

import matplotlib.pyplot as plt

import numpy as npdef main():a = []path = 'D:/NoteComments11-25.txt'fp = open(path, 'r', encoding='UTF-8')content = fp.read()jieba.add_word("英格拉姆")jieba.add_word("老詹")jieba.add_word("武切维奇")# 11-26日主场打魔术,所以把识别不出的魔术中锋武切维奇加入jieba词库try:jieba.analyse.set_stop_words('D:/stopWords.txt')tags = jieba.analyse.extract_tags(content, topK=100, withWeight=True)for item in tags:# print(item[0]+'t'+str(int(item[1]*10000)))a.append(item[0])finally:fp.close()txt = r' '.join(a)wordcloudplot(txt)

在这里我们找出出现词频最高的100个词,并将他们按照出现次数的多少依次保存到数组a中

2利用wordcloud库生成词云

首先我们需要通过pip下载获取wordcloud库和matplotlib库(下载过程中楼主出现了下载失败的情况,此时我们可以通过更换下载源来实现成功下载)。

将词汇分好之后我们引入一个函数wordcloundplot,通过此函数来制作一个词云图。

def wordcloudplot(txt):path = 'D:/SentyTang/SentyTang.ttf'lakers_mask = np.array(PIL.Image.open('D:/Lakerskobe2.jpg'))wordcloud = WordCloud(background_color="white",font_path=path,margin=5,width=1800,height=1800,mask=lakers_mask,max_words=200,max_font_size=200,random_state=42)wordcloud = wordcloud.generate(txt)wordcloud.to_file('D:/lakersWordCloud.jpg')plt.imshow(wordcloud)plt.axis("off")plt.show()

由于wordcloud本身是不支持中文词云的,此时中文会被显示为一个个的方块,这时候我们需要提供给wordcloud字体,在这里楼主用的唐朝体,可以根据自己的喜好更换。

然后对wordcloud设置一系列的参数来制作词云

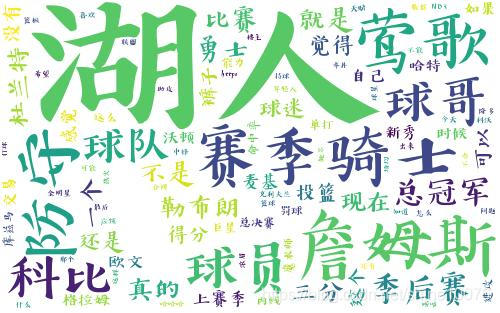

最终词云的效果图如下

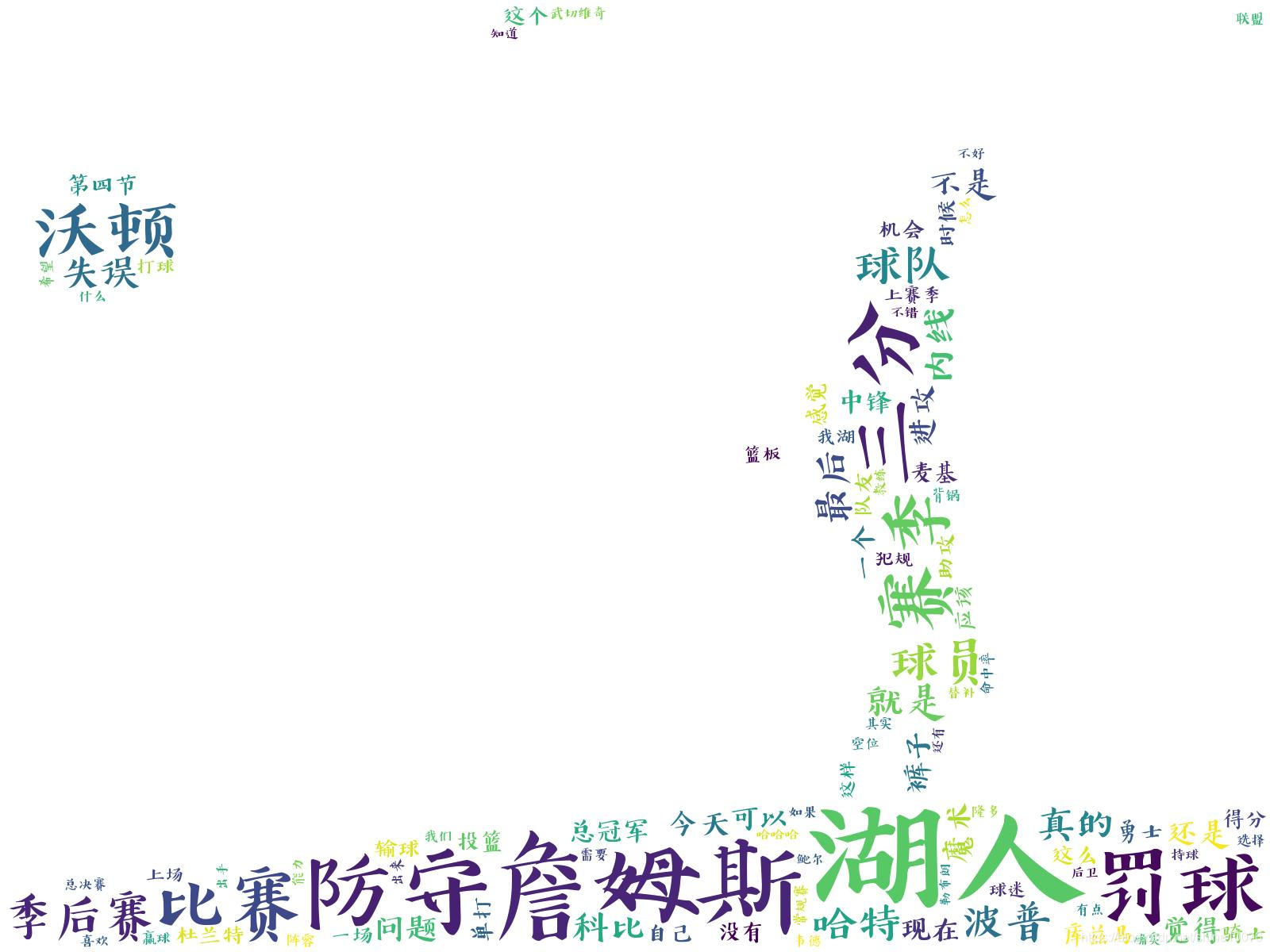

这样看上去还是有一点单调,所以我们可以通过设置mask参数来制作指定形状的词云,楼主使用一张科比的图片。

最终词云的效果图如下:

这篇关于利用BeautifulSoup库爬取虎扑湖区评论并且制作词云(二)的文章就介绍到这儿,希望我们推荐的文章对编程师们有所帮助!