本文主要是介绍找到【SVM】中最优的惩罚项系数C,希望对大家解决编程问题提供一定的参考价值,需要的开发者们随着小编来一起学习吧!

因为本来SVM是想找到间隔最大的分割面,所以C越大,SVC会选择边际更小的,能够更好的分类所有训练点的决策边界,不过模型的训练时间也会越长。如果C的设定值较小,那SVC会尽量最大化边界,决策功能会更简单,但代价是训练的准确度。

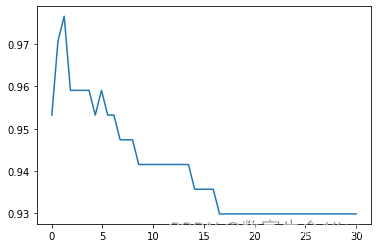

我们先来调线性核函数:

#调线性核函数

score = []

C_range = np.linspace(0.01,30,50)

for i in C_range:clf = SVC(kernel="linear",C=i,cache_size=5000).fit(Xtrain,Ytrain)score.append(clf.score(Xtest,Ytest))

print(max(score), C_range[score.index(max(score))])

plt.plot(C_range,score)

plt.show()输出结果为:0.9766081871345029 1.2340816326530613

可以看到准确率最高是97%以上。接下来我们来看看在rbf上的结果:

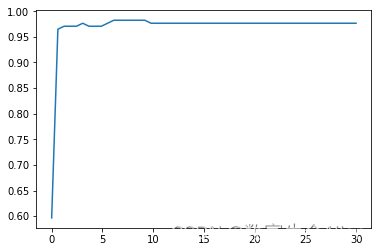

score = []

C_range = np.linspace(0.01,30,50)

for i in C_range:clf = SVC(kernel="rbf",C=i,gamma = 0.012742749857031322,cache_size=5000).fit(Xtrain,Ytrain)score.append(clf.score(Xtest,Ytest))print(max(score), C_range[score.index(max(score))])

plt.plot(C_range,score)

plt.show()输出结果为:0.9824561403508771 6.130408163265306

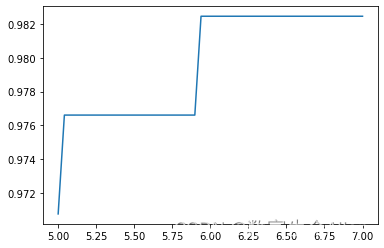

既然最高的得分所对应的C值是6,那么我们可以在5-7之间进一步细化,看能否找到一个更好的局部最优:

#进一步细化

score = []

C_range = np.linspace(5,7,50)

for i in C_range:clf = SVC(kernel="rbf",C=i,gamma =

0.012742749857031322,cache_size=5000).fit(Xtrain,Ytrain)score.append(clf.score(Xtest,Ytest))print(max(score), C_range[score.index(max(score))])

plt.plot(C_range,score)

plt.show()输出结果为:0.9824561403508771 5.938775510204081

可以看到,98.2456%就是我们最好的得分。

这篇关于找到【SVM】中最优的惩罚项系数C的文章就介绍到这儿,希望我们推荐的文章对编程师们有所帮助!