本文主要是介绍A100-PCIE-40GB with CUDA capability sm_80 is not compatible with the current PyTorch installation,希望对大家解决编程问题提供一定的参考价值,需要的开发者们随着小编来一起学习吧!

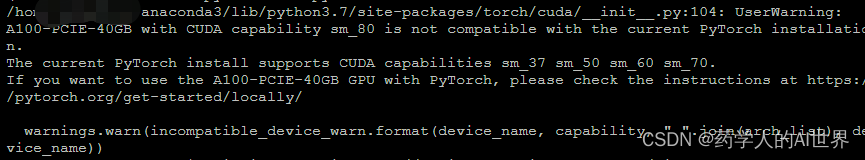

Pytorch报错:

使用以下命令进行安装,成功安装运行:

pip3 install torch==1.9.0+cu111 torchvision==0.10.0+cu111 torchaudio==0.9.0 -f https://download.pytorch.org/whl/torch_stable.html

Reference:

https://stackoverflow.com/questions/66992585/how-does-one-use-pytorch-cuda-with-an-a100-gpu#

这篇关于A100-PCIE-40GB with CUDA capability sm_80 is not compatible with the current PyTorch installation的文章就介绍到这儿,希望我们推荐的文章对编程师们有所帮助!