本文主要是介绍论文阅读笔记《Training Socially Engaging Robots Modeling Backchannel Behaviors with Batch Reinforcement Lea,希望对大家解决编程问题提供一定的参考价值,需要的开发者们随着小编来一起学习吧!

Training Socially Engaging Robots Modeling Backchannel Behaviors with Batch Reinforcement Learning

训练社交机器人:使用批量强化学习对反馈信号行为进行建模

发表于TAC 2022。

Hussain N, Erzin E, Sezgin T M, et al. Training Socially Engaging Robots: Modeling Backchannel Behaviors with Batch Reinforcement Learning[J]. IEEE Transactions on Affective Computing, 2022, 13(4): 1840-1853.

介绍

研究背景

社交机器人正在越来越多地融入到日常生活中,因此需要设计更具社交能力的机器人。而这种机器人应该可以与人类进行人机交互(HRI),使其被感知为类似于人与人之间的互动。社交机器人的一个重要特征是其持续用户参与度的能力。

研究现状

许多人将参与度作为人机交互的共同目标和衡量其成功的指标。如何吸引对话者参与互动是一个关键策略,通过语言和非语言提示来实现。然而,监督学习中学得的行为无法比数据集的参考行为表现得更好。

最近的研究已经展示了使用在线强化学习(RL)进行参与度最大化的例子。但在线方法需要直接与用户进行交互,训练时间长且可能惹人不满。

本文贡献

本文使用批量强化学习(batch-RL)以离线方式训练机器人进行参与行为,并提出了一种新的算法——Sequential Random Deep Q-Network (SRDQN)。

方法

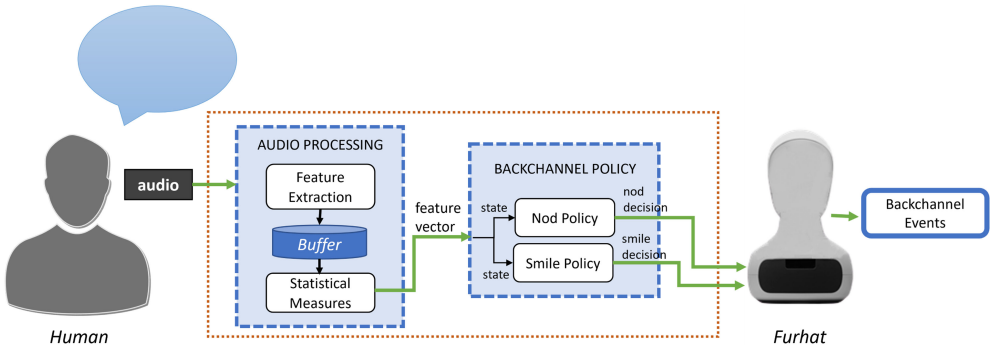

马尔可夫状态表示

本文使用用户语音中Mel-Frequency Cepstrum Coefficients(MFCCs)和声调特征的统计概括来表示用户状态。语音特征以40 Hz的速率确定。

MFCCs是一种用于语音信号处理的特征提取方法,它模拟出人类听觉系统的感知机理。简单来说,MFCCs将语音信号转换成一组能够表达语音信息的数字特征向量。

MFCC是使用40ms汉明窗口计算的13维向量。

声调特征定义为由语音强度,音高和置信度到音高及其一阶导数组成的6维向量。

这两种特征在每个25ms时间步长处连接以创建一个19维特征向量。

过程的状态是根据语音特征历史定义的。通过计算11个统计量(平均值、标准差、偏度、峰度、范围、最小值、最大值、第一四分位数、第三四分位数、中位数和四分位距)来执行特征概括,这些统计量是针对一秒语音特征(40个样本)执行的。

所得到的209维状态特征描述了语音特征的短期分布。机器人的最优策略将定义一个点头(或微笑)行为作为后继行为,取决于用户语音特征,以最大化奖励,即用户参与度。

在本文的MDP公式中,奖励 r t r_t rt 由 E ( t ) E(t) E(t) 给出,该值在实验中计算的时间窗口大小为15秒,以避免奖励函数的突然变化,因为人类的参与度也是随时间缓慢变化的。

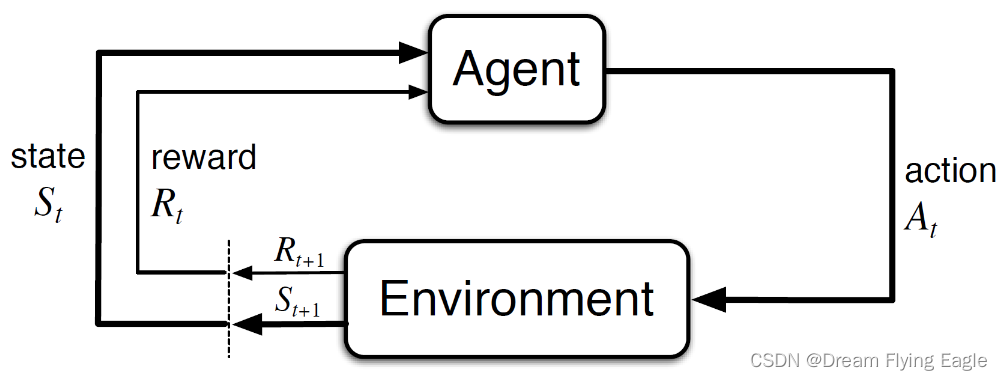

顺序随机深度 Q-Network(SRDQN)

SRDQN作为一种离线批量强化学习算法,用于在人机交互期间学习机器人的backchannel策略。它属于 Q 学习算法类别。 Q π ( s , a ) Q^{\pi}(s,a) Qπ(s,a) 表示从特定状态动作元组开始的预期未来回报。 SRDQN 的目标是仅使用存储在经验重放缓冲区 D D D 中的先前收集的转换样本 ( s t , a t , r t , s t + 1 ) (s_t,a_t,r_t,s_{t +1}) (st,at,rt,st+1) 来学习最佳 Q 值函数。

SRDQN使用多层感知器估计 Q Q Q 值,SRDQN 遵循将 Bellman 控制方程拟合到 D D D 中的样本的迭代过程。使用参数化权重 θ \theta θ 的神经网络 Q θ Q_{\theta} Qθ 估计 Q Q Q 值。一个单独的网络 Q ^ θ ′ \hat{Q}_{\theta'} Q^θ′ 确定目标值,由 θ ′ \theta' θ′ 参数化,该目标值每 N 梯度更新后定期更新。目标值 y t y_t yt 和时序差分误差 e e e 的表示如下:

KaTeX parse error: No such environment: eqnarray at position 8: \begin{̲e̲q̲n̲a̲r̲r̲a̲y̲}̲{} y_t &=&r_t+\…

未来奖励按每个时间步骤折现因子 γ = 0.99 \gamma = 0.99 γ=0.99。

定义损失函数:

L = { 0.5 e 2 , if ∣ e ∣ < 1 ∣ e ∣ − 0.5 , o t h e r w i s e \mathcal{L}=\left\{ \begin{array}{} 0.5e^2,&\textrm{if $|e|<1$}\\ |e|-0.5,&otherwise \end{array} \right. L={0.5e2,∣e∣−0.5,if ∣e∣<1otherwise

为什么要用一个目标网络?

DQN算法在训练过程中,使用一个神经网络来估计当前状态下所有可能动作的Q值。然而,这个神经网络的参数是通过反向传播来更新的,即每次计算误差时都会对当前状态的Q值产生影响,从而导致估计偏差和不稳定性。

为了解决这个问题,DQN算法引入了目标网络的概念。目标网络是一个与主网络结构相同的神经网络,但其参数固定不变,只在一定的时间间隔内进行更新。这样做的目的是为了减少当前状态Q值的不稳定性,提高学习效率。具体原因如下:

- 减少估计偏差:由于目标网络的参数不发生变化,使得在一定时间窗口内,对于某一个状态下的动作Q值的估计更加稳定,减少了估计偏差。

- 提高训练稳定性:由于目标网络的参数不发生变化,每个样本的训练目标也变得更加稳定,使得训练过程更加稳定可靠。

- 增大收敛速度:由于目标网络的参数不发生变化,使得每个样本的训练目标保持不变,加速了算法的收敛速度。

综上所述,DQN算法使用目标网络来估计Q值,可以提高算法的学习效率和稳定性。

SRDQN 中的第一个关键思想是,经验重放缓冲区的容量 C 要比从数据集创建的整个批次小得多。虽然 IEMOCAP 数据集有 12 小时的记录,但回放缓冲区 D D D 仅存储过去 2 分钟的数据。本文的人机交互数据集中的参与者展示了一系列情绪,在不同场景中的底层策略有很大差异。从整个批次中进行随机采样将导致更新存在很大差异。使用短期重放缓冲区从缓慢变化的采样分布进行目标更新可以稳定训练过程。

SRDQN 中的第二个关键思想是使用长度为 m m m 的轨迹 ( s 1 , a 1 , r 1 , . . . , s m , a m , r m , s m + 1 ) (s_1, a_1, r_1, ... , s_m, a_m, r_m, s_{m + 1}) (s1,a1,r1,...,sm,am,rm,sm+1) 进行更新。这与 DQN 相反,DQN 是从随机、不相关的样本中进行更新的。在 SRDQN 中,回放缓冲区 D D D 按顺序存储样本。在每个更新步骤中,从 D D D 中随机选择一个内存索引 i i i,从索引 i i i 开始,选择 m m m 个连续样本来创建 minibatch。因此,每次更新都是从顺序相关的样本中执行的。作者解释人机交互问题的本质上是一个部分可观察的问题,其中只有观察值 (o) 可用于某些状态分布。引入顺序性到学习中允许 Q-network 更好地估计底层系统状态,缩小 Q ( o , a ∣ θ ) Q(o,a|\theta) Q(o,a∣θ) 和 Q ( s , a ∣ θ ) Q(s,a|\theta) Q(s,a∣θ) 之间的差距。

离线训练

批量强化学习算法仅利用以元组形式记录的先前收集的数据 ( s t , a t , r t , s t + 1 ) (s_t,a_t,r_t,s_{t+1}) (st,at,rt,st+1) 。这种基于数据的离线方法允许处理大型数据集,任何具有各种参与度值范围注释的足够大的数据集都可以用作转移的离线批次。本文使用用于分析表现人类交互的IEMOCAP数据集,它由十个职业演员在8个虚构场景和3个剧本中的151个对话组成。对话采用一对一的形式,对其中一个演员标记backchannel动作(点头和微笑),另一个演员提供状态(语音特征)和奖励(参与度)。

使用多层感知器(MLP)建模函数逼近网络。对于点头和微笑行为的 Q 网络使用相同的架构。函数逼近器采用 209 维输入向量(状态特征大小),具有两个隐藏层,分别有 100 和 25 个神经元,并输出两个动作的 Q 值,“什么也不做”和“生成反馈”(点头或微笑)。在每个线性层之间应用 ReLU 激活函数。使用 Adam 优化器和指数衰减学习率来更新训练期间的网络权重。

本文的实验表明,当使用数据集中的状态进行评估时,策略会频繁生成backchannel。本文通过简单的惩罚奖励来处理学习到的策略与行为策略之间的大偏差。本文引入超参数奖励因子 ( κ \kappa κ) 以缩放训练期间的奖励。对于 κ ≤ 1 \kappa \le 1 κ≤1,批处理数据的奖励会被修改,使得反馈数量减少,但不会比数据集中的反馈更少。在所有实验中, κ \kappa κ 设置为 0.9。

r t ′ = { r t , if a t ="do nothing" κ r t , if a t ="generate backchannel" r'_t=\left\{ \begin{array}{} r_t,& \textrm{if $a_t$="do nothing"}\\ \kappa r_t,& \textrm{if $a_t$="generate backchannel"} \end{array} \right. rt′={rt,κrt,if at="do nothing"if at="generate backchannel"

实现了三种批量强化学习方法来训练 点头/微笑 行为的模型:神经拟合 Q 学习(NFQ),深度 Q 网络(DQN)和SRDQN。将数据集按4:1的比例分为训练集和评估集。对于每种方法,进行五次训练,每次训练 1500 个轮次,以解决训练重复时收敛策略的变化问题。最终的反馈策略是通过五个贪婪策略的投票来确定的。3 或以上的多数投票会触发反馈。

策略评估

离线评估

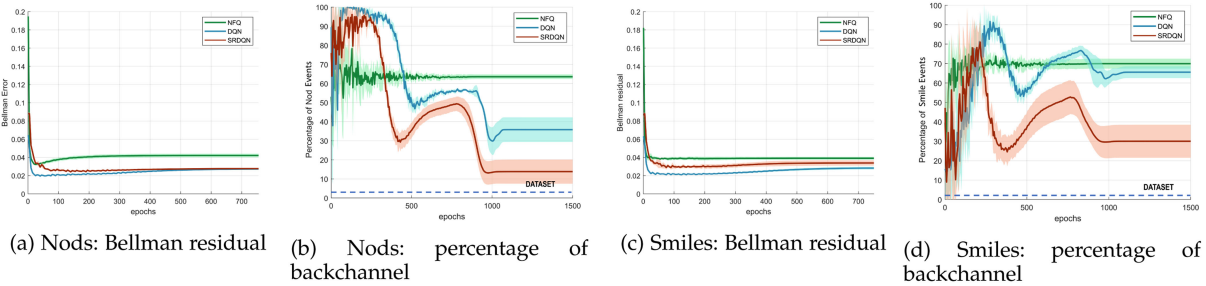

**贝尔曼误差:**较小的误差意味着学习出的策略更接近最优策略,并且表示真实的Q函数。图3a和3c分别显示了点头和微笑的Bellman残差与时代数的关系。由实线表示5个训练会话的平均值。每条曲线都显示出误差的下降趋势。

backchannel频率:NFQ策略预测在训练结束时高频出现点头(63%)和微笑(70%)。图3b和3d显示了随着训练的进行,回应事件预测的比例。SRDQN明显超越了两种算法,预测点头的比例为13%,微笑的比例为30%。这些值更接近数据集中backchannel的实际百分比(1.3%微笑和2.5%点头)。

与人类行为的相似性

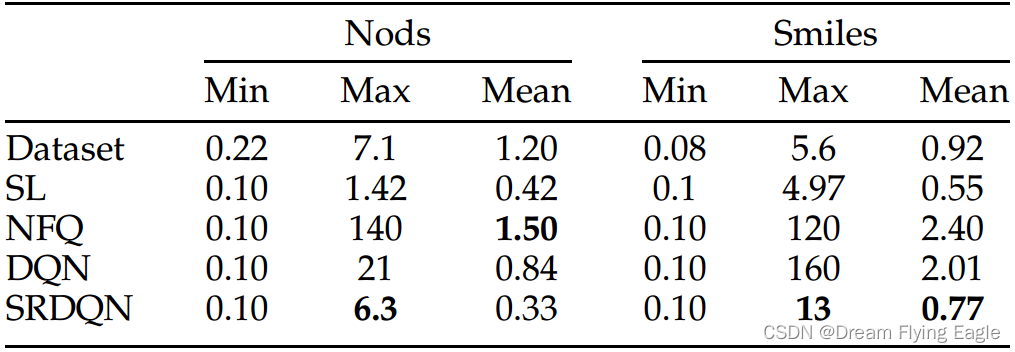

这项指标评估backchannel行为持续时间与人类相似度。本文通过观察最小值、最大值和平均值的统计度量来分析相似性。表1显示了点头和微笑策略产生的backchannel事件持续时间与人类相似度的统计相似性。总体而言,观察到SRDQN在最大和平均两个度量方面表现优异。

人机交互实验

实验设置

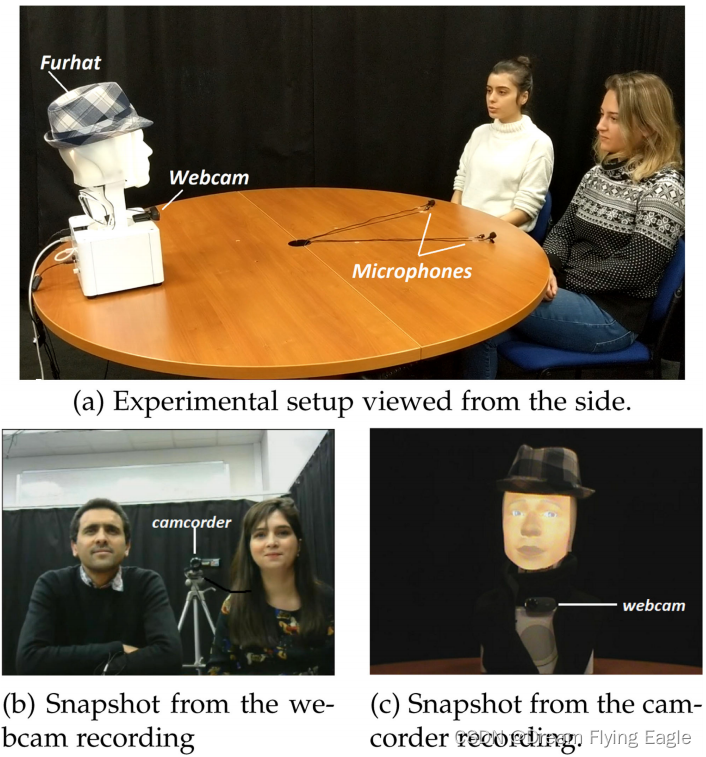

该实验基于一个故事塑造游戏,并使用背投式机器人头型号Furhat作为实验工具。实验由 26 名参与者以成对形式组成 13 个小组参加,他们被要求玩两次游戏,每次游戏的背景策略不同。在实验的过程中,机器人引导参与者进行互动,然后保存视频记录用于后期反馈问卷调查。

作者实现了两种backchannel行为模型:基准规则策略和测试RL策略。规则策略被定义为生成点头和微笑的固定时间间隔。测试RL策略被选为SRDQN训练的最佳表现策略。在 Furhat 的听取阶段独立执行点头 RL 策略和微笑 RL 策略。通过从 Q 网络的贪心决策中进行多数投票来做出背景信号的最终决策。

实验结果

问卷反馈度量

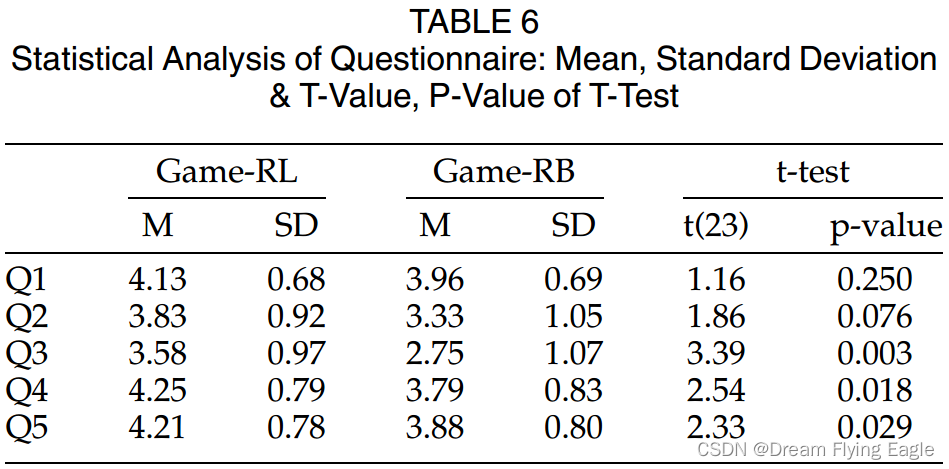

24 名参与者通过填写游戏-RB 和游戏-RL 的后实验问卷提供了他们的反馈。

根据问卷结果打分,总体而言,参与者认为两个游戏都很吸引人。在Q1中,两个策略都得到了很高的平均分,RL稍高。Q2询问点头的时间适宜性,Q3询问微笑的时间适宜性。RL策略再次获得了更高的分数。Q4和Q5旨在了解backchannel在增强吸引力方面的作用。在这些问题中,游戏RL得到了比游戏RB有更大的优势。参与者认为在游戏RL中互动更加自然。在Q5中表明玩家与RL策略互动时表现出更多的兴趣和投入。

此外,使用 t 检验确定游戏RB和游戏RL的平均评分之间的差异是否显著。虽然关于点头的结果并不显着,但微笑的结果是显着的。该分析的一个关键发现是不当的点头时间不太可能被感知,但是需要更谨慎地生成微笑,因为没有上下文联系的微笑会通常不会被接受。

参与度度量

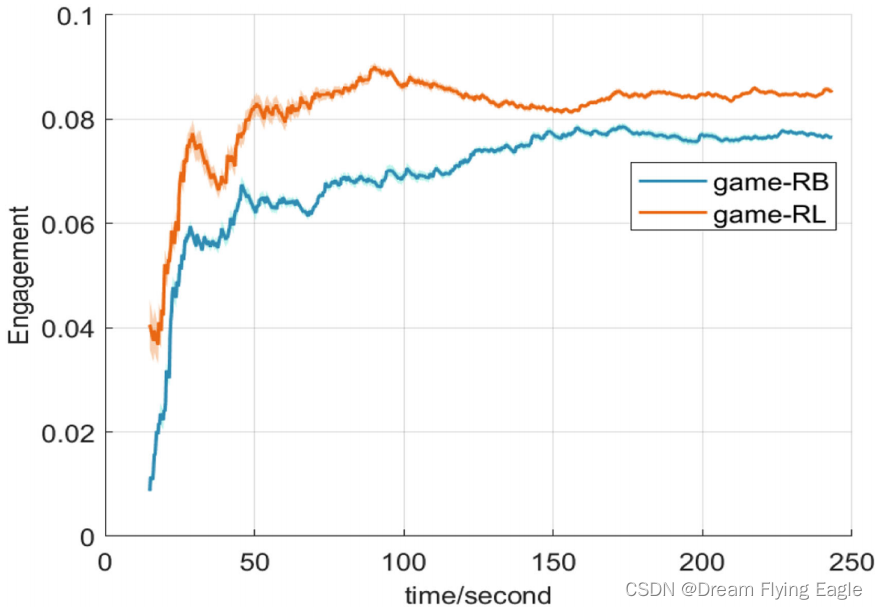

参与度可以从各种可观察的特征和行为线索客观地推断出来,如姿势、头部倾斜和方向、反馈和注视等线索,可以客观地推断出参与度。作者定义了三个连接事件(CE)来衡量参与度:backchannel、邻近配对和相互面部注视,并将参与度定义为时间窗口内 CE 的平均数量。定义 η t \eta_t ηt 为给定会话中在时间t之前参与者的连接事件的数量。

E ( t ) = η t t E(t)=\frac{\eta_t}{t} E(t)=tηt

图6绘制了横跨两种类型会话的运行平均参与度 E ( t ) E(t) E(t) 随时间的变化情况。两条曲线的差异显示了强化学习策略的参与者有更高吸引力。

为了突出两种类型互动之间的区别,我们记录了参与者在互动过程中执行的微笑和点头总数。观察到基于RL策略的用户总共产生了241个微笑,而基于规则的策略则产生了201个微笑。点头的数量在两种策略下几乎相等。

讨论和总结

我们的选择基于文献中各种先前技术的优点和局限性。我们在用户研究中采用了基于规则的策略,这种策略独立于用户状态,可能看起来简单而重复。然而,在每个说话转折点平均两次backchannel之间交替使用微笑和点头有助于减轻策略的重复性质。在我们的试验中,用户称他们无法判断是否有定期触发事件的策略。

该论文提出了一种针对机器人非语言回应行为的生成模型,可以使用记录的人际交互数据来学习近似最优策略的批处理强化学习算法,并且证明了这样的社交可接受的回应策略可以仅使用离线数据训练。最后,论文探讨了将此研究工作用于更多社交行为的可能性,并介绍了可以使用自然语言处理技术和音频状态表示来优化策略。

这篇关于论文阅读笔记《Training Socially Engaging Robots Modeling Backchannel Behaviors with Batch Reinforcement Lea的文章就介绍到这儿,希望我们推荐的文章对编程师们有所帮助!