本文主要是介绍梯度运算MORPH_GRADIENT,希望对大家解决编程问题提供一定的参考价值,需要的开发者们随着小编来一起学习吧!

梯度是指图像梯度,可以简单地理解为像素的变化程度。 如果⼏个连续的像素,其像素值跨度越⼤,则梯度值越⼤。 梯度运算的运算过程:让原图的膨胀图减原图的腐蚀图。因为膨胀图⽐原图⼤,腐蚀图⽐原图⼩,利⽤腐蚀图将膨胀图掏空,就得到了原图的轮廓图。

梯度有两个重要的属性,一个是梯度的大小:它描述了图像变化的强弱,一是梯度的角度:它描述了图像中在每个点(像素)上强度变化最大的方向

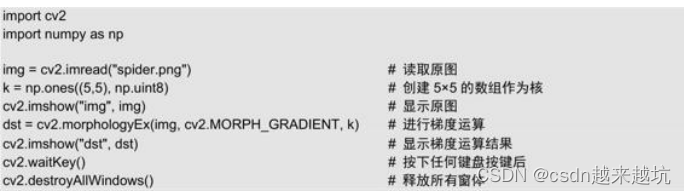

梯度运算的参数为cv2.MORPH_GRADIENT

这篇关于梯度运算MORPH_GRADIENT的文章就介绍到这儿,希望我们推荐的文章对编程师们有所帮助!