本文主要是介绍Tensorflow入门教程(三十三)优化器算法简介(Momentum、NAG、Adagrad、Adadelta、RMSprop、Adam),希望对大家解决编程问题提供一定的参考价值,需要的开发者们随着小编来一起学习吧!

#

#作者:韦访

#博客:https://blog.csdn.net/rookie_wei

#微信:1007895847

#添加微信的备注一下是CSDN的

#欢迎大家一起学习

#

------韦访 20181227

1、概述

上一讲中,我们发现,虽然都是梯度下降法,但是不同算法之间还是有区别的,所以,这一讲,我们就来看看它们有什么不同。

2、梯度下降常用的三种方法

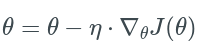

为了博客的完整性,这里再来重复的说一下什么是梯度下降法,简单说,就是寻找一个参数θ,使得函数J(θ)最小。《机器学习入门(四)回归算法》(链接:https://blog.csdn.net/rookie_wei/article/details/83117493)中,我们简单的提了梯度下降常用的三种方法:批量梯度下降法(Batch gradient descent,BGD)、随机梯度下降法(Stochastic gradient descent,SGD)、小批量梯度下降法(mini-batch gradient descent,MBGD)。

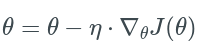

批量梯度下降法:

每次迭代都考虑所有样本,这样做容易得到最优解,但是速度很慢。

参数θ的迭代训练如上式,其中,![]() 表示学习率,

表示学习率,![]() 函数J(θ)的梯度,

函数J(θ)的梯度,

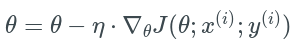

随机梯度下降:

每次随机找一个样本,这样迭代的速度很快,但是不一定每次都朝着收敛方法,效果比较差。

上式中,![]() 表示学习率,

表示学习率,![]() 表示随机选中的样本。

表示随机选中的样本。

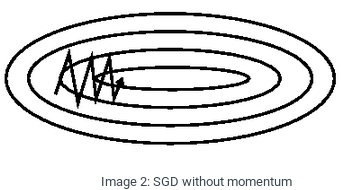

SGD经常进行高方差更新,导致目标函数上图所示剧烈波动。

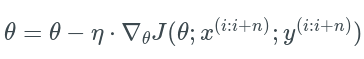

小批量梯度下降法: 每次迭代选择一小部分数据来算,这样就达到了一个速度和效果的平衡,

上式中,![]() 表示学习率,

表示学习率,![]() 表示小批量选中的样本。

表示小批量选中的样本。

我们在TensorFlow中训练就是每次一个batch数据,一般来说,batch大一点,效果会比较好,但是实际应用中也要考虑内存和效率,一般设置为50~256。

3、梯度下降法的挑战

1)学习率的选择不好确定。从上面的三个式子可以看出,不管用什么方法,都得设置一个学习率。学习率决定了每次更新的速度,而学习率的设置是很难的,如果幅度过大,可能导致参数在极优值两侧来回移动,如果幅度过小,就会大大降低优化速度。

2)如果采用在训练期间调整学习率的方法,比如,根据预先定义的计划或者当两个epochs之间的目标的变化低于某个阈值时降低学习率,但是这些计划和阈值也得提前定义。

3)此外,相同的学习率适用于所有参数的更新,如果我们的数据是稀疏的,并且我们的特性具有非常不同的频率,我们可能不希望将它们全部更新到相同的程度,而是对出现频率低的特性进行更大的更新。

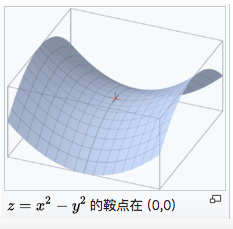

4)对于非凸误差函数的另一个关键挑战是避免陷入其众多的次优局部极小处。困难实际上不是来自局部极小值,而是来自鞍点,即一个维度向上倾斜,另一个维度向下倾斜的点。这些鞍点通常周围的error是一样的,这使得SGD很难逃脱,因为梯度在所有维度上都接近于零。

一个光滑函数的鞍点如上图所示,x轴向上曲,y轴向下曲。

4、Momentum

SGD很容易被困在沟壑(ravine)中,沟壑即在一个维度上的曲线比另一个维度上的曲线陡得多的区域。在这种情况下,SGD在沟壑的斜坡上震荡,同时仅在底部时朝着局部最优状态缓慢前行,如下图所示,

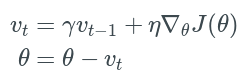

Momentum是一种有助于SGD在收敛方向上加速并且抑制震荡的方法。它通过将上一步的更新向量添加到当前更新向量来实现的。这么说可能有点懵逼,上公式就明白了,

其中![]() ,一般设置为0.9,对比批量梯度下降的公式,

,一般设置为0.9,对比批量梯度下降的公式,

就像我们把球推下山坡,当球向下滚动时,会积累动量,在途中变得越来越快。

在参数更新上类似的,对于梯度指向相同方向的维度,动量项会增加,而对梯度方向改变的维度,动量项会减少更新,所以,我们得到了更快的收敛和减少震荡。

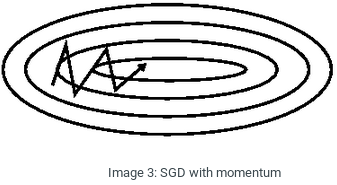

如下图所示,

缺点:这种算法下,“小球”是一个盲目的沿着斜坡滚下山的“笨球”,我们想要一个更聪明的球,一个知道它想去哪的球,这样它就知道在再次上坡之前减速。下一个算法就是解决这个缺点的。

5、Nesterov accelerated gradient(NAG)

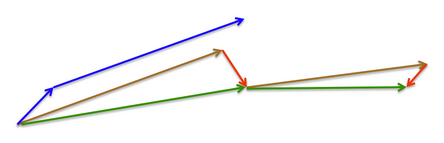

NAG就是一个能让动量项具有“先见之明”的方法。Momentum每下降一步是由前面下降方向的累积和当前点的梯度方向组合而成,而NAG是按照前面一小步位置的“超前梯度”和当前梯度进行组合,也就是说,小球先往前走一步,然后再按照那个位置来修正当前这一步的梯度方向,根据前一步“往回看”。根据下面的图来对比Momentum和NAG这两个算法的工作原理,

如上图所示,Momentum首先计算当前梯度(蓝色小矢量),然后在更新的累积梯度(蓝色大矢量)的方向上进行一次大跳跃。而NAG则首先在先前的累积梯度(棕色矢量)方向上进行一次大跳跃,再测量梯度,然后进行校正(红色矢量),绿色矢量就是NAG的更新结果。这种预期的更新防止了我们走得太快,并使响应能力提高,这显著提高了RNN在许多任务上的性能。

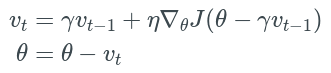

参数更新公式如下,

当学习率η=0.01, 衰减率 γ=0.9γ=0.9时,对比一下Momentum和NAG的收敛速度如下图所示,

可以看到,NAG震荡幅度小于Momentum,收敛速度要快于Momentum。

6、Adagrad

自适应梯度算法(Adaptive gradient algorithm,Adagrad)可以对低频的参数做较大更新,对高频的参数做较小的更新,因此,该算法对于稀疏数据的表现很好,极大的提高了SGD的健壮性。

下面,我们用![]() 表示t时刻下参数

表示t时刻下参数![]() 的梯度,

的梯度,

![]()

SGD更新每个参数的式子如下,

![]()

上式中,每个参数使用相同的学习率,而Adagrad根据为计算参数![]() 的过去梯度,修改每个参数

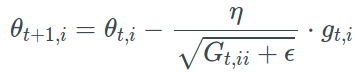

的过去梯度,修改每个参数![]() 的每个时刻t的学习率。式子如下,

的每个时刻t的学习率。式子如下,

其中,![]() 是一个对角矩阵,(i,i)元素是t时刻,参数

是一个对角矩阵,(i,i)元素是t时刻,参数![]() 的梯度平方和,Ɛ是一个避免被零除的平滑项。

的梯度平方和,Ɛ是一个避免被零除的平滑项。

缺点:Adagrad的主要缺点是它在分母中平方梯度的累积,累积在训练中不断增加,这就导致了学习率不断收缩,最终变得无穷小,导致模型几乎无法再训练。接下来的Adadelta算法就是解决这个问题的。

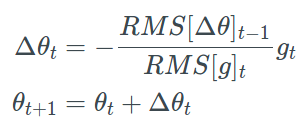

7、Adadelta

Adadelta是Adagrad的扩展,Adadelta不会累积过去所有的平方梯度,而是过去所有的平方梯度的衰减平均值,时刻t的平均值![]() 仅取决于之前的平均值和当前梯度,如下式所示。

仅取决于之前的平均值和当前梯度,如下式所示。

![]()

![]() 一般设为0.9,则Adadelta的参数

一般设为0.9,则Adadelta的参数![]() 更新式子如下,

更新式子如下,

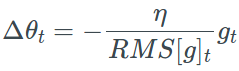

由于分母相当于梯度的均方根(RMS),所以,可以用RMS简写上式如下,

论文作者认为,更新应该具有与参数相同的假设单位,所以他们首先定义另一个指数衰减平均值,这次,不是平方梯度,而是平方参数更新,如下式,

![]()

所以,参数更新的均方根误差为,

![]()

由于![]() 是未知的,我们用上一时刻的参数更新的RMS近似它,所以我们用

是未知的,我们用上一时刻的参数更新的RMS近似它,所以我们用![]() 来替换学习率η,最终得到Adadelta更新规则如下,

来替换学习率η,最终得到Adadelta更新规则如下,

由上式可知,我们甚至到不需要设置默认的学习率η,因为学习率η已经在更新规则中消除了。

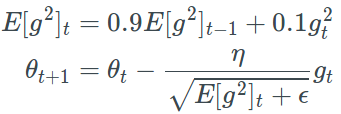

8、RMSprop

RMSprop和Adadelta算法一样,都是为了解决Adagrad算法急剧下降的学习率的算法,RMSprop与Adadelta的第一种形式相同,这两个算法是同一时间独立开发的,英雄所见略同,公式如下,

一般![]() 设置为0.9,学习率η设置为0.001 。

设置为0.9,学习率η设置为0.001 。

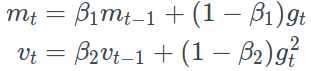

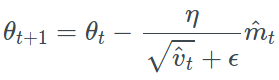

9、Adam

自适应矩估计(Adaptive Moment Estimation,Adam)是另一种参数自适应学习率的方法,有点相当于RMSprop+Momentum,Adam除了像RMSprop存储过去梯度的平方![]() 的指数衰减平均值(如Adadelta和RMSprop) ,还像Momentum一样保留过去梯度

的指数衰减平均值(如Adadelta和RMSprop) ,还像Momentum一样保留过去梯度![]() 的指数衰减平均值,

的指数衰减平均值,![]() 和

和![]() 的式子如下,

的式子如下,

当![]() 和

和![]() 初始化为0的向量时,Adam的作者发现它们会偏向于0,特别是在初始时间步骤,特别是当衰变率很小时(即

初始化为0的向量时,Adam的作者发现它们会偏向于0,特别是在初始时间步骤,特别是当衰变率很小时(即![]() 和

和![]() 接近1)。可以通过计算偏差校正后的

接近1)。可以通过计算偏差校正后的![]() 和

和![]() 来抵消这些偏差,

来抵消这些偏差,

然后,使用这些来更新参数,式子如下,

一般情况下,![]() 设置为0.9,

设置为0.9,![]() 设置为0.999,Ɛ设置为

设置为0.999,Ɛ设置为![]() 。

。

10、各算法的动态效果图

11、如何选择优化器

1)如果训练的数据是稀疏的,则选择一个自适应学习率的算法(Adagrad、Adadelta、RMSprop、Adam)。

2)RMSprop是Adagrad一个扩展,它处理的是急剧下降的学习率。

3)Adam则为RMSprop添加了偏差校正和动量,随着梯度变得越来越稀疏,Adam在优化结束时略优于RMSprop。Adam可能是上述算法中最好的选择。

4)Adadelta、RMSprop、Adam三个算法非常相似,在类似的情况下,效果都不错。

总结:

优化器算法不止这几个,还有比如AdaMax、Nadam、AMSGrad等,这里就不讲了。

参考博客:

http://ruder.io/optimizing-gradient-descent/index.html

如果您感觉本篇博客对您有帮助,请打开支付宝,领个红包支持一下,祝您扫到99元,谢谢~~

这篇关于Tensorflow入门教程(三十三)优化器算法简介(Momentum、NAG、Adagrad、Adadelta、RMSprop、Adam)的文章就介绍到这儿,希望我们推荐的文章对编程师们有所帮助!