本文主要是介绍动态 ETL 管道:使用非结构化 IO 将 AI 与 MinIO 和 Weaviate 的 Web,希望对大家解决编程问题提供一定的参考价值,需要的开发者们随着小编来一起学习吧!

在现代数据驱动的环境中,网络是一个无穷无尽的信息来源,为洞察力和创新提供了巨大的潜力。然而,挑战在于提取、构建和分析这片浩瀚的数据海洋,使其具有可操作性。这就是Unstructured-IO 的创新,结合MinIO的对象存储和Weaviate的AI和元数据功能的强大功能。它们共同创建了一个动态 ETL 管道,能够将非结构化 Web 数据转换为结构化的、可分析的格式。

本文探讨了这些强大技术的集成如何彻底改变数据水合作用和分析,提供一种全面的解决方案,不仅可以管理,还可以从大量 Web 生成的内容中提取有形价值。通过利用 Unstructured-IO 的动态处理工具,该工具旨在智能地解析和构建大量非结构化数据,我们处于进化的最前沿,展示了一种全面的Dynamic ETL 方法,该方法正在重塑数据管理和洞察生成的格局。

揭示非结构化 IO 的潜力

该过程从 Unstructured-IO 开始,这是一个强大的工具,旨在筛选非结构化 Web 数据的混乱,提取有价值的信息并将其转换为结构化格式。这对于依赖网络生成内容的企业和研究人员来说至关重要,但在有效管理和分析内容方面面临障碍。

接下来,MinIO开始发挥作用,提供对象存储解决方案,确保结构化数据安全高效地存储。它的高性能和与现有工具的兼容性使其成为处理非结构化 IO 处理的大量数据的理想主干。

最后,Weaviate 使用 AI 和元数据功能丰富结构化数据,将纯文本转换为丰富的自定义对象。这种增强功能将数据转化为深入情境化的见解,从而提升了决策和创新能力。

实际应用

想象一下,您在网络上遇到了有价值的内容。只需按一下 iOS 快捷方式中的按钮,即可捕获、处理和存储此内容。这不仅仅是保存链接;它旨在实时丰富您的数据生态系统,使每条信息都可以立即访问和分析。

这种动态的 ETL 管道不仅仅是一个理论结构,而是一个已经增强数据工作流的实用工具。它展示了现代解决方案如何解决 Web 生成的数据洪流问题,并将其转化为任何组织的结构化、有价值的资产。

通过将 Unstructured-IO 与 MinIO 和 Weaviate 集成,我们不仅仅是管理数据;我们正在释放它的全部潜力,使你更容易从浩瀚的网络中获得有意义的见解。这是数据管理和分析的未来,简化、安全和智能,随时准备将您的项目提升到一个新的水平。

使用非结构化 IO 彻底改变数据冻结

在反映 D-ETL 在医疗保健领域的成功时,Unstructured-IO 重新定义了 Web 生成内容的数据水合过程。通过将非结构化数据无缝转换为结构化的、可分析的格式,它不仅提高了数据质量和数量,还为突破性的洞察力和人工智能驱动的计划奠定了基础。这种转变对企业和研究人员来说都至关重要,为数字时代的数据高效管理和分析提供了可扩展的解决方案。

有关动态 ETL 方法及其在医疗保健数据管理中的应用的深入探索,请参阅题为“Dynamic-ETL: a hybrid approach for health data extraction, transformation and loading”的研究,该研究可在 PubMed Central 上获得。本研究举例说明了用于克服协调临床研究网络电子健康记录 (EHR) 挑战的创新方法。

准备开发环境

D-ETL 管道设置的初始阶段至关重要,重点是为我们的开发环境配备基本的 Python 库。此步骤通过 pip install 执行,这将安装以下三个软件包:

-

weaviate-client: 促进与 Weaviate 的直接交互,使我们能够利用其复杂的 AI 驱动的搜索功能。

-

unstructured: 提供强大的工具,用于将非结构化数据转换为可供分析和存储的格式。

-

minio: 将我们的工作流程连接到 MinIO,提供与我们的对象存储服务器交互的无缝接口,我们的数据将安全地存储在其中。

pip install weaviate-client unstructured minio

通过将这些软件包集成到我们的环境中,我们确保我们的管道能够完全满足未来的任务。

这种设置不仅为高效的数据提取、转换和加载过程奠定了基础,而且还为创新的数据管理解决方案打开了大门。有了这些工具,我们就可以开始无缝数据处理的旅程,从最初的 Web 内容提取到最终的存储和分析阶段。

演示的代码展示了 MinIO、Weaviate 和非结构化的集成和用法,可在此处查看和探索。

Initializing Clients 初始化客户端

要为 ETL 流程奠定坚实的基础,首先要初始化我们的 MinIO 和 Weaviate 客户端。

from minio import Minio

import weaviate# Setup for MinIO and Weaviate

minio_client = Minio("play.min.io:443", access_key="minioadmin", secret_key="minioadmin", secure=True)

print("MinIO client initialized.")client = weaviate.Client("http://localhost:8080")

print("Weaviate client initialized.")

此过程涉及使用特定参数(如访问凭据和连接 URI)配置每个客户端。

使用非结构化 IO 的自动分区进行数据提取和转换

此阶段涉及动态获取 Web 数据,并利用 Web 抓取请求和非结构化 IO 的组合将内容划分为可管理的段。

该代码首先导入必要的库 - requests用于 HTTP 操作、 re 用于帮助清理 URL 的正则表达式操作、用于更具描述性的对象命名、 io 用于处理字节流以及 unstructured.partition.auto 用于智能地将复杂的 Web 内容分解为结构化数据。

两个关键的帮助函数 sanitize_url_to_object_name 和 prepare_text_for_tokenization 用于清理 URL 和文本内容,确保输出采用有利于分析的标准化格式。该 sanitize_url_to_object_name 函数修改 URL,为每个内容片段创建唯一的、文件系统友好的名称,从而促进有组织的存储。进一步prepare_text_for_tokenization清理文本数据,去除不必要的空白,并为更深入的分析或 AI 处理做好准备。

import requests

import re

import io

from unstructured.partition.auto import partitiondef sanitize_url_to_object_name(url):clean_url = re.sub(r'^https?://', '', url)clean_url = re.sub(r'[^\w\-_\.]', '_', clean_url)return clean_url[:250] + '.txt'def prepare_text_for_tokenization(text):clean_text = re.sub(r'\s+', ' ', text).strip()return clean_text# Dictionary/List of URL to process

urls = ["https://blog.min.io/","https://weaviate.io/blog","https://unstructured.io/blog"

]这种结构化方法不仅简化了将 Web 数据引入我们的系统的过程,而且还为后续阶段奠定了基础,这些数据将存储在 MinIO 中并在 Weaviate 中建立索引。通过仔细选择 URL 作为数据源,该过程可确保提供丰富多样的数据集供探索,随时准备在各种上下文中推动见解和决策。

Loading to MinIO 加载到 MinIO

此步骤旨在确保以有组织的方式保留新结构化和清理的数据,以便于将来进行分析。

数据进行转换后,下一步涉及将其安全地存储在 MinIO 中,该过程如以下代码块所示:

bucket_name = "cda-datasets"if not minio_client.bucket_exists(bucket_name):minio_client.make_bucket(bucket_name)print(f"Bucket '{bucket_name}' created.")

该脚本会自动检查现有 MinIO 存储桶,或在必要时创建一个新存储桶,从而演示管道为有效处理数据所做的准备。

for url in urls:print(f"Fetching URL: {url}")try:response = requests.get(url)response.raise_for_status() # Check for HTTP issueshtml_content = io.BytesIO(response.content)elements = partition(file=html_content, content_type="text/html")combined_text = "\n".join([e.text for e in elements if hasattr(e, 'text')])combined_text = prepare_text_for_tokenization(combined_text)object_name = sanitize_url_to_object_name(url)with tempfile.NamedTemporaryFile(delete=False, mode="w", encoding="utf-8", suffix=".txt") as tmp_file:tmp_file.write(combined_text)tmp_file_path = tmp_file.nameminio_client.fput_object(bucket_name, object_name, tmp_file_path)print(f"Stored '{object_name}' in MinIO bucket '{bucket_name}'.")os.remove(tmp_file_path) # Clean upexcept requests.RequestException as e:print(f"Failed to fetch URL {url}: {e}")except Exception as e:print(f"Error processing {url}: {e}")通过系统地处理每个数据片段并将其上传到 MinIO 中,该方法强调了可靠的存储解决方案在维护数据完整性和可用性方面的重要性,以便后续检索和分析工作。

使用 Weaviate 简化数据利用

转换数据后,下一步是将这些精炼的信息汇集到 Weaviate 中。

此阶段是使用 Weaviate 的高级搜索功能增强数据并将其保护到高效存储系统中所必需的。Python 代码片段概述了一种将转换后的数据(特别是文本文件)从 MinIO 导入 Weaviate 的系统方法。

该过程不仅展示了存储和搜索平台之间的无缝集成,还突出了双 ETL 管道在增强数据可访问性和分析就绪性方面的实际应用。

for obj in minio_client.list_objects(bucket_name, recursive=True):if obj.object_name.endswith('.txt'):print(f"Processing document: {obj.object_name}")file_path = obj.object_nameminio_client.fget_object(bucket_name, obj.object_name, file_path)elements = partition(filename=file_path)text_content = "\n".join([e.text for e in elements if hasattr(e, 'text')])data_object = {"source": obj.object_name, "content": text_content}client.data_object.create(data_object, "Document")print(f"Inserted document '{obj.object_name}' into Weaviate.")os.remove(file_path)管道的这一部分强调在 Weaviate 中将静态数据转换为动态的、可搜索的资产。通过将数据嵌入 Weaviate 的上下文感知环境中,它释放了细致入微的查询功能和数据驱动的洞察力的潜力。这一步概括了双 ETL 方法的精髓——利用 MinIO 的可扩展存储和 Weaviate 的智能搜索的综合优势,培养一个既强大又响应分析查询的数据生态系统。

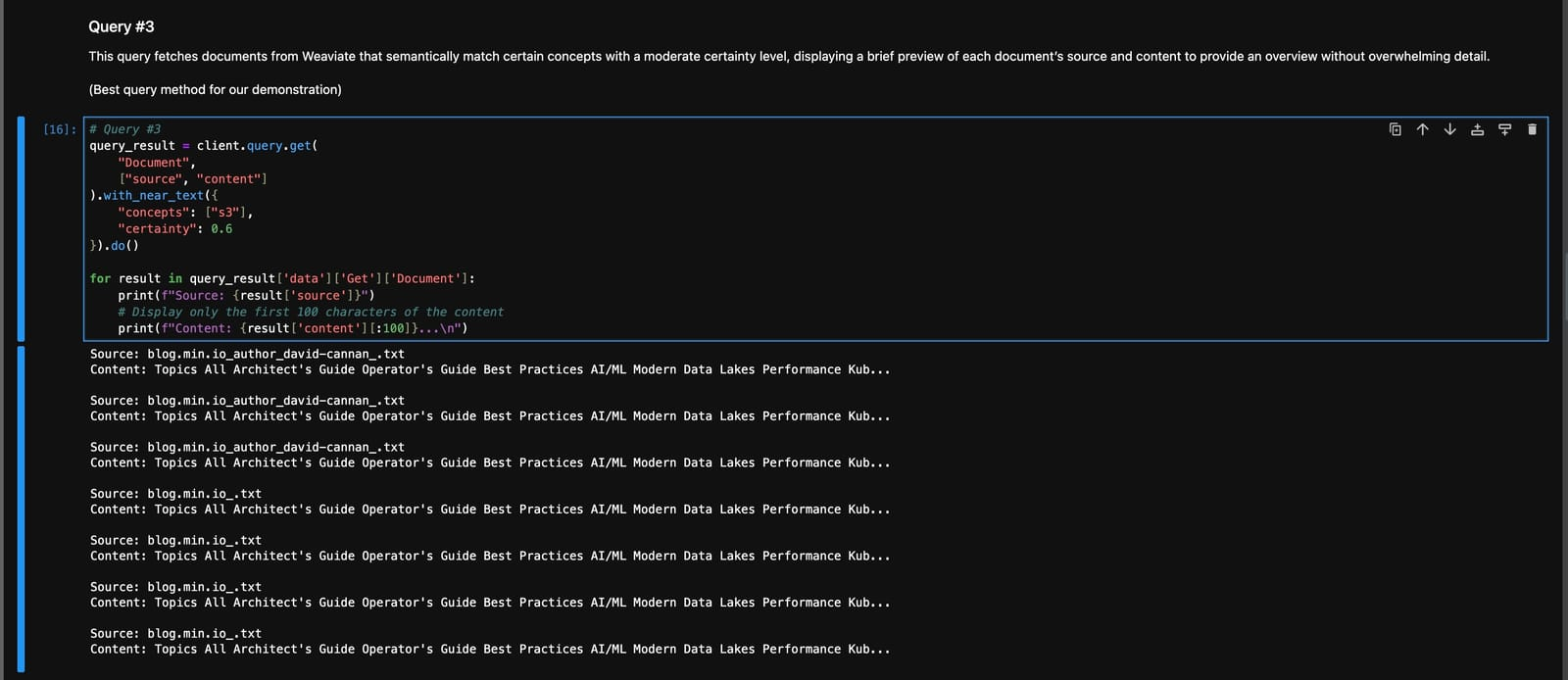

查询 Weaviate - 完成我们的数据流程

我们数据管道的最后阶段采用 Weaviate 的语义搜索功能,查询转换后的数据以提取有意义的见解。

此过程将结构化数据转化为实用的、可操作的情报。

query_result = client.query.get("Document",["source", "content"]

).with_near_text({"concepts": ["s3"],"certainty": 0.6

}).do()for result in query_result['data']['Get']['Document']:print(f"Source: {result['source']}")# Display only the first 100 characters of the contentprint(f"Content: {result['content'][:100]}...\n")

Python 代码演示了 Weaviation 中的有针对性的搜索,检索在语义上与给定概念匹配且具有定义确定性级别的文档。

此功能体现了我们的双 ETL 管道的实用功能,即将复杂的数据转化为易于理解且有用的信息,供业务应用程序使用。

随着我们对动态 ETL 管道的探索的结束,以及 Unstructured-IO 的基本功能的增强,很明显,我们正站在数据管理革命的风口浪尖。将非结构化 Web 数据转换为结构化信息宝库的复杂过程的过程简直是变革性的。借助 Unstructured-IO 的自动分区、MinIO 的存储解决方案和 Weaviate 的 AI 功能,我们推出了一种途径,不仅可以简化数据管理,还可以解锁比以往任何时候都更深入、更可操作的见解。

使用非结构化 IO 连接器增强 ETL 流程

在概念验证的开发过程中,我们评估了几种方法,以确保简化和高效的实现,旨在减少代码行数。非结构化 IO Weaviate 连接器为增强数据处理工作流程提供了一条很有前途的途径。

连接器特别擅长管理批处理,确保数据符合预定义的架构,并简化错误处理机制。这使其成为需要可扩展、高效和可靠数据处理能力的项目的宝贵工具,尤其是在复杂或数据密集型环境中。它在这种情况下的潜在效用强调了考虑各种工具和方法来优化数据管道开发和运营效率的重要性。

在我们的动态 ETL 管道中集成非结构化 IO 不仅仅是一种技术方法;这种方法为数据分析和人工智能技术开辟了道路。通过将非结构化数据转化为有组织的、可搜索的存储库,我们不仅增强了当前的分析能力,还为新兴的人工智能方法奠定了基础,这些方法有望重新定义数据驱动决策的可能性。

创新与合作邀请

显然,在这一点上,创新的潜力是无限的,对从医疗保健到金融等行业的影响尚未完全实现。我们邀请您,开发人员,数据工程师和有远见的人,加入我们的冒险之旅。无论是通过定制管道以满足利基需求,还是探索这些工具的新应用,您的贡献都是解锁下一阶段数据驱动突破的关键。

归根结底,这不仅仅是关于数据或技术;这是关于我们建立的联系、我们发现的见解以及我们创造的影响。

如果您受到动态 ETL 可能性的启发,对 Unstructured-IO 的功能感兴趣,或者只是想分享您的想法和想法,我们随时为您服务。

这篇关于动态 ETL 管道:使用非结构化 IO 将 AI 与 MinIO 和 Weaviate 的 Web的文章就介绍到这儿,希望我们推荐的文章对编程师们有所帮助!