本文主要是介绍Spark速度比MapReduce快,不仅是内存计算,希望对大家解决编程问题提供一定的参考价值,需要的开发者们随着小编来一起学习吧!

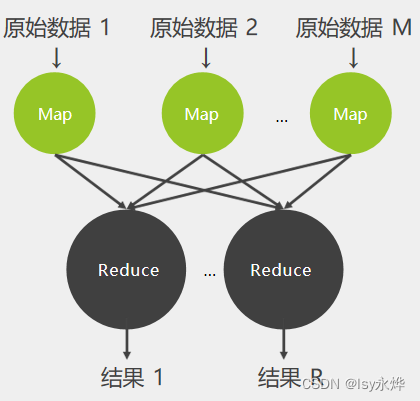

作为Hadoop的分布式计算框架,MapReduce扮演着分布式计算的任务,适用于离线批计算任务。Spark本身不具备存储数据功能,通常基于HDFS。我们经常会在各类文章中看到类似这样的描述:Spark是基于内存计算的,其速度远快于Hadoop的MapReduce。本文旨在讨论这一结论背后的原因。

一、Spark内存计算 VS MapReduce读写磁盘

-

MapReduce:MapReduce通常需要将计算的中间结果写入磁盘。map进程和reduce进程需要读取指定位置的数据作为输入,如果不将中间结果写入磁盘以保证可靠存储,一旦中间结果丢失或者损坏,MapReduce没有机制能够恢复中间结果。此外,一个job可能涉及到多个stage,而每个stage的处理结果都需要存储到HDFS中,这就必然导致频繁的磁盘IO;

-

Spark:Spark不需要将计算的中间结果写入磁盘,这得益于Spark的RDD(弹性分布式数据集)和DAG(有向无环图),前者是Spark中引入的一种只读的、可扩展的数据结构,后者则记录了job的stage以及在job执行过程中父RDD和子RDD之间的依赖关系。中间结果能够以RDD的形式存放在内存中,一旦Job中的某个RDD丢失或者损坏,则可以根据DAG来重新计算得到该RDD。此外,在Spark中一个job的多个stage任务可以串联或者并联执行,stage的中间结果不需写入HDFS。

我们知道频繁的磁盘IO非常影响系统的处理性能,而基于内存计算则大大提升了处理性能。

二、其他区别

2.1 任务调度

-

Hadoop的MapReduce是针对大文件的批处理而设计的,延迟较高;

-

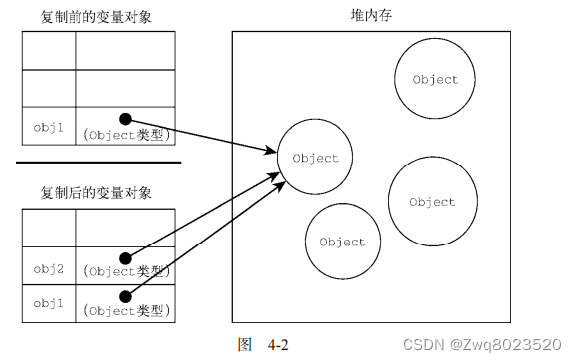

Hadoop的MapReduce的Map Task和Reduce Task都是进程级别的,而Spark Task则是基于线程模型的(而mapreduce 中的 map 和 reduce 都是 jvm 进程,每次启动都需要重新申请资源,启动时间大概1s;想象一下如果是8096个block,那么单独启动map进程事件就需要8096秒,非常影响效率;);

-

Spark通过复用线程池中的线程来减少启动、关闭task所需要的开销。

2.2 执行策略

-

MapReduce在shuffle前需要花费大量时间进行排序;

-

Spark在shuffle时只有部分场景才需要排序,支持基于Hash的分布式聚合,更加省时;

2.3 数据格式和内存布局

-

MapReduce Schema on Read处理方式会引起较大的处理开销;

-

Spark RDD能支持粗粒度写操作,对于读操作则可以精确到每条record,因此RDD可以用来作为分布式索引。此外用户可以自定义分区策略,如Hash分区等。Shark和Spark SQL在Spark的基础上实现了列存储和列存储压缩。

往期推荐

1、干货 | Kafka 内核知识梳理,附思维导图

2、MapReduce Shuffle 和 Spark Shuffle 结业篇

3、HBase原理 | HBase Compaction介绍与参数调优

4、实时数仓 | 你想要的数仓分层设计与技术选型

这篇关于Spark速度比MapReduce快,不仅是内存计算的文章就介绍到这儿,希望我们推荐的文章对编程师们有所帮助!