activation专题

【HDU】 4089 Activation 概率DP

题目大意:Tomato要玩一个游戏,他需要排队,一开始这个队列共有N个人,而他在队列的第M个位置,每当有玩家尝试激活登陆游戏时, 会概率性触发四个事件。p1的概率注册失败,队列无变化。p2的概率连接失败,排在队首的人排到队尾。p3的概率成功,队首出队。p4的概率服务器 瘫痪,停止激活!这时候如果排在Tomato前面的人不足K个,那么他会很气愤。问 : Tomato排在第k位以内服务器瘫痪的概率。

Error when checking model target: expected activation_2 to have shape (None, 10) but got array with

我遇到了这个问题,因为我在用reshape层后,忘了改我的GT label的尺寸。 reshape最终的输出是10长度的,但是标签用的还是1长度的 就是(0,0,1,0,0,0,0,...)与3的不匹配

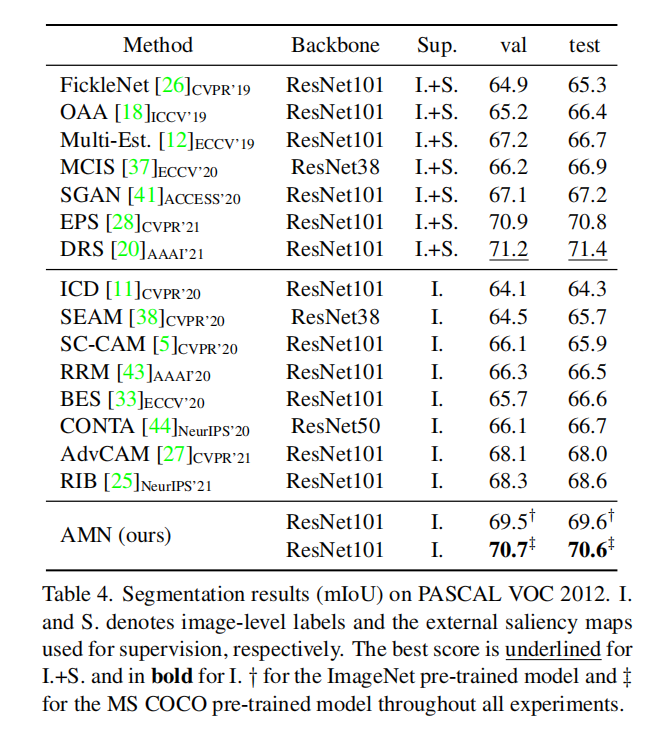

Clustering-Guided Class Activation for WeaklySupervised Semantic Segmentation

pdf:https://ieeexplore.ieee.org/stamp/stamp.jsp?tp=&arnumber=10381698 code:https://github.com/DCVL-WSSS/ClusterCAM 摘要: 基于transformer的弱监督语义分割(WSSS)方法利用其捕获全局上下文的强大能力得到了积极的研究。然而,由于激活函数在transformer的自注意

【darknet】阅读理解(5)——batchnorm和activation

1. batchnorm 1.1 原理 大致的原理可以参考:https://blog.csdn.net/qq_25737169/article/details/79048516 如果了解个大概的话,就是:(x-均值)/ 偏差 * 缩放系数 + 一个偏置 1.2 darknet实现 说明: darknet cpu采用C实现的,能更有助于原理的理解或者也可以用numpy等高级框架实现 总

NoClassDefFoundError: javax/activation/DataSource解决方案

今天开发邮件系统,发送程序能在main函数中顺利运行.可是布署到没tomcat之中后,出现启动服务器后,先是出现: Source not found for WebappClassLoader.loadClass(String, boolean) line: 1352 myEclips要求打开debug窗口调试程序. 进入debug追踪,调试程序入口指向发送程序的类,按下

keras activation 报错 ‘_OverloadedFunction‘ object has no attribute ‘__name__‘

今天在训练模型的时候报错如下: 详细信息如下所示: Traceback (most recent call last):File "/usr/local/lib64/python3.6/site-packages/keras/legacy/interfaces.py", line 91, in wrapperreturn func(*args, **kwargs)File "/usr/lo

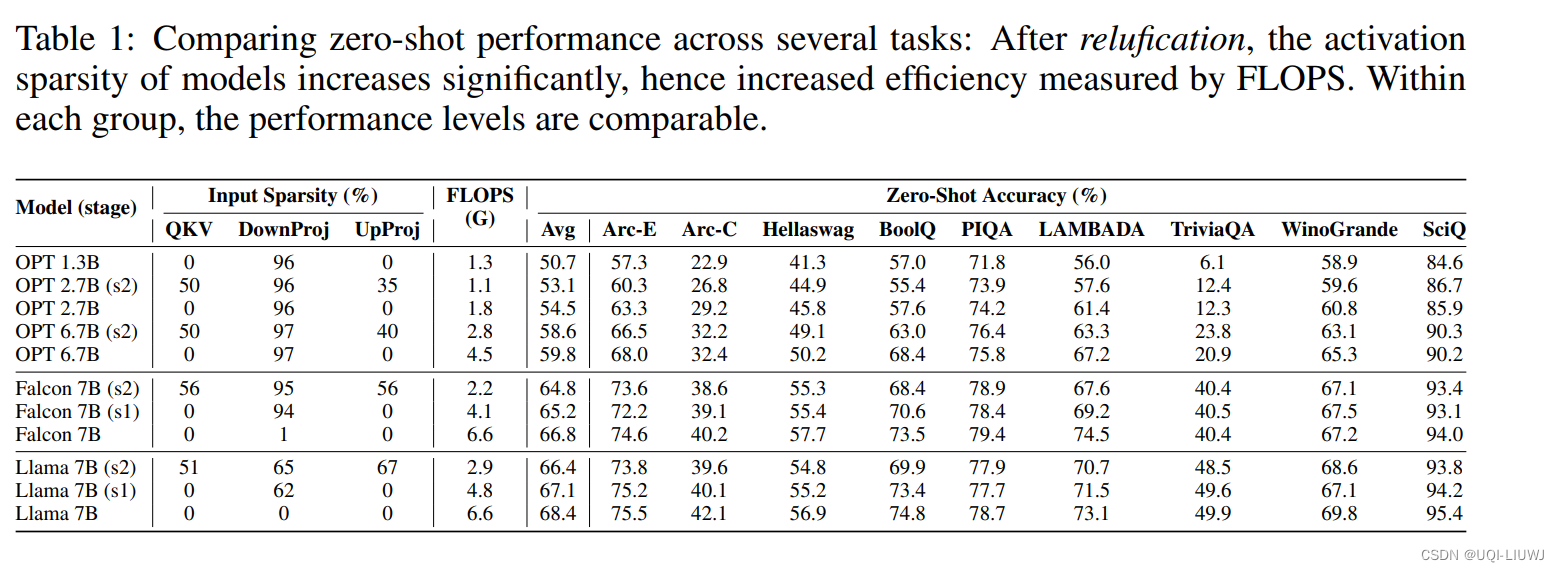

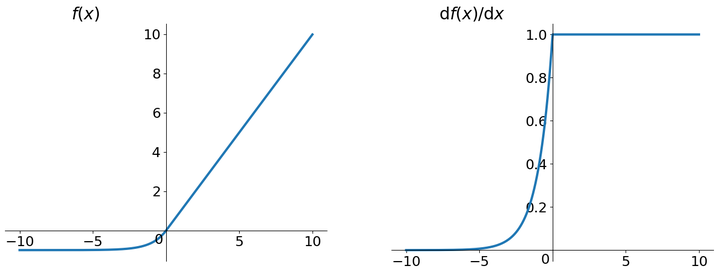

ReLU Strikes Back: Exploiting Activation Sparsity in Large Language Models

iclr 2024 oral reviewer 评分 688 1 intro 目前LLM社区中通常使用GELU和SiLU来作为替代激活函数,它们在某些情况下可以提高LLM的预测准确率 但从节省模型计算量的角度考虑,论文认为经典的ReLU函数对模型收敛和性能的影响可以忽略不计,同时可以显着减少计算和权重IO量\ 2 激活函数影响效果吗? 选用了开源的大模型 OPT,Llama

2.3 PyTorch神经网络基础-激励函数(Activation Function)

目录 1.写在前面 2.非线性方程 3.激励函数 4.常用选择 5.Torch中的激励函数 1.写在前面 今天我们要来聊聊现代神经网络中 必不可少的一个组成部分, 激励函数, activation function。 2.非线性方程 我们为什么要使用激励函数? 用简单的语句来概括. 就是因为, 现实并没有我们想象的那么美好, 它是残酷多变的.

BUG:解决执行firewall-cmd 命令后centos出现activation of network connection fail问题

问题背景(先了解清楚): 开发环境是centos7.6、VMware15.0。之前在虚拟机上配置了静态ip、安装了jdk1.8等(其它无关这个问题的配置就不列举出来了)。安装nginx时需要打开防火墙端口,运行 firewall-cmd --add-port=80/tcp --permanent 重启之后之后出现(执行命令之后不会马上出现) 问题成因: 看过很多博客,自己也回退很多快照,发

深度学习的activation function

转自:https://zhuanlan.zhihu.com/p/25110450 优先使用ReLU (Rectified Linear Unit) 函数作为神经元的activation function: 背景 深度学习的基本原理是基于人工神经网络,信号从一个神经元进入,经过非线性的activation function,传入到下一层神经元;再经过该层神经元的activate,继

react-activation实现缓存,且部分页面刷新缓存,清除缓存

1.安装依赖 npm i -S react-activation 2.使用AliveScope 包裹根组件 import { AliveScope } from "react-activation"<AliveScope><Router><Switch><Route exact path="/" render={() => <Redirect to="/login" push />} /

调整Activation Function参数对神经网络的影响

目录 介绍: 数据集: 模型一(tanh) : 模型二(relu): 模型三(sigmoid) : 模型四(多层tanh): 模型五(多层relu): 介绍: Activation Function(激活函数)是一种非线性函数,应用在神经网络的每个节点(神经元)上,用来引入非线性变换,增加神经网络的表达能力。 在神经网络中,每个节点的输入是通过加权和计算得到的,然后

CNN入门讲解:什么是激活函数(Activation Function)

各位看官老爷们 ( ̄▽ ̄)/ 这里是波波给大家带来的CNN卷积神经网络入门讲解 不定期我将给大家带来绝对原创,脑洞大开,幽默风趣的深度学习知识点入门讲解 希望大家多多支持,多多关注 微信公众号:follow_bobo 知乎号:蒋竺波 啦啦啦(~ ̄▽ ̄)~ 新年好 好久不见啊 想我吗 我们前面说了卷积层,再到下采样层 根据网络结构 我们应该又进入到卷积层 不 我不去

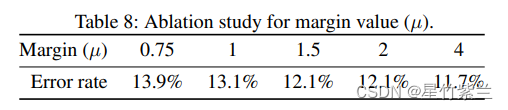

【论文阅读】Threshold Matters in WSSS: Manipulating the Activation for the Robust and Accurat...

一篇弱监督分割领域的论文,发表在CVPR2022上: 论文标题: Threshold Matters in WSSS: Manipulating the Activation for the Robust and Accurate Segmentation Model Against Thresholds 作者信息: 代码地址: https://github.com/gaviotas

【论文阅读】Threshold Matters in WSSS: Manipulating the Activation for the Robust and Accurat...

一篇弱监督分割领域的论文,发表在CVPR2022上: 论文标题: Threshold Matters in WSSS: Manipulating the Activation for the Robust and Accurate Segmentation Model Against Thresholds 作者信息: 代码地址: https://github.com/gaviotas

PyTorch 节省显存技巧:Activation Checkpointing

参考资料 官方文档: https://pytorch.org/docs/2.0/checkpoint.html官方博客:https://medium.com/pytorch/how-activation-checkpointing-enables-scaling-up-training-deep-learning-models-7a93ae01ff2d Activation Checkpoin

AttributeError: Can‘t get attribute ‘SiLU‘ on <module ‘torch.nn.modules.activation‘——报错简记

🥇 版权: 本文由【墨理学AI】原创、在CSDN首发、各位大佬、敬请查阅🎉 声明: 作为全网 AI 领域 干货最多的博主之一,❤️ 不负光阴不负卿 ❤️❤️ 如果文章对你有帮助、欢迎一键三连 文章目录 ❤️ 运行报错如下❤️ 解决方法📘 更多有效教程❤️ 人生苦短, 欢迎和墨理一起学AI ❤️ 运行报错如下 AttributeError: Can't get

The type javax.activation.DataHandler cannot be resolved

具体错误 The type javax.activation.DataHandler cannot be resolved. It is indirectly referenced from required .class files 解决办法 GitHub - LANGJIALINGBOJUE/Tools additionnal.jar;activation.jar;mail.jar

【深度学习】卷积神经网络的可视化---Visualization by activation Maximization

The Overview: Activation Maximization (AM)是用来可视化各个卷积层的输入偏好。 通过观测输入偏好,我们可以更好的了解CNN的卷积层到底学习到了什么。卷积学习得到的特征可以通过一帧合成图像来最大化神经元的激活。为了合成这个输入偏好,我们可以通过对CNN的输入像素进行反复迭代来最大化神经元的激活。 换言之,我们可以通过合成一个输入样式来激活神经元,使得神经元

pycharm全网最新安装教程(附加activation code),支持2018-2023版本

官网地址Download PyCharm: Python IDE for Professional Developers by JetBrains 下载的话无脑下载安装即可! 2018.2~2023版本用这个,最新的activation code码 2018.1以下版本用这个 老是审核不通过只能贴图片了(T-T)

CAM-Classification activation map 类激活图玩耍指南

原始论文 Learning Deep Features for Discriminative Localization 衍生论文 代码实现 torch-cam 该项目把代码打包成为了一个库,我们可以直接调用; torchcam.methods 这是上面那个项目的文档说明;

激活函数Activation Functions

激活函数Activation Functions sigmoid σ(x)=1(1+e−x) σ ( x ) = 1 ( 1 + e − x ) \sigma(x) = \frac{1}{(1 + e^{-x})} 每个元素被压缩到[0,1]范围内 Squashes numbers to range [0,1]它曾经一度非常流行,因为它有一个很好的解释就像神经元的

【知识蒸馏2018】Knowledge Transfer via Distillation of Activation Boundaries Formed by Hidden Neurons

【知识蒸馏2018】Knowledge Transfer via Distillation of Activation Boundaries Formed by Hidden Neurons 论文: https://arxiv.org/pdf/1811.03233.pdf 目录 一 主要思想:二 问题来源及推导模型:1. 问题及推导2.补充: 三 实验结果: 一 主要思想:

《Noisy Activation Function》噪声激活函数

原文:https://arxiv.org/pdf/1603.00391v3.pdf 参考: http://blog.csdn.net/yhl_leo/article/details/51736830 Noisy Activation Functions是ICML 2016年新发表的一篇关于激活函数的论文,其中对以往的激活函数进行了深入的分析,并提出了训练过程中添加噪声的新方法,效果不错,觉得

Empirical Evaluation of Rectified Activation in Convoluation Network 激活函数的讨论

Empirical Evaluation of Rectified Activation in Convoluation Network 对神经网络激活函数的经验评估 Standard rectified linear unit relu 标准整流线单元 这是最常用的激活函数 Leaky rectified linear unit lrelu Parametric r

iOS11 beta iCloud Activation Lock曝漏洞

iOS 11 目前还是测试版,所以系统中难免会出现漏洞,不过有些比较严重的漏洞还是值得各位使用测试版的用户注意。在 iOS 11 的前两个测试版中就有一个漏洞,当 iCloud 被锁定时,使用设备的人还是可以激活设备的某些功能和特性。而这完全违背了 iCloud 被锁定之后锁定设备功能和限制的初衷。iPad 或 iPhone 被锁定到特定 iCloud 账户时,在没有正确的账户凭据的情况下,谁